Hadoop_04_Hadoop 的HDFS客户端shell命令

1.Hdfs shell客户端命令操作:

1.1.查看命令列表:hadoop fs

帮助如下:

Usage: hadoop fs [generic options]

[-appendToFile <localsrc> ... <dst>] //追加一个文件到已经存在的文件末尾

[-cat [-ignoreCrc] <src> ...]

[-checksum <src> ...]

[-chgrp [-R] GROUP PATH...]

[-chmod [-R] <MODE[,MODE]... | OCTALMODE> PATH...]

[-chown [-R] [OWNER][:[GROUP]] PATH...]

[-copyFromLocal [-f] [-p] [-l] <localsrc> ... <dst>]

[-copyToLocal [-p] [-ignoreCrc] [-crc] <src> ... <localdst>]

[-count [-q] [-h] <path> ...]

[-cp [-f] [-p | -p[topax]] <src> ... <dst>]

[-createSnapshot <snapshotDir> [<snapshotName>]]

[-deleteSnapshot <snapshotDir> <snapshotName>]

[-df [-h] [<path> ...]]

[-du [-s] [-h] <path> ...]

[-expunge]

[-find <path> ... <expression> ...]

[-get [-p] [-ignoreCrc] [-crc] <src> ... <localdst>]

[-getfacl [-R] <path>]

[-getfattr [-R] {-n name | -d} [-e en] <path>]

[-getmerge [-nl] <src> <localdst>]

[-help [cmd ...]]

[-ls [-d] [-h] [-R] [<path> ...]]

[-mkdir [-p] <path> ...]

[-moveFromLocal <localsrc> ... <dst>]

[-moveToLocal <src> <localdst>] //从hdfs剪切粘贴到本地

[-mv <src> ... <dst>]

[-put [-f] [-p] [-l] <localsrc> ... <dst>]

[-renameSnapshot <snapshotDir> <oldName> <newName>]

[-rm [-f] [-r|-R] [-skipTrash] <src> ...]

[-rmdir [--ignore-fail-on-non-empty] <dir> ...]

[-setfacl [-R] [{-b|-k} {-m|-x <acl_spec>} <path>]|[--set <acl_spec> <path>]]

[-setfattr {-n name [-v value] | -x name} <path>]

[-setrep [-R] [-w] <rep> <path> ...]

[-stat [format] <path> ...]

[-tail [-f] <file>]

[-test -[defsz] <path>]

[-text [-ignoreCrc] <src> ...]

[-touchz <path> ...]

[-truncate [-w] <length> <path> ...]

[-usage [cmd ...]] Generic options supported are

-conf <configuration file> specify an application configuration file

-D <property=value> use value for given property

-fs <local|namenode:port> specify a namenode

-jt <local|resourcemanager:port> specify a ResourceManager

-files <comma separated list of files> specify comma separated files to be copied to the map reduce cluster

-libjars <comma separated list of jars> specify comma separated jar files to include in the classpath.

-archives <comma separated list of archives> specify comma separated archives to be unarchived on the compute machines. The general command line syntax is

bin/hadoop command [genericOptions] [commandOptions]

1.1.1.查看文件列表:hadoop fs -ls / (/:HDFS文件系统的根目录)

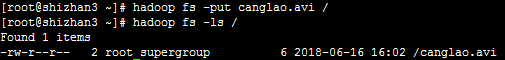

1.1.2.上传文件:hadoop fs -put canglao.avi /

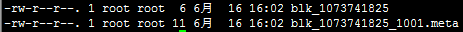

注意:真实的数据文件路径在DataNode节点数据目录的:/usr/local/src/hadoop-2.6.4/hdpdata3/dfs/data/current/BP-1438427861-192.168.232.201-1529131287527/current/finalized/subdir0/subdir0/下面有如下文件列表:

此时会发现在shizhan5的DataNode数据存放目录下面会有该blk_1073741825的副本

可以用下面的命令查看一下blk_1073741825文件的内容:cat blk_1073741825

然后会发现输出的内容是canglao.avi文件的内容。因为文件太小,没有切开。默认128M才切开,再放一个超过128M的文件:

hadoop fs -put /root/temp/hadoop-2.7.3.tar.gz /

在dataNode数据存放目录查看(同样存在副本):

-rw-r--r-- 1 root root 23562 2月 18 12:53 blk_1073741825

-rw-r--r-- 1 root root 195 2月 18 12:53 blk_1073741825_1001.meta

-rw-r--r-- 1 root root 134217728 2月 18 13:09 blk_1073741826

-rw-r--r-- 1 root root 1048583 2月 18 13:09 blk_1073741826_1002.meta

-rw-r--r-- 1 root root 79874467 2月 18 13:09 blk_1073741827

-rw-r--r-- 1 root root 624027 2月 18 13:09 blk_1073741827_1003.meta

接下来我们把blk_1073741826和blk_1073741827尝试拼接起来,然后试一下能不能解压:

cat blk_1073741826 >> tmp.file

cat blk_1073741827 >> tmp.file

tar -zxvf tmp.file

操作后的文件列表是:

-rw-r--r-- 1 root root 23562 2月 18 12:53 blk_1073741825

-rw-r--r-- 1 root root 195 2月 18 12:53 blk_1073741825_1001.meta

-rw-r--r-- 1 root root 134217728 2月 18 13:09 blk_1073741826

-rw-r--r-- 1 root root 1048583 2月 18 13:09 blk_1073741826_1002.meta

-rw-r--r-- 1 root root 79874467 2月 18 13:09 blk_1073741827

-rw-r--r-- 1 root root 624027 2月 18 13:09 blk_1073741827_1003.meta

drwxr-xr-x 9 root root 4096 8月 18 2016 hadoop-2.7.3/ ----解压tmp.file后的文件

-rw-r--r-- 1 root root 214092195 2月 18 13:16 tmp.file

1.1.3.获取文件:hadoop fs -get /hadoop-2.7.3.tar.gz(完整文件)

1.1.4.删除文件:hadoop fs -rm /canglao.avi

1.1.5.从本地剪切粘贴到HDFS:hadoop fs -moveFromLocal /home/hadoop/a.txt /aaa/bbb

1.1.5.查看集群状态:hdfs dfsadmin -report

[root@shizhan3 subdir0]# hdfs dfsadmin -report

Configured Capacity: 55306051584 (51.51 GB)

Present Capacity: 23346880478 (21.74 GB)

DFS Remaining: 23346765824 (21.74 GB)

DFS Used: 114654 (111.97 KB)

DFS Used%: 0.00%

Under replicated blocks: 0

Blocks with corrupt replicas: 0

Missing blocks: 0 -------------------------------------------------

Live datanodes (3): Name: 192.168.232.208:50010 (192.168.232.208)

Hostname: shizhan6

Decommission Status : Normal

Configured Capacity: 18435350528 (17.17 GB)

DFS Used: 24576 (24 KB)

Non DFS Used: 10881404928 (10.13 GB)

DFS Remaining: 7553921024 (7.04 GB)

DFS Used%: 0.00%

DFS Remaining%: 40.98%

Configured Cache Capacity: 0 (0 B)

Cache Used: 0 (0 B)

Cache Remaining: 0 (0 B)

Cache Used%: 100.00%

Cache Remaining%: 0.00%

Xceivers: 1

Last contact: Sat Jun 16 16:44:28 CST 2018 Name: 192.168.232.205:50010 (shizhan3)

Hostname: shizhan3

Decommission Status : Normal

Configured Capacity: 18435350528 (17.17 GB)

DFS Used: 45039 (43.98 KB)

Non DFS Used: 10236620817 (9.53 GB)

DFS Remaining: 8198684672 (7.64 GB)

DFS Used%: 0.00%

DFS Remaining%: 44.47%

Configured Cache Capacity: 0 (0 B)

Cache Used: 0 (0 B)

Cache Remaining: 0 (0 B)

Cache Used%: 100.00%

Cache Remaining%: 0.00%

Xceivers: 1

Last contact: Sat Jun 16 16:44:27 CST 2018 Name: 192.168.232.207:50010 (shizhan5)

Hostname: shizhan5

Decommission Status : Normal

Configured Capacity: 18435350528 (17.17 GB)

DFS Used: 45039 (43.98 KB)

Non DFS Used: 10841145361 (10.10 GB)

DFS Remaining: 7594160128 (7.07 GB)

DFS Used%: 0.00%

DFS Remaining%: 41.19%

Configured Cache Capacity: 0 (0 B)

Cache Used: 0 (0 B)

Cache Remaining: 0 (0 B)

Cache Used%: 100.00%

Cache Remaining%: 0.00%

Xceivers: 1

Last contact: Sat Jun 16 16:44:26 CST 2018

可以看出,集群共有3个datanode可用

也可以打开web控制台查看HDFS集群信息:http://shizhan2:50070

Hadoop_04_Hadoop 的HDFS客户端shell命令的更多相关文章

- Hadoop HDFS的shell(命令行客户端)操作实例

HDFS的shell(命令行客户端)操作实例 3.2 常用命令参数介绍 -help 功能:输出这个命令参数手册 -ls 功能:显示目录信息 示例: hadoop fs ...

- HDFS 常用Shell命令

HDFS Shell命令 概述 HDFS Shell命令允许使用命令行在HDFS存储中进行文件夹和文件操作. 如文件夹的增删改查.文件的增删改查等. 开始练习hadoop时,打开Linux之后要用 s ...

- 009 HDFS的shell命令(里面有一个安全模式)

一:dfs的命令 1.所有的领命 2.解释 -appendToFile <localsrc> ... <dst> :追加文件 -checksum <src> . ...

- HDFS基本Shell命令

bin目录下: 1. hadoop fs 基本操作命令,类似linux shell 2. hadoop dfsadmin 管理命令 3. hadoop fsck (1. 检查hdfs中文件的健康 ...

- HDFS常用shell命令

注,其实常用命令不用网上搜,和linux下的命令很类似,触类旁通,直接在linux 上 hadoop fs 看一下就行了,不需要刻意去记我把 linux 上的 help 列举下,方便直接看吧,hdfs ...

- Hadoop 学习之路(六)—— HDFS 常用 Shell 命令

1. 显示当前目录结构 # 显示当前目录结构 hadoop fs -ls <path> # 递归显示当前目录结构 hadoop fs -ls -R <path> # 显示根目录 ...

- Hadoop 系列(六)—— HDFS 常用 Shell 命令

一.基本命令 打开 Hbase Shell: # hbase shell 1.1 获取帮助 # 获取帮助 help # 获取命令的详细信息 help 'status' 1.2 查看服务器状态 stat ...

- hadoop系列二:HDFS文件系统的命令及JAVA客户端API

转载请在页首明显处注明作者与出处 一:说明 此为大数据系列的一些博文,有空的话会陆续更新,包含大数据的一些内容,如hadoop,spark,storm,机器学习等. 当前使用的hadoop版本为2.6 ...

- Hadoop学习笔记(2)-HDFS的基本操作(Shell命令)

在这里我给大家继续分享一些关于HDFS分布式文件的经验哈,其中包括一些hdfs的基本的shell命令的操作,再加上hdfs java程序设计.在前面我已经写了关于如何去搭建hadoop这样一个大数据平 ...

随机推荐

- NFS PersistentVolume

一.部署nfs服务端: k8s-master 节点上搭建了 NFS 服务器 (1)安装nfs服务: yum install -y nfs-utils rpcbind vim /etc/exports ...

- IDEA 2019中一些有偏好设置

1.取消启动时自动进入上一次工程: 路径:Setting ——> Appearance & Behavior ——> System Setting 取消勾选Reopen last ...

- docker笔记(3)—— 容器

操作环境:mac OS 10.14.6 docker版本:10.03.1 终端:iterm2 3.3 时间:2019年8月 容器相当于镜像的实例,镜像相当于只读模板,容器在镜像所有层级之上创建了一个可 ...

- 【Abode Air程序开发】iOS证书(.p12)和描述文件(.mobileprovision)申请

iOS证书(.p12)和描述文件(.mobileprovision)申请 5+App开发 Apple证书 iOS证书 iOS有两种证书和描述文件: 证书类型 使用场景 开发(Development)证 ...

- JAVA -----------交互式程序

2.6交互式程序 如果程序能在执行期间交互地从用户输入中读取数据,就可使程序每执行一次时计算出新结果,并且新结果取决于输入数据.这样的程序才具有实用性. 2.6.1 Scanner类 Scanner类 ...

- gdb移植(设备端本地版本)

Gdb下载地址:http://ftp.gnu.org/gnu/gdb/ ncurse下载地址:http://ftp.gnu.org/pub/gnu/ncurses/ 目录结构如下: ├── insta ...

- C++学习 之 程序的组成部分(部分知识笔记)

1.预处理器编译指令#include: 预处理器是在程序编译前运行的工具.预处理器编译指令是向预处理器发送的命令,总是以#为标识,include便是其中常见的一种,用于引用文件,比如:iostream ...

- HTML accessKey约定俗成的标准

accessKey属性提供了键盘快捷键 例: <a href="index.html" accessKey="1">Home</a> 这 ...

- 前端 CSS 2

无序列表去除自带的样式 <!DOCTYPE html> <html lang="en"> <head> <meta charset=&qu ...

- 句子反转——牛客刷题(java)

题目描述: 给定一个句子(只包含字母和空格), 将句子中的单词位置反转,单词用空格分割, 单词之间只有一个空格,前后没有空格. 比如: (1) “hello xiao mi”-> “mi xia ...