Hadoop 权限管理(转)

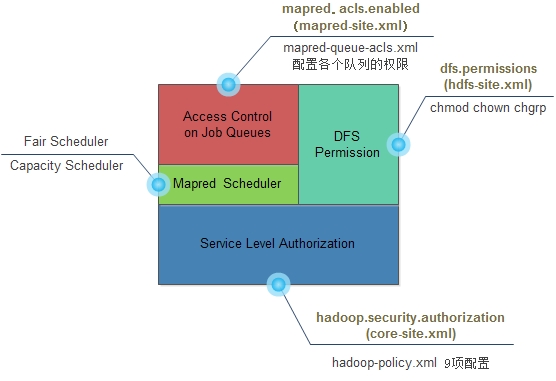

如下图,hadoop访问控制分为两级,其中ServiceLevel Authorization为系统级,用于控制是否可以访问指定的服务,例如用户/组是否可以向集群提交Job,它是最基础的访问控制,优先于文件权限和mapred队列权限验证。Access Control on Job Queues在job调度策略层之上,控制mapred队列的权限。DFSPermmision用户控制文件权限。目前版本中,连接到hadoop集群的用户/组信息取决于客户端环境,即客户端主机中`whoami`和`bash –c groups`取到的用户名和组名,没有uid和gid,用户属组列表中只要有一个与集群配置的用户组相同即拥有该组权限。

1、 配置Service Level Authorization

修改core-site.xml

<property>

<name>hadoop.security.authorization</name>

<value>true</value>

</property>

hadoop.security.authorization=true则开启ServiceLevel Authorization,若为false则不经过任何验证,所有用户拥有全部权限。(修改此配置需要重启hadoop)

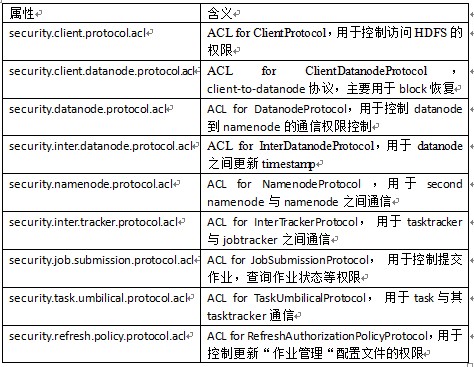

Service LevelAuthorization有9个可配置的属性,每个属性可指定拥有相应访问权限的用户或者用户组。这9个ACL属性如下(hadoop-policy.xml):

这9个属性的配置方法相同,具体如下:

每个可配置多个用户,用户之间用“,”分割;可配置多个用户组,分组之间用“,”分割,用户和分组之间用空格分割,如果只有分组,前面保留一个空格,如:

<property>

<name>security.job.submission.protocol.acl</name>

<value>alice,bobgroup1,group2</value>

</property>

默认情况下,这9个属性不对任何用户和分组开放。

该配置文件可使用以下命令动态加载:

(1) 更新namenode相关属性:bin/hadoop dfsadmin –refreshServiceAcl

(2) 更新jobtracker相关属性:bin/hadoopmradmin –refreshServiceAcl

2、 调度器配置

修改mapred-site.xml

<property>

<name>mapred.jobtracker.taskScheduler</name>

<value>org.apache.hadoop.mapred.CapacityTaskScheduler</value>

</property>

启用Access Contol onJob Queues需选择一个支持多队列管理的调度器,所以mapred.jobtracker.taskScheduler只能为CapacityTaskScheduler或FairScheduler。

在mapred-site.xml里配置队列,如:

<property>

<name>mapred.queue.names</name>

<value>default,hadoop,stat,query</value>

</property>

3、 Access Contol on JobQueues配置

Access Contol on Job Queues开关在mapred-site.xml,如下:

<property>

<name>mapred.acls.enabled</name>

<value>true</value>

</property>

mapred.acls.enabled=true开启,为false关闭。

具体ACL属性在mapred-queue-acl.xml里,如:

<property>

<name>mapred.queue.stat.acl-submit-job</name>

<value>user1,user2 group1,group2</value>

</property>

表示user1,user2和group1,group2可以向stat queue提交job。

4、 DFS permission配置

修改hdfs-site.xml

<property>

<name> dfspermission </name>

<value>true</value>

</property>

dfs.permission是否开启文件权限验证,true开启,false不进行读写权限验证。(注:dfs.permission开启与否dfs permission信息都不会改变后丢失,chown、chgrp、chmod操作也始终会验证权限,dfspermission信息只在namenode里,并不在danode里与blocks关联)

用chown、chgrp、chmod修改文件/目录的属主、属组和权限。

补:Job ACL

Job ACL默认值配置在mapred-site.xml里,如下:

<property>

<name>mapreduce.job.acl-view-job</name>

<value>user1</value>

</property>

<property>

<name>mapreduce.job.acl-modify-job</name>

<value>user1</value>

</property>

表示,默认情况下,user1用户拥有job的查看和修改权限。

Job提交者可以指定mapreduce.job.acl-view-job和mapreduce.job.acl-modify-job值,提交时指定的值会覆盖默认值。

Job提交者、superuser、集群管理员(mapreduce.cluster.administrators)、JobQueue管理员始终拥有该权限。

转自 http://blog.csdn.net/cheersu/article/details/8080162

参考资料:

《Service Level Authorization Guide》

Hadoop 权限管理(转)的更多相关文章

- Hadoop权限管理

1.Hadoop权限管理包括以下几个模块: (1) 用户分组管理.用于按组为单位组织管理,某个用户只能向固定分组中提交作业,只能使用固定分组中配置的资源:同时可以限制每个用户提交的作业数,使用的资源量 ...

- Hadoop 权限管理

Hadoop的权限管理同Linux的很像,有用户,用户组之分,同时Hadoop提供了权限管理命令,主要包括: chmod [-R] mode file … 只有文件的所有者或者超级用户才有权限改变文件 ...

- HADOOP docker(七):hive权限管理

1. hive权限简介1.1 hive中的用户与组1.2 使用场景1.3 权限模型1.3 hive的超级用户2. 授权管理2.1 开启权限管理2.2 实现超级用户2.3 实现hiveserver2用户 ...

- Spark SQL Thrift Server 配置 Kerberos身份认证和权限管理

转载请注明出处:http://www.cnblogs.com/xiaodf/ 之前的博客介绍了通过Kerberos + Sentry的方式实现了hive server2的身份认证和权限管理功能,本文主 ...

- 【linux相识相知】用户及权限管理

linux系统是多用户(Multi-users)和多任务(Multi-tasks)的,这样的目的是为了一台linux主机可以给很多用户提供服务同时运行多种服务,但是我们是怎么区分每个用户呢?作为一个管 ...

- Linux命令-用户及权限管理

一.权限管理linux系统中对文件权限的描述机制: u g od r w x r w x r - x (r读,w写,x执行)文件 所有者 所属组 其他人可以表示为二进制: 111 111 101也可以 ...

- 【Hive学习之七】Hive 运行方式&权限管理

环境 虚拟机:VMware 10 Linux版本:CentOS-6.5-x86_64 客户端:Xshell4 FTP:Xftp4 jdk8 hadoop-3.1.1 apache-hive-3.1.1 ...

- Hive 系列(二)权限管理

Hive 系列(二)权限管理 一.关于 Hive Beeline 问题 启动 hiveserver2 服务,启动 beeline -u jdbc:hive2:// 正常 ,启动 beeline -u ...

- HDFS权限管理用户指南

原文地址:http://hadoop.apache.org/docs/r1.0.4/cn/hdfs_permissions_guide.html 概述 用户身份 理解系统的实现 文件系统API变更 S ...

随机推荐

- ansible控制winserver笔记

原文地址: https://www.cnblogs.com/kingleft/p/6391652.html 环境描述: ansible控制远程windows .系统必须是sp1 .安装framewor ...

- scrapy工作流程

整个scrapy流程,我们可以用去超市取货的过程来比喻一下 两个采购员小王和小李开着采购车,来到一个大型商场采购公司月饼.到了商场之后,小李(spider)来到商场前台,找到服务台小花(引擎)并对她说 ...

- 2018-2019-2 20175105王鑫浩《Java程序设计》实验四 《Android开发基础》实验报告

实验四 <Android开发基础> 实验报告封面 课程:Java程序设计 班级:1751班 姓名:王鑫浩 学号:20175105 指导教师:娄嘉鹏 实验日期:2019年5月17日 实验时间 ...

- 2018-2019 2 20165203 《网络对抗技术》Exp9 Web安全基础

2018-2019 2 20165203 <网络对抗技术>Exp9 Web安全基础 实验要求 本实践的目标理解常用网络攻击技术的基本原理,做不少于7个题目,共3.5分.包括(SQL,XSS ...

- php关键字static使用

php中static关键字使用: 情景1:静态变量 使用static关键字定义静态变量 静态变量:只存在于函数作用域内,也就是说,静态变量只存活在栈中.一般的函数内变量在函数结束后会释放,比如局部变量 ...

- 【读书笔记】:MIT线性代数(1):Linear Combinations

1. Linear Combination Two linear operations of vectors: Linear combination: 2.Geometric Explaination ...

- java多线程学习笔记(八)

本节开始线程间通信: 使用wait/notify实现线程间通信 生产者/消费者模式的实现 方法join的使用 ThreadLocal类的使用 可以通过使用 sleep() 结合 while(true) ...

- MySQL Workbench无法显示左侧的navigator,只显示Object info和Session

问题描述:Mac版MySQL Workbench出现异常强制退出后,再次进入后左侧的navigator消失,左侧整个导航条消失了,只显示Object info和Session. 问题根源:MySQL ...

- 【置顶】CSP/S 2019退役祭

标题没错,今年就是我的最后一年了. 才高一啊,真不甘心啊. DAY1(之前的看前几篇博客吧) T1 现在没挂 T2 貌似是树形DP,跑到80000的深度时挂了,于是特判了链的情况,大样例过了,现在没挂 ...

- IDEA compile successfully many errors still occur

Compile and install successfully with maven in IDEA, but error prompt still popup. Your local enviro ...