Spark在MaxCompute的运行方式

一、Spark系统概述

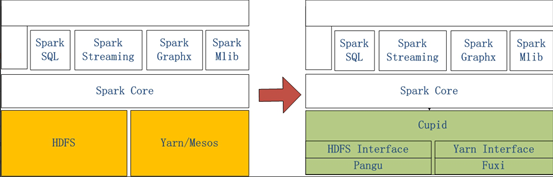

左侧是原生Spark的架构图,右边Spark on MaxCompute运行在阿里云自研的Cupid的平台之上,该平台可以原生支持开源社区Yarn所支持的计算框架,如Spark等。

二、Spark运行在客户端的配置和使用

2.1打开链接下载客户端到本地

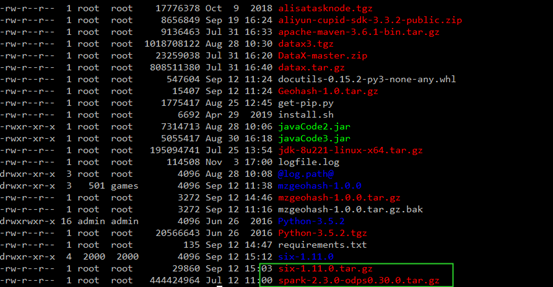

2.2将文件上传的ECS上

2.3将文件解压

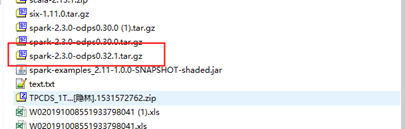

tar -zxvf spark-2.3.0-odps0.30.0.tar.gz

2.4配置Spark-default.conf

# spark-defaults.conf

# 一般来说默认的template只需要再填上MaxCompute相关的账号信息就可以使用Spark

spark.hadoop.odps.project.name =

spark.hadoop.odps.access.id =

spark.hadoop.odps.access.key =

# 其他的配置保持自带值一般就可以了

spark.hadoop.odps.end.point = http://service.cn.maxcompute.aliyun.com/api

spark.hadoop.odps.runtime.end.point = http://service.cn.maxcompute.aliyun-inc.com/api

spark.sql.catalogImplementation=odps

spark.hadoop.odps.task.major.version = cupid_v2

spark.hadoop.odps.cupid.container.image.enable = true

spark.hadoop.odps.cupid.container.vm.engine.type = hyper

2.5在github上下载对应代码

https://github.com/aliyun/MaxCompute-Spark

2.5将代码上传到ECS上进行解压

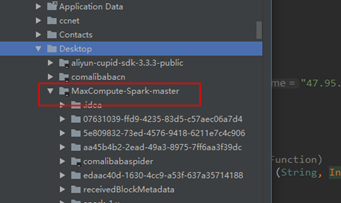

unzip MaxCompute-Spark-master.zip

2.6将代码打包成jar包(确保安装Maven)

cd MaxCompute-Spark-master/spark-2.x

mvn clean package

2.7查看jar包,并进行运行

bin/spark-submit --master yarn-cluster --class com.aliyun.odps.spark.examples.SparkPi \

MaxCompute-Spark-master/spark-2.x/target/spark-examples_2.11-1.0.0-SNAPSHOT-shaded.jar

三、Spark运行在DataWorks的配置和使用

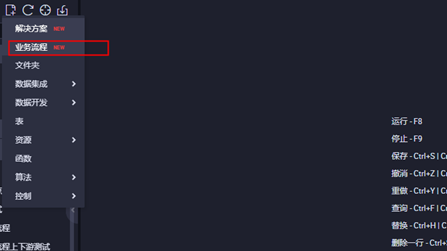

3.1进入DataWorks控制台界面,点击业务流程

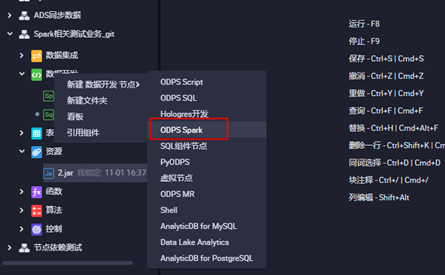

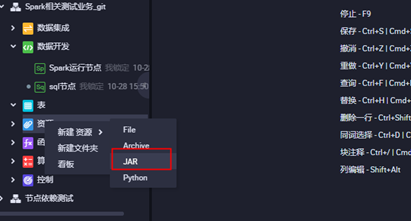

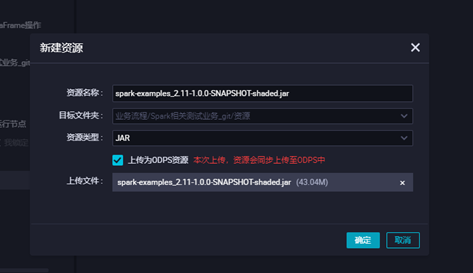

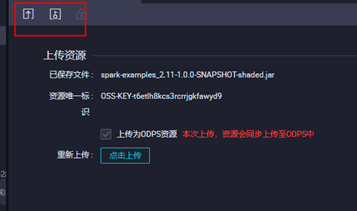

3.2打开业务流程,创建ODPS Spark节点

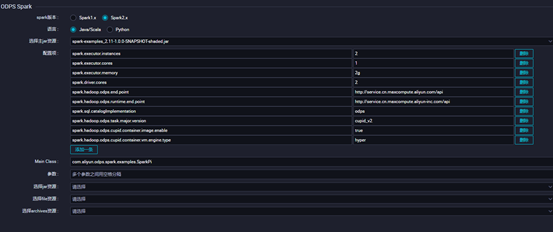

3.3上传jar包资源,点击对应的jar包上传,并提交

3.4配置对应ODPS Spark的节点配置点击保存并提交,点击运行查看运行状态

四、Spark在本地idea测试环境的使用

4.1下载客户端与模板代码并解压

模板代码:

https://github.com/aliyun/MaxCompute-Spark

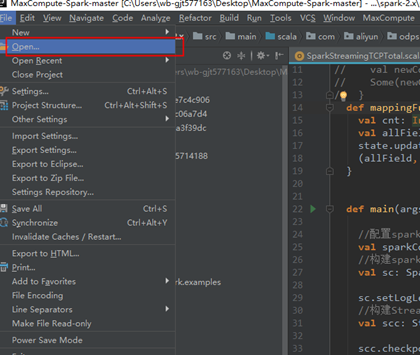

4.2打开idea,点击Open选择模板代码

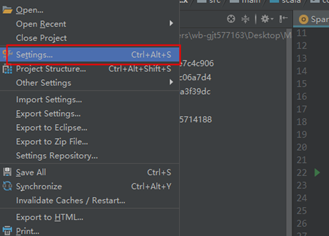

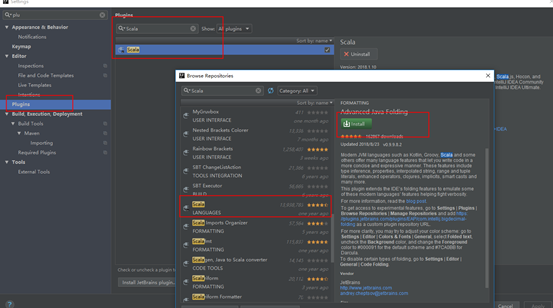

4.2安装Scala插件

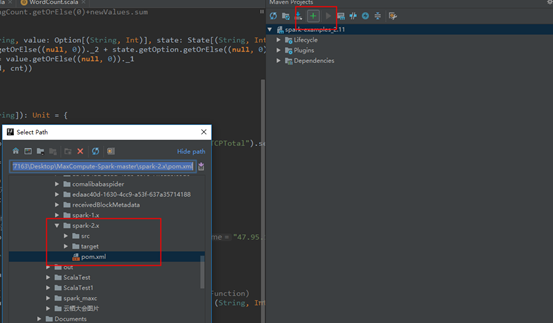

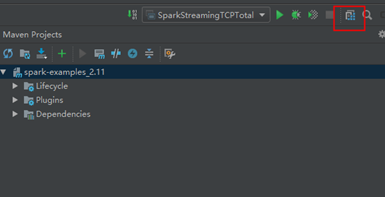

4.3配置maven

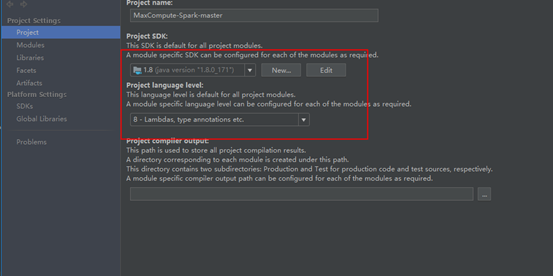

4.4配置JDK和相关依赖

本文作者:耿江涛

本文为云栖社区原创内容,未经允许不得转载。

Spark在MaxCompute的运行方式的更多相关文章

- 「Spark」Spark SQL Thrift Server运行方式

Spark SQL可以使用JDBC/ODBC或命令行接口充当分布式查询引擎.这种模式,用户或者应用程序可以直接与Spark SQL交互,以运行SQL查询,无需编写任何代码. Spark SQL提供两种 ...

- MaxCompute Spark开发指南

0. 概述 本文档面向需要使用MaxCompute Spark进行开发的用户使用.本指南主要适用于具备有Spark开发经验的开发人员. MaxCompute Spark是MaxCompute提供的兼容 ...

- MaxCompute问答整理之7月

本文是基于本人对MaxCompute产品的学习进度,再结合开发者社区里面的一些问题,进而整理成文.希望对大家有所帮助. 问题一.DataWorks V2.0简单模式和标准模式的区别?公司数仓的数据上云 ...

- 阿里云大数据计算服务 - MaxCompute (原名 ODPS)

MaxCompute 是阿里EB级计算平台,经过十年磨砺,它成为阿里巴巴集团数据中台的计算核心和阿里云大数据的基础服务.去年MaxCompute 做了哪些工作,这些工作背后的原因是什么?大数据市场进入 ...

- 一文快速了解MaxCompute

很多刚初次接触MaxCompute的用户,面对繁多的产品文档内容以及社区文章,往往很难快速.全面了解MaxCompute产品全貌.同时,很多拥有大数据开发经验的开发者,也希望能够结合自身的背景知识,将 ...

- spark学习(基础篇)--(第三节)Spark几种运行模式

spark应用执行机制分析 前段时间一直在编写指标代码,一直采用的是--deploy-mode client方式开发测试,因此执行没遇到什么问题,但是放到生产上采用--master yarn-clus ...

- 【互动问答分享】第10期决胜云计算大数据时代Spark亚太研究院公益大讲堂

“决胜云计算大数据时代” Spark亚太研究院100期公益大讲堂 [第10期互动问答分享] Q1:Spark on Yarn的运行方式是什么? Spark on Yarn的运行方式有两种:Client ...

- Hive数据如何同步到MaxCompute之实践讲解

摘要:本次分享主要介绍 Hive数据如何迁移到MaxCompute.MMA(MaxCompute Migration Assist)是一款MaxCompute数据迁移工具,本文将为大家介绍MMA工具的 ...

- MaxCompute新功能发布

2018年Q3 MaxCompute重磅发布了一系列新功能. 本文对主要新功能和增强功能进行了概述. 实时交互式查询:Lightning on MaxCompute 生态兼容:Spark on Max ...

随机推荐

- linux文本图形界面转换

vim /etc/inittab 3为默认进入文本界面, 5为默认进入图形界面 文本界面下输入init5或者startx切换图形化界面 图形化界面下输入init3切换文本界面

- 2 Vue.js基础

1 简易计算器 <!DOCTYPE html> <html lang="en"> <head> <meta charset="U ...

- Java8的I/O整理

一.什么是I/O? Java的核心库java.io提供了全面的IO接口.包括:文件读写.标准设备输出等.Java中IO是以流为基础进行输入输出的,所有数据被串行化写入输出流,或者从输入流读入. 二.什 ...

- MYSQL的ACID

原子性 (Atomicity) 原子性是指一个事务是一个不可分割的工作单位,其中的操作要么都做,要么都不做. 隔离性 (Isolation) 隔离性是指多个事务并发执行的时候,事务内部的操作与其他事务 ...

- mysql续集(查询部分)

mysql查询部分,从基础的查询到关键字,where子句,group by, order by, limit ,having,子查询分为from子查询和where子查询,左连接和右连接,内连接的连表查 ...

- Javascript之谈对象

谈谈如何理解对象 使用预定义对象只是面向对象语言的能力的一部分,ECMAScript 真正强大之处在于能够创建自己专用的类和对象.面向对象的语言有一个标志,那就是它们都有类的概念,而通过类可以创建任意 ...

- 手动刷新客户端配置内容(Spring Cloud Config)

手动刷新客户端配置内容 客户端项目增加依赖项 <dependency> <groupId>org.springframework.boot</groupId> &l ...

- WOJ#3836 Sightseeing Trip

描述 给定一张无向图,求图中一个至少包含 3 个点的环,环上的节点不重复,并且环上的边的长度之和最小.该问题称为无向图的最小环问题.在本题中,你需要输出最小环的方案,若最小环不唯一,输出任意一个均可. ...

- 什么是 Python?

Python 是一种编程语言,它有对象.模块.线程.异常处理和自动内存管理,可以加入其他语言的对比. Python 是一种解释型语言,Python 在代码运行之前不需要解释. Python 是动 ...

- Mysql8- Public Key Retrieval is not allowed

在使用 MySQL 8.0 时重启应用后提示 com.mysql.jdbc.exceptions.jdbc4.MySQLNonTransientConnectionException: Public ...