大数据学习之hdfs集群安装部署04

1-> 集群的准备工作

1)关闭防火墙(进行远程连接)

systemctl stop firewalld

systemctl -disable firewalld

2)永久修改设置主机名

vi /etc/hostname

注意:需要重启生效->reboot

3)配置映射文件

vi /etc/hosts

#127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

#::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.40.11 bigdata11

192.168.40.12 bigdata12

192.168.40.13 bigdata13

2-> 安装jdk

1)上传tar包

用winscp那个软件吧

2)解压tar包

tar -zxvf jdk

3)配置环境变量

vi /etc/profile

export JAVA_HOME=/root/training/jdk1.8.0_144

export PATH=$PATH:$JAVA_HOME/bin

注意:加载环境变量 source /etc/profile

4)发送到其它机器(偷个懒,不用一个一个的配,哈哈哈)

scp -r /root/.bash_profile root@bigdata12:/root/.bash_profile

scp -r /root/.bash_profile root@bigdata13:/root/.bash_profile

注意:加载环境变量 source /etc/profile

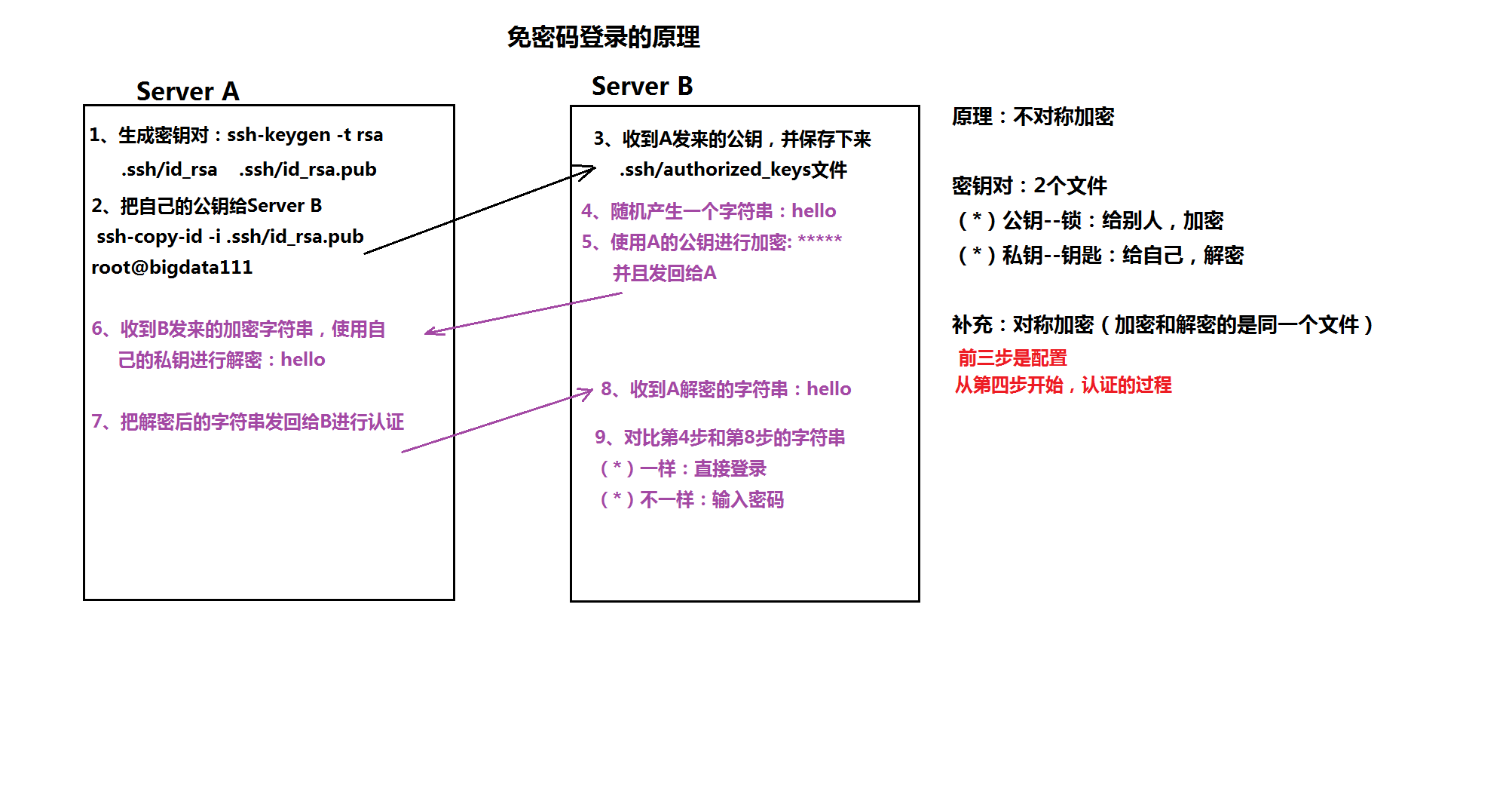

5)配置ssh免密登录

-》ssh-keygen 生成密钥对

-》 ssh-copy-id 自己

ssh-copy-id 其它

ssh-copy-id 其它

每台机器都这样操作。

1:生产公钥对:ssh-keygen -t rsa(直接回车到底)

2:把公钥发送给serverB: ssh-copy-id -i .ssh/id_rsa.pub root@bigdata11

ssh-copy-id -i .ssh/id_rsa.pub root@bigdata12

ssh-copy-id -i .ssh/id_rsa.pub root@bigdata13

3-> 安装HDFS集群(注意,只是安装的hdfs,并非完全的hadoop,我们用到什么就装什么。有助于学习理解)

1) 修改hadoop-env.sh

export JAVA_HOME=/root/training/jdk1.8.0_144

2) 修改core-site.xml

<!--配置hdfs-->

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://bigdata11:9000</value>

</property>

</configuration>

3) 修改hdfs-site.xml

<configuration>

<!--配置元数据存储位置-->

<property>

<name>dfs.namenode.name.dir</name>

<value>/root/training/hadoop-2.8.4/dfs/name</value>

</property>

//配置数据存储位置

<property>

<name>dfs.datanode.data.dir</name>

<value>/root/training/hadoop-2.8.4/dfs/data</value>

</property>

</configuration>

4)格式化namenode

hadoop namemode -format

5)分发hadoop到其它机器

scp -r /root/training/hadoop-2.8.4/ bigdata12:/root/training/

scp -r /root/training/hadoop-2.8.4/ bigdata13:/root/training/

6)配置hadoop环境变量

export HADOOP_HOME=/root/training/hadoop-2.8.4

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

6)分发hadoop环境变量

scp -r /root/.bash_profile root@bigdata12:/root/.bash_profile

scp -r /root/.bash_profile root@bigdata13:/root/.bash_profile

注意:加载环境变量 source /root/.bash_profile(每个虚拟机都要配置)

7)启动namenode

hadoop-daemon.sh start namenode

8)启动datanode

hadoop-daemon.sh start datanode

9)访问namenode提供的web端口:50070

4-> 自动批量的启动脚本

1)修改配置文件vi /etc/hadoop/slaves(记得每台虚拟机都要配置哦)

bigdata12

bigdata13

2)执行启动命令

start-dfs.sh

start-dfs.sh

如果在安装过程中出现了问题。可以私聊我的qq。在线帮忙解决。或者将问题发在我qq邮箱1850748316@qq.com,我会第一时间回复你!!

附加一个免密登录的原理图吧!!

===========================================================》》

小bug1:secondNameNode(备份)在bigdata11那个机器上,这样第二名称节点也没有起什么作用!

完全成了摆设

解决方案:先在bigdata11上修改hdfs-site.xlm

添加如下代码

<property>

<!--注意不是https。-->

<name>dfs.namenode.secondary.http-address</name>

<value>bigdata12:50090</value>

</property>

这里只是在bigdata11上修改了。由于是集群模式。所有机子都要修改!!!

直接分发到其他机器就行了

scp hdfs-site.xml bigdata12:$PWD

scp hdfs-site.xml bigdata13:$PWD

重启集群就会发现只有bigdata12上才有secondnamenode

大数据学习之hdfs集群安装部署04的更多相关文章

- 大数据平台搭建-spark集群安装

版本要求 java 版本:1.8.*(1.8.0_60) 下载地址:http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downl ...

- 大数据学习——hadoop2.x集群搭建

1.准备Linux环境 1.0先将虚拟机的网络模式选为NAT 1.1修改主机名 vi /etc/sysconfig/network NETWORKING=yes HOSTNAME=itcast ### ...

- HDFS集群安装部署

准备环境: 三台centos7虚拟机(Node-1,Node-2,Node-3) 配置虚拟机网络,保证三台机器可以互相ping通,并且和宿主机可以互相ping通.如果仅仅是作为虚拟机学习,可以关闭防火 ...

- 2 Hadoop集群安装部署准备

2 Hadoop集群安装部署准备 集群安装前需要考虑的几点硬件选型--CPU.内存.磁盘.网卡等--什么配置?需要多少? 网络规划--1 GB? 10 GB?--网络拓扑? 操作系统选型及基础环境-- ...

- 第06讲:Flink 集群安装部署和 HA 配置

Flink系列文章 第01讲:Flink 的应用场景和架构模型 第02讲:Flink 入门程序 WordCount 和 SQL 实现 第03讲:Flink 的编程模型与其他框架比较 第04讲:Flin ...

- HBase集群安装部署

0x01 软件环境 OS: CentOS6.5 x64 java: jdk1.8.0_111 hadoop: hadoop-2.5.2 hbase: hbase-0.98.24 0x02 集群概况 I ...

- HBase 1.2.6 完全分布式集群安装部署详细过程

Apache HBase 是一个高可靠性.高性能.面向列.可伸缩的分布式存储系统,是NoSQL数据库,基于Google Bigtable思想的开源实现,可在廉价的PC Server上搭建大规模结构化存 ...

- 【分布式】Zookeeper伪集群安装部署

zookeeper:伪集群安装部署 只有一台linux主机,但却想要模拟搭建一套zookeeper集群的环境.可以使用伪集群模式来搭建.伪集群模式本质上就是在一个linux操作系统里面启动多个zook ...

- flink部署操作-flink standalone集群安装部署

flink集群安装部署 standalone集群模式 必须依赖 必须的软件 JAVA_HOME配置 flink安装 配置flink 启动flink 添加Jobmanager/taskmanager 实 ...

随机推荐

- SpringMVC配置与使用

一.MVC概要 MVC是模型(Model).视图(View).控制器(Controller)的简写,是一种软件设计规范,用一种将业务逻辑.数据.显示分离的方法组织代码,MVC主要作用是降低了视图与业务 ...

- RTC及sensor时间同步

https://blog.csdn.net/dai_jing/article/details/38147419 ----------------------------- linux 的系统时间有时跟 ...

- textCNN原理

一.TextCnn的结构 1. 嵌入层(embedding layer) textcnn使用预先训练好的词向量作embedding layer.对于数据集里的所有词,因为每个词都可以表征成一个向量,因 ...

- 数据结构与算法之美学习笔记:B+树(第48讲)

一.解决问题的前提是定义清楚问题 通过对一些模糊需求进行假设,来限定要解决问题的范围 根据某个值查找数据,比如 select * from use where id=1234: 根据区间值来查询某些数 ...

- CentOS使用@Value注解为属性赋值的时候出现乱码

在本地开发用windows的没有出现乱码,在CentOS上运行的时候出现乱码. 1.修改中文的编码方式 (成功) env.properties为ANSI格式 先设置idea编码格式,utf-8, 将 ...

- [Machine Learning] 浅谈LR算法的Cost Function

了解LR的同学们都知道,LR采用了最小化交叉熵或者最大化似然估计函数来作为Cost Function,那有个很有意思的问题来了,为什么我们不用更加简单熟悉的最小化平方误差函数(MSE)呢? 我个人理解 ...

- 关于读取XML文件代码【学习笔记】

public class XmlManager { private XmlDocument m_XMLDoc = null; public XmlManager(XmlDocument xmldoc) ...

- Java(18) 集合框架

一.集合框架 Collectoin Map List set HashMap ArrayList LinkedList ...

- vue.js学习系列-第一篇

VUE系列一 简介 vue是一个兴起的前端js库,是一个精简的MVVM.从技术角度讲,Vue.js专注于 MVVM 模型的 ViewModel 层.它通过双向数据绑定把 View 层和 Mode ...

- Burp插件开发——环境配置

最近打算开发个Burp插件,从网上各种地找资料学习.第一步就应该是环境配置,请见下文. (其实最重要的前提是你已经安装了Burp,否则下面的所有内容都是无稽之谈了. https://pan.baidu ...