Kubernetes如何使用kube-dns实现服务发现

大纲:

• Kubernetes中如何发现服务

• 如何发现Pod提供的服务

• 如何使用Service发现服务

• 如何使用kube-dns发现服务

• kube-dns原理

• 组成

• 域名格式

• 配置

注:本次分享内容基于Kubernetes 1.2版本!

下面从一个简单的例子开始讲解。

1.Kubernetes中如何发现服务

◆ 发现Pod提供的服务

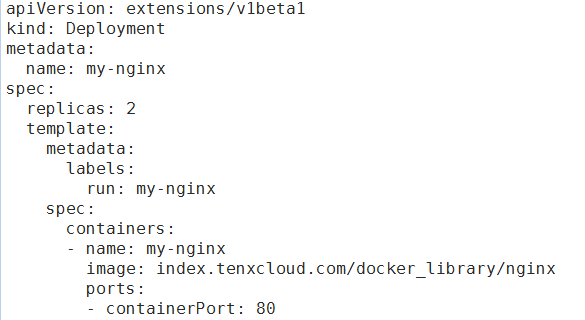

首先使用nginx-deployment.yaml文件创建一个Nginx Deployment,文件内容如图所示:

首先创建两个运行Nginx服务的Pod:

使用kubectl create -f nginx-deployment.yaml指令创建,这样便可以得到两个运行nginx服务的Pod。待Pod运行之后查看一下它们的IP,并在k8s集群内通过podIP和containerPort来访问Nginx服务:

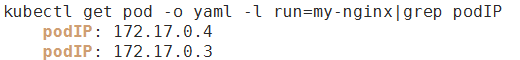

获取Pod IP:

在集群内访问Nginx服务:

看到这里相信很多人会有以下疑问:

1. 每次收到获取podIP太扯了,总不能每次都要手动改程序或者配置才能访问服务吧,要怎么提前知道podIP呢?

2. Pod在运行中可能会重建,IP变了怎么解?

3. 如何在多个Pod中实现负载均衡嘞?

这些问题使用k8s Service就可以解决。

◆ 使用Service发现服务

下面为两个Nginx Pod创建一个Service。使用nginx-service.yaml文件进行创建,文件内容如下:

创建之后,仍需要获取Service的Cluster-IP,再结合Port访问Nginx服务。

Service可以将pod IP封装起来,即使Pod发生重建,依然可以通过Service来访问Pod提供的服务。此外,Service还解决了负载均衡的问题,大家可以多访问几次Service,然后通过kubectl logs <Pod Name>来查看两个Nginx Pod的访问日志来确认。

获取IP:

在集群内访问Service:

虽然Service解决了Pod的服务发现和负载均衡问题,但存在着类似的问题:不提前知道Service的IP,还是需要改程序或配置啊。看到这里有没有感觉身体被掏空?

接下来聊聊kube-dns是如何解决上面这个问题的。

◆ 使用kube-dns发现服务

kube-dns可以解决Service的发现问题,k8s将Service的名称当做域名注册到kube-dns中,通过Service的名称就可以访问其提供的服务。

可能有人会问如果集群中没有部署kube-dns怎么办?没关系,实际上kube-dns插件只是运行在kube-system命名空间下的Pod,完全可以手动创建它。可以在k8s源码(v1.2)的cluster/addons/dns目录下找到两个模板(skydns-rc.yaml.in和skydns-svc.yaml.in)来创建,为大家准备的完整示例文件会在分享结束后提供获取方式,PPT中只截取了部分内容。

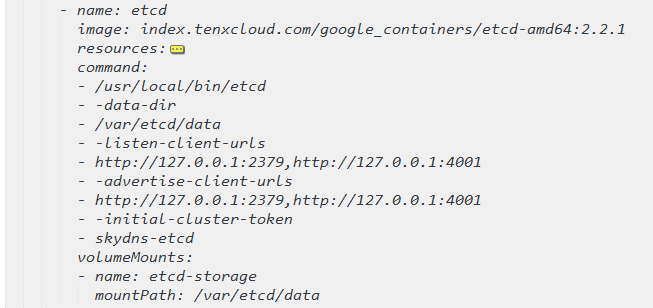

通过skydns-rc.yaml文件创建kube-dns Pod,其中包含了四个containers,这里开始简单过一下文件的主要部分,稍后做详细介绍。

第一部分可以看到kube-dns使用了RC来管理Pod,可以提供最基本的故障重启功能。

创建kube-dns Pod,其中包含了4个containers

接下来是第一个容器 etcd ,它的用途是保存DNS规则。

第二个容器 kube2sky ,作用是写入DNS规则。

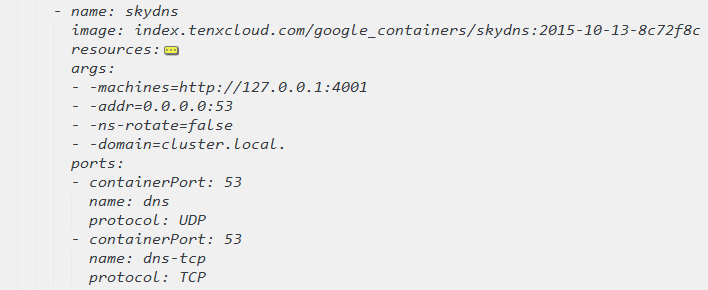

第三个容器是 skydns ,提供DNS解析服务。

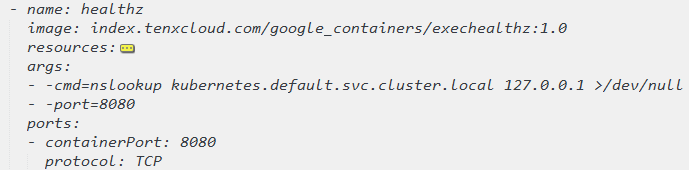

最后一个容器是 healthz ,提供健康检查功能。

有了Pod之后,还需要创建一个Service以便集群中的其他Pod访问DNS查询服务。通过skydns-svc.yaml创建Service,内容如下:

创建完kube-dns Pod和Service,并且Pod运行后,便可以访问kube-dns服务。

下面创建一个Pod,并在该Pod中访问Nginx服务:

创建之后等待kube-dns处于运行状态

再新建一个Pod,通过其访问Nginx服务

在curl-util Pod中通过Service名称访问my-nginx Service:

只要知道需要的服务名称就可以访问,使用kube-dns发现服务就是那么简单。

虽然领略了使用kube-dns发现服务的便利性,但相信有很多人也是一头雾水:kube-dns到底怎么工作的?在集群中启用了kube-dns插件,怎么就能通过名称访问Service了呢?

2.kube-dns原理

◆ Kube-dns组成

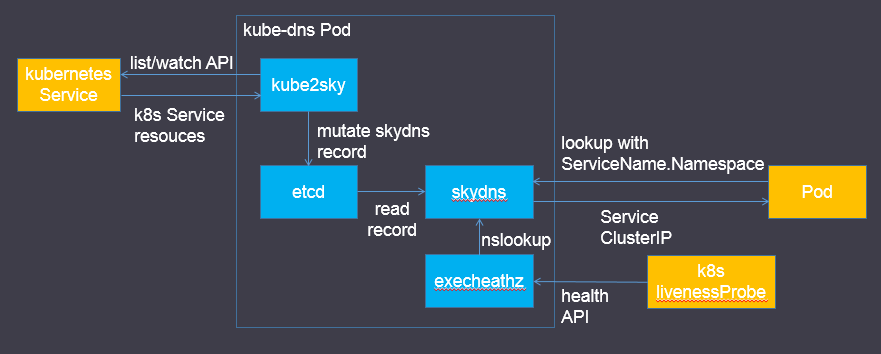

之前已经了解到kube-dns是由四个容器组成的,它们扮演的角色可以通过下面这张图来理解。

其中:

● SkyDNS是用于服务发现的开源框架,构建于etcd之上。作用是为k8s集群中的Pod提供DNS查询接口。项目托管于https://github.com/skynetservices/skydns

● etcd是一种开源的分布式key-value存储,其功能与ZooKeeper类似。在kube-dns中的作用为存储SkyDNS需要的各种数据,写入方为kube2sky,读取方为SkyDNS。项目托管于https://github.com/coreos/etcd。

● kube2sky是k8s实现的一个适配程序,它通过名为kubernetes的Service(通过kubectl get svc可以查看到该Service,由集群自动创建)调用k8s的list和watch API来监听k8s Service资源的变更,从而修改etcd中的SkyDNS记录。代码可以在k8s源码(v1.2)的cluster/addons/dns/kube2sky/目录中找到。

● exec-healthz是k8s提供的一种辅助容器,多用于side car模式中。它的原理是定期执行指定的Linux指令,从而判断当前Pod中关键容器的健康状态。在kube-dns中的作用就是通过nslookup指令检查DNS查询服务的健康状态,k8s livenessProbe通过访问exec-healthz提供的Http API了解健康状态,并在出现故障时重启容器。其源码位于https://github.com/kubernetes/contrib/tree/master/exec-healthz。

● 从图中可以发现,Pod查询DNS是通过ServiceName.Namespace子域名来查询的,但在之前的示例中只用了Service名称,什么原理呢?其实当我们只使用Service名称时会默认Namespace为default,而上面示例中的my-nginx Service就是在default Namespace中,因此是可以正常运行的。关于这一点,后续再深入介绍。

● skydns-rc.yaml中可以发现livenessProbe是设置在kube2sky容器中的,其意图应该是希望通过重启kube2sky来重新写入DNS规则。

◆ 域名格式

接下来了解一下kube-dns支持的域名格式,具体为:<service_name>.<namespace>.svc.<cluster_domain>。

其中cluster_domain可以使用kubelet的--cluster-domain=SomeDomain参数进行设置,同时也要保证kube2sky容器的启动参数中--domain参数设置了相同的值。通常设置为cluster.local。那么之前示例中的my-nginx Service对应的完整域名就是my-nginx.default.svc.cluster.local。看到这里,相信很多人会有疑问,既然完整域名是这样的,那为什么在Pod中只通过Service名称和Namespace就能访问Service呢?下面来解释其中原因。

3.配置

◆ 域名解析配置

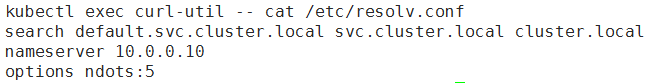

为了在Pod中调用其他Service,kubelet会自动在容器中创建域名解析配置(/etc/resolv.conf),内容为:

感兴趣的可以在网上查找一些resolv.conf的资料来了解具体的含义。之所以能够通过Service名称和Namespace就能访问Service,就是因为search配置的规则。在解析域名时会自动拼接成完整域名去查询DNS。

刚才提到的kubelet --cluster-domain参数与search的具体配置是相对应的。而kube2sky容器的--domain参数影响的是写入到etcd中的域名,kube2sky会获取Service的名称和Namespace,并使用--domain参数拼接完整域名。这也就是让两个参数保持一致的原因。

◆ NS相关配置

kube-dns可以让Pod发现其他Service,那Pod又是如何自动发现kube-dns的呢?在上一节中的/etc/resolv.conf中可以看到nameserver,这个配置就会告诉Pod去哪访问域名解析服务器。

相应的,可以在之前提到的skydns-svc.yaml中看到spec.clusterIP配置了相同的值。通常来说创建一个Service并不需要指定clusterIP,k8s会自动为其分配,但kube-dns比较特殊,需要指定clusterIP使其与/etc/resolv.conf中的nameserver保持一致。

修改nameserver配置同样需要修改两个地方,一个是kubelet的--cluster-dns参数,另一个就是kube-dns Service的clusterIP。

4.总结

接下来重新梳理一下本文的主要内容:

● 在k8s集群中,服务是运行在Pod中的,Pod的发现和副本间负载均衡是我们面临的问题。

● 通过Service可以解决这两个问题,但访问Service也需要对应的IP,因此又引入了Service发现的问题。

● 得益于kube-dns插件,我们可以通过域名来访问集群内的Service,解决了Service发现的问题。

● 为了让Pod中的容器可以使用kube-dns来解析域名,k8s会修改容器的/etc/resolv.conf配置。

有了以上机制的保证,就可以在Pod中通过Service名称和namespace非常方便地访问对应的服务了。

5.Q&A

1. 问: 请问如果公司已有的应用接入的话,那么现有的没有接入的应用就无法访问了,因为这个服务发现是k8s集群内部的,外部无法访问。主要是k8s集群内的服务和集群外的己有的生产的域名访问如何实现,能在kube-dns整合吗?

答:两个问题可以抽象为k8s集群内与集群外服务连通性问题,我们从两个方面讲:

一、集群内访问集群外

这个问题比较简单,集群内的Pod会继承Node上的DNS解析规则。因此只要Node可以访问的服务,Pod中也可以访问到。

另外,在1.4版本中,k8s支持了一种ExternalName类型的Service,可以与一个公网域名绑定,通过该Service可以访问对应公网服务。

二、集群外访问集群内

1. 可以将Service设置为NodePort类型,这样通过任意Node的IP和Service Port便可以访问Service。适合对外的Service比较少的场景。

2. 通过kube-proxy可以对外暴露集群内的服务。

3. 根据实际情况在集群内自定义实现反向代理。

2. 问:我想问下etcd这个容器可以省掉吗?k8s集群有etcd不可以共用吗?

答:理论上可以共用etcd。从隔离性的角度考虑来说还是分开好,这样kube-dns服务不会对整个k8s集群的稳定性产生影响。另外如果把kube-dns看做一个微服务的话,那么应该保证内部组件不依赖外部,可以独立运行。

Kubernetes如何使用kube-dns实现服务发现的更多相关文章

- K8s基于DNS的服务发现(转)

原文地址:https://www.oschina.net/question/2657833_2201246 1.Kubernetes中如何发现服务 ◆ 发现Pod提供的服务 首先使用nginx-d ...

- kubernetes云平台管理实战: 服务发现和负载均衡(五)

一.rc控制器常用命令 1.rc控制器信息查看 [root@k8s-master ~]# kubectl get replicationcontroller NAME DESIRED CURRENT ...

- Kubernetes服务发现之Service详解

一.引子 Kubernetes Pod 是有生命周期的,它们可以被创建,也可以被销毁,然后一旦被销毁生命就永远结束.通过ReplicationController 能够动态地创建和销毁Pod(列如,需 ...

- Kubernetes 服务发现

目录 什么是服务发现? 环境变量 DNS 服务 Linux 中 DNS 查询原理 Kubernetes 中 DNS 查询原理 调试 DNS 服务 存根域及上游 DNS 什么是服务发现? 服务发现就是一 ...

- Kubernetes服务发现入门:如何高效管理服务?

愈发复杂的应用程序正在依靠微服务来保持可扩展性和提升效率.Kubernetes为微服务提供了完美的环境,并能够让其与Kubernetes的工具组件和功能兼容.当应用程序的每个部分放置在一个容器中,整个 ...

- Prometheus在Kubernetes下的服务发现机制

Prometheus作为容器监控领域的事实标准,随着以Kubernetes为核心的云原生热潮的兴起,已经得到了广泛的应用部署.灵活的服务发现机制是Prometheus和Kubernetes两者得以连接 ...

- SpringCloud之Nacos服务发现(十七)

一 Nacos简介 Nacos是以服务为主要服务对象的中间件,Nacos支持所有主流的服务发现.配置和管理. Nacos主要提供以下四大功能: 服务发现与服务健康检查 Nacos使服务更容易注册自己并 ...

- Kubernetes+Federation打造跨多云管理服务

Kubernetes日渐普及,在公有云.私有云等多个环境中部署kubernetes集群已是常规做法,而随着环境的复杂多样和集群数量增长,如何高效地管理这些集群成为新的问题.于是跨多云管理服务应运而生. ...

- k8s全方位监控-prometheus-配置文件介绍以及基于文件服务发现

1.scrape_configs 参数介绍 # 默认的全局配置 global: scrape_interval: 15s # 采集间隔15s,默认为1min一次 evaluation_interval ...

- 基于Docker的负载均衡和服务发现

应用的容器化和微服务化带来的问题 在缺省网络模型中,容器每次重启后,IP会发生变动,在一个大的分布式系统保证IP地址不变是比较复杂的事情 IP频繁发生变动,动态应用部署无法预知容器的IP地址,clie ...

随机推荐

- 使用Axure来仿真Vogue网站

用户体验包括三部分:用户研究.视觉设计和交互设计.按顺序进行,在用户研究和视觉设计之后,开始交互设计,Axure是最好的交互设计的软件. Vogue是著名的奢侈品品牌,网站设计“高大上”,用Axure ...

- yii2更改面包屑的首页链接

<?= Breadcrumbs::widget([ 'homeLink' => ['label' => 'Home', 'url' => Yii::$app->getHo ...

- tomcat 8在win8.1中的配置

配置jdk: 三个步骤: 1.环境变量=>新建 JAVA_HOME C:\Program Files\Java\jdk1.8.0_40 2.环境变量=>新建 CLASS_PATH .;%J ...

- Android ViewPager 用法

Android ViewPager 用法 场景:一般第一次打开应用程序时,程序会有一个提示页来给展现应用程序都有哪些功能:或者程序更新时,又更新哪些新特性,都可以使用ViewPager Demo 描述 ...

- JAVA使用POI操作excel

文中处理的excel是2003年以前的版本,使用HSSFworkbook,如果处理2007版本以后的excel,用XSSFworkbook,对于二者的兼容性问题,可参考 http://blog.csd ...

- cmd输出的日志里有中文乱码的解决办法

在命令行使用adb logcat命令直接输出日志中文内容显示乱码,原因是中文系统中cmd命令行窗口默认的编码是GBK,而LogCat打印的日志是UTF-8编码,所以adb logcat命令输出的中文内 ...

- jar包合并

多个jar包合并: 1.首先将所以要合并的jar包解压到同一目录中.jar xvf xxx.jar 2.用jar命令将所有.class, .aidl文件打包. jar cvf output.jar ...

- 2013-08-12【随笔2】-Roy

最近总是因为一下小事情,就会变得闹心,就会自己胡思乱想,自己吓唬自己,自己给自己找烦恼. 是因为每天无所事事,日子过得没有了重点,然后每天人心惶惶,有点杞人忧天了. 还是因为这样平淡的日子,消磨了我们 ...

- Java 对象内存占用

java基本类型及对象占用的内存大小 请参考下面文章 原始类型及对象占用的内存大小 http://www.javamex.com/tutorials/memory/object_memory_usag ...

- 让人一用钟情的VS插件系列之一——Web Essentials(Web开发必备利器)

返回VS插件总目录 本篇目录 初识Web Essentials 看国外大牛如何评价Web Essentials Web Essentials下载与安装 Web Essentials涉及到了哪些内容 初 ...