MapReduce统计每个用户的使用总流量

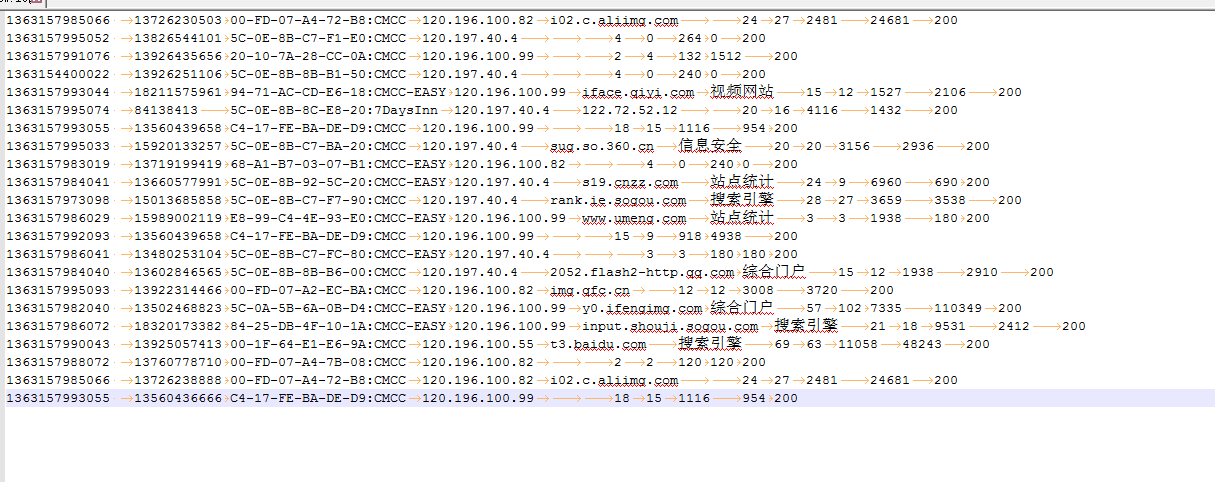

1、原始数据

2、使用java程序

1)新建项目

2)导包

hadoop-2.7.3\share\hadoop\mapreduce

+hsfs的那些包

+common

3、写项目

1)实体类

注:属性直接定义为String和 Long定义更方便

package com.zy.flow; import java.io.DataInput;

import java.io.DataOutput;

import java.io.IOException; import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.io.Writable; public class Flow implements Writable{//Writable可序列化的(序列化:把对象变成二进制流 反序列化:把二进制流变成对象)

//包含 电话 上行流量 下行流量 总流量

private Text phone;

private LongWritable upflow;//上行

private LongWritable downflow;//下行

private LongWritable sumflow;//总流量

//这个对象以后要在集群中传输,所以要可序列化 //序列化反序列化顺序要一致

@Override//反序列化时会调用该方法

public void readFields(DataInput in) throws IOException {

phone=new Text(in.readUTF());

upflow=new LongWritable(in.readLong());

downflow=new LongWritable(in.readLong());

sumflow=new LongWritable(in.readLong());

} @Override//序列化时会调用该方法

public void write(DataOutput out) throws IOException {

out.writeUTF(phone.toString());

out.writeLong(upflow.get());

out.writeLong(downflow.get());

out.writeLong(sumflow.get()); }

public Text getPhone() {

return phone;

}

public void setPhone(Text phone) {

this.phone = phone;

}

public LongWritable getUpflow() {

return upflow;

}

public void setUpflow(LongWritable upflow) {

this.upflow = upflow;

}

public LongWritable getDownflow() {

return downflow;

}

public void setDownflow(LongWritable downflow) {

this.downflow = downflow;

}

public LongWritable getSumflow() {

return sumflow;

}

public void setSumflow(LongWritable sumflow) {

this.sumflow = sumflow;

}

public Flow() { }

public Flow(Text phone, LongWritable upflow, LongWritable downflow, LongWritable sumflow) {

super();

this.phone = phone;

this.upflow = upflow;

this.downflow = downflow;

this.sumflow = sumflow;

}

public Flow(LongWritable upflow, LongWritable downflow, LongWritable sumflow) {

super();

this.upflow = upflow;

this.downflow = downflow;

this.sumflow = sumflow;

} @Override//toString最后就是reduce中输出值的样式

public String toString() {

//输出样式

return upflow+"\t"+downflow+"\t"+sumflow;

} }

2)FlowMap类

package com.zy.flow; import java.io.IOException; import javax.security.auth.callback.LanguageCallback; import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper; public class FlowMap extends Mapper<LongWritable, Text, Text, Flow>{ @Override

protected void map(LongWritable key, Text value, Mapper<LongWritable, Text, Text, Flow>.Context context)

throws IOException, InterruptedException {

//输入的值 value

//切分value 寻找有价值的列

String[] split = value.toString().split("\t");

int length=split.length;

//取哪几列split[1] split[length-3] split[length-2]

String phone=split[1];

Long upflow=Long.parseLong(split[length-3]);

Long downflow=Long.parseLong(split[length-2]);

Long sumflow=upflow+downflow;

//输出

context.write(new Text(phone), new Flow(new Text(phone), new LongWritable(upflow), new LongWritable(downflow),new LongWritable(sumflow)));

//对象里虽然用不到phone但是要给它赋值,不然序列化时会报空指针异常

}

}

3)Part(分区)类

package com.zy.flow;

import java.util.HashMap;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Partitioner;

// map的输出是suffer的输入

public class Part extends Partitioner<Text, Flow> {//分区

//逻辑自己写 HashMap<String,Integer> map = new HashMap(); public void setMap(){

map.put("135",0);

map.put("136", 1);

map.put("137",2);

map.put("138", 3);

map.put("139",4);

}

// 生成的文件 part-00000 part的编号的结尾就是这个int类型的返回值;

@Override

public int getPartition(Text key, Flow value, int arg2) { setMap();

//从输入的数据中获得电话的前三位跟map对比。决定分到哪个区中

String substring = key.toString().substring(0, 3);//例如截取135 return map.get(substring)==null?5:map.get(substring);//根据键取值 键135 取出0

//其他号码分到(编号为5)第6个区中

}

//在这个逻辑下partition分了6个区,所以以后要指定6个reducetask }

4)FlowReduce类

package com.zy.flow; import java.io.IOException; import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; public class FlowReduce extends Reducer<Text, Flow, Text, Flow>{

@Override

protected void reduce(Text key, Iterable<Flow> value, Reducer<Text, Flow, Text, Flow>.Context context)

throws IOException, InterruptedException {

//累加

long allup=0;

long alldown=0;

for (Flow flow : value) {

allup+=Long.parseLong(flow.getUpflow().toString());//同一个电话的上行流量累加

alldown+=Long.parseLong(flow.getDownflow().toString());//同一个电话的下行流量累加 }

long allsum=allup+alldown;

context.write(key, new Flow(new Text(key), new LongWritable(allup), new LongWritable(alldown), new LongWritable(allsum)));

} }

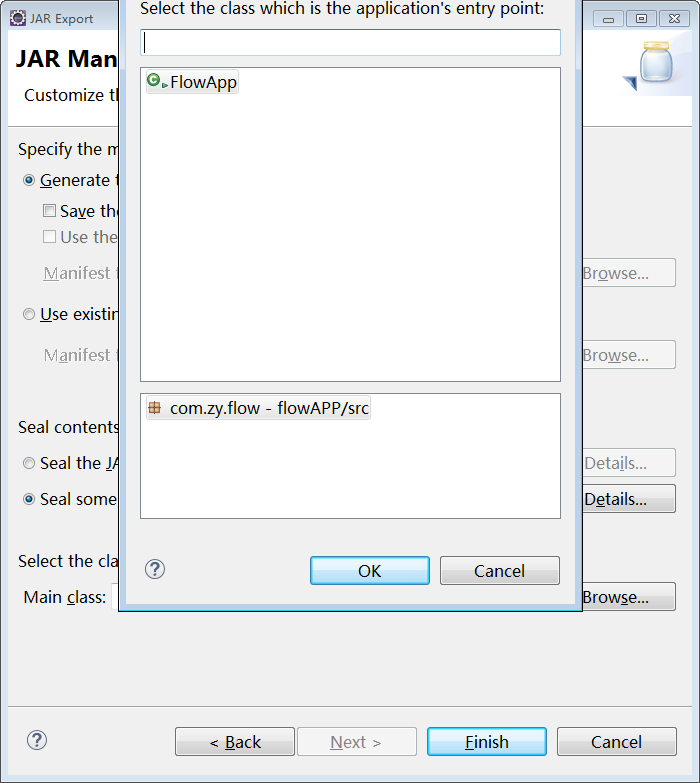

5)FlowApp类

package com.zy.flow; import java.io.IOException; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text; import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; public class FlowApp { public static void main(String[] args) throws Exception {

//创建配置对象

Configuration configuration = new Configuration();

//得到job实例

Job job = Job.getInstance(configuration);

//指定job运行类

job.setJarByClass(FlowApp.class); //指定job中的mapper

job.setMapperClass(FlowMap.class);

//指定mapper中的输出键和值类型

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(Flow.class); //指定job中的reducer

job.setReducerClass(FlowReduce.class);

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(Flow.class); //-----

//指定Partitioner使用的类

job.setPartitionerClass(Part.class);

//指定ReduceTask数量

job.setNumReduceTasks(6);

//----- //指定输入文件

FileInputFormat.setInputPaths(job, new Path(args[0]));//运行时填入参数

//指定输出文件

FileOutputFormat.setOutputPath(job, new Path(args[1]));

//提交作业

job.waitForCompletion(true); } }

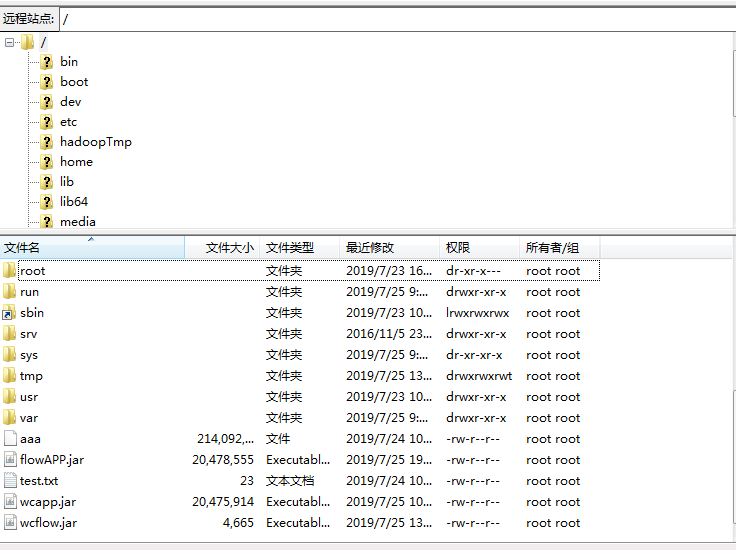

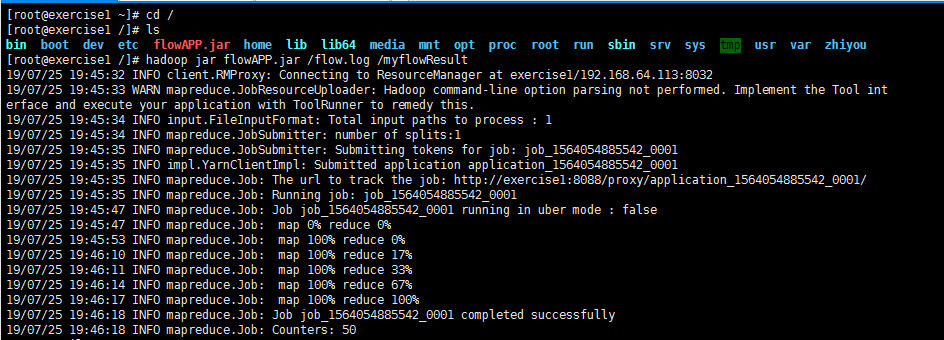

4、运行

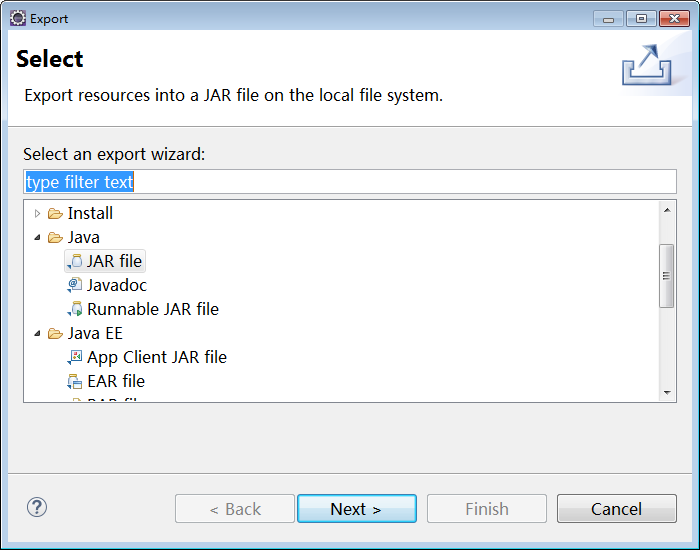

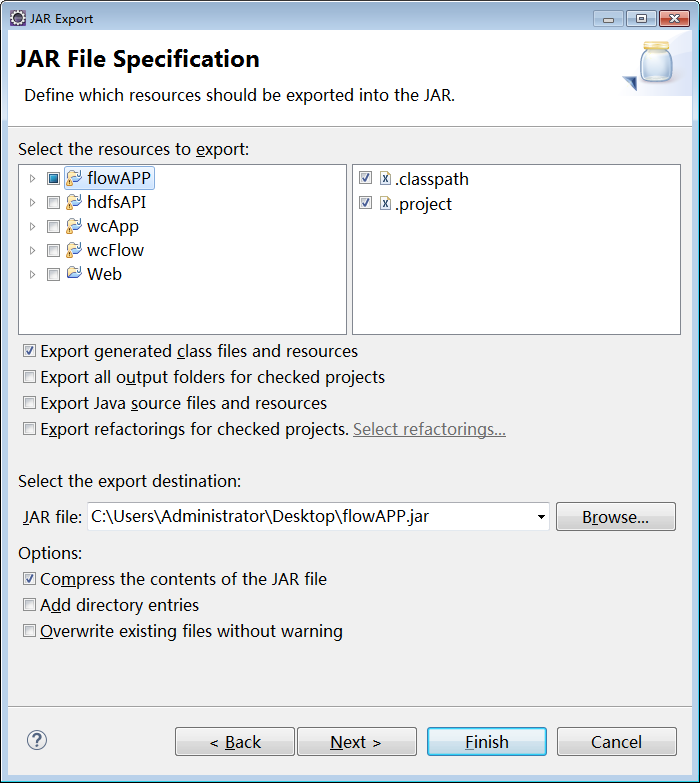

1)打包

2)上传到linux

3)运行

MapReduce统计每个用户的使用总流量的更多相关文章

- MongoDb 用 mapreduce 统计留存率

MongoDb 用 mapreduce 统计留存率(金庆的专栏)留存的定义采用的是新增账号第X日:某日新增的账号中,在新增日后第X日有登录行为记为留存 输出如下:(类同友盟的留存率显示)留存用户注册时 ...

- 使用 Redis 统计在线用户人数

在构建应用的时候, 我们经常需要对用户的一举一动进行记录, 而其中一个比较重要的操作, 就是对在线的用户进行记录. 本文将介绍四种使用 Redis 对在线用户进行记录的方案, 这些方案虽然都可以对在线 ...

- Hadoop基础-Map端链式编程之MapReduce统计TopN示例

Hadoop基础-Map端链式编程之MapReduce统计TopN示例 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.项目需求 对“temp.txt”中的数据进行分析,统计出各 ...

- Tomcat集群下获取memcached缓存对象数量,统计在线用户数据量

项目需要统计在线用户数量,系统部署在集群环境下,使用会话粘贴的方式解决Session问题.要想得到真实在线用户数,必须是所有节点的总和. 这里考虑使用memcached存放用户登录数据,key为use ...

- 用HttpSessionListener统计在线用户或做账号在线人数管理

使用HttpSessionListener接口可监听session的创建和失效 session是在用户第一次访问页面时创建 在session超时或调用request.getSession().inva ...

- 拼多多后台开发面试真题:如何用Redis统计独立用户访问量

众所周至,拼多多的待遇也是高的可怕,在挖人方面也是不遗余力,对于一些工作3年的开发,稍微优秀一点的,都给到30K的Offer,当然,拼多多加班也是出名的,一周上6天班是常态,每天工作时间基本都是超过1 ...

- 拼多多面试真题:如何用 Redis 统计独立用户访问量!

阅读本文大概需要 2.8 分钟. 作者:沙茶敏碎碎念 众所周至,拼多多的待遇也是高的可怕,在挖人方面也是不遗余力,对于一些工作 3 年的开发,稍微优秀一点的,都给到 30K 的 Offer. 当然,拼 ...

- 从GoogleClusterData统计每个用户的使用率、平均每次出价

之前将google cluster data导入了Azure上的MySQL数据库,下一步就是对这些数据进行分析, 挖掘用户的使用规律了. 首先,为了加快执行速度,对user,time等加入索引. 然后 ...

- 如何用 Redis 统计独立用户访问量

众所周至,拼多多的待遇也是高的可怕,在挖人方面也是不遗余力,对于一些工作3年的开发,稍微优秀一点的,都给到30K的Offer,当然,拼多多加班也是出名的,一周上6天班是常态,每天工作时间基本都是超过1 ...

随机推荐

- 风炫安全WEB安全学习第十八节课 使用SQLMAP自动化注入(二)

风炫安全WEB安全学习第十八节课 使用SQLMAP自动化注入(二) –is-dba 当前用户权限(是否为root权限) –dbs 所有数据库 –current-db 网站当前数据库 –users 所有 ...

- 项目API接口鉴权流程总结

权益需求对接中,公司跟第三方公司合作,有时我们可能作为甲方,提供接口给对方,有时我们也作为乙方,调对方接口,这就需要API使用签名方法(Sign)对接口进行鉴权.每一次请求都需要在请求中包含签名信息, ...

- Second_week_mofangzhen

第二周 奇数阶魔方阵 一.上节回顾 1.数组的基本操作 数组:若干个相同类型变量的集合. 声明:数据类型 数组名称[]; (在栈内存分配空间,存储的是数组的引用地址.数组首元素在堆内存 中的地址) 初 ...

- JAVA原生mvc实现用户信息的增删查改

笔者最近学完jsp和servlet,于是心血来潮的打算写个简单的用户案例 环境准备: 开发工具eclipse jdk-1.8.0_72 tomcat-9.0.5 前端部分: 1.自己手写了一套样式 2 ...

- 万万没想到,JVM内存区域的面试题也可以问的这么难?

二.Java内存区域 1.Java内存结构 内存结构 程序计数器 当前线程所执行字节码的行号指示器.若当前方法是native的,那么程序计数器的值就是undefined. 线程私有,Java内存区域中 ...

- halcon案例学习之cbm_label_simple

*cbm_label_simple 程序说明:*这个示例程序展示了如何使用基于组件的匹配来定位复合对象.在这种情况下,应该在图像中找到一个标签,用户既不知道其中的组件,也不知道它们之间的关系.因此,创 ...

- 【Flutter】功能型组件之异步UI更新

前言 很多时候会依赖一些异步数据来动态更新UI,比如在打开一个页面时我们需要先从互联网上获取数据,在获取数据的过程中我们显示一个加载框,等获取到数据时我们再渲染页面:又比如想展示Stream(比如文件 ...

- ASP.NET Core - JWT认证实现

一.JWT结构 JWT介绍就太多了,这里主要关注下Jwt的结构. Jwt中包含三个部分:Header(头部).Payload(负载).Signature(签名) Header:描述 JWT 的元数据的 ...

- 【MySQL】SELECT语句 - 查询数据

第4章 检索数据 文章目录 第4章 检索数据 1.SELECT语句 2.检索单个列 3.检索多个列 4.检索所有列 5.检索不同的行 6.限制结果 7.使用完全限定的表名 8.小结 简单记录 - My ...

- SpringBoot Logback无法获取配置中心属性

SpringBoot Logback无法获取配置中心属性 前言 最近在做项目中,需要把项目中的日志信息通过RabbitMQ将规定格式的消息发送到消息队列中,然后ELK系统通过消息队列拿日志并且保存起来 ...