Flink的DataSource三部曲之二:内置connector

欢迎访问我的GitHub

https://github.com/zq2599/blog_demos

内容:所有原创文章分类汇总及配套源码,涉及Java、Docker、Kubernetes、DevOPS等;

本篇概览

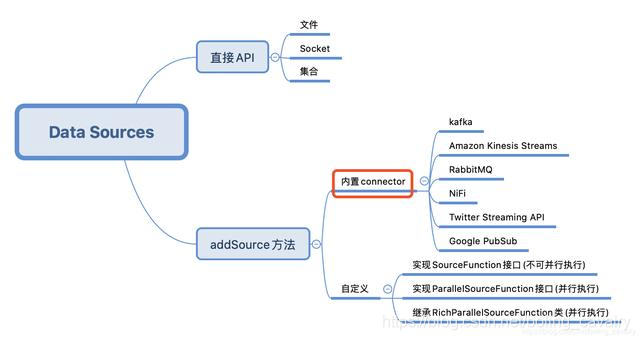

本文是《Flink的DataSource三部曲》系列的第二篇,上一篇《Flink的DataSource三部曲之一:直接API》学习了StreamExecutionEnvironment的API创建DataSource,今天要练习的是Flink内置的connector,即下图的红框位置,这些connector可以通过StreamExecutionEnvironment的addSource方法使用:

今天的实战选择Kafka作为数据源来操作,先尝试接收和处理String型的消息,再接收JSON类型的消息,将JSON反序列化成bean实例;

Flink的DataSource三部曲文章链接

源码下载

如果您不想写代码,整个系列的源码可在GitHub下载到,地址和链接信息如下表所示(https://github.com/zq2599/blog_demos):

| 名称 | 链接 | 备注 |

|---|---|---|

| 项目主页 | https://github.com/zq2599/blog_demos | 该项目在GitHub上的主页 |

| git仓库地址(https) | https://github.com/zq2599/blog_demos.git | 该项目源码的仓库地址,https协议 |

| git仓库地址(ssh) | git@github.com:zq2599/blog_demos.git | 该项目源码的仓库地址,ssh协议 |

这个git项目中有多个文件夹,本章的应用在flinkdatasourcedemo文件夹下,如下图红框所示:

环境和版本

本次实战的环境和版本如下:

- JDK:1.8.0_211

- Flink:1.9.2

- Maven:3.6.0

- 操作系统:macOS Catalina 10.15.3 (MacBook Pro 13-inch, 2018)

- IDEA:2018.3.5 (Ultimate Edition)

- Kafka:2.4.0

- Zookeeper:3.5.5

请确保上述内容都已经准备就绪,才能继续后面的实战;

Flink与Kafka版本匹配

- Flink官方对匹配Kafka版本做了详细说明,地址是:https://ci.apache.org/projects/flink/flink-docs-stable/dev/connectors/kafka.html

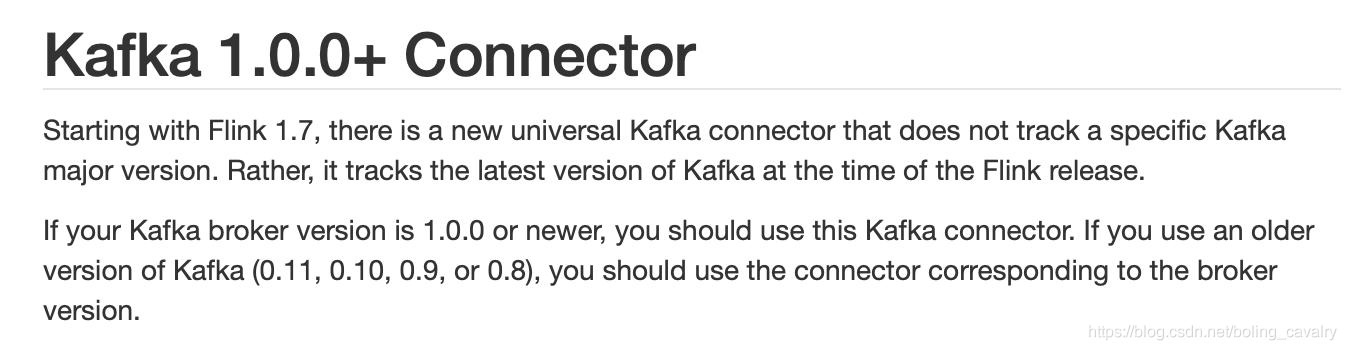

- 要重点关注的是官方提到的通用版(universal Kafka connector ),这是从Flink1.7开始推出的,对于Kafka1.0.0或者更高版本都可以使用:

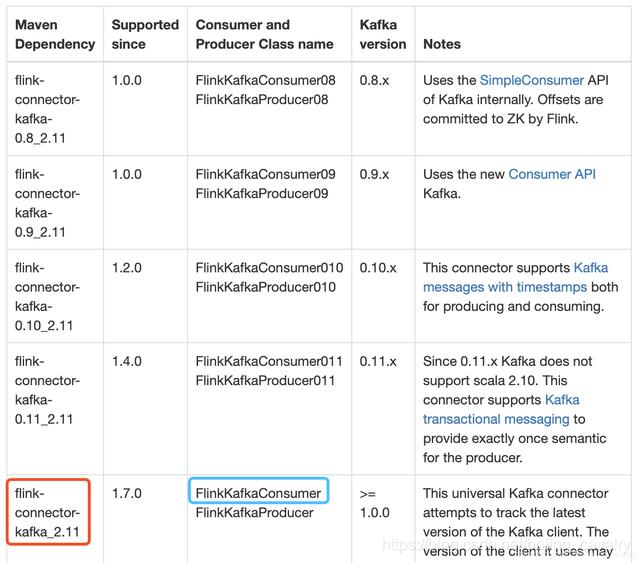

3. 下图红框中是我的工程中要依赖的库,蓝框中是连接Kafka用到的类,读者您可以根据自己的Kafka版本在表格中找到适合的库和类:

实战字符串消息处理

- 在kafka上创建名为test001的topic,参考命令:

./kafka-topics.sh \

--create \

--zookeeper 192.168.50.43:2181 \

--replication-factor 1 \

--partitions 2 \

--topic test001

- 继续使用上一章创建的flinkdatasourcedemo工程,打开pom.xml文件增加以下依赖:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka_2.11</artifactId>

<version>1.10.0</version>

</dependency>

- 新增类Kafka240String.java,作用是连接broker,对收到的字符串消息做WordCount操作:

package com.bolingcavalry.connector;

import com.bolingcavalry.Splitter;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.windowing.time.Time;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer;

import java.util.Properties;

import static com.sun.tools.doclint.Entity.para;

public class Kafka240String {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

//设置并行度

env.setParallelism(2);

Properties properties = new Properties();

//broker地址

properties.setProperty("bootstrap.servers", "192.168.50.43:9092");

//zookeeper地址

properties.setProperty("zookeeper.connect", "192.168.50.43:2181");

//消费者的groupId

properties.setProperty("group.id", "flink-connector");

//实例化Consumer类

FlinkKafkaConsumer<String> flinkKafkaConsumer = new FlinkKafkaConsumer<>(

"test001",

new SimpleStringSchema(),

properties

);

//指定从最新位置开始消费,相当于放弃历史消息

flinkKafkaConsumer.setStartFromLatest();

//通过addSource方法得到DataSource

DataStream<String> dataStream = env.addSource(flinkKafkaConsumer);

//从kafka取得字符串消息后,分割成单词,统计数量,窗口是5秒

dataStream

.flatMap(new Splitter())

.keyBy(0)

.timeWindow(Time.seconds(5))

.sum(1)

.print();

env.execute("Connector DataSource demo : kafka");

}

}

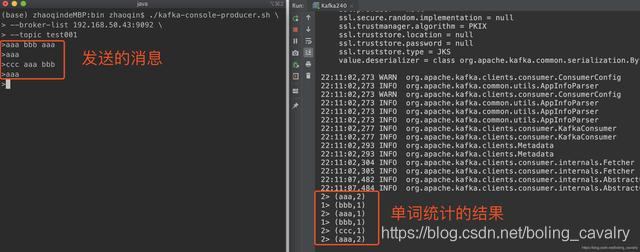

- 确保kafka的topic已经创建,将Kafka240运行起来,可见消费消息并进行单词统计的功能是正常的:

5. 接收kafka字符串消息的实战已经完成,接下来试试JSON格式的消息;

实战JSON消息处理

- 接下来要接受的JSON格式消息,可以被反序列化成bean实例,会用到JSON库,我选择的是gson;

- 在pom.xml增加gson依赖:

<dependency>

<groupId>com.google.code.gson</groupId>

<artifactId>gson</artifactId>

<version>2.8.5</version>

</dependency>

- 增加类Student.java,这是个普通的Bean,只有id和name两个字段:

package com.bolingcavalry;

public class Student {

private int id;

private String name;

public int getId() {

return id;

}

public void setId(int id) {

this.id = id;

}

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

}

- 增加类StudentSchema.java,该类是DeserializationSchema接口的实现,将JSON反序列化成Student实例时用到:

ackage com.bolingcavalry.connector;

import com.bolingcavalry.Student;

import com.google.gson.Gson;

import org.apache.flink.api.common.serialization.DeserializationSchema;

import org.apache.flink.api.common.serialization.SerializationSchema;

import org.apache.flink.api.common.typeinfo.TypeInformation;

import java.io.IOException;

public class StudentSchema implements DeserializationSchema<Student>, SerializationSchema<Student> {

private static final Gson gson = new Gson();

/**

* 反序列化,将byte数组转成Student实例

* @param bytes

* @return

* @throws IOException

*/

@Override

public Student deserialize(byte[] bytes) throws IOException {

return gson.fromJson(new String(bytes), Student.class);

}

@Override

public boolean isEndOfStream(Student student) {

return false;

}

/**

* 序列化,将Student实例转成byte数组

* @param student

* @return

*/

@Override

public byte[] serialize(Student student) {

return new byte[0];

}

@Override

public TypeInformation<Student> getProducedType() {

return TypeInformation.of(Student.class);

}

}

- 新增类Kafka240Bean.java,作用是连接broker,对收到的JSON消息转成Student实例,统计每个名字出现的数量,窗口依旧是5秒:

package com.bolingcavalry.connector;

import com.bolingcavalry.Splitter;

import com.bolingcavalry.Student;

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.api.common.serialization.SimpleStringSchema;

import org.apache.flink.api.java.tuple.Tuple2;

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.windowing.time.Time;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer;

import java.util.Properties;

public class Kafka240Bean {

public static void main(String[] args) throws Exception {

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

//设置并行度

env.setParallelism(2);

Properties properties = new Properties();

//broker地址

properties.setProperty("bootstrap.servers", "192.168.50.43:9092");

//zookeeper地址

properties.setProperty("zookeeper.connect", "192.168.50.43:2181");

//消费者的groupId

properties.setProperty("group.id", "flink-connector");

//实例化Consumer类

FlinkKafkaConsumer<Student> flinkKafkaConsumer = new FlinkKafkaConsumer<>(

"test001",

new StudentSchema(),

properties

);

//指定从最新位置开始消费,相当于放弃历史消息

flinkKafkaConsumer.setStartFromLatest();

//通过addSource方法得到DataSource

DataStream<Student> dataStream = env.addSource(flinkKafkaConsumer);

//从kafka取得的JSON被反序列化成Student实例,统计每个name的数量,窗口是5秒

dataStream.map(new MapFunction<Student, Tuple2<String, Integer>>() {

@Override

public Tuple2<String, Integer> map(Student student) throws Exception {

return new Tuple2<>(student.getName(), 1);

}

})

.keyBy(0)

.timeWindow(Time.seconds(5))

.sum(1)

.print();

env.execute("Connector DataSource demo : kafka bean");

}

}

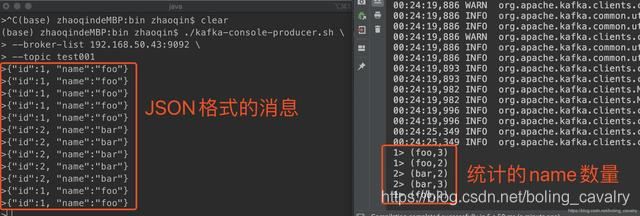

- 在测试的时候,要向kafka发送JSON格式字符串,flink这边就会给统计出每个name的数量:

至此,内置connector的实战就完成了,接下来的章节,我们将要一起实战自定义DataSource;

欢迎关注公众号:程序员欣宸

微信搜索「程序员欣宸」,我是欣宸,期待与您一同畅游Java世界...

https://github.com/zq2599/blog_demos

Flink的DataSource三部曲之二:内置connector的更多相关文章

- Flink的DataSource三部曲之一:直接API

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- Flink的DataSource三部曲之三:自定义

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- Flink on Yarn三部曲之二:部署和设置

欢迎访问我的GitHub https://github.com/zq2599/blog_demos 内容:所有原创文章分类汇总及配套源码,涉及Java.Docker.Kubernetes.DevOPS ...

- ASP.NET Core 2.1 : 十二.内置日志、使用Nlog将日志输出到文件

应用离不开日志,虽然现在使用VS有强大的调试功能,开发过程中不复杂的情况懒得输出日志了(想起print和echo的有木有),但在一些复杂的过程中以及应用日常运行中的日志还是非常有用. ASP.NET ...

- 菜鸟日记之JSP二 内置对象的理解

·最近学习JSP了,对编程和网络又有了一些理解.无论是现实中人与人的交流,还是网络世界的接触,都是在相互表达自己的意思让别人知道,并理解对方的信息.然后我们知道的事情不断的变多,会又交杂出新的内容,不 ...

- 模拟Springboot二:内置tomcat

既然要将tomcat内置到项目中,并且能够成功的启动项目就要知道 tomcat 做了哪些事情 ,那么就必须先搞明白 一个 普通的web项目是如何被我们本地配置的tomcat启动并运行的 (1). 先 ...

- python之字典二 内置方法总结

Python字典包含了以下内置方法: clear()函数用于删除字典内所有元素 dict1 = {, 'Class': 'First'} print('the start len %d' % len( ...

- ASP 基础二 内置对象

一 Request 二 Response 三 Application 四 Session 五 Server <script language="vbscript" runat ...

- day0318装饰器和内置函数

一.装饰器 1.装饰器: 解释:装饰器的本事就是一个函数,不改动主代码的情况下,增加新功能.返回值也是一个函数对象. 2.装饰器工作过程 import time def func(): print(' ...

随机推荐

- osgEarth使用笔记4——加载矢量数据

目录 1. 概述 2. 详论 2.1. 基本绘制 2.2. 矢量符号化 2.2.1. 可见性 2.2.2. 高度设置 2.2.3. 符号化 2.2.4. 显示标注 2.3. 其他 3. 结果 4. 问 ...

- Linux 串口工具 lsz lrz 移植

//之前写的,刚才不小心误删了,所以重新再发出来. 1 下载源码包 首先下载最新版的lrzsz,地址:https://ohse.de/uwe/software/lrzsz.html.下面以 0.12. ...

- 【题解】NOIP2018 填数游戏

题目戳我 \(\text{Solution:}\) 题目标签是\(dp,\)但是纯暴力打表找规律可以有\(65\)分. 首先是对于\(O(2^{nm}*nm)\)的暴力搜索,显然都会. 考虑几条性质: ...

- 教你两步快速使用华为HMS沙盒(沙箱)测试

沙盒(沙箱)测试允许在开发者在接入华为应用内支付IAP联调过程中无需真实支付即可完成端到端的测试. 第一步:添加测试账号 在AppGallery Connect中的"用户与访问"添 ...

- Python日志采集(详细)

通常在前期调试代码的时候,我们会使用print在IDE控制台打印一些信息,判断运行情况.但在运行整个自动化测试项目的过程中,通过print打印信息的方式获取运行情况显然行不通. 这时就需要收集日志,每 ...

- IdentityServer 3.1.x 迁移到 4.x

一.前言 IdentityServer4 4.x已经正式发布了,根据官方的 Release Note,3.1.x 到 4.x 的变更也是非常多,今天在将代码迁移到 4.x 遇到了一些问题在此记录下来, ...

- 2020已经过去五分之四了,你确定还不来了解一下JS的rAF?

不会吧,不会吧,现在都2020年了不会还真人有人不知道JS的rAF吧??? rAF 简介 rAF是requestAnimationFrame的简称: 我们先从字面意思上理解requestAnimati ...

- scp带密码拷贝文件

应用场景:将B服务器的文件传输到A服务器.核心命令: sshpass -p 123456 scp ubuntu@192.168.52.1:/home/ubuntu/"TEST"'' ...

- linux(centos8):lnmp环境编译安装zabbix5.0

一,zabbix的用途: zabbix是一个基于WEB界面的提供分布式系统监视以及网络监视功能的企业级的开源解决方案 zabbix能监视各种网络参数,保证服务器系统的安全运营: 并提供灵活的通知机制以 ...

- python+selenium 爬取中国工业园网

import math import re import requests from lxml import etree type = "https://www.cnrepark.com/g ...