关联分析中寻找频繁项集的FP-growth方法

关联分析是数据挖掘中常用的分析方法。一个常见的需求比如说寻找出经常一起出现的项目集合。

引入一个定义,项集的支持度(support),是指所有包含这个项集的集合在所有数据集中出现的比例。

规定一个最小支持度,那么不小于这个最小支持度的项集称为频繁项集(frequent item set)。

如何找到数据集中所有的频繁项集呢?

最简单的方法是对所有项集进行统计,可以通过逐渐增大项集大小的方式来遍历所有项集。比如说下面的数据集,先统计所有单个元素集合的支持度,{z} 的支持度为5 (这里把项目出现次数作为支持度,方便描述),然后逐渐增大项集大小,比如{z,r} 的支持度为1

| 数据集ID | 数据 |

| 001 | r, z, h, j, p |

| 002 | z, y, x, w, v, u, t, s |

| 003 | z |

| 004 | r, x, n, o, s |

| 005 | y, r, x, z, q, t, p |

| 006 | y, z, x, e, q, s, t, m |

显然这样的方式,计算量很大,当项目增多,项集的数目是指数增长的。当然我们也可以应用一些规律

1)如果一个项集是频繁项集,那么它的子集都是频繁项集

2)如果一个项集不是频繁项集,那么它的超集也不是频繁项集

Apriori算法就是应用了这些方法可以减少寻找频繁项集的计算。而FP-Growth算法则另辟蹊径,它在遍历数据的时候构造一个树结构,当树构造完成,每个节点记录的值就是这个节点到根节点路径上的项集的支持度。

首先对数据集中的数据按单个元素的支持度进行重排

| 数据集ID | 数据 | 按单元数支持度重排后的数据 |

| 001 | r, z, h, j, p | z, r |

| 002 | z, y, x, w, v, u, t, s | z, x, y, s, t |

| 003 | z | z |

| 004 | r, x, n, o, s | x, s, r |

| 005 | y, r, x, z, q, t, p | z, x, y, r, t |

| 006 | y, z, x, e, q, s, t, m | z, x, y, s, t |

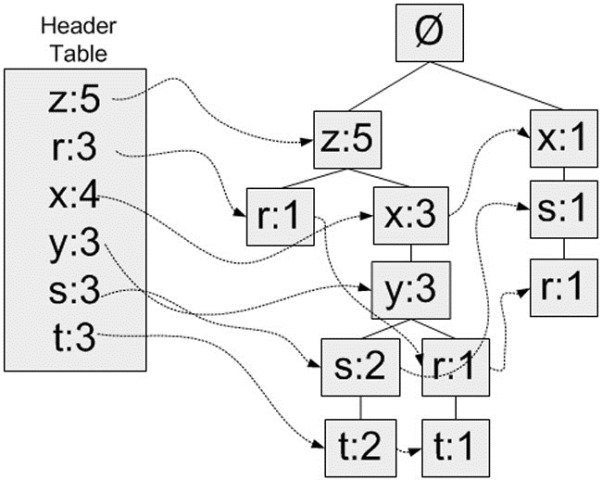

然后把每一行数依次拿来构建FP树。把重排后每一行数据从左到右入树。从空集开始,如果树中已存在现有元素,则增加现有元素的值;如果现有元素不存在,则向树添加一个分支。

树构造完成后,以{x:3}这个节点为例,它表示了从这个节点到根节点路径上集合{x,z}的支持度为3。

那么问题来了,我们如何保证我们能获得所有的频繁项集,即支持度大于最小支持度的项集。是找出节点值大于最小支持度就够了吗?比如设最小支持度为3,从树上可以看出{z,x,y}的支持度为3,但是仔细观察{z,x,y,t}这个项集的支持度也是为3,如何做呢?

首先为每个元素的找到所有前缀路径,一条前缀路径,是指元素父节点到根节点的路径

| 单元素 | 前缀路径 |

| z | {}: 5 |

| r | {x, s}: 1, {z, x, y}: 1, {z}: 1 |

| x | {z}: 3, {}: 1 |

| y | {z, x}: 3 |

| s | {z, x, y}: 2, {x}: 1 |

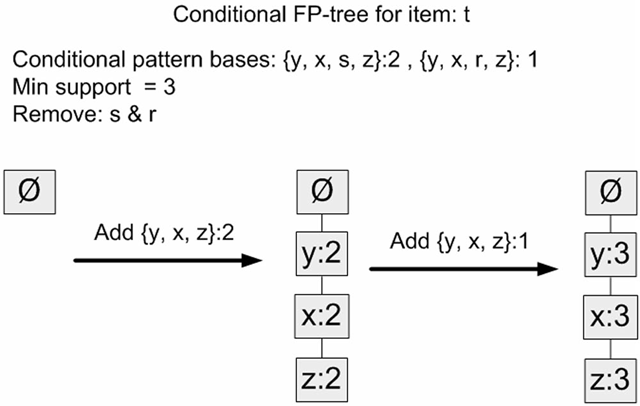

| t | {z, x, y, s}: 2, {z, x, y, r}: 1 |

然后对每个元素的所有前缀路径再执行一次FP树的构造过程,这样看到去除这个元素后能得到什么样的频繁项集。如下可以顺利得出{z,x,y} + {t}是一个支持度为3的频繁项集。

据此,FP-Growth方法就可以算出数据集中最小支持度为3的频繁项集:{z},{z,x},{z,x,y},{z,x,y,t}

参考:

1. https://www.cnblogs.com/qwertWZ/p/4510857.html

关联分析中寻找频繁项集的FP-growth方法的更多相关文章

- 使用 FP-growth 算法高效挖掘海量数据中的频繁项集

前言 对于如何发现一个数据集中的频繁项集,前文讲解的经典 Apriori 算法能够做到. 然而,对于每个潜在的频繁项,它都要检索一遍数据集,这是比较低效的.在实际的大数据应用中,这么做就更不好了. 本 ...

- 第十五篇:使用 FP-growth 算法高效挖掘海量数据中的频繁项集

前言 对于如何发现一个数据集中的频繁项集,前文讲解的经典 Apriori 算法能够做到. 然而,对于每个潜在的频繁项,它都要检索一遍数据集,这是比较低效的.在实际的大数据应用中,这么做就更不好了. 本 ...

- R_Studio(时序)Apriori算法寻找频繁项集的方法

应用ARIMA(1,1,0)对2015年1月1日到2015年2月6日某餐厅的销售数量做为期5天的预测 setwd('D:\\dat') #install.packages("forecast ...

- 海量数据挖掘MMDS week2: 频繁项集挖掘 Apriori算法的改进:非hash方法

http://blog.csdn.net/pipisorry/article/details/48914067 海量数据挖掘Mining Massive Datasets(MMDs) -Jure Le ...

- 机器学习实战 - 读书笔记(12) - 使用FP-growth算法来高效发现频繁项集

前言 最近在看Peter Harrington写的"机器学习实战",这是我的学习心得,这次是第12章 - 使用FP-growth算法来高效发现频繁项集. 基本概念 FP-growt ...

- FP-Growth算法之频繁项集的挖掘(python)

前言: 关于 FP-Growth 算法介绍请见:FP-Growth算法的介绍. 本文主要介绍从 FP-tree 中提取频繁项集的算法.关于伪代码请查看上面的文章. FP-tree 的构造请见:FP-G ...

- FP-growth算法发现频繁项集(一)——构建FP树

常见的挖掘频繁项集算法有两类,一类是Apriori算法,另一类是FP-growth.Apriori通过不断的构造候选集.筛选候选集挖掘出频繁项集,需要多次扫描原始数据,当原始数据较大时,磁盘I/O次数 ...

- 关联规则—频繁项集Apriori算法

频繁模式和对应的关联或相关规则在一定程度上刻画了属性条件与类标号之间的有趣联系,因此将关联规则挖掘用于分类也会产生比较好的效果.关联规则就是在给定训练项集上频繁出现的项集与项集之间的一种紧密的联系.其 ...

- 海量数据挖掘MMDS week2: Association Rules关联规则与频繁项集挖掘

http://blog.csdn.net/pipisorry/article/details/48894977 海量数据挖掘Mining Massive Datasets(MMDs) -Jure Le ...

随机推荐

- 补习系列(14)-springboot redis 整合-数据读写

目录 一.简介 二.SpringBoot Redis 读写 A. 引入 spring-data-redis B. 序列化 C. 读写样例 三.方法级缓存 四.连接池 小结 一.简介 在 补习系列(A3 ...

- pwnable.tw applestore 分析

此题第一步凑齐7174进入漏洞地点 然后可以把iphone8的结构体中的地址通过read修改为一个.got表地址,这样就能把libc中该函数地址打出来.这是因为read函数并不会在遇到\x00时截断( ...

- Tomcat 对 HTTP 协议的实现(上)

协议,直白的说就是存在一堆字节,按照协议指定的规则解析就能得出这堆字节的意义.HTTP 解析分为两个部分:解析请求头和请求体. 请求头解析的难点在于它没有固定长度的头部,也不像其他协议那样提供数据包长 ...

- #6 判断一个数是否为2的n次方

「ALBB面试题」 [题目] 如何判断一个数是否为2的n次方 [题目分析] 看到这种题,相信大家第一反应就是循环除2,这样做肯定是可以得出结果的:但是这种做法无疑大大增加了计算机的运行时间,一个非常大 ...

- asp.net后台管理系统-登陆模块-路由权限控制_1

using System.Web.Routing; //重写System.Web.Routing中Initialize方法 protected override void Initialize(Req ...

- C# xml序列化与反序列化 特性的使用

以下为将被序列化的类Entity: [XmlRoot("Root")] public class Entity { [XmlAttribute(AttributeName = &q ...

- 设计模式系列13:模板方法模式(Template Method Pattern)

定义 定义一个操作中的算法的骨架,而将一些步骤延迟到子类中.模板方法使得子类可以不改变一个算法的结构即可重定义该算法的某些特定步骤. --<设计模式GoF> UML类图 使用场景 有 ...

- 使用 DotNet CLI 创建自定义的 WPF 项目模板

描述 当我们安装完 DotNetCore 3.0 版本的 SDK 后,我们就可以创建基于 DotNetCore 的 WPF 项目模板,通过如下 CLI 可以方便快捷的创建并运行我们的项目: dotne ...

- PhotoshopCS5中将单位修改成百分比

PhotoshopCS5中单位默认是厘米或px,当用同一动作修改两张照片时,会因为片子大小不同,修改收到影响.若将单位修改成百分比,则动作会根据照片大小,自动进行调整. 1)选择菜单栏中的“编辑”选项 ...

- gitbook 入门教程之主题插件

主题插件 目前 gitbook 提供三类文档: Book 文档,API 文档和 FAQ 文档. 其中,默认的也是最常使用的就是 Book 文档,如果想要了解其他两种文档模式,需要引入相应的主题插件. ...