lucene_02_IKAnalyre

前言

在lucene中虽然已经提供了许多的分词器:StandardAnalyzer、CJKAnalyzer等,但在解析中文的时候都会把文中拆成一个个的单子。

毕竟老外不懂中文。这里介绍一个中文的分词器:IKAnalyre。虽然在其在分词的时候还不够完美

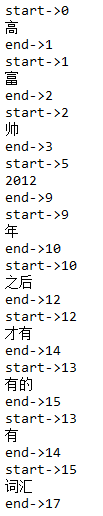

例如:将“高富帅,是2012年之后才有的词汇”

拆分为下图:

但是它可以通过配置文件来,增加新词和过滤不许出现的词比如:“的、啊、呀”等等没有具体意思的修饰副词和语气词等等。

配置IK解析器

第一步:在pom.xml 引入IK,注意:这个分词器由于从2012年之后就没有更新过,所以只能在低版本的lucene的版本中使用,该例使用的是:4.10.3

<!--ik 中文分词器-->

<!-- https://mvnrepository.com/artifact/com.janeluo/ikanalyzer -->

<dependency>

<groupId>com.janeluo</groupId>

<artifactId>ikanalyzer</artifactId>

<version>2012_u6</version>

</dependency>

完整pom.xml

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion> <groupId>com.chen</groupId>

<artifactId>lucene</artifactId>

<version>1.0-SNAPSHOT</version>

<packaging>jar</packaging> <name>lucene</name>

<url>http://maven.apache.org</url> <properties>

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

</properties> <dependencies>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>3.8.1</version>

<scope>test</scope>

</dependency> <!-- https://mvnrepository.com/artifact/org.apache.lucene/lucene-core -->

<dependency>

<groupId>org.apache.lucene</groupId>

<artifactId>lucene-core</artifactId>

<version>4.10.3</version>

</dependency> <!-- https://mvnrepository.com/artifact/org.apache.lucene/lucene-queryparser -->

<dependency>

<groupId>org.apache.lucene</groupId>

<artifactId>lucene-queryparser</artifactId>

<version>4.10.3</version>

</dependency> <!-- https://mvnrepository.com/artifact/org.apache.lucene/lucene-analyzers-common -->

<dependency>

<groupId>org.apache.lucene</groupId>

<artifactId>lucene-analyzers-common</artifactId>

<version>4.10.3</version>

</dependency> <!-- https://mvnrepository.com/artifact/commons-io/commons-io -->

<dependency>

<groupId>commons-io</groupId>

<artifactId>commons-io</artifactId>

<version>2.6</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>RELEASE</version>

</dependency> <!-- https://mvnrepository.com/artifact/io.github.zacker330.es/ik-analysis-core -->

<!--ik 中文分词器-->

<!-- https://mvnrepository.com/artifact/com.janeluo/ikanalyzer -->

<dependency>

<groupId>com.janeluo</groupId>

<artifactId>ikanalyzer</artifactId>

<version>2012_u6</version>

</dependency> </dependencies> <build>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<version>3.6.0</version>

<configuration>

<source>1.8</source>

<target>1.8</target>

</configuration>

</plugin>

</plugins>

</build>

</project>

第二步:在资源目录下引入配置文件和扩展词汇文件、过滤词文件

IKAnalyzer.cfg.xml,是该分词器的核心配置文件,管理着ext.dic(扩展词汇文件)、stopword.dic(禁词文件)

内容如下:

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

<properties>

<comment>IK Analyzer 扩展配置</comment>

<!--用户可以在这里配置自己的扩展字典 -->

<entry key="ext_dict">ext.dic;</entry> <!--用户可以在这里配置自己的扩展停止词字典-->

<entry key="ext_stopwords">stopword.dic;</entry> </properties>

ext.dic 内容示例:

高富帅

白富美

java工程师

stopword.dic内容示例:

我

是

用

的

你

它

他

她

a

an

and

are

as

at

be

but

by

for

if

in

into

is

it

no

not

of

on

or

such

that

the

their

then

there

these

they

this

to

was

will

with

测试代码

// 查看标准分析器的分词效果

@Test

public void testTokenStream() throws Exception {

// 创建一个标准分析器对象

// Analyzer analyzer = new StandardAnalyzer();

// Analyzer analyzer = new CJKAnalyzer();

// Analyzer analyzer = new SmartChineseAnalyzer();

Analyzer analyzer = new IKAnalyzer();

// 获得tokenStream对象

// 第一个参数:域名,可以随便给一个

// 第二个参数:要分析的文本内容

// TokenStream tokenStream = analyzer.tokenStream("test",

// "The Spring Framework provides a comprehensive programming and configuration model.");

TokenStream tokenStream = analyzer.tokenStream("test",

"高富帅,是2012年之后才有的词汇");

// 添加一个引用,可以获得每个关键词

CharTermAttribute charTermAttribute = tokenStream.addAttribute(CharTermAttribute.class);

// 添加一个偏移量的引用,记录了关键词的开始位置以及结束位置

OffsetAttribute offsetAttribute = tokenStream.addAttribute(OffsetAttribute.class);

// 将指针调整到列表的头部

tokenStream.reset();

// 遍历关键词列表,通过incrementToken方法判断列表是否结束

while (tokenStream.incrementToken()) {

// 关键词的起始位置 System.out.println("start->" + offsetAttribute.startOffset());

// 取关键词

System.out.println(charTermAttribute);

// 结束位置

System.out.println("end->" + offsetAttribute.endOffset());

}

tokenStream.close();

}

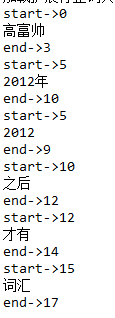

结果如下图:

lucene_02_IKAnalyre的更多相关文章

随机推荐

- Codeforces Round #281 (Div. 2) D. Vasya and Chess 博弈

D. Vasya and Chess Vasya decided to learn to play chess. Classic chess doesn't seem interesting to ...

- SharePoint 2013 Silverlight中使用Netclient对象模型

1.创建Silverlight时,选择Silverlight 4.不要选择版本号5,试了非常久版本号5都调用不了,自己也不知道什么原因.谷歌也没找到答案.后来尝试版本号4,能够调用. 至于Host t ...

- luogu1357 花园 状态压缩 矩阵快速幂

题目大意 小L有一座环形花园,沿花园的顺时针方向,他把各个花圃编号为1~N(2<=N<=10^15).他的环形花园每天都会换一个新花样,但他的花园都不外乎一个规则,任意相邻M(2<= ...

- vim copy termi

用vim写代码时,经常遇到这样的场景,复制多行,然后粘贴. 这样做:1. 将光标移动到要复制的文本开始的地方,按v进入可视模式.2. 将光标移动到要复制的文本的结束的地方,按y复制.此时vim会自动将 ...

- C++ Web 编程(菜鸟教程)

C++ Web 编程(菜鸟教程) C++ Web 编程 什么是 CGI? 公共网关接口(CGI),是一套标准,定义了信息是如何在 Web 服务器和客户端脚本之间进行交换的. CGI 规范目前是由 NC ...

- SQL排他锁的解决方案

SQL排他锁的解决方案 分类: 事务与锁 数据库管理维护2009-04-28 22:41 680人阅读 评论(0) 收藏 举报 sql数据库database服务器killdisk 问题描述: 我有一个 ...

- Necklace of Beads(polya定理)

http://poj.org/problem?id=1286 题意:求用3种颜色给n个珠子涂色的方案数.polya定理模板题. #include <stdio.h> #include &l ...

- 运行Django项目指定IP和端口

默认IP和端口 python manage.py runserver 指定端口: python manage.py runserver 192.168.12.12:8080 此时会报错,我们需要修改配 ...

- JavaScript异步加载方案

(1) defer,只支持IE defer属性的定义和用法(我摘自w3school网站) defer 属性规定是否对脚本执行进行延迟,直到页面加载为止. 有的 javascript 脚本 docume ...

- C# 多线程系列(一)

线程是怎样工作的 1.多线程由一个线程调度器来进行内部管理,一个功能是CLR常常委托给操做系统. 一个线程调度器确保所有激活的线程在执行期间被合适的分配,等待或者阻塞的线程(比如,一个独占锁或者等待用 ...