带你认识spark安装包的目录结构

福利 => 每天都推送

其实啊,将spark的压缩包解压好,就已经是spark的最简易安装了。

其实啊,想说的是,只要将spark这压缩包解压好,就已经是spark的最简易安装了。

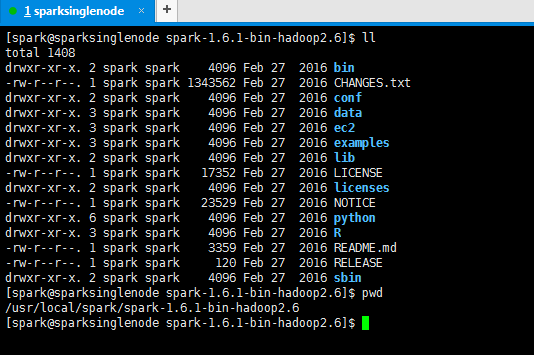

[spark@sparksinglenode spark-1.6.1-bin-hadoop2.6]$ ll

total 1408

drwxr-xr-x. 2 spark spark 4096 Feb 27 2016 bin (可执行)

-rw-r--r--. 1 spark spark 1343562 Feb 27 2016 CHANGES.txt

drwxr-xr-x. 2 spark spark 4096 Feb 27 2016 conf (配置文件)

drwxr-xr-x. 3 spark spark 4096 Feb 27 2016 data (例子里用到的一些数据)

drwxr-xr-x. 3 spark spark 4096 Feb 27 2016 ec2

drwxr-xr-x. 3 spark spark 4096 Feb 27 2016 examples (自带的例子一些源代码)

drwxr-xr-x. 2 spark spark 4096 Feb 27 2016 lib (jar包)

-rw-r--r--. 1 spark spark 17352 Feb 27 2016 LICENSE

drwxr-xr-x. 2 spark spark 4096 Feb 27 2016 licenses

-rw-r--r--. 1 spark spark 23529 Feb 27 2016 NOTICE

drwxr-xr-x. 6 spark spark 4096 Feb 27 2016 python

drwxr-xr-x. 3 spark spark 4096 Feb 27 2016 R

-rw-r--r--. 1 spark spark 3359 Feb 27 2016 README.md (包含一些入门的spark说明)

-rw-r--r--. 1 spark spark 120 Feb 27 2016 RELEASE

drwxr-xr-x. 2 spark spark 4096 Feb 27 2016 sbin (集群启停,因为spark有自带的集群环境)

[spark@sparksinglenode spark-1.6.1-bin-hadoop2.6]$ pwd

/usr/local/spark/spark-1.6.1-bin-hadoop2.6

[spark@sparksinglenode spark-1.6.1-bin-hadoop2.6]$

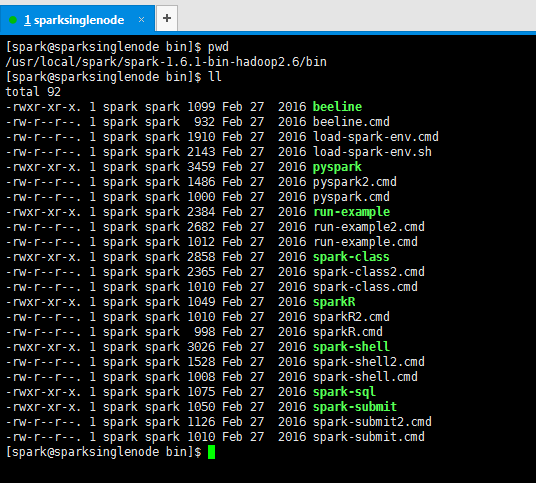

[spark@sparksinglenode bin]$ pwd

/usr/local/spark/spark-1.6.1-bin-hadoop2.6/bin

[spark@sparksinglenode bin]$ ll

total 92

-rwxr-xr-x. 1 spark spark 1099 Feb 27 2016 beeline

-rw-r--r--. 1 spark spark 932 Feb 27 2016 beeline.cmd

-rw-r--r--. 1 spark spark 1910 Feb 27 2016 load-spark-env.cmd

-rw-r--r--. 1 spark spark 2143 Feb 27 2016 load-spark-env.sh

-rwxr-xr-x. 1 spark spark 3459 Feb 27 2016 pyspark

-rw-r--r--. 1 spark spark 1486 Feb 27 2016 pyspark2.cmd

-rw-r--r--. 1 spark spark 1000 Feb 27 2016 pyspark.cmd

-rwxr-xr-x. 1 spark spark 2384 Feb 27 2016 run-example

-rw-r--r--. 1 spark spark 2682 Feb 27 2016 run-example2.cmd

-rw-r--r--. 1 spark spark 1012 Feb 27 2016 run-example.cmd

-rwxr-xr-x. 1 spark spark 2858 Feb 27 2016 spark-class

-rw-r--r--. 1 spark spark 2365 Feb 27 2016 spark-class2.cmd

-rw-r--r--. 1 spark spark 1010 Feb 27 2016 spark-class.cmd

-rwxr-xr-x. 1 spark spark 1049 Feb 27 2016 sparkR

-rw-r--r--. 1 spark spark 1010 Feb 27 2016 sparkR2.cmd

-rw-r--r--. 1 spark spark 998 Feb 27 2016 sparkR.cmd

-rwxr-xr-x. 1 spark spark 3026 Feb 27 2016 spark-shell

-rw-r--r--. 1 spark spark 1528 Feb 27 2016 spark-shell2.cmd

-rw-r--r--. 1 spark spark 1008 Feb 27 2016 spark-shell.cmd

-rwxr-xr-x. 1 spark spark 1075 Feb 27 2016 spark-sql

-rwxr-xr-x. 1 spark spark 1050 Feb 27 2016 spark-submit

-rw-r--r--. 1 spark spark 1126 Feb 27 2016 spark-submit2.cmd

-rw-r--r--. 1 spark spark 1010 Feb 27 2016 spark-submit.cmd

[spark@sparksinglenode bin]$

拿bin目录而言。比如

[spark@sparksinglenode bin]$ pwd

/usr/local/spark/spark-1.6.1-bin-hadoop2.6/bin

[spark@sparksinglenode bin]$ ./spark-shell

log4j:WARN No appenders could be found for logger (org.apache.hadoop.metrics2.lib.MutableMetricsFactory).

log4j:WARN Please initialize the log4j system properly.

log4j:WARN See http://logging.apache.org/log4j/1.2/faq.html#noconfig for more info.

Using Spark's repl log4j profile: org/apache/spark/log4j-defaults-repl.properties

To adjust logging level use sc.setLogLevel("INFO")

Welcome to

____ __

/ __/__ ___ _____/ /__

_\ \/ _ \/ _ `/ __/ '_/

/___/ .__/\_,_/_/ /_/\_\ version 1.6.1

/_/ Using Scala version 2.10.5 (Java HotSpot(TM) 64-Bit Server VM, Java 1.8.0_60)

Type in expressions to have them evaluated.

Type :help for more information.

Spark context available as sc.

17/03/24 04:37:19 WARN Connection: BoneCP specified but not present in CLASSPATH (or one of dependencies)

17/03/24 04:37:21 WARN Connection: BoneCP specified but not present in CLASSPATH (or one of dependencies)

17/03/24 04:37:36 WARN ObjectStore: Version information not found in metastore. hive.metastore.schema.verification is not enabled so recording the schema version 1.2.0

17/03/24 04:37:36 WARN ObjectStore: Failed to get database default, returning NoSuchObjectException

17/03/24 04:37:43 WARN Connection: BoneCP specified but not present in CLASSPATH (or one of dependencies)

17/03/24 04:37:43 WARN Connection: BoneCP specified but not present in CLASSPATH (or one of dependencies)

17/03/24 04:37:53 WARN ObjectStore: Version information not found in metastore. hive.metastore.schema.verification is not enabled so recording the schema version 1.2.0

17/03/24 04:37:53 WARN ObjectStore: Failed to get database default, returning NoSuchObjectException

SQL context available as sqlContext. scala>

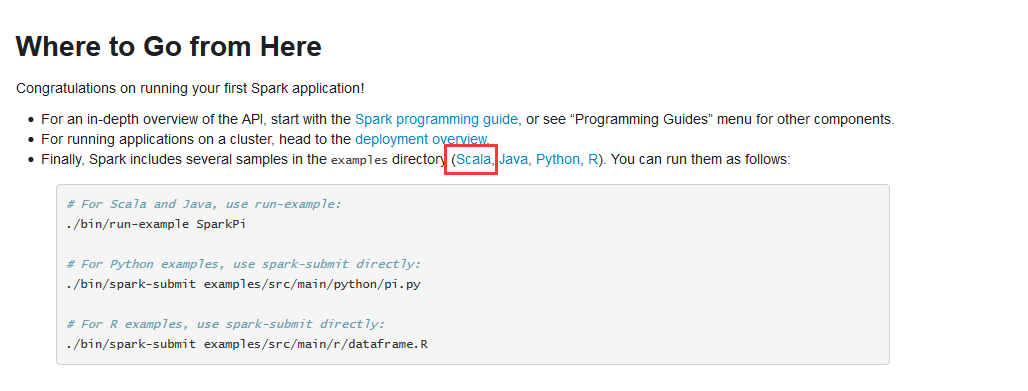

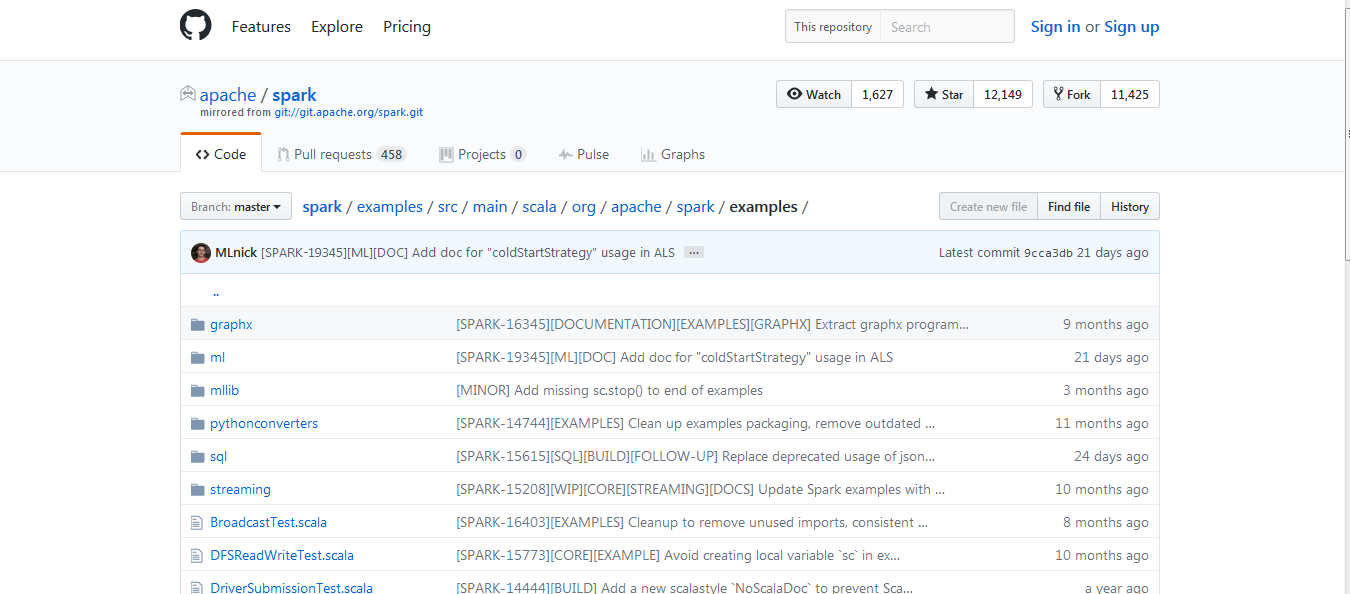

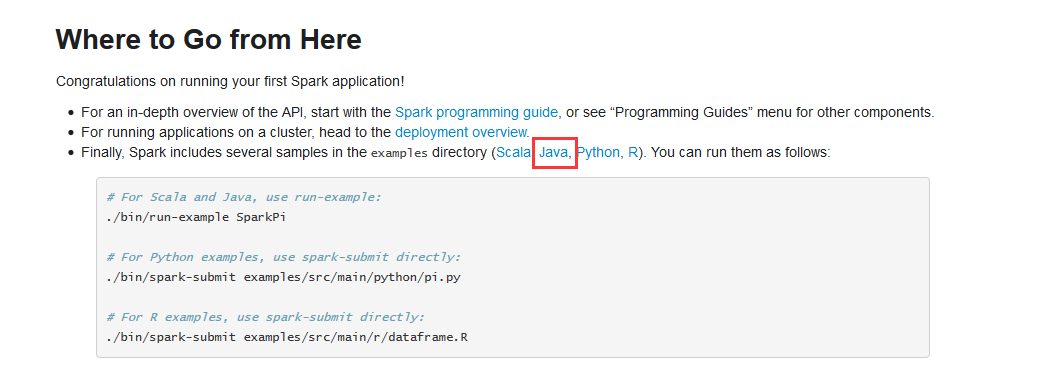

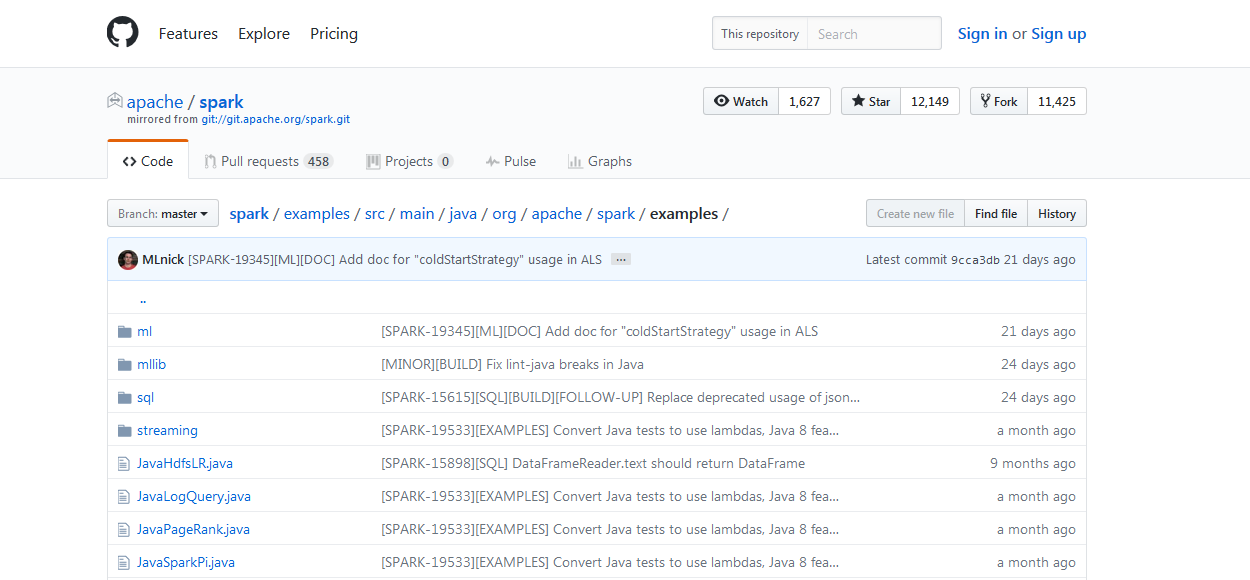

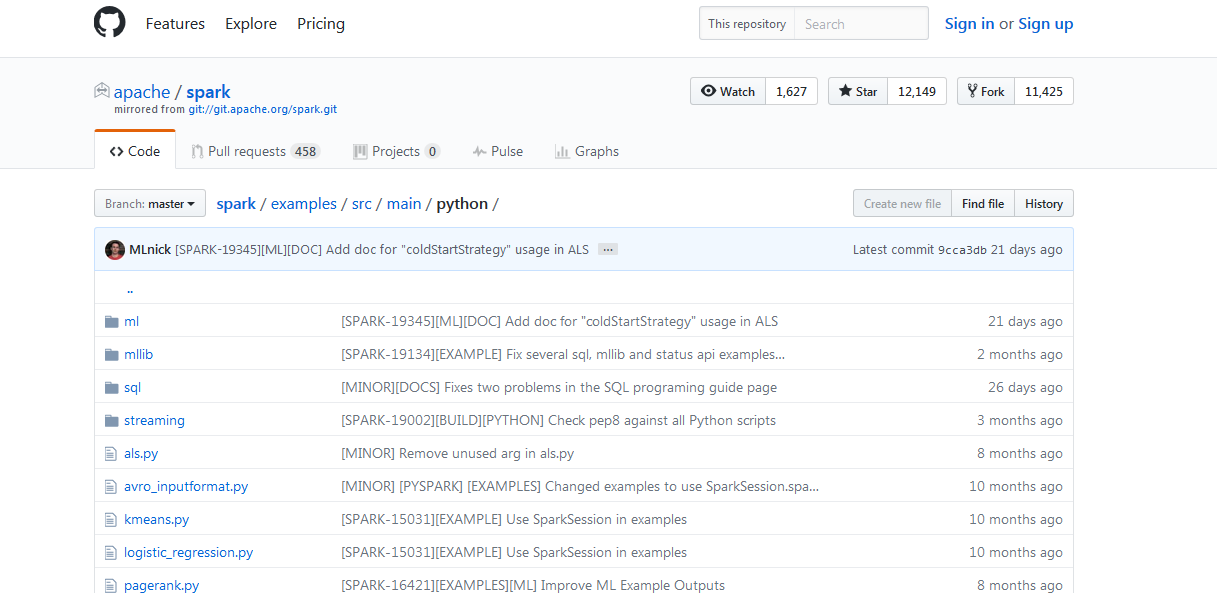

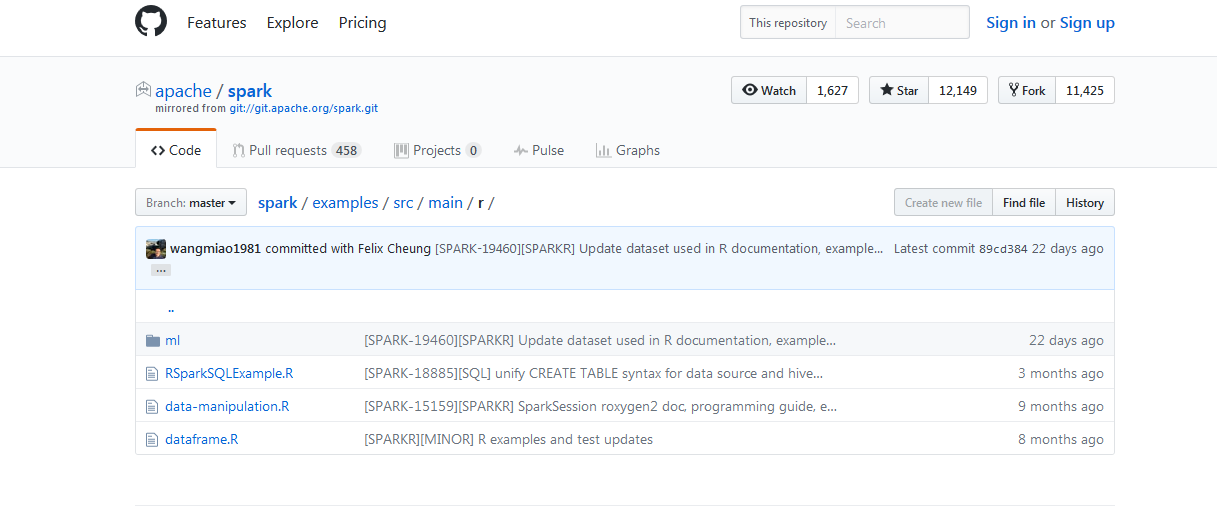

拿example而言,比如

例子,(官网给的)

http://spark.apache.org/docs/latest/quick-start.html

同时,大家可以关注我的个人博客:

http://www.cnblogs.com/zlslch/ 和 http://www.cnblogs.com/lchzls/ http://www.cnblogs.com/sunnyDream/

详情请见:http://www.cnblogs.com/zlslch/p/7473861.html

人生苦短,我愿分享。本公众号将秉持活到老学到老学习无休止的交流分享开源精神,汇聚于互联网和个人学习工作的精华干货知识,一切来于互联网,反馈回互联网。

目前研究领域:大数据、机器学习、深度学习、人工智能、数据挖掘、数据分析。 语言涉及:Java、Scala、Python、Shell、Linux等 。同时还涉及平常所使用的手机、电脑和互联网上的使用技巧、问题和实用软件。 只要你一直关注和呆在群里,每天必须有收获

对应本平台的讨论和答疑QQ群:大数据和人工智能躺过的坑(总群)(161156071)

打开百度App,扫码,精彩文章每天更新!欢迎关注我的百家号: 九月哥快讯

带你认识spark安装包的目录结构的更多相关文章

- hadoop安装包的目录结构

初次接触Hadoop,了解了Hadoop安装包的目录结构,和大家分享下: bin:Hadoop最基本的管理脚本和使用脚本的目录,这些脚本是sbin目录下管理脚本的基础实现,用户可以直接使用这些脚本管理 ...

- vs2010制作带卸载功能的安装包过程,及asp.net网站iis发布、备份数据库

1:新建安装部署项目 打开VS编辑器,点击新建项目,选择:其他项目类型->安装与部署->安装项目,然后点击确定. 2 安装向导完成后即可进入项目文件夹: 双击"应用程序文件夹&q ...

- Linux 查找安装包所在目录的常用方法

1. which命令查找出相关命令是否已经在搜索路径中: $which gcc //显示出GNC的C编译器安装在哪个目录 返回: /usr/bin/gcc 注意:如果which没有找到要找的命令,可以 ...

- InstallShield 12 制作安装包

目 录 一. 二. 三. (一) 打开project... 2 (二) project助手页面... 3 1.Application Information:程序信息... 4 2.Installa ...

- 有关VS2008制作安装包时遇到的问题详解

公司最近要做一个安装包,然而在做的时候遇到好多问题,这里我一一记录下来 一.先用VS2008建一个Setup项目,添加你需要打包的文件,这里我就不具体介绍了,网上一搜都好多,这时我们一般都需要在安装前 ...

- astgo 老版本免激活完整安装包带安装命令脚本

astgo是个国产的老牌经典软交换服务器,主要用来当回拨网络电话服务端,同时也具备群呼.传真等功能! 这个需要安装在centos 5.x 32位系统.带安装脚本,上传到root目录后执行安装脚本即可等 ...

- python一些模块的exe安装包在windows的64位系统里识别不到已安装Python目录的解决方法

在windows里安装python一些模块时候,有时候源码安装比较困难,pip install也各种报错,这时候最喜欢用别人编译好的exe或者whl文件来安装,但是在windows的64位系统里,如果 ...

- Windows安装docker (带安装包)

docker安装包链接 链接:https://pan.baidu.com/s/1JBk8GCH6j_WeGdoaUuIoWw 提取码:8kgg 我电脑上有了git所以没有勾选最后一个 安装完成后将此目 ...

- Solr 01 - 什么是Solr + Solr安装包目录结构说明

目录 1 Solr概述 1.1 Solr是什么 1.2 Solr与Lucene的区别 2 Solr文件说明 2.1 Solr的目录结构 2.2 其他常用概念说明 2.3 创建基础文件目录 2.4 so ...

随机推荐

- 常用Linux命令:ls/cd/pwd/mkdir/rm/mv/cp

一.ls:列出目标目录中所有的子目录和文件 1.命令格式 ls [选项] [目录名] 2.常用参数 -a :列出目录下所有文件 -h :以容易理解的格式列出文件大小 -l :除了文件名之外,还将文件 ...

- [转]Marshaling a SAFEARRAY of Managed Structures by P/Invoke Part 3.

1. Introduction. 1.1 In part 1 of this series of articles, I demonstrated how to transfer managed ar ...

- 转【C#调用DLL的几种方法,包括C#调用C\C++\C#DLL】

C#中dll调用方法 一. DLL与应用程序 动态链接库(也称为DLL,即为“Dynamic Link Library”的缩写)是Microsoft Windows最重要的组成要素之一, ...

- 树形DP--求树上任意两点间距离和

例题:HDU2376 HDU6446(2018CCPC网络赛) 思路:求任意两点间距离和可以转换为->路径长度乘经过路径次数的和. 求经过次数:设这条边两端的点,被经过的次数分别为A和B,那 ...

- Win10每次开机总是自动弹出MSN网址导航如何取消

Win10每次开机总是自动弹出MSN网址导航如何取消 近来有用户在升级Win10系统后,每次开机总是会自动弹出MSN中文网的网址导航.如果不想要开机打开MSN网址导航,那么应该怎么设置来取消呢?对此, ...

- Percona5.6源码安装

---恢复内容开始--- 系统环境:CentOS 6.8 1.安装依赖包 yum install gcc-c++ make cmake bison bison-devel ncurses-devel ...

- [SinGuLaRiTy] NOIP膜你赛-Day 1

[SinGuLRiTy-1022] Copyright (c) SinGuLaRITy 2017. All Rights Reserved. 对于所有题目:Time Limit:1s || Memo ...

- curl抓取网页内容php

1.cURL curl是客户端向服务器请求资源的工具 2.cURL使用场景 网页资源:网页爬虫 webservice数据接口资源:动态获取接口数据 天气 号码归属地 ftp资源:下载ftp服务器里面 ...

- 《图解HTTP》阅读笔记--第十一章针对web的攻击技术

第十一章.针对WEB的攻击技术 ----<图解HTTP>阅读笔记攻击目标---Web简单的HTTP协议本身并不存在安全性 问题,协议本身并不会成为被攻击的对象,应用HTTP的服务器和客户端 ...

- Canvas制作动态进度加载水球

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8&quo ...