给你一颗“定心丸”——记一次由线上事故引发的Log4j2日志异步打印优化分析

一、内容提要

自知是人外有人,天外有天,相信对于Log4j2的异步日志打印早有老师或者同学已是熟稔于心,优化配置更是信手拈来,为了防止我在这里啰里八嗦的班门弄斧,我先将谜底在此公布:log4j2.asyncQueueFullPolicy=Discard & log4j2.discardThreshold=ERROR,这两个Log4j2配置在强依赖的RPC服务方系统或中间件系统出现问题且业务流量巨大时,对系统的快速止血和影响范围的控制有奇效。要问为什么如此配置,是否还有高手?请见下文分晓。

二、现场还原

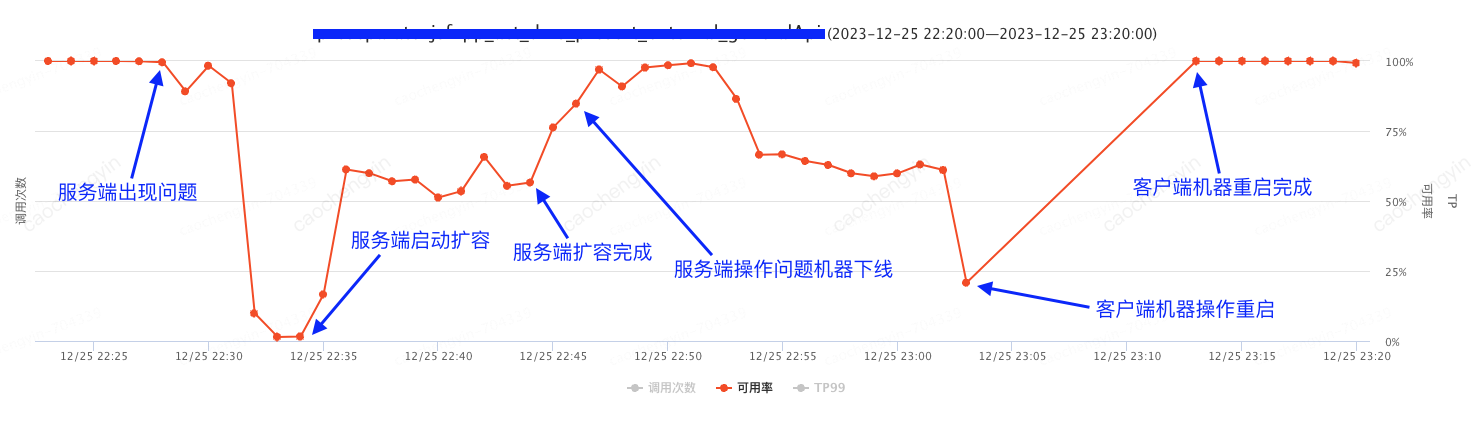

在2023年12月15日这“普通”的一天午后14点25分,我们收到了来自UMP的报警,接口服务可用率直接从100%干到了0.72%(该服务会直接影响到订单接单的相关流程,对客户体验有着重大影响)。我们顺藤摸瓜,并配合其他的服务监控定位到是强依赖系统出现了故障,导致其服务高度不可用,因此赶紧联系相关系统同事进行问题排查和处理。

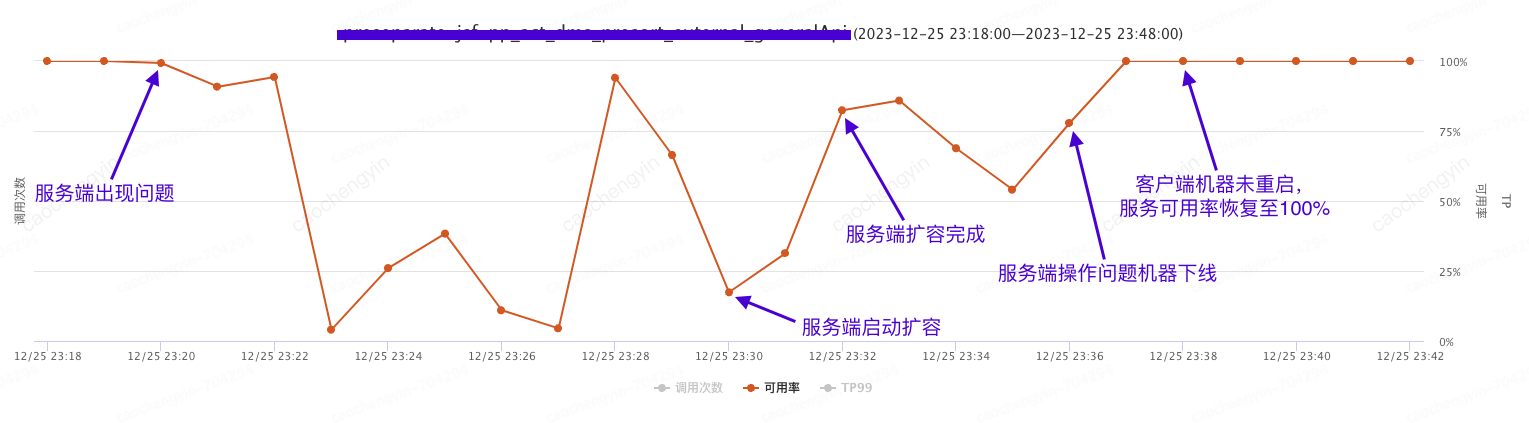

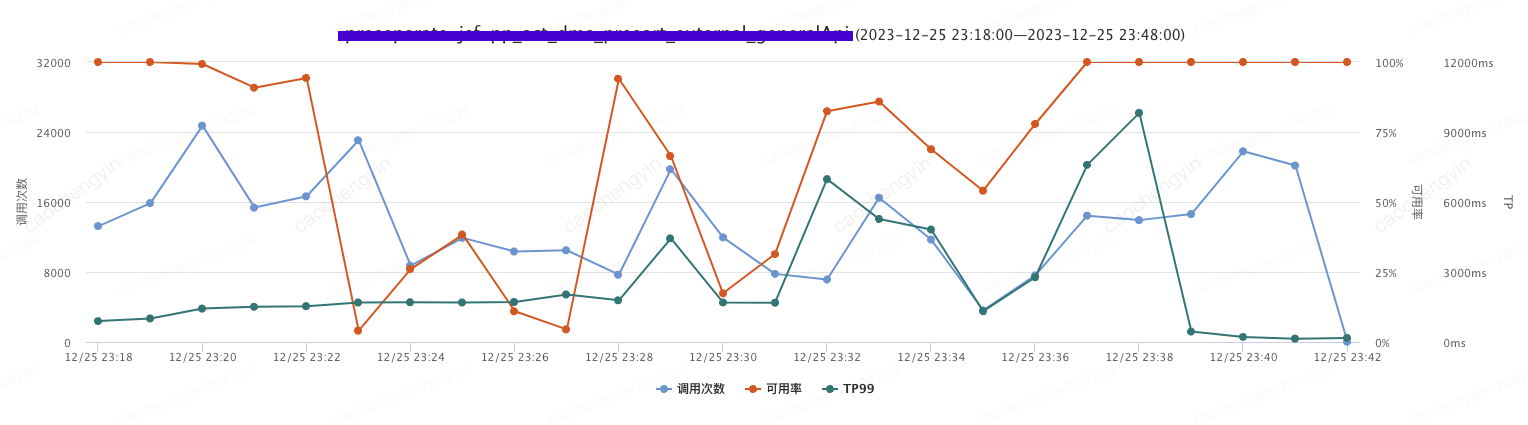

大概14:33左右,服务端系统同事反馈已经机器扩容完成,由以下截图可见,确实在14:32左右服务可用率开始有抬头趋势,但是至此问题却并未终结,在14:36服务可用率开始急转直下(错误日志内容除了服务响应超时,服务端线程池满等异常以外,同时还收到了无服务的异常以及其他不相关服务调用的超时异常)。服务端系统同事反馈新扩容机器仅有极少数流量流入,如此“意外之喜”是我们没想到的,其后续排查和问题定位的过程分析也是该文成文的主要原因。最终我们通过操作客户端机器重启,服务得以完全恢复。

图2-1 服务端系统问题初现

图2-2 客户端服务监控可用率再次骤降

图2-3 客户端服务监控TP指标

系统JDK和相关依赖版本信息:

三、问题点

四、排查过程

如果上面的问题解决不了,大概我晚上睡觉的时候一掀开被窝也全是“为何”了,带着这些问题我们便开始了如下排查过程。

第一查

排查客户端机器是否出现由于GC导致的STW(stop the world)

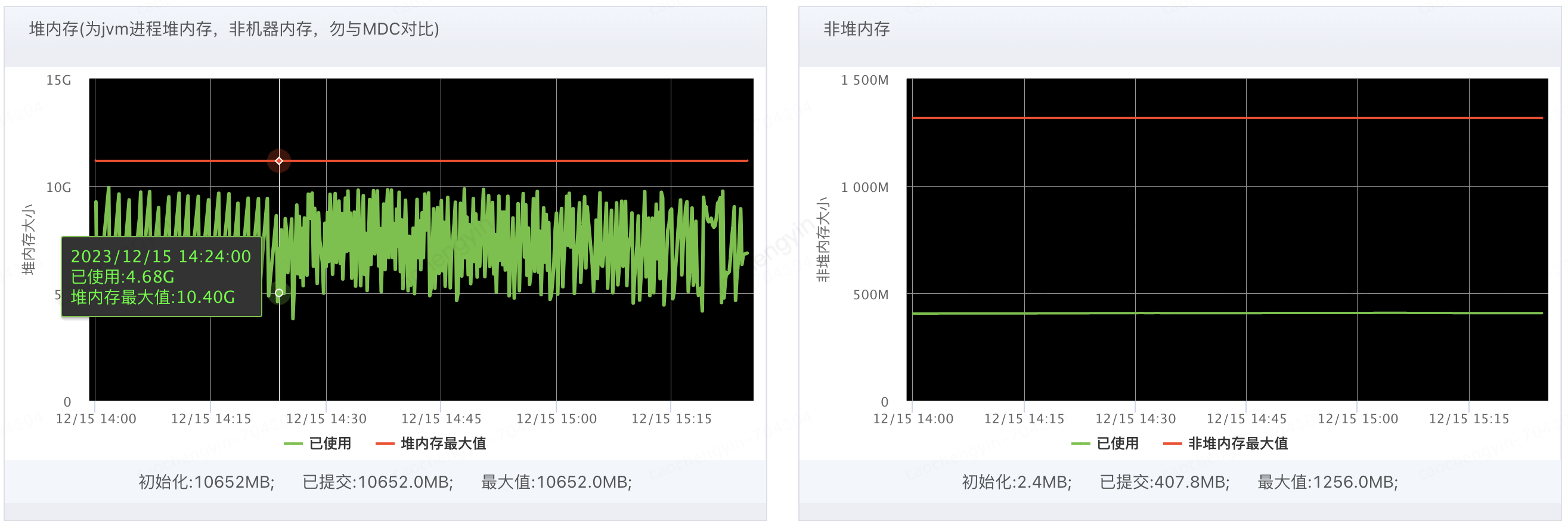

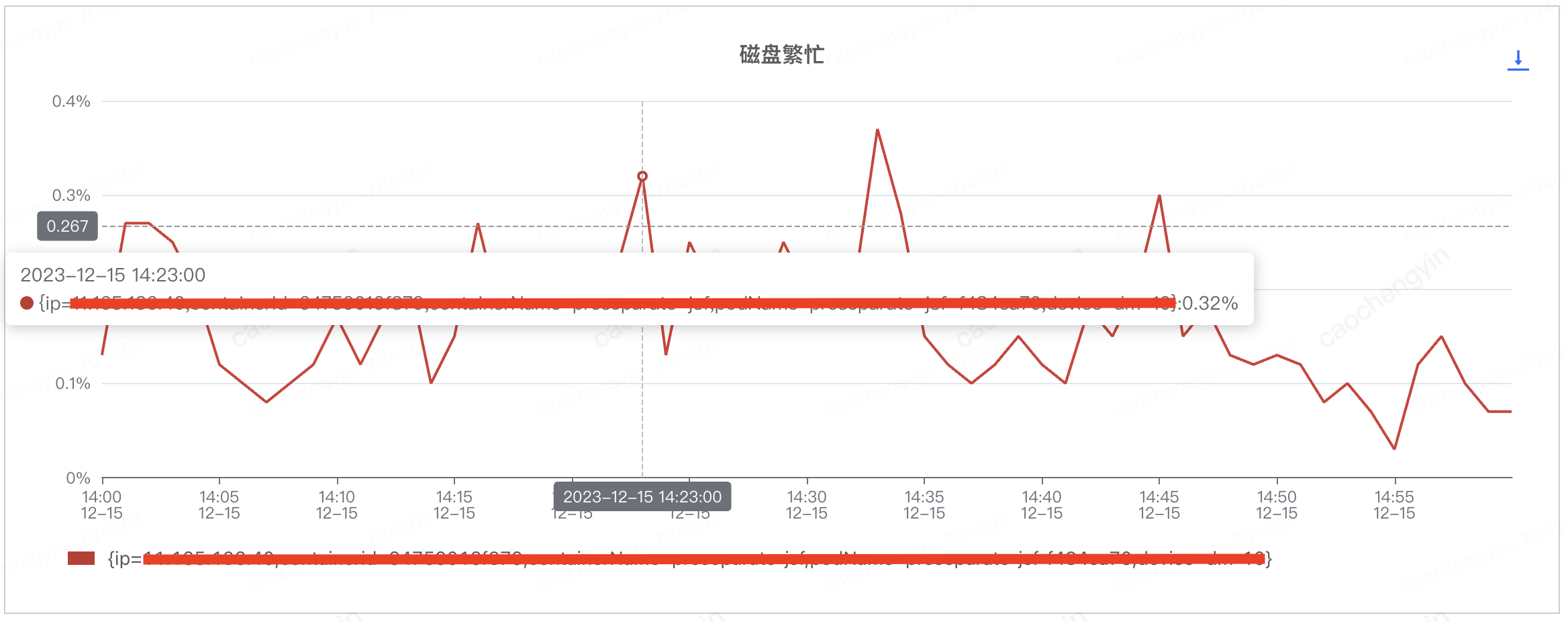

由以下截图可见Young GC次数确有所升高(猜测应该有较多大对象产生),Full GC并未触发;堆内存,非堆内存的使用率处于正常水平;CPU使用率有所飙高且线程数略有增加,但是尚处于正常可接受范围内,目前看来问题时间段内机器的JVM指标并不能提供太多的定位线索。

图4-1-1 客户端服务器Young GC和Full GC情况

图4-1-2 客户端服务器堆内存和非堆内存情况

图4-1-3 客户端服务器CPU使用率和线程数情况

第二查

排查客户端机器磁盘情况,看是否存在日志阻塞的情况

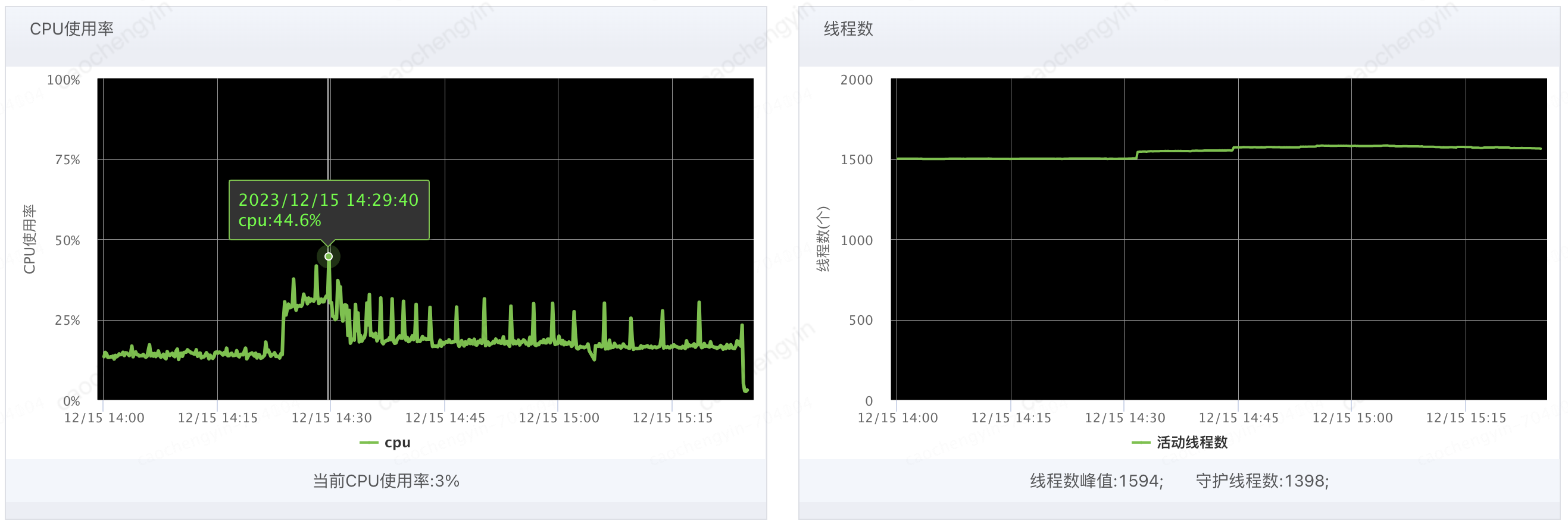

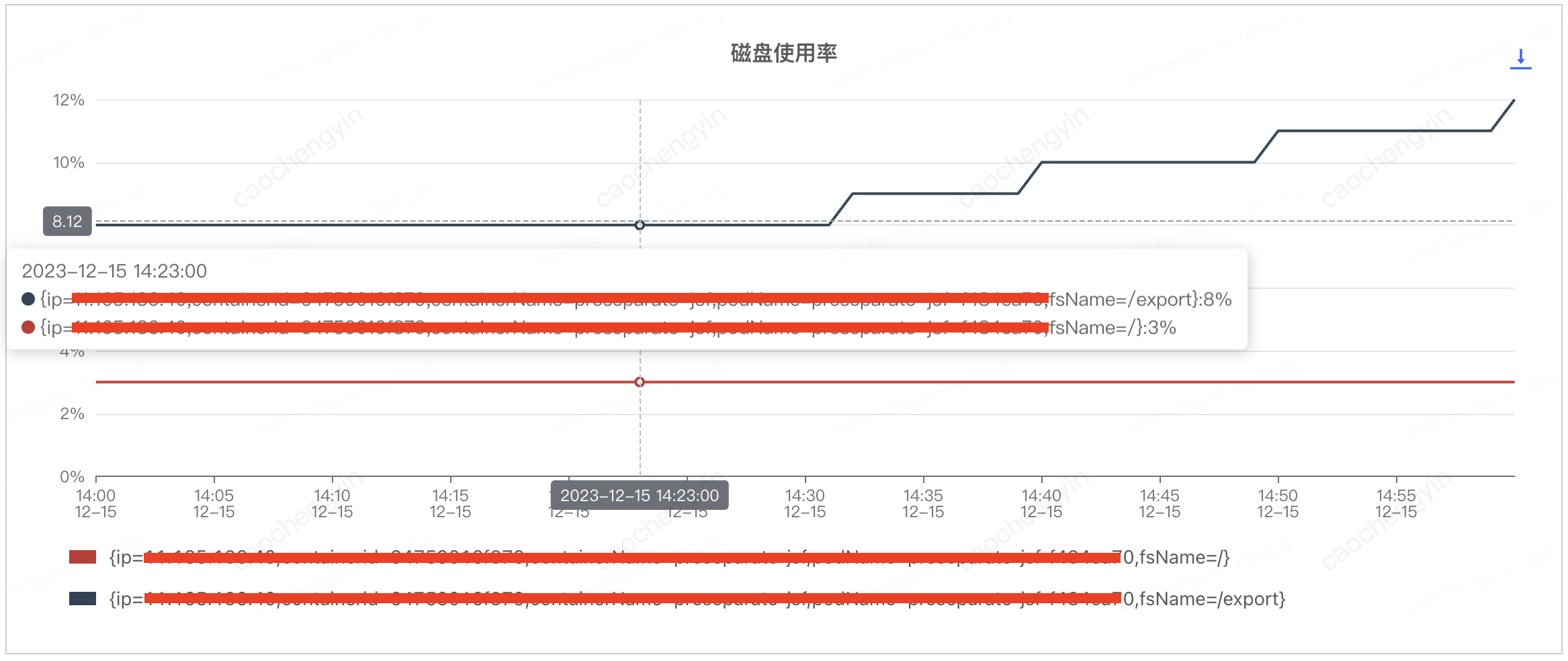

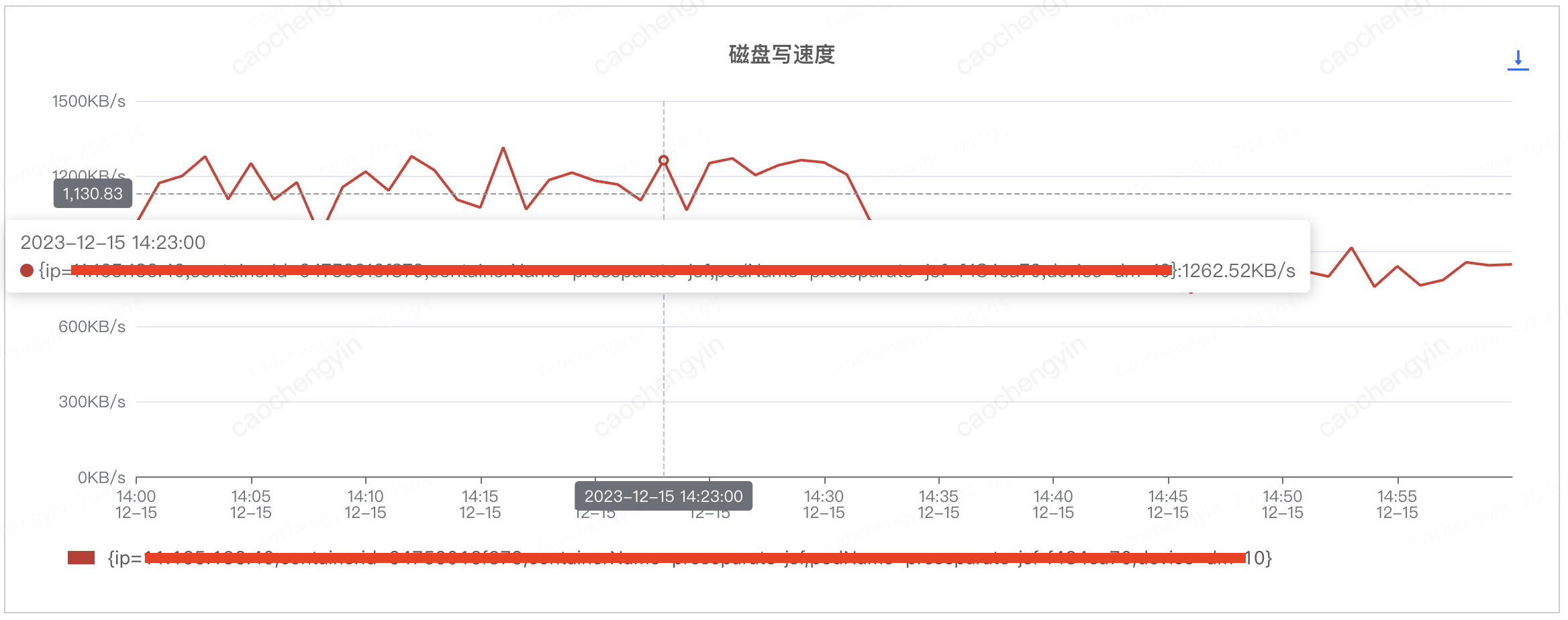

通过以下截图可见,磁盘使用率,磁盘繁忙,磁盘写速度等磁盘指标看起来也尚属正常,由此暂时推断该问题与日志的相关性并不大。

注:这对我们后来问题排查的方向造成了误导,将罪魁祸首给很快排除掉了,其实再仔细看一下磁盘使用率的截图,在相对较短的时间内磁盘使用率却有了明显的增长,这是出现了“精英怪”呀,不过即便如此,目前也仅仅是猜测,并无充足的证据来支持定罪,接下来的排查才是重量级)

图4-2-1 客户端服务器磁盘使用率情况

图4-2-2 客户端服务器磁盘繁忙情况

图4-2-3 客户端服务器磁盘写速度情况

第三查

查看问题时间段内客户端机器的内存状况(jmaq -dump)

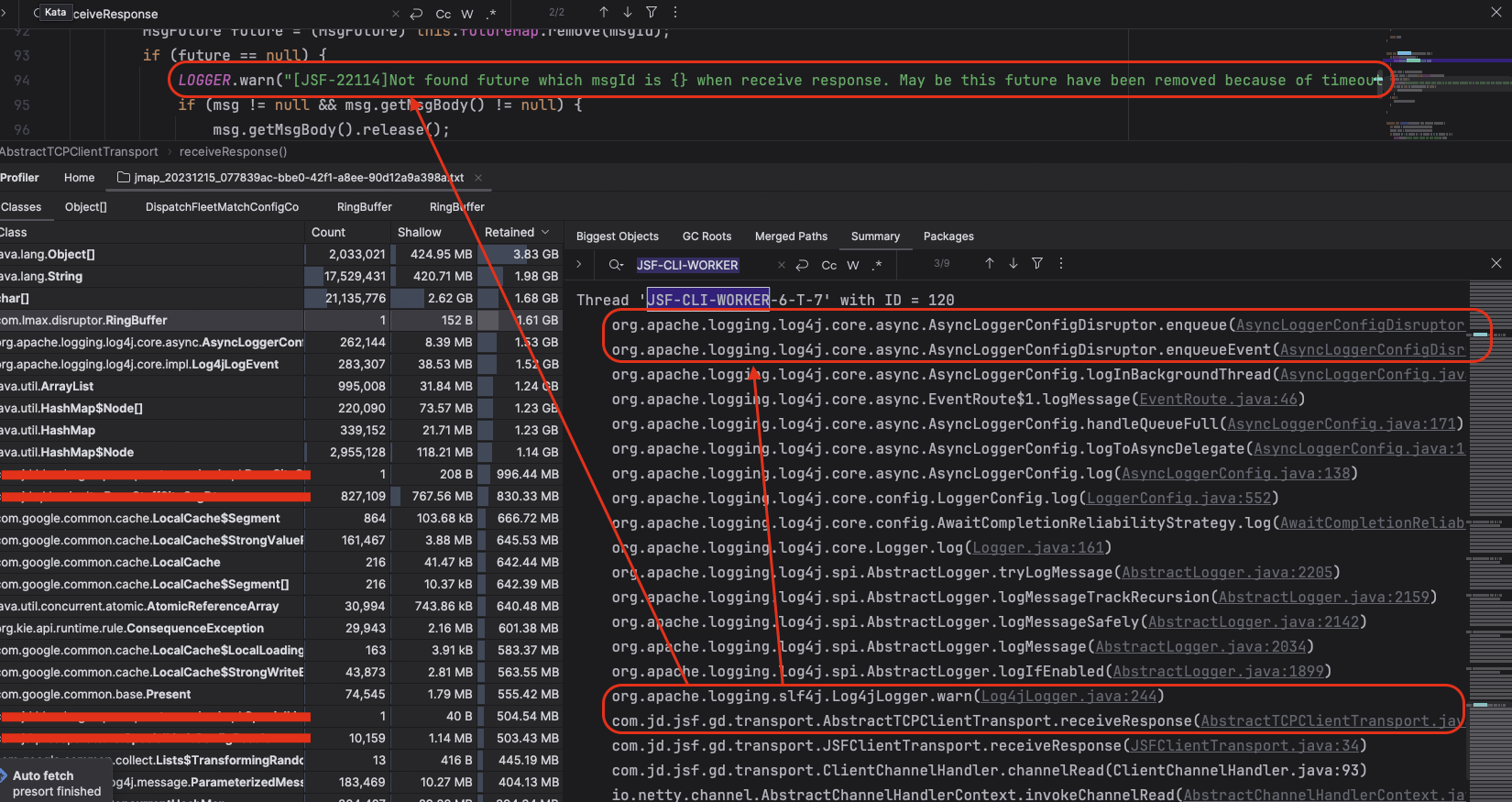

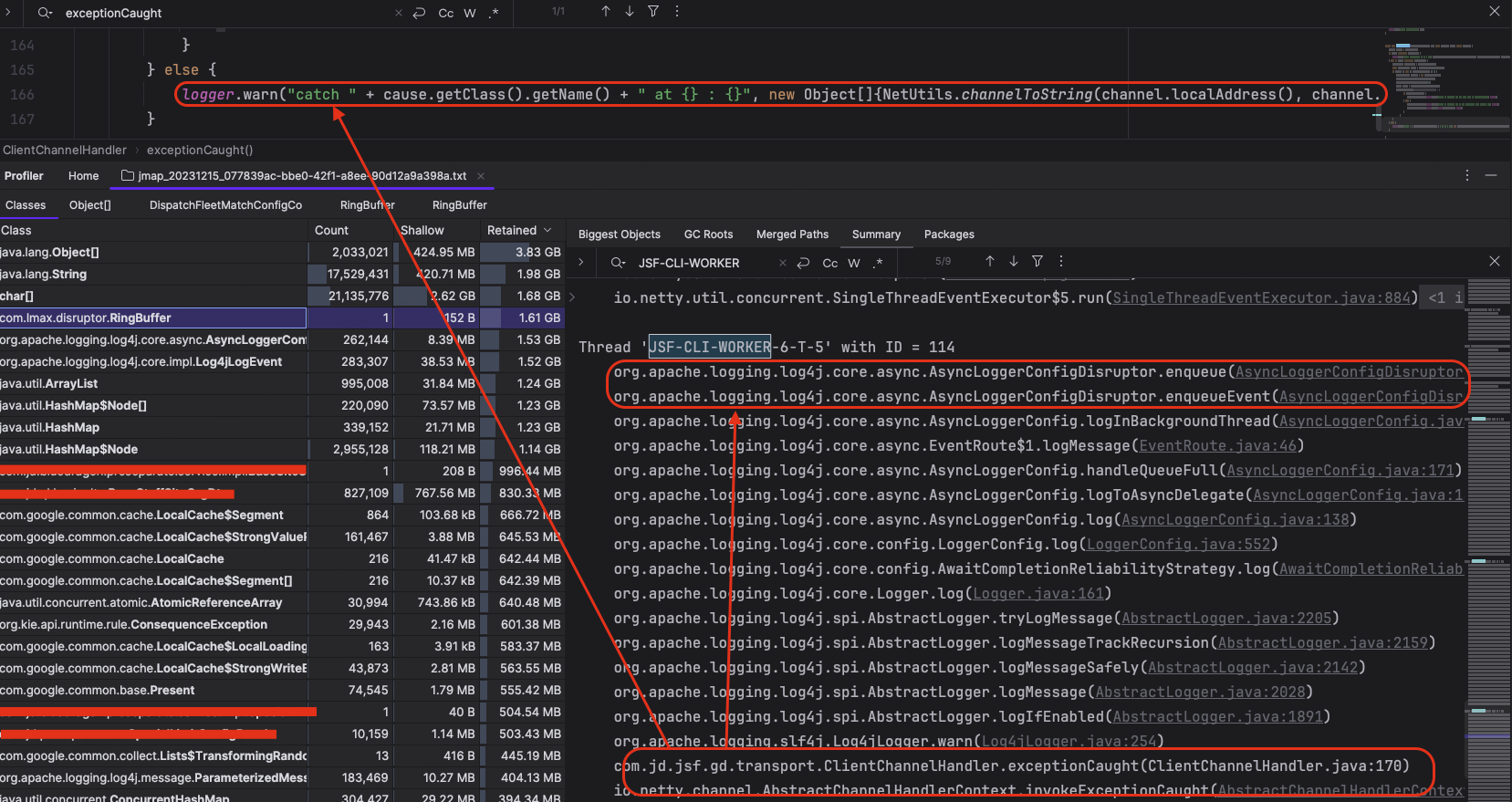

通过JSF-CLI-WORKER关键字我们可以定位到JSF客户端线程状态,通过以下截图可以看出,JSF客户端线程虽然在执行不同的服务处理流程,但是都在执行WARN/ERROR日志打印的时候卡在了enqueue环节。

图4-3-1 JSF客户端线程状态1

图4-3-2 JSF客户端线程状态2

下面让我们来分析一下源码,具体看一下enqueue到底干了什么?

// enqueue源码分析

// 代码位置org.apache.logging.log4j.core.async.AsyncLoggerConfigDisruptor#enqueue 363

private void enqueue(final LogEvent logEvent, final AsyncLoggerConfig asyncLoggerConfig) {

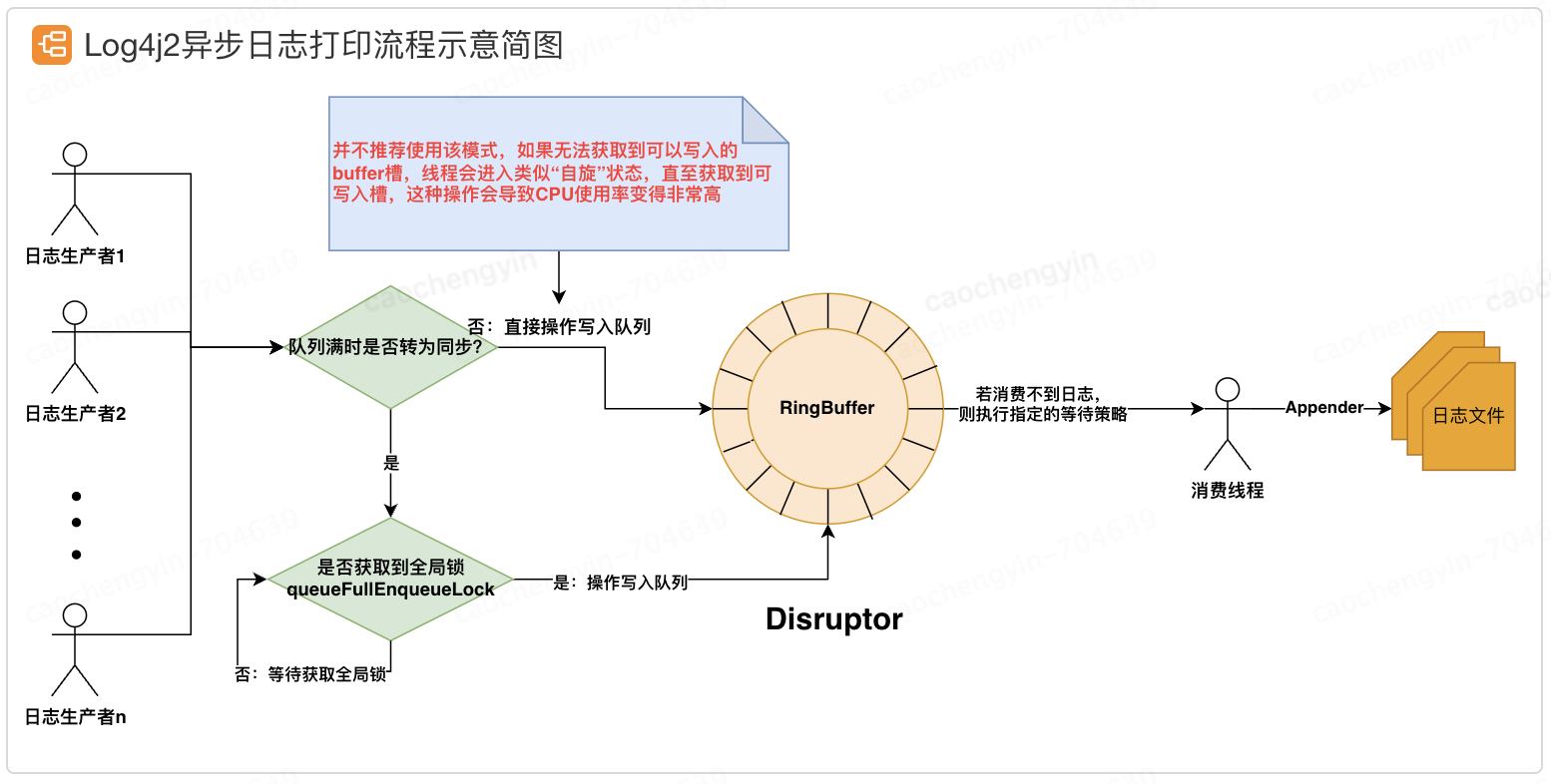

// synchronizeEnqueueWhenQueueFull() 是与另外一个要和大家分享的开关配置(AsyncLoggerConfig.SynchronizeEnqueueWhenQueueFull)有关,该配置用于指定当日志异步打印使用的RingBuffer满了以后,将多个日志线程的队列写入操作通过锁(queueFullEnqueueLock)调整为同步

if (synchronizeEnqueueWhenQueueFull()) {

// 同步锁:private final Object queueFullEnqueueLock = new Object();

synchronized (queueFullEnqueueLock) {

disruptor.getRingBuffer().publishEvent(translator, logEvent, asyncLoggerConfig);

}

} else {

disruptor.getRingBuffer().publishEvent(translator, logEvent, asyncLoggerConfig);

}

}

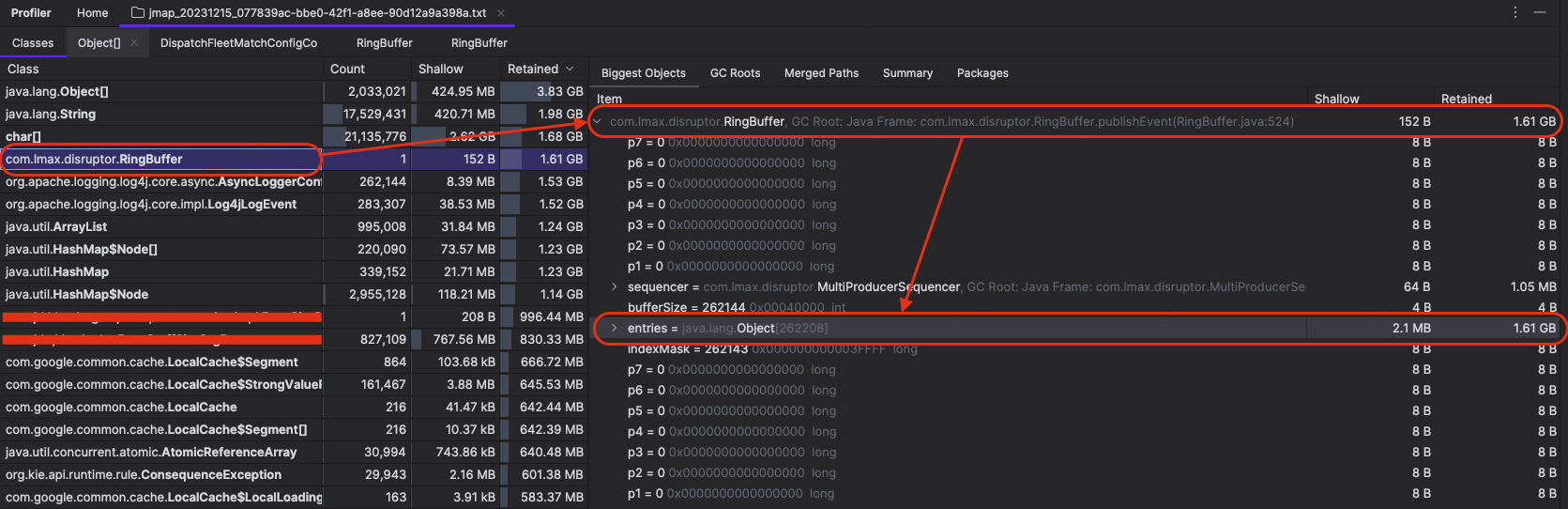

由上述源码我们不妨大胆的假设一下:JSF的客户端线程由于日志打印被阻塞而导致功能出现异常。那么顺着这个思路,我们就顺藤摸瓜,看看RingBuffer里面到底存了啥。聚光灯呢?往这打!

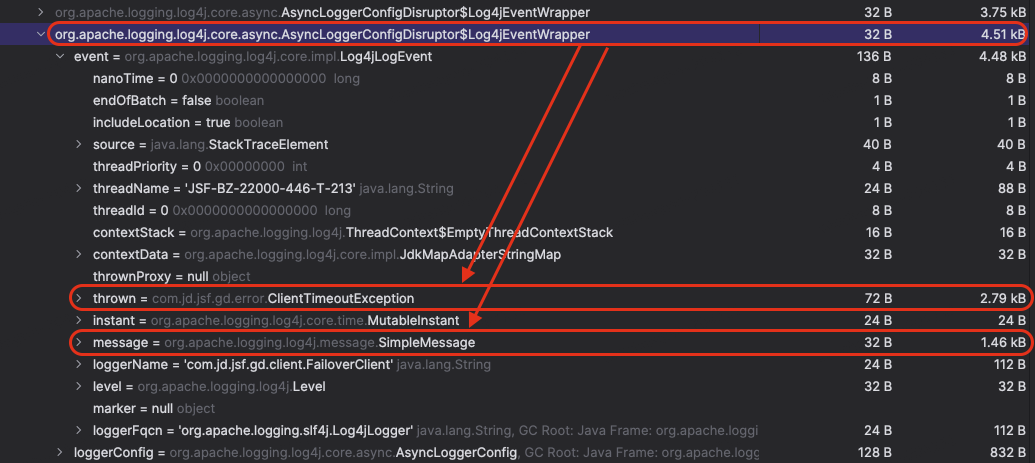

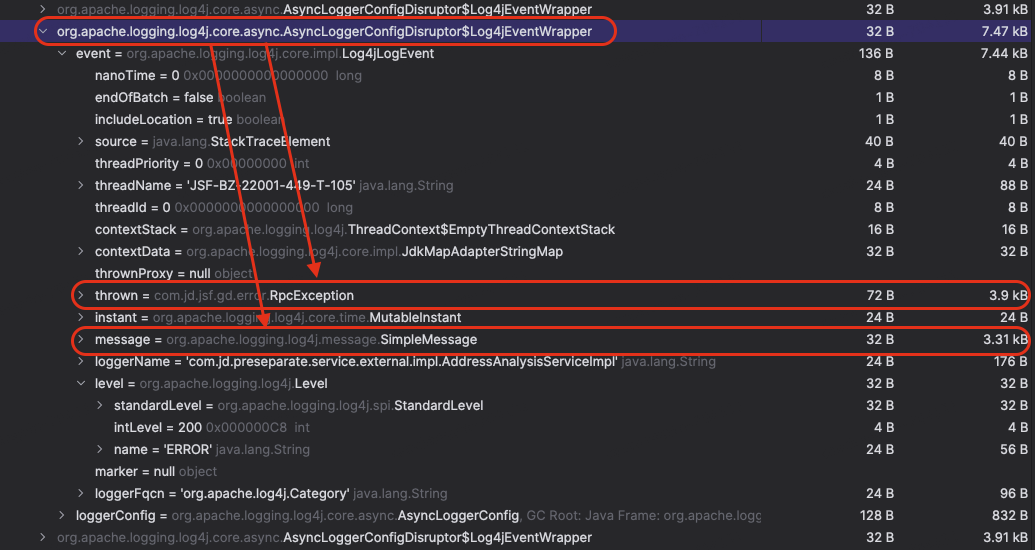

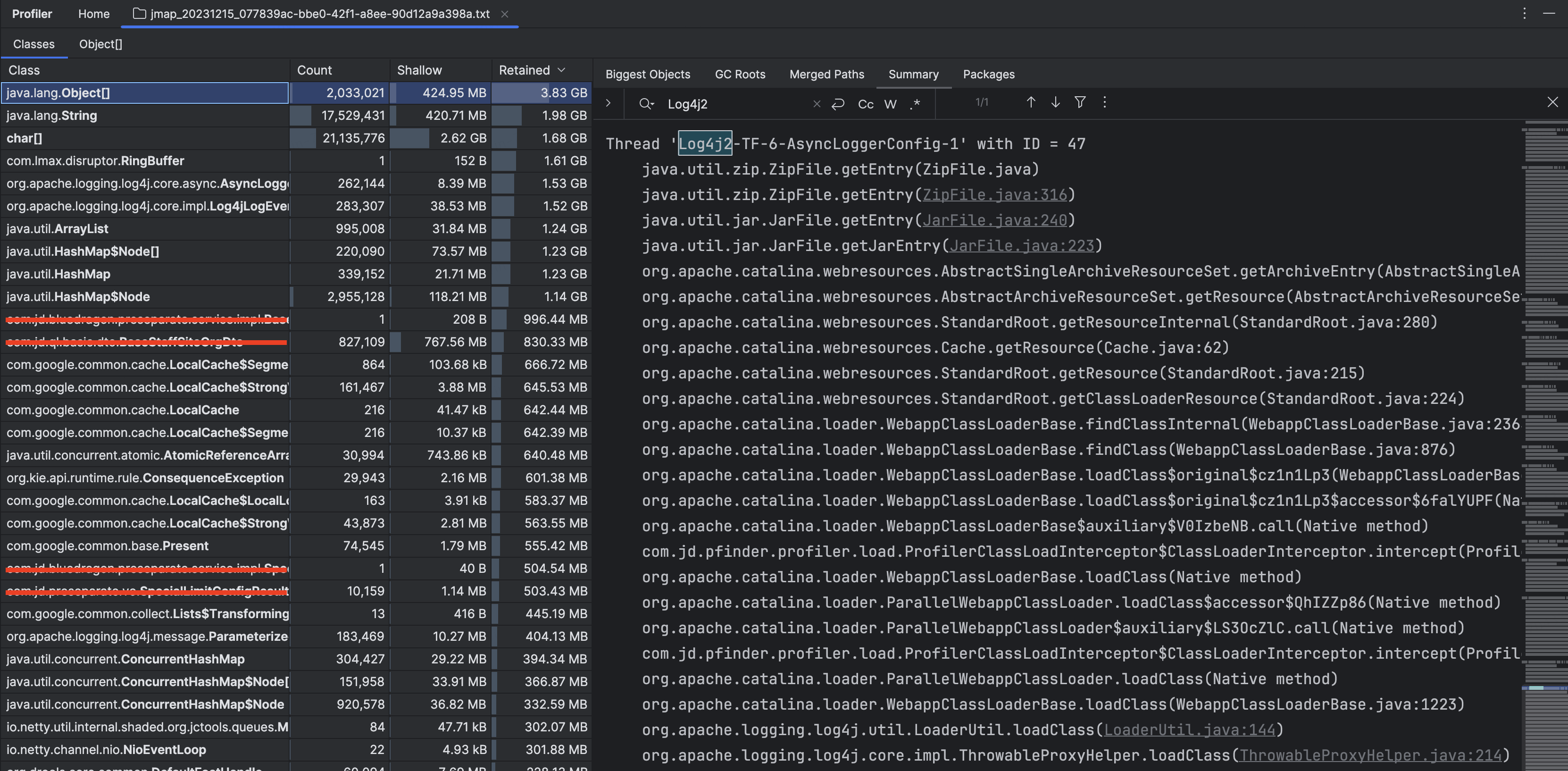

当我们找到RingBuffer的时候,不禁倒吸一口凉气,这小小RingBuffer居然有1.61GB之巨,让我们更近一步到RingBuffer的entries里面看看,到底是什么样的压力让RingBufferの竟如此干燥!

图4-3-3 RingBuffer的内存情况

(RingBuffer的entries里面都是Log4jEventWrapper,该Wrapper用于存储一些RingBuffer事件在执行的时候所需的必要信息)

图4-3-4 RingBufferLog4jEventWrapper 1

图4-3-5 RingBufferLog4jEventWrapper 2

在遍历entries过程中,我们看到基本上日志级别都是WARN和ERROR,并且含有大量的堆栈信息。排查到这个地方,综合以前了解到的Log4j2异步日志打印的相关知识(具体内容我会在下文压测过程说明完成后附上),我们基本上可以确定是当服务端系统出现问题时,生成的大量堆栈信息需要通过WARN和ERROR日志打印出来,RingBuffer被填满以后,又触发了锁竞争,由于等待的线程较多,系统中多个业务线程由并行变成了串型,并由此带来了一系列的连锁反应。至此也引出了本文的两位主角【log4j2.asyncQueueFullPolicy】&【log4j2.discardThreshold】。

log4j2.asyncQueueFullPolicy用于指定当日志打印队列被打满的时候,如何处理尚无法正常打印的日志事件,如果不指定的话,默认(Default)是阻塞,建议使用丢弃(Discard)。

log4j2.discardThreshold用于配合log4j2.asyncQueueFullPolicy使用,指定哪些日志级别及以下的日志事件可以执行丢弃操作,默认为INFO,建议使用ERROR。

排查到这里我们已经定位到日志生产的量的确比较多。但是如果日志打印出现了瓶颈,日志生产的多是一方面,另一方面还要看日志消费的情况是怎样的,如果消费的性能足够高的话,那么即便是日志生产的多,也不会造成日志打印的瓶颈。

图4-3-6 Log4j2日志消费线程状态

比较遗憾的是,我虽然找到了日志消费和日志文件写入的相关线程,但是并不能够足以支持我对于问题时间段内日志的消费出现了瓶颈进行定论。因为我dump出的内存信息并未统计出线程在问题时间段内写文件操作的执行次数,想以此来和日常进行比较,看是否是有较大的增量。(抑或是有方法,但是我没找到?我使用的是IDEA Profiler,如果您有好兵器,请不吝赐教。)

氛围都已经烘托到这个地步了,就此打住可就有些不解风情了,不妨我们用针对性的压测来验证一下我们的想法。

五、压测验证

压测脚本

(复现场景)

注:上述3、4、5操作并不会持续太长时间,因为流量基本保持不变,如果持续压力会再次将服务端扩容机器打垮,本次压测仅用于验证在服务端扩容以后,客户端机器无法正常请求到服务端新扩容机器的问题,故仅验证客户端能够正常请求到新扩容机器且客户端调用服务短时间内可自行恢复,即视为达到压测目标。

第一压 INFO

// 日志配置

log4j2.discardThreshold=INFO压测结果:日志丢弃级别使用INFO时, 服务端操作问题机器下线后,客户端调用服务监控可用率长时间无法恢复到100%,重启客户端机器后恢复;

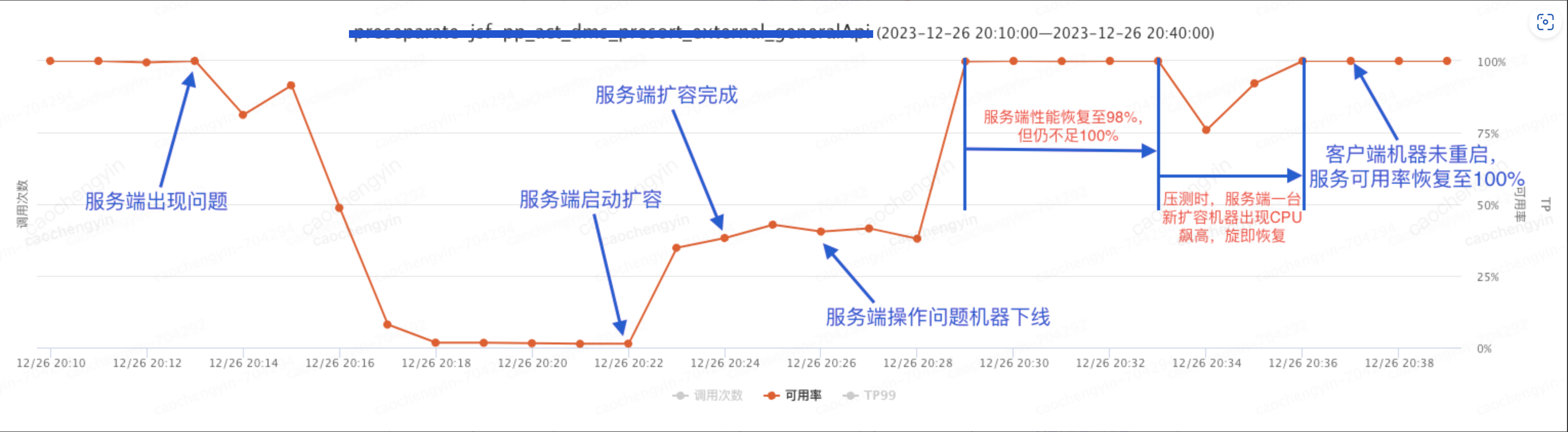

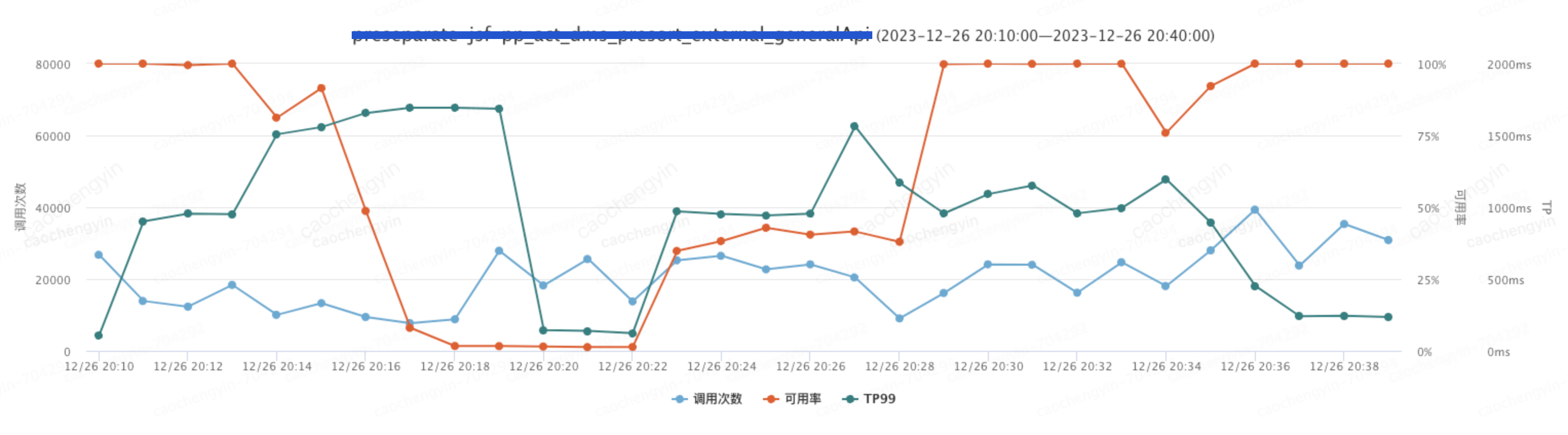

图5-2-1 压测过程可用率情况

图5-2-2 压测过程可用率+TP99+调用次数综合情况

第二压 WARN

// 日志配置

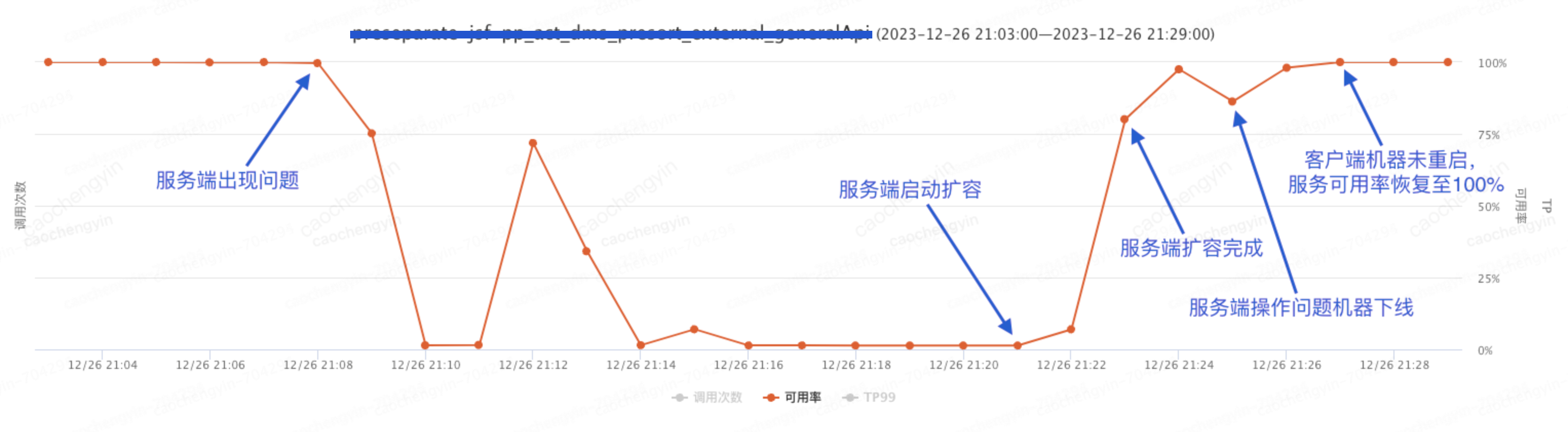

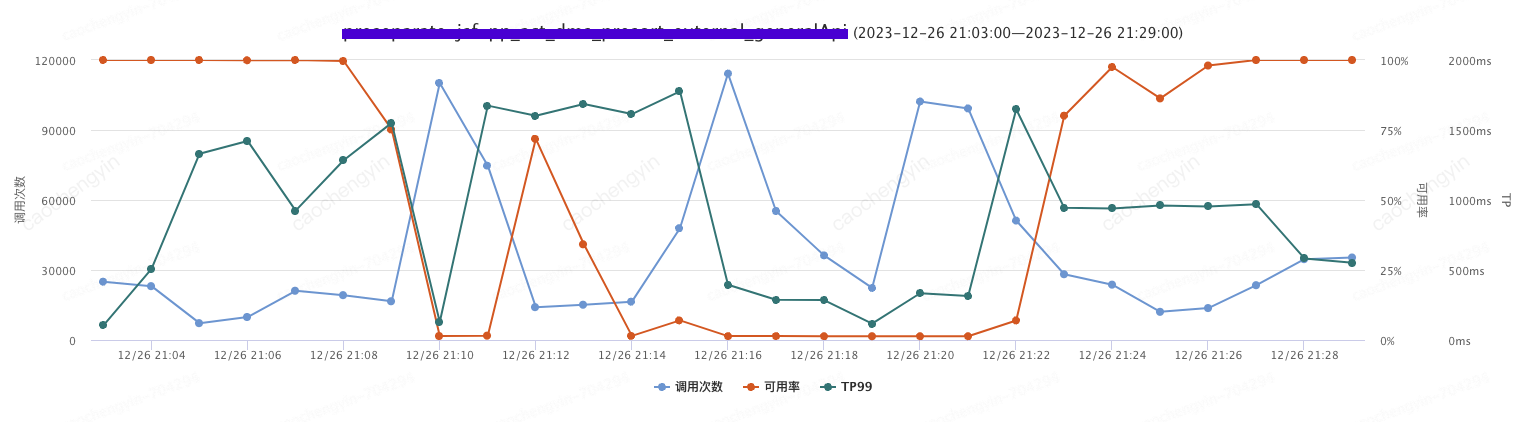

log4j2.discardThreshold=WARN压测结果:日志丢弃的级别调整到WARN后,客户端无需操作,大概3分钟左右服务可用率恢复到95%左右,大概8分钟后可用率恢复至100%;

图5-3-1 压测过程可用率情况

图5-3-2 压测过程可用率+TP99+调用次数综合情况

第三压 ERROR

// 日志配置

log4j2.discardThreshold=ERROR压测结果:日志丢弃的级别调整到ERROR后,客户端无需操作,在2分钟左右服务可用率即可恢复至100%。

图5-4-1 压测过程可用率情况

图5-4-2 压测过程可用率+TP99+调用次数综合情况

第四压 FATAL

// 日志配置

log4j2.discardThreshold=FATAL压测结果:日志丢弃的级别调整到了FATAL后,客户端无需操作,在2分钟左右服务可用率即可恢复至100%,效果与ERROR基本相同。

图5-5-1 压测过程可用率情况

图5-5-2 压测过程可用率+TP99+调用次数综合情况

异步原理

下面我们通过一副示意简图来简单介绍一下Log4j2使用Disruptor的RingBuffer进行异步日志打印的基本原理。

图5-6-1 Log4j2异步日志打印流程示意简图

六、还有高手?

配置信息

| 配置名称 | 默认值 | 描述 |

| RingBuffer槽位数量:log4j2.asyncLoggerConfigRingBufferSize(同步&异步混合使用) | 256 * 1024 (garbage-free模式下默认为4*1024) | RingBuffer槽位数量,最小值为128,在首次使用的时候进行分配,并固定大小 |

| 异步日志等待策略:log4j2.asyncLoggerConfigWaitStrategy(同步&异步混合使用) | Timeout (建议设置为Sleep) | Block:I/O线程使用锁和条件变量等待可用的日志事件,建议在CPU资源重要程度大于系统吞吐和延迟的情况下使用该种策略; Timeout:是Block策略的一个变体,可以确保如果线程没有被及时唤醒(awit())的话,线程也不会卡在那里,可以以一个较小的延迟(默认10ms)恢复; Sleep:是一种自旋策略,使用纳秒级别的自旋交叉执行Thread.yield()和LockSupport.parkNanos(),该种策略可以较好的平衡系统性能和CPU资源的使用率,并且对程序线程影响较小。 Yield:相较于Sleep省去了LockSupport.parkNanos(),而是不断执行Thread.yield()来让渡CPU使用权,但是会造成CPU一直处于较高负载,强烈不建议在生产环境使用该种策略 |

| RingBuffer槽位数量:log4j2.asyncLoggerRingBufferSize(纯异步) | 256 * 1024 (garbage-free模式下默认为4*1024) | RingBuffer槽位数量,最小值为128(2的指数),在首次使用的时候进行分配,并固定大小 |

| 异步日志等待策略:log4j2.asyncLoggerWaitStrategy(纯异步) | Timeout (建议设置为Sleep) | Block:I/O线程使用锁和条件变量等待可用的日志事件,建议在CPU资源重要程度大于系统吞吐和延迟的情况下使用该种策略; Timeout:是Block策略的一个变体,可以确保如果线程没有被及时唤醒(awit())的话,线程也不会卡在那里,可以以一个较小的延迟(默认10ms)恢复; Sleep:是一种自旋策略,使用纳秒级别的自旋交叉执行Thread.yield()和LockSupport.parkNanos(),该种策略可以较好的平衡系统性能和CPU资源的使用率,并且对程序线程影响较小。 Yield:相较于Sleep省去了LockSupport.parkNanos(),而是不断执行Thread.yield()来让渡CPU使用权,但是会造成CPU一直处于较高负载,强烈不建议在生产环境使用该种策略 |

| 异步队列满后执行策略:log4j2.asyncQueueFullPolicy | Default (强烈建议设置为Discard) | 当Appender的日志消费速度跟不上日志的生产速度,且队列已满时,指定如何处理尚未正常打印的日志事件,默认为阻塞(Default),强烈建议配置为丢弃(Discard) |

| 日志丢弃阈值:log4j2.discardThreshold | INFO (强烈建议设置为ERROR) | 当Appender的消费速度跟不上日志记录的速度,且队列已满时,若log4j2.asyncQueueFullPolicy为Discard,该配置用于指定丢弃的日志事件级别(小于等于),默认为INFO级别(即将INFO,DEBUG,TRACE日志事件丢弃掉), 强烈建议设置为ERROR(FATAL虽然有些极端,但是也可以) |

| 异步日志超时时间:log4j2.asyncLoggerTimeout | 10 | 异步日志等待策略为Timeout时,指定超时时间(单位:ms) |

| 异步日志睡眠时间:log4j2.asyncLoggerSleepTimeNs | 100 | 异步日志等待策略为Sleep时,线程睡眠时间(单位:ns) |

| 异步日志重试次数:log4j2.asyncLoggerRetries | 200 | 异步日志等待策略为Sleep时,自旋重试次数 |

| 队列满时是否将对RingBuffer的访问转为同步:AsyncLogger.SynchronizeEnqueueWhenQueueFull | true | 当队列满时是否将对RingBuffer的访问转为同步,当Appender日志消费速度跟不上日志的生产速度,且队列已满时,通过限制对队列的访问,可以显著降低CPU资源的使用率,强烈建议使用该默认配置 |

配置方式

| 配置源 | 优先级(值越低优先级越高) | 描述 |

| Spring Boot Properties | -100 | Spring Boot日志配置,需要有【log4j-spring】模块支持 |

| System Properties | 0 | 在类路径下添加log4j2.system.properties(推荐) |

| Environment Variables | 100 | 使用环境变量进行日志配置,注意该系列配置均以LOG4J_作为前缀 |

| log4j2.component.properties file | 200 | 在类路径下添加log4j2.component.properties(其实是【System Properties】的一种配置方式,但是具有较低的优先级,一般用作默认配置) |

以上内容均参考自Log4j2官方文档:Log4j – Configuring Log4j 2 (apache.org)

七、总结

经过上文分析,我们可以将Log4j2的异步日志打印优化总结如下:

上述三个配置可以保证在极端情况下日志的打印不会成为系统瓶颈,喂系统服下一颗“定心丸”。

作者:京东物流 曹成印

来源:京东云开发者社区 自猿其说 Tech 转载请注明来源

给你一颗“定心丸”——记一次由线上事故引发的Log4j2日志异步打印优化分析的更多相关文章

- 记一次线上事故的JVM内存学习

今天线上的hadoop集群崩溃了,现象是namenode一直在GC,长时间无法正常服务.最后运维大神各种倒腾内存,GC稳定后,服务正常.虽说全程在打酱油,但是也跟着学习不少的东西. 第一个问题:为什么 ...

- 记一次真实的线上事故:一个update引发的惨案!

目录 前言 项目背景介绍 要命的update 结语 前言 从事互联网开发这几年,参与了许多项目的架构分析,数据库设计,改过的bug不计其数,写过的sql数以万计,从未出现重大纰漏,但常在河边走,哪 ...

- 记一次 android 线上 oom 问题

背景 公司的主打产品是一款跨平台的 App,我的部门负责为它提供底层的 sdk 用于数据传输,我负责的是 Adnroid 端的 sdk 开发. sdk 并不直接加载在 App 主进程,而是隔离在一个单 ...

- 记一次排查线上MySQL死锁过程,不能只会curd,还要知道加锁原理

昨晚我正在床上睡得着着的,突然来了一条短信. 啥,线上MySQL死锁了,我赶紧登录线上系统,查看业务日志. 能清楚看到是这条insert语句发生了死锁. MySQL如果检测到两个事务发生了死锁,会回滚 ...

- 记一次线上bug排查-quartz线程调度相关

记一次线上bug排查,与各位共同探讨. 概述:使用quartz做的定时任务,正式生产环境有个任务延迟了1小时之久才触发.在这一小时里各种排查找不出问题,直到延迟时间结束了,该任务才珊珊触发.原因主要就 ...

- NOI Day2线上同步赛崩盘记

Preface 蒟蒻愉快的NOI线上赛Day2之行,不过因为太菜就凉了 这次由于策略&&网络的问题,最后两题都没有交,结果就靠T1稳住拿了75分就回家了. 我真是太菜了. 屠龙勇士 首 ...

- 解Bug之路-记一次线上请求偶尔变慢的排查

解Bug之路-记一次线上请求偶尔变慢的排查 前言 最近解决了个比较棘手的问题,由于排查过程挺有意思,于是就以此为素材写出了本篇文章. Bug现场 这是一个偶发的性能问题.在每天几百万比交易请求中,平均 ...

- 【算法随记】Canny边缘检测算法实现和优化分析。

以前的博文大部分都写的非常详细,有很多分析过程,不过写起来确实很累人,一般一篇好的文章要整理个三四天,但是,时间越来越紧张,后续的一些算法可能就以随记的方式,把实现过程的一些比较容易出错和有价值的细节 ...

- 记go中一次http超时引发的事故

记一次http超时引发的事故 前言 分析下具体的代码实现 服务设置超时 客户端设置超时 http.client context http.Transport 问题 总结 参考 记一次http超时引发的 ...

- 记一次线上频繁fullGc的排查解决过程

发生背景 最近上线的一个项目几乎全是查询业务,并且都是大表的慢查询,sql优化是做了一轮又一轮,前几天用户反馈页面加载过慢还时不时的会timeout,但是我们把对应的sql都优化一遍过后,前台响应还是 ...

随机推荐

- Python 将省、市 json 替换 成拼音

1.将 city_code_cn.json 中的省.市.区,翻译成英文,或直接替换去掉省.市 如:苏州市 -> 苏州 转成拼音后就变成 Suzhou,否则就会转成 Suzhoushi 怪怪的 ...

- JDk 与 ADB 环境变量配置

### Java环境变量配置 首先,JDK是整个Java的核心,包括了Java运行环境,一推Java工具和Java基础的类库. 网址:https://www.oracle.com/technetwor ...

- 机器学习的线性代数(Python 版)

线性代数是数学的分支学科,涉及矢量.矩阵和线性变换.它是机器学习的重要基础,从描述算法操作的符号到代码中算法的实现,都属于该学科的研究范围. 虽然线性代数是机器学习领域不可或缺的一部分,但二者的紧密关 ...

- 【OpenSSL】Visual Studio 2019配置OpenSSL 3.0开发环境

OpenSSL从1.0.2版本升级为3.0.3版本后,需要对代码进行重构.如果不可用的代码太多,需要重新开一个项目.重新配置开发环境. [第一步]登录http://slproweb.com/,下载Wi ...

- 一个“不需要”写代码 的 mock & 代理 工具

install yarn create @lowcoding/mock start yarn start mock server 默认在本地 3000 端口启动,访问 http://localhost ...

- java读取解析endnote文件

有些项目中会要求代码解析endnote文献资料获取一些标准的信息,例如XX在某著名期刊上发表了某篇文章,关于发表文章的这个事情的描述就会给坐着一个endnote文件来记录文章名称.作者.期刊名称.出版 ...

- vue中form组件中上传el-upload(单、多附件上传,以及上传回显以及编辑不出现等问题)

https://blog.csdn.net/weixin_46565787/article/details/121934075?spm=1001.2101.3001.6650.2&utm_me ...

- node知识点及第三方模块

1. 读文件内容 // 1. 通过模块的名字fs对模块进行引用 const fs = require('fs'); // 2. 通过模块内部的readFile读取文件内容 fs.readFile('. ...

- plsqll连接Oracle的两种方式

第一种方式:配置tnsnames.ora 找到plsql软件根目录 下的配置文件

- GCC 指定运行期动态链接库搜索路径

链接器 ld 的 -rpath=dir 选项可以指定运行期 so 文件的搜索路径. GCC 的 -Wl,option 选项可以传递选项给链接器 ld. 所以组合起来,可以直接使用 -Wl,-rpath ...