数据可视化基础专题(四):Pandas基础(三) mysql导入与导出

转载(有添加、修改)

作者:但盼风雨来_jc

链接:https://www.jianshu.com/p/238a13995b2b

來源:简书

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。 本次分享将介绍如何在Python中使用Pandas库实现MySQL数据库的读写。首先我们需要了解点ORM方面的知识

ORM技术

对象关系映射技术,即ORM(Object-Relational Mapping)技术,指的是把关系数据库的表结构映射到对象上,通过使用描述对象和数据库之间映射的元数据,将程序中的对象自动持久化到关系数据库中。

在Python中,最有名的ORM框架是SQLAlchemy。Java中典型的ORM中间件有:Hibernate,ibatis,speedframework。

SQLAlchemy

SQLAlchemy是Python编程语言下的一款开源软件。提供了SQL工具包及对象关系映射(ORM)工具,使用MIT许可证发行

SQLAlchemy模块提供了create_engine()函数用来初始化数据库连接,SQLAlchemy用一个字符串表示连接信息:

'数据库类型+数据库驱动名称://用户名:口令@机器地址:端口号/数据库名'

Pandas读写MySQL数据库

我们需要以下三个库来实现Pandas读写MySQL数据库:

- pandas

- sqlalchemy

- pymysql

其中,pandas模块提供了read_sql_query()函数实现了对数据库的查询,to_sql()函数实现了对数据库的写入。并不需要实现新建MySQL数据表。

sqlalchemy模块实现了与不同数据库的连接,而pymysql模块则使得Python能够操作MySQL数据库。

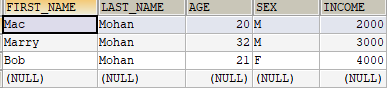

我们将使用MySQL数据库中的mydb数据库以及employee表,内容如下:

注意:

- 1.根据库的文档,我们看到to_sql函数支持两类mysql引擎一个是sqlalchemy,另一个是sqlliet3.没错,在你写入库的时候,pymysql是不能用的!!!

- mysqldb也是不能用的,你只能使用sqlalchemy或者sqlliet3!!鉴于sqllift3已经很久没有更新了,笔者这里建议使用sqlalchemy!!

- 2.to_sql函数并不在pd之中,而是在io.sql之中,是sql脚本下的一个类!!!所以to_sql的最好写法就是:

- pd.io.sql.to_sql(df1,tablename,con=conn,if_exists='repalce') qq_34685317的博客

1 import pandas as pd

2 from sqlalchemy import create_engine

3 # 初始化数据库连接,使用pymysql模块

4 # MySQL的用户:root, 密码:147369, 端口:3306,数据库:test

5 engine = create_engine('mysql+pymysql://root:123456@localhost:3306/test')

6 # 查询语句,选出employee表中的所有数据

7 sql = ''' select * from employee; '''

8 # read_sql_query的两个参数: sql语句, 数据库连接

9 df = pd.read_sql_query(sql, engine)

10 # 输出employee表的查询结果

11 print(df)

12

13 # 新建pandas中的DataFrame, 只有id,num两列

14 df = pd.DataFrame({'id': [1, 2, 3, 4], 'name': ['zhangsan', 'lisi', 'wangwu', 'zhuliu']})

15 # 将新建的DataFrame储存为MySQL中的数据表,储存index列

16 df.to_sql('mydf', engine, index=True)

17 print('Read from and write to Mysql table successfully!')

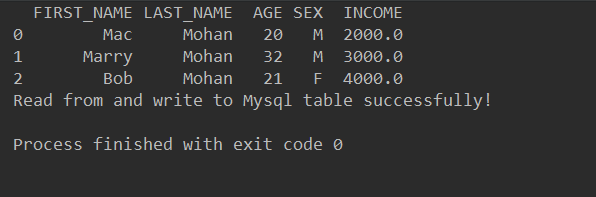

运行结果:

这说明我们确实将pandas中新建的DataFrame写入到了MySQL中!

将CSV文件写入到MySQL中

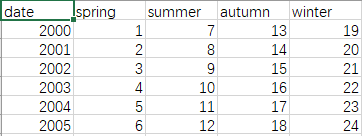

以上的例子实现了使用Pandas库实现MySQL数据库的读写,我们将再介绍一个实例:将CSV文件写入到MySQL中,示例的example.csv文件如下

示例的Python代码如下:

1 # -*- coding: utf-8 -*-

2

3 # 导入必要模块

4 import pandas as pd

5 from sqlalchemy import create_engine

6

7 # 初始化数据库连接,使用pymysql模块

8 db_info = {'user': 'root',

9 'password': '123456',

10 'host': 'localhost',

11 'port': 3306,

12 'database': 'test'

13 }

14

15 engine = create_engine('mysql+pymysql://%(user)s:%(password)s@%(host)s:%(port)d/%(database)s?charset=utf8' % db_info, encoding='utf-8')

16 # 直接使用下一种形式也可以

17 # engine = create_engine('mysql+pymysql://root:123456@localhost:3306/test')

18

19 # 读取本地CSV文件

20 df = pd.read_csv("C:/Users/fuqia/Desktop/example.csv", sep=',')

21 print(df)

22 # 将新建的DataFrame储存为MySQL中的数据表,不储存index列(index=False)

23 # if_exists:

24 # 1.fail:如果表存在,啥也不做

25 # 2.replace:如果表存在,删了表,再建立一个新表,把数据插入

26 # 3.append:如果表存在,把数据插入,如果表不存在创建一个表!!

27 pd.io.sql.to_sql(df, 'example', con=engine, index=False, if_exists='replace')

28 # df.to_sql('example', con=engine, if_exists='replace')这种形式也可以

29 print("Write to MySQL successfully!")

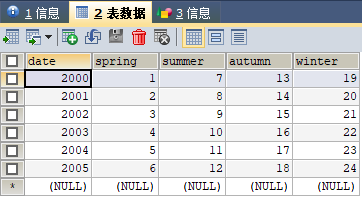

在MySQL中查看example表格

补充:engine.execute(sql)可以直接执行sql语句:

1 from sqlalchemy import create_engine

2

3

4 engine = create_engine('mysql+pymysql://root:123456@localhost:3306/test')

5 sql = "DROP TABLE IF EXISTS example"

6 engine.execute(sql)

如果用pymysql,则必须用cursor,读者可以对比一下。

1 import pymysql

2 from sqlalchemy import create_engine

3

4 conn = pymysql.connect(host='127.0.0.1', port=3306, user='root', passwd='123456', db='test')

5 # engine = create_engine('mysql+pymysql://root:123456@localhost:3306/test')

6 sql = "DROP TABLE IF EXISTS test_input"

7 cursor = conn.cursor()

8 cursor.execute(sql)

总结

本文主要介绍了ORM技术以及SQLAlchemy模块,并且展示了两个Python程序的实例,介绍了如何使用Pandas库实现MySQL数据库的读写。

程序本身并不难,关键在于多多练习

数据可视化基础专题(四):Pandas基础(三) mysql导入与导出的更多相关文章

- [独孤九剑]Oracle知识点梳理(三)导入、导出

本系列链接导航: [独孤九剑]Oracle知识点梳理(一)表空间.用户 [独孤九剑]Oracle知识点梳理(二)数据库的连接 [独孤九剑]Oracle知识点梳理(三)导入.导出 [独孤九剑]Oracl ...

- mysql导入和导出数据

Linux下如何单个库进行导入和备份操作 1.将数据导入数据库mysql -u账号 -p密码 数据库<sql脚本 mysql -uroot -proot test</home/upload ...

- 数据可视化之powerBI基础(十二)PowerBI导入Excel数据有哪几种方式?

https://zhuanlan.zhihu.com/p/64999937 Excel作为使用最频繁.应用最广泛.用户最庞大的数据处理工具,当然也应该是PowerBI最常用的数据获取方式,本文介绍一下 ...

- 前端er必须掌握的数据可视化技术

又是一月结束,打工人准时准点的汇报工作如期和大家见面啦.提到汇报,必不可少的一部分就是数据的汇总.分析. 作为一名合格的社会人,我们每天都在工作.生活.学习中和数字打交道.小到量化的工作内容,大到具体 ...

- Oracle 数据的导入和导出(SID service.msc)

一:版本号说明: (1)(Oracle11 32位系统)Oracle - OraDb11g_home1: (2)成功安装后显演示样例如以下:第一个图是管理工具.创建连接.创建表:第二个是数据库创建工 ...

- 小白学 Python 数据分析(5):Pandas (四)基础操作(1)查看数据

在家为国家做贡献太无聊,不如跟我一起学点 Python 人生苦短,我用 Python 前文传送门: 小白学 Python 数据分析(1):数据分析基础 小白学 Python 数据分析(2):Panda ...

- Python数据可视化基础讲解

前言 本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者:爱数据学习社 首先,要知道我们用哪些库来画图? matplotlib ...

- python 爬虫与数据可视化--python基础知识

摘要:偶然机会接触到python语音,感觉语法简单.功能强大,刚好朋友分享了一个网课<python 爬虫与数据可视化>,于是在工作与闲暇时间学习起来,并做如下课程笔记整理,整体大概分为4个 ...

- 「kuangbin带你飞」专题十四 数论基础

layout: post title: 「kuangbin带你飞」专题十四 数论基础 author: "luowentaoaa" catalog: true tags: mathj ...

随机推荐

- 授权函数-web_set_user

为Web服务器指定登录字符串.当我们使用RNS服务器或者某些服务器的时候需要我们输入账号密码登录才能给进行访问,那么这个时候就需要用到该函数 int web_set_user(const char* ...

- python获取本地时间戳

import time print(time.time())#获当前时间的时间戳 print(time.localtime())#获取本地时间 print(time.strftime('%Y-%m-% ...

- Adobe Photoshop CC 2019 下载+安装教程

1. 安装包 链接: https://pan.baidu.com/s/1_w1SjGVjWNJ9nuTqEcaykg 提取码: xatq 2. 打开安装包 运行Set-up,选择语言,位置 ,选择继续 ...

- YII2.0安装教程,数据库配置前后台

1.首先下载yii-advanced-app-2.0.6.tgz 我本地服务用的是Apache 2.解压到E:\wamp\www\yii2目录下面将目录advanced下所有文件剪切到 E:\wamp ...

- position两种绝对定位的区别

position绝对定有两种,分别为absolute和fixed 一.共同点: 1.改变行内元素的呈现方式,display被置为inline:block 2.让元素脱离普通流,不占据空间 3.默认会覆 ...

- Netty中的这些知识点,你需要知道!

一.Channel Channel是一个接口,而且是一个很大的接口,我们称之为“大而全”,囊括了server端及client端接口所需要的接口. Channel是一个门面,封装了包括网络I/O及相关的 ...

- Oracle调用Java方法(上)如何使用LoadJava命令和如何将简单的Jar包封装成Oracle方法

最近在工作中遇到了遇到了一个需求需要将TIPTOP中的数据导出成XML并上传到FTP主机中,但是4GL这方面的文档比较少最终决定使用Oracle调用Java的方法,在使用的过程中发现有很多的坑,大部分 ...

- 第三章:软件也要拼脸蛋-UI 开发的点点滴滴

常用控件 常用控件有:按钮 Button.文本显示框 TextView.图片显示框 ImageView.文本编辑框 EditText.进度条 ProgressBar.提示框 AlertDialog.进 ...

- java并发——copyonwrite

今天在网上看到一个问题,问除了加锁之外,有没有其他方法来保证线程安全? ---- copyonwrite机制 一.copyonwrite机制 机制实现:写时复制, 在往集合中添加数据的时候,先拷贝存储 ...

- Python三大器之生成器

Python三大器之生成器 生成器初识 什么是生成器 生成器本身属于迭代器.继承了迭代器的特性,惰性求值,占用内存空间极小. 为什么要有生成器 我们想使用迭代器本身惰性求值的特点创建出一个可以容纳百万 ...