Datenode无法启动

执行start-dfs.sh后,或者执行datenode没有启动。很大一部分原因是因为在第一次格式化dfs后,启动并使用了hadoop,后来又重新执行了格式化命令

这时主节点namenode的clusterID会重新生成,而从节点datanode的clusterID 保持不变导致的。

解决方法:

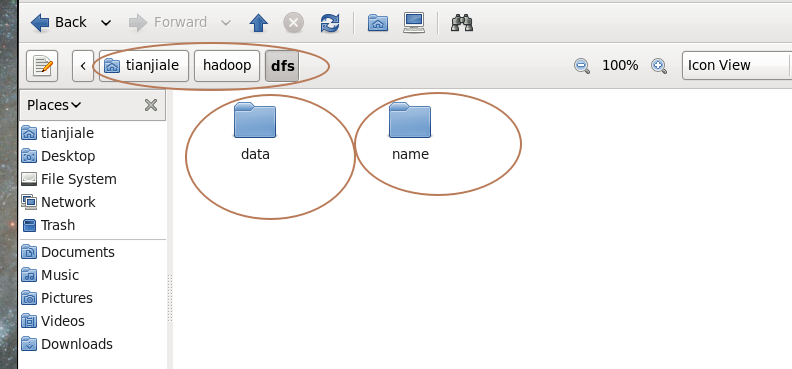

1.查看路径:

配置hadoop-2.6.4的各项文件(注意:路径不同,命令也不一样)

cd

cd hadoop/hadoop-2.6.4

cd etc/hadoop

gedit hdfs-site.xml //修改代码

找到如下代码:

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/home/tianjiale/hadoop/dfs/name</value>

<final>true</final>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/home/tianjiale/hadoop/dfs/data</value>

<final>true</final>

</property>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<value> 里面的路径需要注意

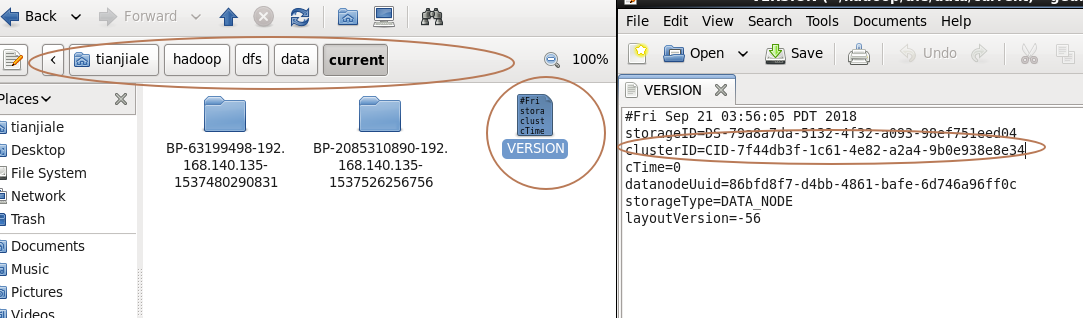

2.查看namenode和datanode的clusterID是否相同。

如果clusterID不相同,则将namenode的clusterID赋值给datanode的clusterID。

然后重新运行脚本start-dfs.sh.

最后jps查询看看。

Datenode无法启动的更多相关文章

- 执行start-dfs.sh后,datenode没有启动的解决办法

执行start-dfs.sh后,datenode没有启动,很大一部分原因是因为在第一次格式化dfs后,启动并使用了hadoop,后来又重新执行了格式化命令(hdfs namenode -format) ...

- hadoop集群之Datenode无法启动解决办法

hadoop集群之Datenode无法启动解决办法 我们在启动hadoop集群的时候,通过jps查看进程,发现namenode RM和Secondary NameNode都有,但datanode没有启 ...

- 执行start-dfs.sh后,datenode没有启动

Hadoop2.2.0启动异常 – Incompatible clusterIDs 2014年08月29日 ⁄ 综合 ⁄ 共 2399字 ⁄ 字号 小 中 大 ⁄ 评论关闭 今天启动Hadoop2.2 ...

- 安装hadoop2.4.0遇到的问题

一.执行start-dfs.sh后,datenode没有启动 查看日志如下: 2014-06-18 20:34:59,622 FATAL org.apache.hadoop.hdfs.server.d ...

- Hadoop安装错误总结

Master的NodeManager/DateNode未启动 日志中未出现任何错误 正常现象,如需在Master中启动可在slave文件中 slaves localhost slave01 slave ...

- Hadoop、Spark 集群环境搭建问题汇总

Hadoop 问题1: Hadoop Slave节点 NodeManager 无法启动 解决方法: yarn-site.xml reducer取数据的方式是mapreduce_shuffle 问题2: ...

- Hadoop中的控制脚本

1.提出问题 在上篇博文中,提到了为什么要配置ssh免密码登录,说是Hadoop控制脚本依赖SSH来执行针对整个集群的操作,那么Hadoop中控制脚本都是什么东西呢?具体是如何通过SSH来针对整个集群 ...

- dateNode 启动不了

dateNode 启动不了 进去路径中找到 name和data文件夹,current下面分别有 一个 version文件,打开发现两个clusterId都不一样 把name和data文件里面的ver ...

- hadoop集群之HDFS和YARN启动和停止命令

假如我们只有3台linux虚拟机,主机名分别为hadoop01.hadoop02和hadoop03,在这3台机器上,hadoop集群的部署情况如下: hadoop01:1个namenode,1个dat ...

随机推荐

- Android学习笔记_63_手机安全卫士知识点归纳(3)分享 程序锁 服务 进程管理 widget

1.分享: Intent shareIntent = new Intent(); shareIntent.setAction(Intent.ACTION_SEND); shareIntent.setT ...

- mssql数据库迁移到mysql

使用mysql migration toolkit工具来进行迁移.(需要安装jdk6 java的安装包) 发现数据量大的表却没能迁过来.软件使用比较容易,配置下源数据库信息,和目标数据库信息就可以进行 ...

- 数据库——MySQL——数据类型

详细的看后面给的链接,我只是挑了一部分:http://www.runoob.com/mysql/mysql-data-types.html 在之前说了MySQL的存储引擎.它决定了表的类型,而表内存放 ...

- ref、refs使用的注意事项

ref是被用来给元素或子组件注册引用信息.引用信息将注册在父组件的 $refs 对象身上.如果在普通的DOM元素身上使用,引用指向就是DOM元素:如果用在子组件身上,引用就是指向组件实例. 当v-fo ...

- CentOS7——vi编辑保存

按ESC键 跳到命令模式,然后: :w 保存文件但不退出vi :w file 将修改另外保存到file中,不退出vi :w! 强制保存,不推出vi :wq 保存文件并退出vi :wq! 强制保存文件, ...

- Python日常运维脚本

1 扫描Windows系统CPU.内存.磁盘利用率 1.1 实现代码 #!usr/bin/env python #-*- coding:utf-8 _*- ""&quo ...

- 【Linux】wget: command not found的两种解决方法

1.rpm 安装 下载wget的RPM包: http://mirrors.163.com/centos/6.8/os/x86_64/Packages/wget-1.12-8.el6.x86_64.rp ...

- C#中给WebClient添加代理Proxy

效果图: using System; using System.Collections.Generic; using System.ComponentModel; using System.Data; ...

- hive 学习系列二(数据库的创建删除修改) 拿走,不谢。

database 相当于一个目录或者命名空间,用来更好地进行表的管理 在hdfs 的目录位置大致如下: [root@iZbp12vtv76y9q3d633bh6Z /]# hadoop fs -ls ...

- mysql日志管理#慢日志详解

MySQL的慢查询日志是MySQL提供的一种日志记录,它用来记录在MySQL中响应时间超过阀值的语句,具体指运行时间超过long_query_time值的SQL,则会被记录到慢查询日志中 long_q ...