BP算法完整推导 2.0 (下)

上篇主要阐述 BP算法的过程, 以及 推导的 4 大公式的结论, 现在呢要来逐步推导出这写公式的原理. 当理解到这一步, 就算真正理解 BP算法了. 也是先做一个简单的回顾一下, 不是很细, 重点在推导, 不清楚就结合图像呀, 其实很直观的. 全篇其实就是在求偏导, 引入中间变量, 应用链式法则 而已.

BP算法-变量声明

重点是理解 反向 即从 从右到左 的方向哦;

- \(w^l_{jk}\) 第 l 层, 第 j 个节点, 到 第 \((l-1)\) 层的 第 k 个节点的 权值 (weight) ( 反向, 反向, 方向, 反向, 说了4遍)

- \(w^l\) 第 l 层, 的 权值矩阵, 第 j 行, 第 k 列 为 \(w^l_{jk}\)

- \(b_j^l\) 第 l 层, 第 j 个节点 的 bias (偏置)

- \(b^l\) 第 l 层, 的 bias 向量

- \(a^l_j\) 第 l 层, 第 j 个节点的 激励 (activation)

- \(a^l\) 第 l 层, 的 激励 向量

假设激活函数是 \(\sigma\) , 根据网络 层次间的 映射(加权求和) 的关系, (每个神经元的模型):

单个神经元: \(a^l_j = \sigma(\sum\limits _k w^l_{jk} \ a^{l-1}_k + b^l_j)\)

该层的神经元: \(a^l = \sigma (w^l a^{l-1} + b^l)\)

如不能理解每个变量代表的意义, 就看图, 非常直观的呀

\(z^l = w^l a^{l-1} + b^l\)

\(z^l\) The weighted input to the neurons in layer l.

再定义一个中间变量 \(z^l\) 即 第 l 层神经元的 加权求输入向量, 其分量, \(z^l_j\) 为第 l 层, 第 j 个神经元的 加权求和输入.

\(z^l_j =\sum \limits_k w_{jk} a_k ^{l-1} + b^l_j\)

于是呢, 对于每个节点的输出, 就可以简单表示为 (向量形式哈) :

\(a^l = \sigma(z^l)\)

然后来看定义 损失函数, 采用咱最熟悉的 平方损失 的形式:

\(y = y(x)\) 样本 x 的标签向量 (期望输出)

\(a^L = a^L(x)\) 样本 x 的网络输出激励向量

n : 表示样本数量; L 表示网络层数

样本 x 表示向量, 每个分量也是一个向量(多特征), 对应于数据的每一行. 因此, x 写出来就是 nxp的矩阵

\(C = \frac {1}{2n} \sum \limits_x ||y(x) - a^L(x)||^2\)

这个 0.5 都懂哈, , 没啥特定意义. 就是求导的时候, 式子的2范数, 要把2拿下来 再 乘0.5, 就为1 , 形式上美观而已.

公式1: C 对于 - 输出层的梯度

梯度, 在BP中, 就是误差

\(\delta_j^L = \frac {\partial C}{\partial a^L_j} \ \sigma'(z^L_j) = \nabla _a C \odot \ \sigma'(z^L_j)\)

过程: (理解图 和 求导链式法则哦)

因为, \(\delta_j^L = \frac {\partial C}{\partial a^L_j} \ \frac {\partial a^L_j}{\partial z^L_j}\) , 而 \(a^L_j = \sigma (z^L_j)\), 因此, \(\delta_j^L = \frac {\partial C}{\partial a^L_j} \ \sigma'(z^L_j)\)

- \(\frac {\partial C}{\partial a^L_j}\) 表示代价函数 C 对于 输出层 第 j 个节点 的激励变化程度.

- \(\sigma'(z^L_j)\) 表示 这第 j 个节点, 对于上层 加权输入 的变化程度.

如果使用上面给定的 哈达玛积公式, 写成矩阵形式的话, 就变成了:

\(\nabla _a C \odot \ \sigma'(z^L_j)\)

- 向量 \(\nabla_a C\) 的第 j 个元素误差为: \(\frac {\partial C}{\partial a^L_j} = \nabla_a C = (a^L - y)\)

- $ \delta ^L = (a^L - y) \odot \ \sigma'(z^L)$

过程:

\(\nabla_a C\) 即是对 \(C_x = \frac {1}{2} ||y - a^L||^2\) 的求导而得 ( \(y-a^L\) )

公式2: C 对于- 中间层 的梯度

\(\delta ^l = ((w^{l+1})^T \delta ^{l+1}) \odot \sigma '(z^l)\)

即假设已经知道 \(l+1\) 层的误差, 通过 \(l+1\) 层 和 l 层之间的 权值矩阵 w, 将误差进行回传, 得到 l 层的误差

推导:

根据上面 z 和 每层的节点的 误差定义 (偏导数作为误差) ,则第 l+1 层, 的第 k 个节点 的误差表示为:

\(\delta ^{l+1}_k = \frac {\partial C} {\partial z_k^{l+1}}\)

对于 l 层, 第第 j 个节点, 的误差表示为:

\(\delta ^l = \frac {\partial C}{\partial z^l_j}\) 这个是定义来的, 然后根据 层 之间的 加权输入用 链式法则 展开为有关于 (l +1) 层的变量

\(=\sum \limits_k \frac {\partial C}{\partial z^{l+1}_k} \frac {\partial z^{l+1}_k}{\partial z^l_j} = \sum \limits_k \delta^{l+1}_k \frac {\partial z^{l+1}_k}{\partial z^l_j}\)

第一项已经知道了, 继续探讨下 第二项 (注意变量的下标, 结合图形来理解)

\(z^{l+1}_k = \sum\limits_j w_{kj}^{l+1} a^l_j + b^{l+1}_k = \sum\limits_j w_{kj}^{l+1} \sigma (z^l_j) + b^{l+1}_k\)

\(\frac {\partial z^{l+1}_k}{\partial z^l_j} = w^{l+1}_{kj} \sigma '(z^l_j)\) 这里 \(\sum\) 是没有了, 因为跟 其他的 j 项 是没有关系的.

因此,

\(\delta ^l = \sum_k w^{l+1}_{kj} \sigma '(z^l_j) \delta_k ^{l+1}\)

\(\delta ^l = \sigma '(z^l_j) \sum_k w^{l+1}_{kj}\delta_k ^{l+1}\) 拎出 \(\sigma\) 是因为 \(\sum\) 对其不起作用, 可看作一个常数放在外面.

这个写成 哈达玛积的形式, 也就是上面的 \(\delta ^l = ((w^{l+1})^T \delta ^{l+1}) \odot \sigma '(z^l)\)

我个人感觉, 就直接写成推导的式子挺好的, 写为了 哈达玛积 反而有些让人看不懂, 而且吧, 我还容易写错. 都是矩阵嘛, 真的很容易就写错了, 这样反而造成更大的误解...不过呢, 多学学 debug 也是蛮重要的.

ps: 我现在就特别喜欢 debug 或者找 帮小伙伴找 bug 还有代码重构, 我感觉这是一个最为高效的互相学习交流的方式, 既学习别人的开发思路和代码风格 , 同时也跟别人分享自己的思路, 蛮有趣的体验哦.

公式3: C 对于 - Bias 的梯度

\(\frac {\partial C}{\partial b^l_j} = \delta^l_j\) 写成矩阵就是: \(\frac {\partial C}{\partial b} = \delta\)

推导:

\(z^l_j = \sum\limits_k w^l_{jk} a^{l-1}_k + b_j ^l\) 这个上面的 l 层 和 l+1 层是一样的, 重在理解层间的, 加权求和输入再激活的 关系

易知: \(\frac {\partial z^l_j}{\partial b^l_j} = 1\)

则: \(\frac {\partial C}{\partial b^l_j} = \frac {\partial C}{\partial z^l_j} \frac {\partial z^l_j}{\partial b^l_j} = \frac {\partial C}{\partial z^l_j} = \delta^l_j\)

公式4: C 对于 - 权值 的梯度

\(\frac {\partial C}{\partial w^l_{jk}} = a^{l-1}_k \delta^l_j\) 也可这样表达为: \(\frac {\partial C}{\partial w} = a_{in} \delta_{out}\)

推导: (跟公式3一样, 还是厉害 层间的关系, 注意理解每个下标的含义哦)

\(z^l_j = \sum\limits_k w^l_{jk} a^{l-1}_k + b^l_j\)

易知: \(\frac {\partial z^l_j}{\partial w^l_{jk}} = a^{l-1}_k\)

则: \(\frac {\partial C}{\partial w^l_{jk}} = \frac {\partial C}{\partial z^l_j} \frac {\partial z^l_j}{\partial w^l_{jk}} = a^{l-1}_k \ \frac {\partial C}{\partial z^l_{j}} = a^{l-1}_k \delta^l_j\)

\(a_{in}\) 表示 输入权值 w 上层 神经元的 激励实值

\(\delta_{out}\) 表示 本层 权值 w 输入到 下层 神经元的 误差实值

如果 \(a_{in}\) 接近于0, 则表示该 权值的梯度也接近0, 此时称该神经元的权值学习比较慢, 即梯度变化时, 对代价函数的影响较小. (激励值过低的神经元学习很慢), 这种神经元呢, 也被称为 饱和神经元 这就是我们期望的效果呀.

饱和神经元: (先看咱上边推导出的结论)

\(\sigma(x) = \frac {1}{1+e^{-x}}\)

\(\sigma'(x) = \sigma(x) (1-\sigma(x))\)

\(\delta_j^L = \frac {\partial C}{\partial a^L_j} \ \sigma'(z^L_j) = \nabla _a C \odot \ \sigma'(z^L_j)\)

\(\delta ^l = ((w^{l+1})^T \delta ^{l+1}) \odot \sigma '(z^l)\)

\(\frac {\partial C}{\partial w^l_{jk}} = a^{l-1}_k \delta^l_j\)

从激励函数来看,

\(\sigma(x) = \frac {1}{1+e^{-x}}\) 是一个 " s " 型的函数, 当 x = 0的时候, 激励值为 0.5

当某层神经元的 加权输入, **过大 或 过小 ** 时, 则 输出的激励值 要么接近1, 要么接近于 0, 这样呢, 对于 C 来时, 会导致 激励的导数值为 0, 从而 误差减小, 即权值学习很慢, 逐渐接近 饱和 (saturated) , 逐渐停止学习.

理解上面式子, 因为 \(\sigma'(x)\) 变化所带来的一连串影响哦

一个权值学习慢, 可能是因为 输入的神经元的激励很小, 或者其输出的神经元接近饱和( 激励过大接近1, 或过小, 接近0) .

小结 - 四大公式 及 矩阵表达

公式1: C 对于 - 输出层的梯度: \(\delta_j^L = \frac {\partial C}{\partial a^L_j} \ \sigma'(z^L_j) = \nabla _a C \odot \ \sigma'(z^L_j)\)

公式2: C 对于 - 中间层的梯度: \(\delta ^l = ((w^{l+1})^T \delta ^{l+1}) \odot \sigma '(z^l)\)

公式3: C 对于 - Bias 的梯度: \(\frac {\partial C}{\partial b^l_j} = \delta^l_j\)

公式4: C 对于 - 权值 的梯度: \(\frac {\partial C}{\partial w^l_{jk}} = a^{l-1}_k \delta^l_j\)

然后来写一波矩阵表达. (假设 隐含层是 m个节点, 输出层是 n 个节点)

为啥要矩阵表达呢, 首先是比较简洁呀, 公式上, 虽然有点不好理解. 但, 写成矩阵, 容易编程实现呀

公式1 可写为: \(\delta^L = \Sigma(z^L) \nabla_aC\)

\(\Sigma\) 这不是求和, 我写的 latex 是这样的: \Sigma 读作 " C 格码", 是个对角阵 \(\Sigma(z^L)\)主对角线元素为: \(\sigma (z^L_j)\)

维数: n x n, nx1 ==> nx1 的向量; L 表示输出层

公式2 可写为: \(\delta^l = \Sigma (z^L) (w^{l+1})^T \delta ^{l+1})\)

跟前面转法一样的, 维数分别是: mxm, (nxm) ^T, nx1 ==> m x 1 的向量, \(l\) 表示 中间的任意一层

公式3 可写为: \(\frac {\partial C}{\partial b^l} = \delta^l\)

公式4 可写为: \(\frac {\partial C}{\partial w} = a^{l-1}\ (\delta^l)^T\)

w 是 mxn 的矩阵; \(\delta ^l\) 是 l 层的误差向量, nx1维; $a^{l-1} 是 (l-1)层 $ 的激励向量, mx1维.

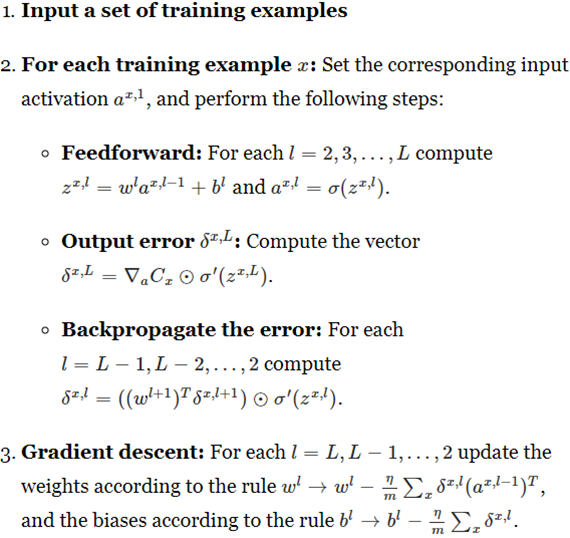

BP算法步骤 (SGD)

总体来看, BP 算法, 就2步

- 前向计算出误差

- 误差后传, 更新权值

搞定, 还差 撸一把numpy 代码, 这个不是很难哦, 网上也有很多, 不在这些了, 私下自己后面再编写吧, 毕竟思路的很清楚了.

BP算法完整推导 2.0 (下)的更多相关文章

- BP算法基本原理推导----《机器学习》笔记

前言 多层网络的训练需要一种强大的学习算法,其中BP(errorBackPropagation)算法就是成功的代表,它是迄今最成功的神经网络学习算法. 今天就来探讨下BP算法的原理以及公式推导吧. 神 ...

- BP算法的推导

反向传播算法的推导 如图为2-layers CNN,输入单元下标为i,数量d:隐层单元下表j,数量\(n_H\):输出层下表k,单元数量c 1.目标 调整权系数\(w_{ji}\),\(w_{kj}\ ...

- EM算法-完整推导

前篇已经对EM过程,举了扔硬币和高斯分布等案例来直观认识了, 目标是参数估计, 分为 E-step 和 M-step, 不断循环, 直到收敛则求出了近似的估计参数, 不多说了, 本篇不说栗子, 直接来 ...

- 一文彻底搞懂BP算法:原理推导+数据演示+项目实战(上篇)

欢迎大家关注我们的网站和系列教程:http://www.tensorflownews.com/,学习更多的机器学习.深度学习的知识! 反向传播算法(Backpropagation Algorithm, ...

- 深度学习——前向传播算法和反向传播算法(BP算法)及其推导

1 BP算法的推导 图1 一个简单的三层神经网络 图1所示是一个简单的三层(两个隐藏层,一个输出层)神经网络结构,假设我们使用这个神经网络来解决二分类问题,我们给这个网络一个输入样本,通过前向运算得到 ...

- 多层神经网络BP算法 原理及推导

首先什么是人工神经网络?简单来说就是将单个感知器作为一个神经网络节点,然后用此类节点组成一个层次网络结构,我们称此网络即为人工神经网络(本人自己的理解).当网络的层次大于等于3层(输入层+隐藏层(大于 ...

- BP算法的矩阵推导

目录 1. 需要的微积分知识 1.1 导数 1.2 求导的链式法则 2. 梯度下降法 2.1 梯度 2.2 梯度算法的解释 3.误差反向传播算法 3.1 理论推导 3.1.1 符号说明 3.1.2 推 ...

- 人工神经网络反向传播算法(BP算法)证明推导

为了搞明白这个没少在网上搜,但是结果不尽人意,最后找到了一篇很好很详细的证明过程,摘抄整理为 latex 如下. (原文:https://blog.csdn.net/weixin_41718085/a ...

- 从 0 开始机器学习 - 神经网络反向 BP 算法!

最近一个月项目好忙,终于挤出时间把这篇 BP 算法基本思想写完了,公式的推导放到下一篇讲吧. 一.神经网络的代价函数 神经网络可以看做是复杂逻辑回归的组合,因此与其类似,我们训练神经网络也要定义代价函 ...

- 误差逆传播(error BackPropagation, BP)算法推导及向量化表示

1.前言 看完讲卷积神经网络基础讲得非常好的cs231后总感觉不过瘾,主要原因在于虽然知道了卷积神经网络的计算过程和基本结构,但还是无法透彻理解卷积神经网络的学习过程.于是找来了进阶的教材Notes ...

随机推荐

- Linux服务器部署SpringBoot项目教程

1. 服务器配置1.1 购买服务器1.2 配置安全组1.3 登录实例1.4 安装宝塔面板2. 配置宝塔2.1 创建数据库3. 打包部署项目3.1 修改项目配置3.2 打包3.3 部署3.4 放行端口3 ...

- 如何用爱思助手给苹果iPhone手机免越狱修改虚拟定位教程

使用爱思助手修改定位的方法: 1.在电脑上下载安装 爱思助手 客户端,并更新到最新版,用数据线将苹果移动设备连接到电脑. 2.连接成功后,依次打开爱思助手"工具箱 - 虚拟定位". ...

- 八米云-Hyper-V虚拟机安装教程

疑难解答加微信机器人,给它发:进群,会拉你进入八米交流群 机器人微信号:bamibot 简洁版教程访问:https://bbs.8miyun.cn 准备阶段: 八米云启动U盘(制作方法可参看<制 ...

- Typecho去除更新检测和后台日志

Typecho去除官方日志 打开 admin/index.php,找到下面的代码并删除,在 93-102 行. 代码: <div class="col-mb-12 col-tb-4&q ...

- 豆包:php如何模拟多客户端访问服务器

在 PHP 中模拟多客户端访问服务器可以通过以下几种方式实现,具体方法根据需求选择: 方法 1:使用 cURL 多请求(Multi Handle) 通过 curl_multi_* 系列函数实现并发 ...

- 【答题系统可参考】php 禁止api被跨域调用

在 PHP 中,防止 API 被跨域调用可以通过设置适当的 HTTP 响应头来实现.跨域资源共享(CORS,Cross-Origin Resource Sharing)机制允许或拒绝来自不同源的请求. ...

- 震惊!AI编程正在淘汰这5类人,你在其中吗?

大家好,我是狂师. 今天在知乎上看到一个关于讨论:"人工智能大爆发,AI编程工具对程序员到底是颠覆还是辅助?'"问题,觉得蛮有意思.的确,AI编程的出现,引发了人们对于程序员职业未 ...

- Laravel11 从0开发 Swoole-Reverb 扩展包(三) - reverb广播驱动使用流程

前情提要 我们第一节的时候,已经大致介绍reverb,他 是 Laravel 应用程序的第一方 WebSocket 服务器,可将客户端和服务器之间的实时通信直接带到您的指尖.开源且只需一个 Artis ...

- 基于webman实现的服务层框架-webman-biz-framework

简介 webman的基础上扩展的一个服务层框架,基于分层体系结构的代码模式. 如果觉得有用,可以帮我在webman-biz-framework点个小星星哟,也希望大家交流 分层体系结构的代码模式 什么 ...

- Go语言修改字符串

Go 语言的字符串无法直接修改每一个字符元素,只能通过重新构造新的字符串并赋值给原来的字符串变量实现.请参考下面的代码: angel := "Heros never die" an ...