SUSE CaaS Platform 4 - 使用 Ceph RBD 作为持久存储 (静态)

Kubernetes PersistentVolumes 持久化存储方案中,提供两种 API 资源方式: PersistentVolume(简称 PV) 和 PersistentVolumeClaim(简称 PVC)。PV 可理解为集群资源,PVC 可理解为对集群资源的请求,Kubernetes 支持很多种持久化卷存储类型。Ceph 是一个开源的分布式存储系统,支持对象存储、块设备、文件系统,具有可靠性高、管理方便、伸缩性强等特点。在日常工作中,我们会遇到使用 k8s 时后端存储需要持久化,这样不管 Pod 调度到哪个节点,都能挂载同一个卷,从而很容易读取或存储持久化数据,我们可以使用 Kubernetes 结合 Ceph 完成。

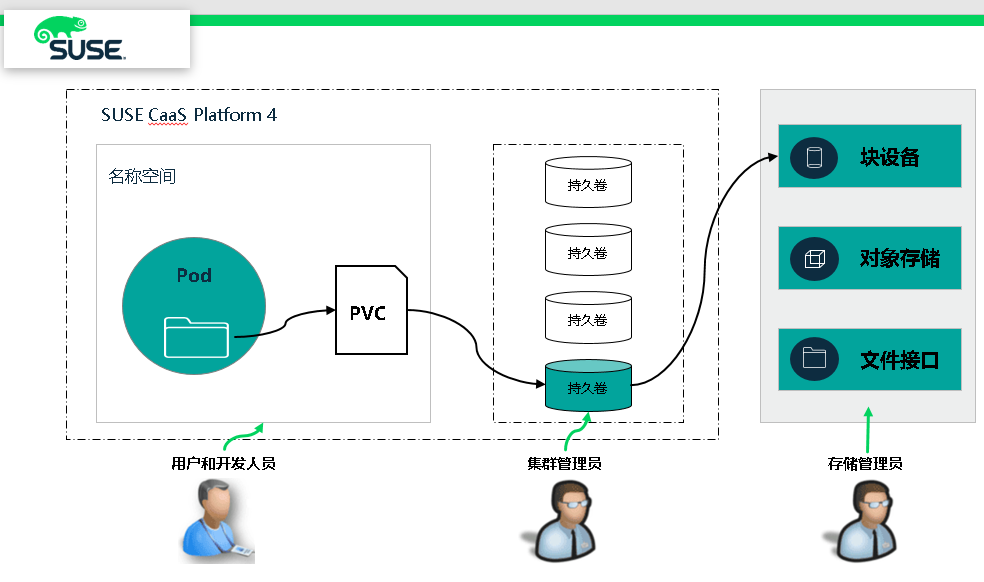

图1 Pod 存储卷、PVC 及存储设备的调用关系

实验环境搭建 - 静态供给

图2 实验环境架构

1、所有节点安装

# zypper -n in ceph-common

复制 ceph.conf 到 worker 节点上

# scp admin:/etc/ceph/ceph.conf /etc/ceph/

2、创建池

# ceph osd pool create caasp4

3、创建 key ,并存储到 /etc/ceph/ 目录中

# ceph auth get-or-create client.caasp4 mon 'allow r' \

osd 'allow rwx pool=caasp4' -o /etc/ceph/caasp4.keyring

4、创建 RBD 镜像,2G

# rbd create caasp4/ceph-image-test -s

5、查看 ceph 集群 key 信息,并生成基于 base64 编码的key

# ceph auth list

.......

client.admin

key: AQA9w4VdAAAAABAAHZr5bVwkALYo6aLVryt7YA==

caps: [mds] allow *

caps: [mgr] allow *

caps: [mon] allow *

caps: [osd] allow *

.......

client.caasp4

key: AQD1VJddM6QIJBAAlDbIWRT/eiGhG+aD8SB+5A==

caps: [mon] allow r

caps: [osd] allow rwx pool=caasp4

client.caasp4 密钥以 base64 编码

# echo AQD1VJddM6QIJBAAlDbIWRT/eiGhG+aD8SB+5A== | base64

QVFEMVZKZGRNNlFJSkJBQWxEYklXUlQvZWlHaEcrYUQ4U0IrNUE9PQo=

6、Master 节点上,创建 secret 资源,插入 base64 key

# vi ceph-secret-test.yaml

apiVersion: v1

kind: Secret

metadata:

name: ceph-secret-test

data:

key: QVFEMVZKZGRNNlFJSkJBQWxEYklXUlQvZWlHaEcrYUQ4U0IrNUE9PQo=

# kubectl create -f ceph-secret-test.yaml

secret/ceph-secret-test created

# kubectl get secrets ceph-secret-test

NAME TYPE DATA AGE

ceph-secret-test Opaque 14s

7、Master 节点上,创建 Persistent Volume

# vim ceph-pv-test.yaml

apiVersion: v1

kind: PersistentVolume

metadata:

name: ceph-pv-test

spec:

capacity:

storage: 2Gi

accessModes:

- ReadWriteOnce

rbd:

monitors:

- 192.168.2.40:6789

- 192.168.2.41:6789

- 192.168.2.42:6789

pool: caasp4

image: ceph-image-test

user: caasp4

secretRef:

name: ceph-secret-test

fsType: ext4

readOnly: false

persistentVolumeReclaimPolicy: Retain

# kubectl create -f ceph-pv-test.yaml

# kubectl get pv

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE

ceph-pv-test 2Gi RWO Retain Available 29s

8、创建 Persistent Volume Claim (PVC)

# vim ceph-claim-test.yaml

kind: PersistentVolumeClaim

apiVersion: v1

metadata:

name: ceph-claim-test

spec:

accessModes:

- ReadWriteOnce

resources:

requests:

storage: 2Gi

# kubectl create -f ceph-claim-test.yaml

# kubectl get pvc

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE

ceph-claim-test Bound ceph-pv-test 2Gi RWO 14s

9、创建 Pod

# vim ceph-pod-test.yaml

apiVersion: v1

kind: Pod

metadata:

name: ceph-pod-test

spec:

containers:

- name: ceph-busybox

image: busybox

command: ["sleep", ""]

volumeMounts:

- name: ceph-vol-test

mountPath: /usr/share/busybox

readOnly: false

volumes:

- name: ceph-vol-test

persistentVolumeClaim:

claimName: ceph-claim-test

# kubectl create -f ceph-pod-test.yaml

# kubectl get pods

NAME READY STATUS RESTARTS AGE

ceph-pod-test / ContainerCreating 6s

# kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE

ceph-pod-test / ContainerCreating 32s <none> worker02

10、worker02 节点显示 RBD 映射

# rbd showmapped

id pool namespace image snap device

caasp4 ceph-image-test - /dev/rbd0

# df -Th | grep ceph

/dev/rbd0 ext4 2.0G 6.0M 1.9G 1% /var/lib/kubelet/plugins/kubernetes.io/rbd/mounts/caasp4-image-ceph-image-test

SUSE CaaS Platform 4 - 使用 Ceph RBD 作为持久存储 (静态)的更多相关文章

- SUSE CaaS Platform 4 - 使用 Ceph RBD 作为持久存储(动态)

图1 架构图 图2 各存储插件对动态供给方式的支持状况 1.所有节点安装 # yum install ceph-common 复制 ceph.conf 到 worker 节点上 # scp admin ...

- SUSE CaaS Platform 4 - Ceph RBD 作为 Pod 存储卷

RBD存储卷 目前 CaaSP4 支持多种 Volume 类型,这里选择 Ceph RBD(Rados Block Device),主要有如下好处: Ceph 经过多年开发,已经非常熟,社区也很活跃: ...

- SUSE CaaS Platform 4 - 安装部署

SUSE CaaS Platform 相关文章 (1)SUSE CaaS Platform 4 - 简介 (2)SUSE CaaS Platform 4 - 安装部署 (3)SUSE CaaS Pla ...

- SUSE CaaS Platform 4 - 简介

SUSE CaaS Platform KUBERNETES - 面向企业 SUSE CaaS Platform 是一款企业级容器管理解决方案,可让 IT 和 DevOps 专业人士更轻松地部署.管理和 ...

- SUSE CaaS Platform 4 - 使用 NFS 作为持久存储

SUSE CaaS Platform 4 - 持久存储使用 NFS

- SUSE CaaS Platform 4 - 安装技巧

1.虚拟化环境搭建 - 网络 首先,虚拟机其中一块网卡桥接到 VMnet8 上,通过 VMnet8 地址转换出去访问互联网,如果我们直接桥接到 WIFI 网卡上,由于在不同的的网络环境,地址会时长会 ...

- SUSE Ceph RBD Mirror - Storage 6

Ceph采用的是强一致性同步模型,所有副本都必须完成写操作才算一次写入成功,这就导致不能很好地支持跨域部署,因为如果副本在异地,网络延迟就会很大,拖垮整个集群的写性能.因此,Ceph集群很少有跨域部署 ...

- 理解 QEMU/KVM 和 Ceph(1):QEMU-KVM 和 Ceph RBD 的 缓存机制总结

本系列文章会总结 QEMU/KVM 和 Ceph 之间的整合: (1)QEMU-KVM 和 Ceph RBD 的 缓存机制总结 (2)QEMU 的 RBD 块驱动(block driver) (3)存 ...

- 理解 OpenStack + Ceph (3):Ceph RBD 接口和工具 [Ceph RBD API and Tools]

本系列文章会深入研究 Ceph 以及 Ceph 和 OpenStack 的集成: (1)安装和部署 (2)Ceph RBD 接口和工具 (3)Ceph 物理和逻辑结构 (4)Ceph 的基础数据结构 ...

随机推荐

- java设计模式8.迭代子模式、责任链模式、命令模式

迭代子模式 迭代子模式可以顺序地访问一个聚集中的元素而不必暴露聚集的内部表象.它将迭代逻辑封装到一个独立的迭代子对象中,从而与聚集本身分开.迭代子对象是对遍历的抽象化,不同的聚集对象可以提供相同的迭代 ...

- lightoj 1036 - A Refining Company(简单dp)

题目链接:http://www.lightoj.com/volume_showproblem.php?problem=1036 题解:设dp[i][j]表示处理到(i,j)点时的最大值然后转移显然是 ...

- hdu 2767 Proving Equivalences(tarjan缩点)

题目链接:http://acm.hdu.edu.cn/showproblem.php?pid=2767 题意:问最少加多少边可以让所有点都相互连通. 题解:如果强连通分量就1个直接输出0,否者输出入度 ...

- JOBDU 1140 八皇后

题目1140:八皇后 时间限制:1 秒 内存限制:32 兆 特殊判题:否 提交:1064 解决:665 题目描述: 会下国际象棋的人都很清楚:皇后可以在横.竖.斜线上不限步数地吃掉其他棋子.如何将8个 ...

- 基于servlet的图书管理系统

该项目是Java语言开发的图书管理系统,IDE采用eclipse,技术采用servlet,数据库使用mysql,前端页面采用bootstrap框架,简介美观. 系统具备基础的功能,读者可以注册登录,登 ...

- Java 多线程实现接口Runnable和继承Thread区别(转)

Java 多线程实现接口Runnable和继承Thread区别 Java中有两种实现多线程的方式.一是直接继承Thread类,二是实现Runnable接口.那么这两种实现多线程的方式在应用上有什么区别 ...

- Django2.* + Mysql5.7开发环境整合

环境: MAC_OS 10.12 python 3.6 mysql 5.7.25 django 2.2.3 前提:python django mysql都已经安装成功可单独运行 一.settings中 ...

- Java 创建/识别条形码、二维码

条形码(Barcode)是将宽度不等的多个黑条和空白,按照一定的编码规则排列,用以表达一组信息的图形标识符.常用于标示物品的生产国.制造厂家.商品名称.生产日期.图书分类号.邮件起止地点.类别.日期等 ...

- linux安装python串口工具pyserial遇到不能成功导入的问题

常规方法:pip install pyserial导入serial后提示: 解决方法:apt install python3-serial 参考:https://stackoverflow.com/q ...

- 【ThinkPHP】API控制器中加入析构函数

<?php namespace app\api\controller; use think\Controller; class User extends Controller { public ...