Node.js 爬虫爬取电影信息

Node.js 爬虫爬取电影信息

我的CSDN地址:https://blog.csdn.net/weixin_45580251/article/details/107669713

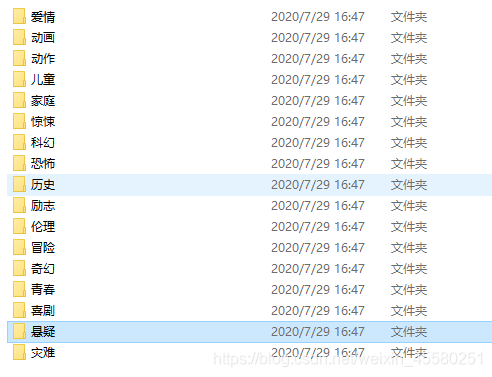

爬取的是1905电影网的信息,使用的是正则匹配。

本来为了更好地学习异步编程打好基础,没想到这玩意这么上头。

代码也写了好几天,自己技术不到家,肯定有写的不好的地方,还需要多努力。

下个月争取把vue学完,九月估计该开学了。

代码在最下面

const request=require('request');

const url="https://www.1905.com/vod/list/n_1/o3p1.html";

const fs=require('fs');

const { resolve } = require('path');

function req(url){

return new Promise((resolve,reject)=>{

request.get(url,(err,response,body)=>{

if(err) reject(err)

else resolve({response,body});

})

})

}

//获取起始界面的所有分类地址

async function getClassUrl(){

let {response,body}=await req(url);

// console.log(body);

let reg1=/<span class="search-index-L">类型 :<\/span>(.*?)<div class="grid-12x">/igs; //i不区分大小写 g全局 s让.匹配换行

let result1=reg1.exec(body)[1];

let reg2=/<a href="javascript\:void\(0\);" onclick="location\.href='(.*?)';return false;"(.*?)>(.*?)<\/a>/igs;

let result2="";

// console.log(reg2.exec(result1));

let urlArr=[];

while(result2=reg2.exec(result1)){

if(result2[3]!="全部"){

let obj={

className:result2[3],

url:result2[1]

}

urlArr.push(obj);

fs.mkdir("./movies/"+result2[3],{ recursive: true },(err) => {

if (err) throw err;

});

getMovies(result2[1],result2[3]);

// console.log(result2.index);

// console.log(reg2.lastIndex);

}

}

// console.log(urlArr.length); //17个分类

};

//通过分类栏,获取页面中的电影连接

async function getMovies(url,className){

let {response,body}=await req(url);

let reg3=/<a class="pic-pack-outer" target="_blank" href="(.*?)".*?><img/igs;

let result3="";

let urlArr=[];

while(result3=reg3.exec(body)){

urlArr.push(result3[1]);

getDate(result3[1],className);

}

}

//对电影详情页进行分析

async function getDate(url,className){

let {response,body}=await req(url);

let reg1=/<h1 class="playerBox-info-name playerBox-info-cnName">(.*?)<\/h1>/;

// let reg4=/<!-- 文字简介 -->.*?<span id="playerBoxIntroCon">(.*?)<a href="(.*?)" target="_blank" data-hrefexp="fr=vodplay_ypzl_xx">\.\.\.<span>[详细]/;

let result1=reg1.exec(body);

// console.log(result1[1]);

let reg2=/<span id="playerBoxIntroCon">(.*?)<a href="(.*?)" /;

let result2=reg2.exec(body);

// console.log(result2[2]);

writeFile(result1,result2,url,className);

}

//写入文件

async function writeFile(result1,result2,url,className){

let movie={

name:result1[1],

brief:result2[1],

url:url,

details:result2[2]

};

let data=JSON.stringify(movie);

fs.writeFile(`./movies/${className}/${movie.name}.json`,data,(err)=>{

if (err) {return console.log(err)}

});

//下面的写入流写法也可以

// let w = fs.createWriteStream(`./movies/${className}/${movie.name}.json`);

// w.write(data,'utf-8');

// w.end;

// w.on('error', function(err){

// console.log(err.stack);

// });

};

getClassUrl();

Node.js 爬虫爬取电影信息的更多相关文章

- Node.js爬虫-爬取慕课网课程信息

第一次学习Node.js爬虫,所以这时一个简单的爬虫,Node.js的好处就是可以并发的执行 这个爬虫主要就是获取慕课网的课程信息,并把获得的信息存储到一个文件中,其中要用到cheerio库,它可以让 ...

- 养只爬虫当宠物(Node.js爬虫爬取58同城租房信息)

先上一个源代码吧. https://github.com/answershuto/Rental 欢迎指导交流. 效果图 搭建Node.js环境及启动服务 安装node以及npm,用express模块启 ...

- node.js爬虫爬取拉勾网职位信息

简介 用node.js写了一个简单的小爬虫,用来爬取拉勾网上的招聘信息,共爬取了北京.上海.广州.深圳.杭州.西安.成都7个城市的数据,分别以前端.PHP.java.c++.python.Androi ...

- 手把手教你用Node.js爬虫爬取网站数据

个人网站 https://iiter.cn 程序员导航站 开业啦,欢迎各位观众姥爷赏脸参观,如有意见或建议希望能够不吝赐教! 开始之前请先确保自己安装了Node.js环境,还没有安装的的童鞋请自行百度 ...

- node js 爬虫爬取静态页面,

先打一个简单的通用框子 //根据爬取网页的协议 引入对应的协议, http||https var http = require('https'); //引入cheerio 简单点讲就是node中的jq ...

- node:爬虫爬取网页图片

代码地址如下:http://www.demodashi.com/demo/13845.html 前言 周末自己在家闲着没事,刷着微信,玩着手机,发现自己的微信头像该换了,就去网上找了一下头像,看着图片 ...

- 一个简单python爬虫的实现——爬取电影信息

最近在学习网络爬虫,完成了一个比较简单的python网络爬虫.首先为什么要用爬虫爬取信息呢,当然是因为要比人去收集更高效. 网络爬虫,可以理解为自动帮你在网络上收集数据的机器人. 网络爬虫简单可以大致 ...

- Python多线程爬虫爬取电影天堂资源

最近花些时间学习了一下Python,并写了一个多线程的爬虫程序来获取电影天堂上资源的迅雷下载地址,代码已经上传到GitHub上了,需要的同学可以自行下载.刚开始学习python希望可以获得宝贵的意见. ...

- 用java编写爬虫爬取电影

一.爬取前提1)本地安装了mysql数据库2)安装了idea或者eclipse等开发工具 二.爬取内容 电影名称.电影简介.电影图片.电影下载链接 三.爬取逻辑1)进入电影网列表页, 针对列表的htm ...

随机推荐

- Spring mvc文件上传实现

Spring mvc文件上传实现 jsp页面客户端表单编写 三个要素: 1.表单项type="file" 2.表单的提交方式:post 3.表单的enctype属性是多部分表单形式 ...

- ansible使用script模块在受控机上执行脚本(ansible2.9.5)

一,ansible的script模块的用途 script 模块用来在远程主机上执行 ansible 管理主机上的脚本, 即:脚本一直存在于 ansible 管理主机本地, 不需要手动拷贝到远程主机后再 ...

- pycharm2018.1下载激活(mac平台)

此教程实时更新,请放心使用:如果有新版本出现猪哥都会第一时间尝试激活: pycharm官网下载地址:http://www.jetbrains.com/pycharm/download/ 激活前准备工作 ...

- scrapy-下载器中间件 随机切换user_agent

from faker import Faker class MySpiderMiddleware(object): def __init__(self): self.fake = Faker() de ...

- 010_Java历史及特性

目录 Java历史 C语言 1972年 C++ 1982年 Java 1995年 Applet 图形界面的程序 J2SE Java 2 标准版 桌面 J2ME Java 2 移动版 手机 J2EE J ...

- Zookeeper(2)---节点属性、监听和权限

之前通过客户端连接之后我们已经知道了zk相关的很多命令(Zookeeper(1)---初识). 节点属性: 现在我们就通过stat指令来看看节点都有哪些属性,或者使用get 指令和-s参数来查看节点数 ...

- App 后台架构

转载请注明出处:http://blog.csdn.net/smartbetter/article/details/53933096 做App做的久了,就想研究一下与之相关的App后台,发现也是蛮有趣的 ...

- 线上问题排查,一不小心踩到阿里的 arthas坑了

最近帮新来的校招同学排查一个线上问题,问题本身不是很难,但是过程中踩到了一个arthas的坑,挺有意思的. 同时,也分享下在排查过程中使用的一些比较实用的工具,包括tcpdump.arthas.sim ...

- 走在深夜的小码农 Fifth Day

Css3 Fifth Day writer:late at night codepeasant 学习大纲: 一.css三大特性 1.层叠性 相同选择器给设置相同的样式,此时一个样式就会覆盖(层叠) ...

- httpx和requests之间有什么区别?

requests只能发送同步请求,httpx能够发送同步和异步请求. httpx的api和requests是兼容的,切换的成本几乎是零.在异步模式下,测试大量接口的话,httpx的速度是能够显著得到提 ...