Java使用极小的内存完成对超大数据的去重计数,用于实时计算中统计UV

Java使用极小的内存完成对超大数据的去重计数,用于实时计算中统计UV – lxw的大数据田地 http://lxw1234.com/archives/2015/09/516.htm

Java使用极小的内存完成对超大数据的去重计数,用于实时计算中统计UV

关键字:streamlib、基数估计、实时计算uv、大数据、去重计数

一直在想如何在实时计算中完成对海量数据去重计数的功能,即SELECT COUNT(DISTINCT) 的功能。比如:从每天零点开始,实时计算全站累计用户数(UV),以及某些组合维度上的用户数,这里的用户假设以Cookieid来计。

想想一般的解决办法,在内存中使用HaspMap、HashSet?或者是在Redis中以Cookieid为key?感觉都不合适,在数以亿计用户的业务场景下,内存显然也成了瓶颈。

如果说,实时计算的业务场景中,对UV的计算精度并不要求100%(比如:实时的监测某一网站的PV和UV),那么可以考虑采用基数估计算法来统计。这里有一个Java的实现版本 stream-lib:https://github.com/addthis/stream-lib

采用基数估计算法目的就是为了使用很小的内存,即可完成超大数据的去重计数。号称是只使用几KB的内存,就可以完成对数以条数据的去重计数。但基数估计算法都不是100%精确的,误差在0~2%之间,一般是1%左右。

本文使用stream-lib来尝试对两个数据集进行去重计数。相关的文档和下载见文章最后。

测试数据集1:

- 文件名:small_cookies.txt

- 文件内容:每个cookieid一行

- 文件总记录数:14892708

- 去重记录数:3896911

- 文件总大小:350153062(约334M)

- [liuxiaowen@dev site_raw_log]$ head -5 small_cookies.txt

- 7EDCF13A03D387548FB2B8

- da5f0196-56036078075b9f-14892137

- 1D0A83B604ADD4558970EE

- 3DF76E7100025F553B1980

- 72C756700C3CAA56035EE0

- [liuxiaowen@dev site_raw_log]$ wc -l small_cookies.txt

- 14892708 small_cookies.txt

- [liuxiaowen@dev site_raw_log]$ awk '!a[$0]++{print $0}' small_cookies.txt | wc -l

- 3896911

- [liuxiaowen@dev site_raw_log]$ ll small_cookies.txt

- -rw-rw-r--. 1 liuxiaowen liuxiaowen 350153062 Sep 25 10:50 small_cookies.txt

测试数据集2:

- 文件名:big_cookies.txt

- 文件内容:每个cookieid一行

- 文件总记录数:547631464

- 去重记录数:190264959

- 文件总大小:12610638153(约11.8GB)

- --总记录数

- spark-sql> select count(1) from big_cookies;

- 547631464

- Time taken: 7.311 seconds, Fetched 1 row(s)

- --去重记录数

- spark-sql> select count(1) from (select cookieid from big_cookies group by cookieid) x;

- 190264959

- Time taken: 80.516 seconds, Fetched 1 row(s)

- hadoop fs -getmerge /hivedata/warehouse/liuxiaowen.db/big_cookies/* big_cookies.txt

- [liuxiaowen@dev site_raw_log]$ wc -l big_cookies.txt

- 547631464 cookies.txt

- //总大小

- [liuxiaowen@dev site_raw_log]$ ll big_cookies.txt

- -rw-r--r--. 1 liuxiaowen liuxiaowen 12610638153 Sep 25 13:25 big_cookies.txt

普通方法测试

所谓普通方法,就是遍历文件,将所有cookieid放到内存的HashSet中,而HashSet的size就是去重记录数。

代码如下:

- package com.lxw1234.streamlib;

- import java.io.BufferedReader;

- import java.io.File;

- import java.io.FileReader;

- import java.io.IOException;

- import java.util.HashSet;

- import java.util.Set;

- public class Test {

- public static void main(String[] args) {

- Runtime rt = Runtime.getRuntime();

- Set set = new HashSet();

- File file = new File(args[0]);

- BufferedReader reader = null;

- long count = 0l;

- try {

- reader = new BufferedReader(new FileReader(file));

- String tempString = null;

- while ((tempString = reader.readLine()) != null) {

- count++;

- set.add(tempString);

- if(set.size() % 5000 == 0) {

- System.out.println("Total count:[" + count + "] Unique count:[" + set.size() + "] FreeMemory:[" + rt.freeMemory() + "] ..");

- }

- }

- reader.close();

- } catch (Exception e) {

- e.printStackTrace();

- } finally {

- if (reader != null) {

- try {

- reader.close();

- } catch (IOException e1) {}

- }

- }

- System.out.println("Total count:[" + count + "] Unique count:[" + set.size() + "] FreeMemory:[" + rt.freeMemory() + "] ..");

- }

- }

指定使用10M的内存运行,命令为:

- java -cp /tmp/teststreamlib.jar -Xms10M -Xmx10M -XX:PermSize=10M -XX:MaxPermSize=10M \

- com.lxw1234.streamlib.Test /home/liuxiaowen/site_raw_log/small_cookies.txt

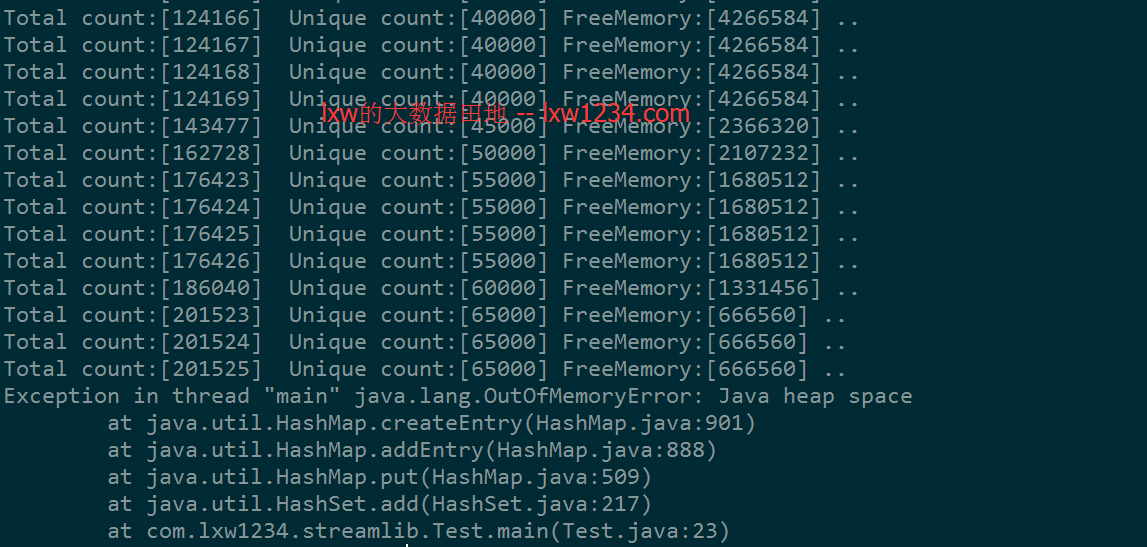

运行结果如下:

10M的内存,仅仅够存65000左右的cookieid,之后就报错,内存不够了。大数据集更不用说。

基数估计方法测试

采用streamlib中的基数估计算法实现ICardinality,对两个结果集的总记录数和去重记录数进行统计,代码如下:

- package com.lxw1234.streamlib;

- import java.io.BufferedReader;

- import java.io.File;

- import java.io.FileReader;

- import java.io.IOException;

- import com.clearspring.analytics.stream.cardinality.AdaptiveCounting;

- import com.clearspring.analytics.stream.cardinality.ICardinality;

- public class TestCardinality {

- public static void main(String[] args) {

- Runtime rt = Runtime.getRuntime();

- long start = System.currentTimeMillis();

- long updateRate = 1000000l;

- long count = 0l;

- ICardinality card = AdaptiveCounting.Builder.obyCount(Integer.MAX_VALUE).build();

- File file = new File(args[0]);

- BufferedReader reader = null;

- try {

- reader = new BufferedReader(new FileReader(file));

- String tempString = null;

- while ((tempString = reader.readLine()) != null) {

- card.offer(tempString);

- count++;

- if (updateRate > 0 && count % updateRate == 0) {

- System.out.println("Total count:[" + count + "] Unique count:[" + card.cardinality() + "] FreeMemory:[" + rt.freeMemory() + "] ..");

- }

- }

- reader.close();

- } catch (Exception e) {

- e.printStackTrace();

- } finally {

- if (reader != null) {

- try {

- reader.close();

- } catch (IOException e1) {}

- }

- }

- long end = System.currentTimeMillis();

- System.out.println("Total count:[" + count + "] Unique count:[" + card.cardinality() + "] FreeMemory:[" + rt.freeMemory() + "] ..");

- System.out.println("Total cost:[" + (end - start) + "] ms ..");

- }

- }

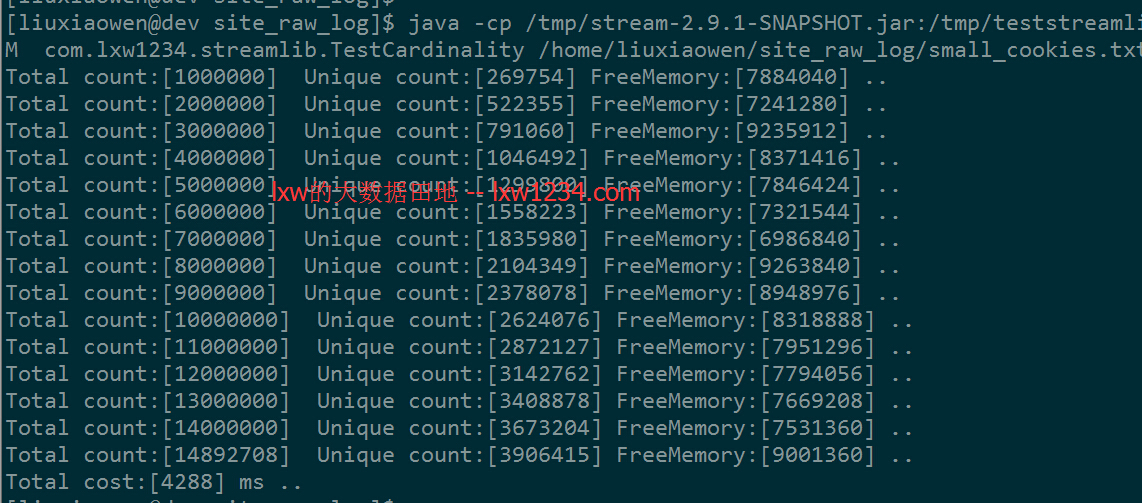

- 测试数据集1

指定使用10M的内存运行,测试数据集1命令为:

- java -cp /tmp/stream-2.9.1-SNAPSHOT.jar:/tmp/teststreamlib.jar -Xms10M -Xmx10M -XX:PermSize=10M -XX:MaxPermSize=10M \

- com.lxw1234.streamlib.TestCardinality /home/liuxiaowen/site_raw_log/small_cookies.txt

运行结果如下:

- 测试数据集2

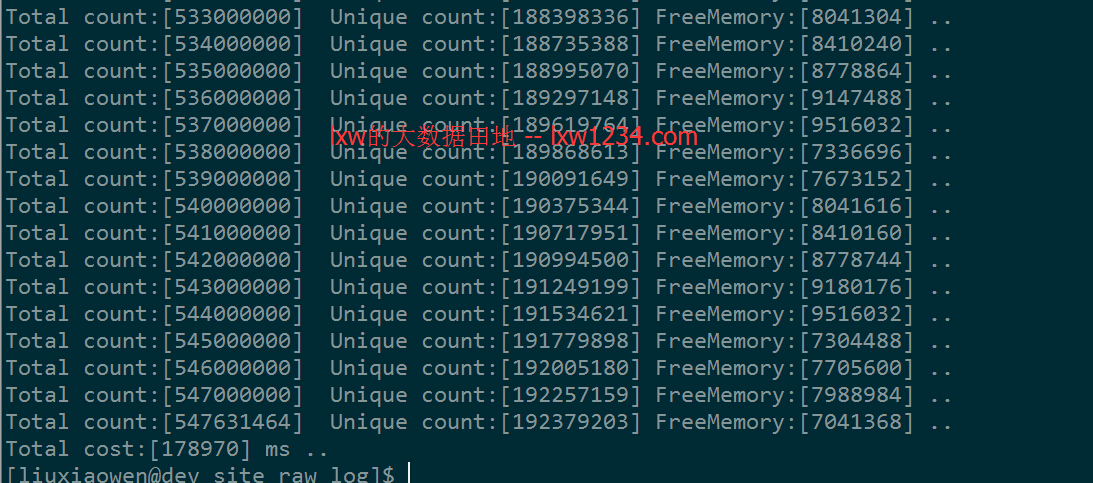

同样指定使用10M的内存运行,测试数据集2命令为:

- java -cp /tmp/stream-2.9.1-SNAPSHOT.jar:/tmp/teststreamlib.jar -Xms10M -Xmx10M -XX:PermSize=10M -XX:MaxPermSize=10M \

- com.lxw1234.streamlib.TestCardinality /home/liuxiaowen/site_raw_log/big_cookies.txt

运行结果为:

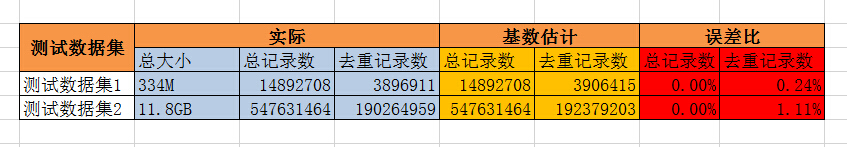

测试结果

测试结果来看,基数估计算法统计的结果中误差的确是0~2%,如果可以接受这个误差,那么这个方案完全可以用于实时计算中的不同维度UV统计中。

从运行结果图上可以看到,虽然指定了10M内存,但空闲内存(FreeMemory)一直在差不多7M以上,也就是说,5.4亿的数据去重计数,也仅仅使用了3M左右的内存。

相关下载

以上程序需要依赖stream-2.9.1-SNAPSHOT.jar,我编译好了一份,

你也可以从官网中下载源码,编译。

相关文章:

http://blog.csdn.net/hguisu/article/details/8433731

http://m.oschina.net/blog/315457

您可以关注 lxw的大数据田地 ,或者 加入邮件列表 ,随时接收博客更新的通知邮件。

如果觉得本博客对您有帮助,请 赞助作者 。

转载请注明:lxw的大数据田地 » Java使用极小的内存完成对超大数据的去重计数,用于实时计算中统计UV

Java使用极小的内存完成对超大数据的去重计数,用于实时计算中统计UV的更多相关文章

- JAVA虚拟机运行时内存划分--运行时数据区域

Java虚拟机在执行java程序时会把内存划分为以下几个不同的数据区域: java虚拟机内存划分(运行时)1.线程私有的: 程序计数器(Program Counter Register):可以看作当前 ...

- java接口对接——别人调用我们接口获取数据

java接口对接——别人调用我们接口获取数据,我们需要在我们系统中开发几个接口,给对方接口规范文档,包括访问我们的接口地址,以及入参名称和格式,还有我们的返回的状态的情况, 接口代码: package ...

- 如何计算Java对象所占内存的大小

[ 简单总结: 随便一个java项目,引入jar包: lucene-core-4.0.0.jar 如果是 maven项目,直接用如下依赖: <dependency> <groupId ...

- 深入理解Java虚拟机之JVM内存布局篇

内存布局**** JVM内存布局规定了Java在运行过程中内存申请.分配.管理的策略,保证了JVM的稳定高效运行.不同的JVM对于内存的划分方式和管理机制存在部分差异.结合JVM虚拟机规范,一起来 ...

- 死磕内存篇 --- JAVA进程和linux内存间的大小关系

运行个JAVA 用sleep去hold住 package org.hjb.test; public class TestOnly { public static void main(String[] ...

- Java内存区域-- 运行时数据区域

jvm在执行Java程序时,会把它所管理的内存划分为若干个不同的数据区.这些区域都有各自的用途,以及创建和销毁的时间. 有的区域随着虚拟机进程的启动而存在,有些区域则依赖用户线程的启动和结束而建立和销 ...

- JAVA基础知识点:内存、比较和Final

1.java是如何管理内存的 java的内存管理就是对象的分配和释放问题.(其中包括两部分) 分配:内存的分配是由程序完成的,程序员需要通过关键字new为每个对象申请内存空间(基本类型除外),所有的对 ...

- java\c程序的内存分配

JAVA 文件编译执行与虚拟机(JVM)介绍 Java 虚拟机(JVM)是可运行Java代码的假想计算机.只要根据JVM规格描述将解释器移植到特定的计算机上,就能保证经过编译的任何Java代码能够在该 ...

- [转]使用Java Mission Control进行内存分配分析

jdk7u40自带了一个非常好用的工具,就是Java Mission Control.JRockit Misson Control用户应该会对mission control的很多功能十分熟悉,JRoc ...

随机推荐

- 使用ffmpeg步骤

av_register_all();//初始化ffmpeg库,如果系统里面的ffmpeg没配置好这里会出错 if (isNetwork) { //需要播放网络视频 avforma ...

- nodejs基础 -- Stream流

nodejs 的 Stream 是一个抽象接口,node中有很多对象实现了这个接口.例如,对http服务器发起请求的request对象就是一个Stream,还有stdout(标准输出)也是一个Stre ...

- c++ list sort

1. bool operator < (S & b) { return ID < b.ID; } struct S { std::string firstn ...

- apache Storm学习之三-消息可靠性

4.1 简介 storm可以确保spout发送出来的每个消息都会被完整的处理.本章将会描述storm体系是如何达到这个目标的,并将会详述开发者应该如何使用storm的这些机制来实现数据的可靠处理. 4 ...

- AI逻辑实现-取舍行为树还是状态机

AI逻辑实现-选择行为树还是状态机? 关注AI的朋友可能会看过赖勇浩翻译的<有限状态机时代终结的10大理由> ,里面谈到了状态机的诸多弊端.同时在ppt(附上下载地址)中述说了行为树的诸多 ...

- Unity延迟和重复调用方法

延迟调用方法 Invoke(arg1,arg2) arg1 是延迟调用的字符串方法名,arg2是延迟多少时间调用arg1 方法. 重复调用方法 InvokeRepeating(arg1,arg2,ar ...

- 这款Office密码破解工具,无坚不摧!

你是否曾经陷入过这样的尴尬:因为忘记Word文档密码去找了一个Word密码破解工具,接着又忘记Excel文档密码去找了一个专门破击Excel的工具,那么如果忘记PowerPoint.Outlook.P ...

- Notepad++下载需要的插件(如何在Notepad++中手动下载需要的插件)

需求说明: 下载在实际工作中需要的Notepad++插件,或者是因为Notepadd++设置的原因导致不能直接在软件中显示插件. 即手动登录到指定的链接中进行插件的下载. 操作过程: 1.以xmlto ...

- mybatis由浅入深day01_4入门程序_4.6根据用户id(主键)查询用户信息

4 入门程序 4.1 需求 根据用户id(主键)查询用户信息 根据用户名称模糊查询用户信息 添加用户 删除 用户 更新用户 4.2 环境 java环境:jdk1.7.0_72 eclipse:indi ...

- 08python之列表的常用方法

列表list是python常用的数据类型,需要掌握以下常用方法: name_list = ['alex','tenglan','65brother'] 这个变量和之前的变量只存一个数字或字符串,这个列 ...