lucene源码分析(5)lucence-group

1. 普通查询的用法

org.apache.lucene.search.IndexSearcher

public void search(Query query, Collector results)

其中

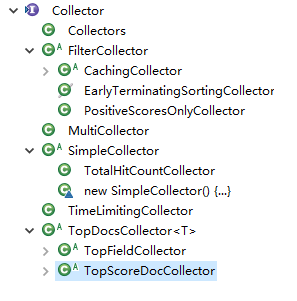

Collector定义

/**

* <p>Expert: Collectors are primarily meant to be used to

* gather raw results from a search, and implement sorting

* or custom result filtering, collation, etc. </p>

*

* <p>Lucene's core collectors are derived from {@link Collector}

* and {@link SimpleCollector}. Likely your application can

* use one of these classes, or subclass {@link TopDocsCollector},

* instead of implementing Collector directly:

*

* <ul>

*

* <li>{@link TopDocsCollector} is an abstract base class

* that assumes you will retrieve the top N docs,

* according to some criteria, after collection is

* done. </li>

*

* <li>{@link TopScoreDocCollector} is a concrete subclass

* {@link TopDocsCollector} and sorts according to score +

* docID. This is used internally by the {@link

* IndexSearcher} search methods that do not take an

* explicit {@link Sort}. It is likely the most frequently

* used collector.</li>

*

* <li>{@link TopFieldCollector} subclasses {@link

* TopDocsCollector} and sorts according to a specified

* {@link Sort} object (sort by field). This is used

* internally by the {@link IndexSearcher} search methods

* that take an explicit {@link Sort}.

*

* <li>{@link TimeLimitingCollector}, which wraps any other

* Collector and aborts the search if it's taken too much

* time.</li>

*

* <li>{@link PositiveScoresOnlyCollector} wraps any other

* Collector and prevents collection of hits whose score

* is <= 0.0</li>

*

* </ul>

*

* @lucene.experimental

*/

Collector的层次结构

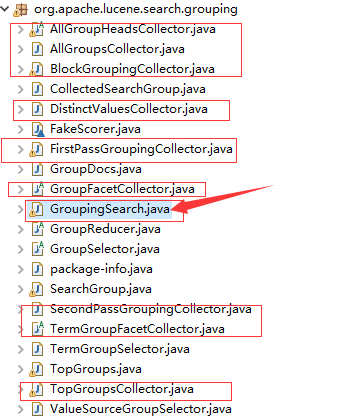

2 lucene-group

提供了分组查询GroupingSearch,对应相应的collector

3.实例:

public Map<String, Integer> groupBy(Query query, String field, int topCount) {

Map<String, Integer> map = new HashMap<String, Integer>();

long begin = System.currentTimeMillis();

int topNGroups = topCount;

int groupOffset = 0;

int maxDocsPerGroup = 100;

int withinGroupOffset = 0;

try {

FirstPassGroupingCollector c1 = new FirstPassGroupingCollector(field, Sort.RELEVANCE, topNGroups);

boolean cacheScores = true;

double maxCacheRAMMB = 4.0;

CachingCollector cachedCollector = CachingCollector.create(c1, cacheScores, maxCacheRAMMB);

indexSearcher.search(query, cachedCollector);

Collection<SearchGroup<String>> topGroups = c1.getTopGroups(groupOffset, true);

if (topGroups == null) {

return null;

}

SecondPassGroupingCollector c2 = new SecondPassGroupingCollector(field, topGroups, Sort.RELEVANCE, Sort.RELEVANCE, maxDocsPerGroup, true, true, true);

if (cachedCollector.isCached()) {

// Cache fit within maxCacheRAMMB, so we can replay it:

cachedCollector.replay(c2);

} else {

// Cache was too large; must re-execute query:

indexSearcher.search(query, c2);

}

TopGroups<String> tg = c2.getTopGroups(withinGroupOffset);

GroupDocs<String>[] gds = tg.groups;

for(GroupDocs<String> gd : gds) {

map.put(gd.groupValue, gd.totalHits);

}

} catch (IOException e) {

e.printStackTrace();

}

long end = System.currentTimeMillis();

System.out.println("group by time :" + (end - begin) + "ms");

return map;

}

几个参数说明:

groupField: 分组域groupSort: 分组排序topNGroups: 最大分组数groupOffset: 分组分页用withinGroupSort: 组内结果排序maxDocsPerGroup: 每个分组的最多结果数withinGroupOffset: 组内分页用

参考资料

https://blog.csdn.net/wyyl1/article/details/7388241

lucene源码分析(5)lucence-group的更多相关文章

- Lucene 源码分析之倒排索引(三)

上文找到了 collect(-) 方法,其形参就是匹配的文档 Id,根据代码上下文,其中 doc 是由 iterator.nextDoc() 获得的,那 DefaultBulkScorer.itera ...

- 一个lucene源码分析的博客

ITpub上的一个lucene源码分析的博客,写的比较全面:http://blog.itpub.net/28624388/cid-93356-list-1/

- lucene源码分析的一些资料

针对lucene6.1较新的分析:http://46aae4d1e2371e4aa769798941cef698.devproxy.yunshipei.com/conansonic/article/d ...

- Lucene 源码分析之倒排索引(一)

倒排索引是 Lucene 的核心数据结构,该系列文章将从源码层面(源码版本:Lucene-7.3.0)分析.该系列文章将以如下的思路展开. 什么是倒排索引? 如何定位 Lucene 中的倒排索引? 倒 ...

- lucene源码分析(1)基本要素

1.源码包 core: Lucene core library analyzers-common: Analyzers for indexing content in different langua ...

- Lucene 源码分析之倒排索引(二)

本文以及后面几篇文章将讲解如何定位 Lucene 中的倒排索引.内容很多,唯有静下心才能跟着思路遨游. 我们可以思考一下,哪个步骤与倒排索引有关,很容易想到检索文档一定是要查询倒排列表的,那么就从此处 ...

- lucene源码分析(8)MergeScheduler

1.使用IndexWriter.java mergeScheduler.merge(this, MergeTrigger.EXPLICIT, newMergesFound); 2.定义MergeSch ...

- lucene源码分析(7)Analyzer分析

1.Analyzer的使用 Analyzer使用在IndexWriter的构造方法 /** * Constructs a new IndexWriter per the settings given ...

- lucene源码分析(6)Query分析

查询的入口 /** Lower-level search API. * * <p>{@link LeafCollector#collect(int)} is called for ever ...

随机推荐

- Android Studio 集成 TFS,实现安卓移动开发的持续集成和交付(DevOps)

目录 1 集成TFS系统.... 1.1 概述.... 1.2 安装TFS插件.... 1.2.1 在线安装方式.... 1.2.2 离线安装方案.... 1.3 常见操作.... 1.3.1 新建G ...

- Asp.Net从相对路径获取绝对路径的方法(不需要httpcontext上下文也可)

//如果拿不到当前HttpContext上下文的话可以用该方法取得绝对路径 var filePath = HostingEnvironment.MapPath("需要获取绝对路径 的 相对路 ...

- 在sqlite中,如何删除字段? how to drop a column in sqlite

在sqlite中可以使用ALTER TABLE语法对表结构进行修改,从官方的文档说明中,语法如下图: 从图中可以看出,ALTER TABLE仅仅支持表名重命名,添加字段,却没有删除字段的方法.那么该如 ...

- 在Android中使用Protocol Buffers(上篇)

本文来自网易云社区. 总览 先来看一下 FlatBuffers 项目已经为我们提供了什么,而我们在将 FlatBuffers 用到我们的项目中时又需要做什么的整体流程.如下图: 在使用 FlatBuf ...

- MySQL(作业练习)

day59 参考:http://www.cnblogs.com/wupeiqi/p/5748496.html 现有数据库 /* Navicat Premium Data Transfer Source ...

- FunDA(15)- 示范:任务并行运算 - user task parallel execution

FunDA的并行运算施用就是对用户自定义函数的并行运算.原理上就是把一个输入流截分成多个输入流并行地输入到一个自定义函数的多个运行实例.这些函数运行实例同时在各自不同的线程里同步运算直至耗尽所有输入. ...

- QQ个人信息保护 | 攻的对面叫防

近来我们愈来愈重视个人信息保护,当接到骚扰电话时,你心里或许在想(我手机号怎么又被别人知道的?别人是怎么知道我手机号的?),现在的时代,手机已或不可缺,QQ几乎每个人都在用.而有些人总想保护个人QQ资 ...

- Xshell多版本被曝存在后门,了解紧急响应修复预案

近日,Xshell远程终端工具被爆出多个版本存在后门,无疑是安全圈的一个大新闻.恶意攻击者利用该后门可以收集到用户名密码等主机敏感信息,并将之传回攻击者的机器,导致服务器信息泄露,进一步可致使整个服务 ...

- Storm集群参数调整

Supervisor 参数调整 修改${STORM_HOME}conf/storm.yaml文件内容 supervisor变更参数 slots 配置: 若storm host仅仅执行superviso ...

- 00-python概述。

人生苦短,我用Python. -发展历史: - 1989年,由Guido van Rossum开始开发, - 1991年,发布第一个公开发行版,第一个Python编译器(同时也是解释器)诞生. - 2 ...