Spark通过修改DataFrame的schema给表字段添加注释(转载)

转载自:https://www.jianshu.com/p/e4c90dc08935

1、需求背景

通过Spark将关系型数据库(以Oracle为例)的表同步的Hive表,要求用Spark建表,有字段注释的也要加上注释。Spark建表,有两种方法:

- 用Spark Sql,在程序里组建表语句,然后用Spark.sql("建表语句")建表,这种方法麻烦的地方在于你要读取Oracle表的详细的表结构信息,且要进行Oracle和Hive的字段类型进行一一对应

- 用DataFrame 的saveAsTable方法,这种方法如果对应的数据库里没有表,则Spark会根据DataFrame的schema自动建表,比较简单,不用考虑字段类型匹配转化问题,但是这种方法有一个问题,Spark读取Oracle的表为DataFrame时,并不能将表字段的注释读进来,所以就有了如标题所示的需求。(一开始以为DataFrame不能加注释,经过研究,发现是可以的!)

2、如何查看DataFrame是否有注释

前面讲到DataFrame里没有Oracle的注释信息,但是如果数据源为Hive的话,是可以将注释获取到的。

2.1 新建Hive测试表(带注释)

create table `test` (

`id` string comment 'ID',

`Name` string comment '名字'

)

comment '测试';

2.2 Spark读取hive表并打印注释(在spark-shell里执行)

首先看一下df.printSchema里并没有注释信息

sql("use test")

val df = spark.table("test")

df.printSchema

root

|-- id: string (nullable = true)

|-- name: string (nullable = true)

用下面这行代码便可以打印注释信息:

df.schema.foreach(s=>println(s.name,s.metadata))

(id,{"comment":"ID","HIVE_TYPE_STRING":"string"})

(name,{"comment":"名字","HIVE_TYPE_STRING":"string"})

3、读取Oracle表并打印DataFrmae的元数据信息

3.1 新建Oracle测试表(带注释)

CREATE TABLE ORA_TEST (

ID VARCHAR2(),

NAME VARCHAR2()

);

COMMENT ON COLUMN ORA_TEST.ID IS 'ID';

COMMENT ON COLUMN ORA_TEST.NAME IS '名字';

COMMENT ON TABLE ORA_TEST IS '测试';

- 注:上面的注释语句和建表语句需要分开执行,或者也可以在数据库工具执行脚本,比如我用的DBeaver用快捷键Alt+x即可。当然也可以在工具的界面直接建表均可。

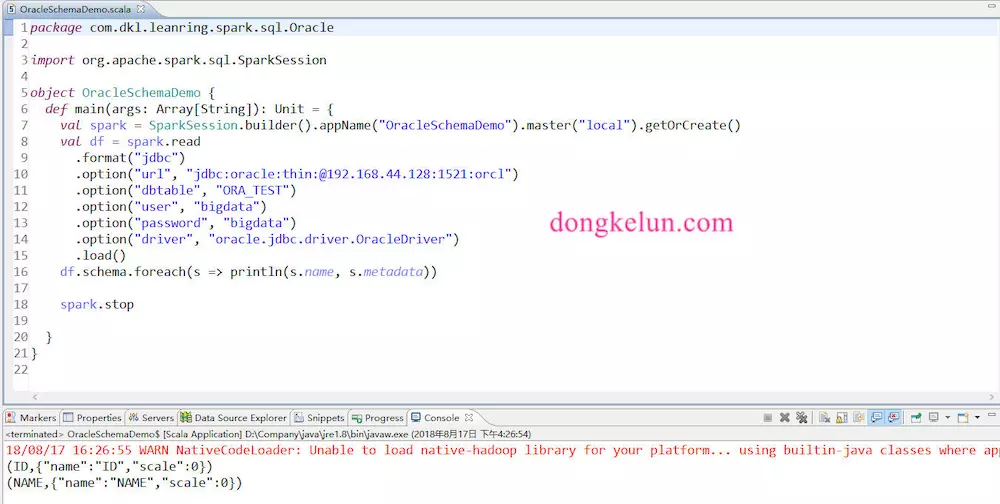

3.2 读取Oracle表,并打印元数据

代码:

package com.dkl.leanring.spark.sql.Oracle

import org.apache.spark.sql.SparkSession

object OracleSchemaDemo {

def main(args: Array[String]): Unit = {

val spark = SparkSession.builder().appName("OracleSchemaDemo").master("local").getOrCreate()

val df = spark.read

.format("jdbc")

.option("url", "jdbc:oracle:thin:@192.168.44.128:1521:orcl")

.option("dbtable", "ORA_TEST")

.option("user", "bigdata")

.option("password", "bigdata")

.option("driver", "oracle.jdbc.driver.OracleDriver")

.load()

df.schema.foreach(s => println(s.name, s.metadata))

spark.stop

}

}

(ID,{"name":"ID","scale":})

(NAME,{"name":"NAME","scale":})

注:Spark2.3.0和Spark2.2.1的元数据不太一样,上面的结果是Spark2.2.1(也是我写博客测试用的),项目中用的Spark2.3.0,2.3.0的元数据是空的,如下

(ID,{})

(NAME,{})

可见并没有注释信息

3.3 给DataFrame添加注释

import org.apache.spark.sql.types._

val commentMap = Map("ID" -> "ID", "NAME" -> "名字") val schema = df.schema.map(s => {

s.withComment(commentMap(s.name))

}) //根据添加了注释的schema,新建DataFrame

val new_df = spark.createDataFrame(df.rdd, StructType(schema)).repartition() new_df.schema.foreach(s => println(s.name, s.metadata))

(ID,{"comment":"ID","name":"ID","scale":})

(NAME,{"comment":"名字","name":"NAME","scale":})

4、 测试写到Hive表有没有注释

需将前面代码中的spark改为支持hive,即加上enableHiveSupport()

spark.sql("use test")

new_df.write.mode("overwrite").saveAsTable("ORA_TEST")

然后在hive里看一下,是否有注释

可以看到,成功的把注释也保存到里hive里

5、附录

附上在Eclipse运行的完整代码

package com.dkl.leanring.spark.sql.Oracle import org.apache.spark.sql.SparkSession

import org.apache.spark.sql.types._ object OracleSchemaDemo {

def main(args: Array[String]): Unit = {

val spark = SparkSession.builder().appName("OracleSchemaDemo").master("local").enableHiveSupport().getOrCreate()

val df = spark.read

.format("jdbc")

.option("url", "jdbc:oracle:thin:@192.168.44.128:1521:orcl")

.option("dbtable", "ORA_TEST")

.option("user", "bigdata")

.option("password", "bigdata")

.option("driver", "oracle.jdbc.driver.OracleDriver")

.load()

df.schema.foreach(s => println(s.name, s.metadata)) val commentMap = Map("ID" -> "ID", "NAME" -> "名字") val schema = df.schema.map(s => {

s.withComment(commentMap(s.name))

}) //根据添加了注释的schema,新建DataFrame

val new_df = spark.createDataFrame(df.rdd, StructType(schema)).repartition() new_df.schema.foreach(s => println(s.name, s.metadata)) spark.sql("use test")

//保存到hive

new_df.write.mode("overwrite").saveAsTable("ORA_TEST") spark.stop }

}

Spark通过修改DataFrame的schema给表字段添加注释(转载)的更多相关文章

- mysql 数据库 表字段添加表情兼容

项目中的几个需要支持Emoji表情符号,手机自带的表情,其实添加也很简单: 1 修改数据库 配置my.cnf init-connect='SET NAMES utf8mb4' ...

- oracle 表字段添加 修改 删除语法

修改列名 alter table 表明 rename column rename 老列名 to 新列名添加 字段alter table 表名 add(字段名 类型):删除字段alter table 表 ...

- PowerDesigner15.1给自定义架构表字段添加MS_Description出错

原因:系统函数sp_addextendedproperty 的第3个参数(用户名) 应该是Schema.但PD在生成的时候却是’user’ 解决方法 在PDM时.DataBase >> E ...

- Maven插件mybatis-generator,如何让生成的PO类的field上有对应表字段的注释

前言 去年刚入职的时候,我就发现,po类(和数据库表对应的类)上,一片都是光秃秃的,什么注释都没有,类上没注释,field上也没注释. 在以前的项目中,其实我们都是有生成注释的,比如,对于下面这个表: ...

- @MySQL为表字段添加索引

删除索引~ DROP INDEX `idx_dict_type` ON `article` 1.添加PRIMARY KEY(主键索引): ALTER TABLE `table_name` ADD PR ...

- Mysql如何为表字段添加索引???

1.添加PRIMARY KEY(主键索引): ALTER TABLE `table_name` ADD PRIMARY KEY ( `column` ) 2.添加UNIQUE(唯一索引) : ALTE ...

- Mysql优化-为表字段添加索引

1.添加PRIMARY KEY(主键索引): ALTER TABLE `table_name` ADD PRIMARY KEY ( `column` ) 2.添加UNIQUE(唯一索引) : ALTE ...

- ORACLE修改表字段顺序

1.若'GYZL_BZPWL_TB' 为要修改的表名,注意表名一定要大写!此句可以获取表的id.select object_id from all_objects where object_name= ...

- oracle查看表名称和表字段注释

--查询该表字段的注释select * from user_col_comments where Table_Name like '%SMS%' --查询类似表select * from user_t ...

随机推荐

- 使用globalData函数设置全局变量

在app.js中设置需要的全局变量的参数,比如公司名称等 //app.js App({ globalData: { title: 'tomatocc' } }) 然后就可以在某个页面的js文件中(比如 ...

- gsoup webservice

SoapUI调用webservice实现的两种方式 gsoup https://blog.csdn.net/zhuzhihai1988/article/details/8131370

- 基于h5+的微信分享,hbuilder打包

1.打开app项目的manifest.json的文件,选择模块权限配置,将Share(分享)模块添加至已选模块中 2.选择SDK配置,在plus.share·分享中,勾选□ 微信消息及朋友圈,配置好a ...

- cocoapods安装错误的原因

gem 可以理解为管理RUBY库和程序包的查找,安装,升级和卸载是个非常好用的工具. gem install cocoapods过程中出现错误的问题.1.gem的源设置错误应该参照,下面来执行gem ...

- Windows异常处理机制简介

windows系统里,为了保证系统内核的强壮和稳定,为了保证用户程序的强壮和稳定,提供了异常处理机制,来帮助程序员和系统使用人员处理异常.简单来说,当CPU执行代码时,发生异常,会把异常告知操作系统, ...

- 洛谷P1019 单词接龙题解(超详细注释)

https://www.luogu.org/problem/P1019 #include<cstdio> #include<cstring> #include<iostr ...

- XOR Clique(按位异或)

XOR Clique(按位异或): 传送门:http://acm.zju.edu.cn/onlinejudge/showProblem.do?problemCode=4057 准备:异或:参加运算的两 ...

- 通过 frp 实现群晖的 drive 远端同步

通过 frp 实现 drive 同步 其实其他的也类似, 只是指定 tcp 的端口不一致就可以. frp 实现的外网端口映射"肥肠"方便. 也推广下 frp 的地址 frp-git ...

- beego 前后端分离登录验证

conf>app.conf 文件添加一下参数 copyrequestbody=true sessionon =true routers>router.go 文件添加初始化路由 func i ...

- 项目发布到tomcat后,通过项目名称访问报404

查看tomcat发布地址发现和项目名称不一致 如果直接拷贝项目,可能也需要修改此选项 解决方案: 经过排查发现了原因: 首先说明一下项目 Maven+SSM 需要使用到 maven tomcat 7 ...