增强学习--Q-leraning

import numpy as np

import random

from environment import Env

from collections import defaultdict class QLearningAgent:

def __init__(self, actions):

# actions = [0, 1, 2, 3]

self.actions = actions

self.learning_rate = 0.01

self.discount_factor = 0.9

self.epsilon = 0.1

self.q_table = defaultdict(lambda: [0.0, 0.0, 0.0, 0.0])#待更新q表 # update q function with sample <s, a, r, s'>

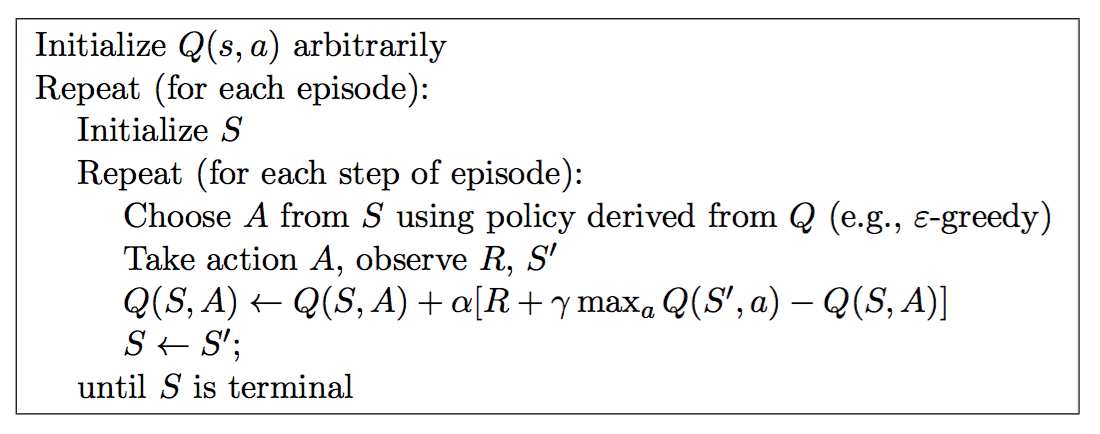

def learn(self, state, action, reward, next_state):

current_q = self.q_table[state][action]

# using Bellman Optimality Equation to update q function

new_q = reward + self.discount_factor * max(self.q_table[next_state])

self.q_table[state][action] += self.learning_rate * (new_q - current_q)#更新公式,off-policy # get action for the state according to the q function table

# agent pick action of epsilon-greedy policy

def get_action(self, state):

#epsilon-greedy policy

if np.random.rand() < self.epsilon:

# take random action

action = np.random.choice(self.actions)

else:

# take action according to the q function table

state_action = self.q_table[state]

action = self.arg_max(state_action)

return action @staticmethod

def arg_max(state_action):

max_index_list = []

max_value = state_action[0]

for index, value in enumerate(state_action):

if value > max_value:

max_index_list.clear()

max_value = value

max_index_list.append(index)

elif value == max_value:

max_index_list.append(index)

return random.choice(max_index_list) if __name__ == "__main__":

env = Env()

agent = QLearningAgent(actions=list(range(env.n_actions))) for episode in range(1000):

state = env.reset() while True:

env.render() # take action and proceed one step in the environment

action = agent.get_action(str(state))

next_state, reward, done = env.step(action) # with sample <s,a,r,s'>, agent learns new q function

agent.learn(str(state), action, reward, str(next_state)) state = next_state

env.print_value_all(agent.q_table) # if episode ends, then break

if done:

break

增强学习--Q-leraning的更多相关文章

- 马里奥AI实现方式探索 ——神经网络+增强学习

[TOC] 马里奥AI实现方式探索 --神经网络+增强学习 儿时我们都曾有过一个经典游戏的体验,就是马里奥(顶蘑菇^v^),这次里约奥运会闭幕式,日本作为2020年东京奥运会的东道主,安倍最后也已经典 ...

- 增强学习(三)----- MDP的动态规划解法

上一篇我们已经说到了,增强学习的目的就是求解马尔可夫决策过程(MDP)的最优策略,使其在任意初始状态下,都能获得最大的Vπ值.(本文不考虑非马尔可夫环境和不完全可观测马尔可夫决策过程(POMDP)中的 ...

- 增强学习(四) ----- 蒙特卡罗方法(Monte Carlo Methods)

1. 蒙特卡罗方法的基本思想 蒙特卡罗方法又叫统计模拟方法,它使用随机数(或伪随机数)来解决计算的问题,是一类重要的数值计算方法.该方法的名字来源于世界著名的赌城蒙特卡罗,而蒙特卡罗方法正是以概率为基 ...

- 增强学习(Reinforcement Learning and Control)

增强学习(Reinforcement Learning and Control) [pdf版本]增强学习.pdf 在之前的讨论中,我们总是给定一个样本x,然后给或者不给label y.之后对样本进行 ...

- 增强学习 | Q-Learning

"价值不是由一次成功决定的,而是在长期的进取中体现" 上文介绍了描述能力更强的多臂赌博机模型,即通过多台机器的方式对环境变量建模,选择动作策略时考虑时序累积奖赏的影响.虽然多臂赌博 ...

- 常用增强学习实验环境 II (ViZDoom, Roboschool, TensorFlow Agents, ELF, Coach等) (转载)

原文链接:http://blog.csdn.net/jinzhuojun/article/details/78508203 前段时间Nature上发表的升级版Alpha Go - AlphaGo Ze ...

- 增强学习训练AI玩游戏

1.游戏简介 符号A为 AI Agent. 符号@为金币,AI Agent需要尽可能的接取. 符号* 为炸弹,AI Agent需要尽可能的躲避. 游戏下方一组数字含义如下: Bomb hit: 代表目 ...

- 【读书笔记】2_增强学习中的Q-Learning

本文为Thomas Simonini增强学习系列文章笔记或读后感,原文可以直接跳转到medium系列文章. 主要概念为: Q-Learning,探讨其概念以及用Numpy实现 我们可以将二维游戏想象成 ...

- 转:增强学习(二)----- 马尔可夫决策过程MDP

1. 马尔可夫模型的几类子模型 大家应该还记得马尔科夫链(Markov Chain),了解机器学习的也都知道隐马尔可夫模型(Hidden Markov Model,HMM).它们具有的一个共同性质就是 ...

- Multi-armed Bandit Problem与增强学习的联系

选自<Reinforcement Learning: An Introduction>, version 2, 2016, Chapter2 https://webdocs.cs.ualb ...

随机推荐

- HDU1174(空间点到直线的距离,用叉积)

爆头 Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Others)Total Submissi ...

- 解决小米/红米手机无法进行jdwp调试的问题

问题描述:在逆向一个app,研究环境是一台红米2,需要使用jdwp接口,也就是ddms下面这个界面: 但神奇的是,同一台主机上,模拟器的进程可以显示在ddms界面上,红米2确一个进程都没有显示出来.c ...

- win7中下载和安装redis

下载地址:https://github.com/MicrosoftArchive/redis/releases 这里我下载的是3.2.100版本,下载zip,然后解压.解压后如图所示: 开启redis ...

- JAVA中“==”和equals

A."=="可用于基本类型和引用类型: 当用于基本类型时候,是比较值是否相同:1==2: false: 当用于引用类型的时候,是比较是否指向同一个对象. B.基本类型int.c ...

- 使用Python获取计算机名,ip地址,mac地址等等

获取计算机名 # 获取计算机名,常用的方法有三种 import os import socket # method one name = socket.gethostname() print(name ...

- SPOJ - AMR11H

Array Diversity Time Limit: 404MS Memory Limit: 1572864KB 64bit IO Format: %lld & %llu Submi ...

- selenium 常用浏览器操作API

package test; import org.openqa.selenium.By;import org.openqa.selenium.Dimension;import org.openqa.s ...

- docker从零开始 存储(六)存储驱动如何选择

Docker存储驱动程序 理想情况下,将非常少的数据写入容器的可写层,并使用Docker卷来写入数据.但是,某些工作负载要求您能够写入容器的可写层.这是存储驱动程序的用武之地. Docker使用可插拔 ...

- xshell连接虚拟机CentOS出现eth0 device not found的解决方法

昨天用xshell连接虚拟机上的centOS老是连接不上,ifconfig eth0 命令显示 device not found.不知道是什么原因... 折腾了好久 网上是各种搜啊 终于找到解决方法了 ...

- hdu 1227(动态规划)

Fast Food Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/32768 K (Java/Others)Total S ...