java批量读取多个文件并存入数据库

背景:有时候服务运行的日志文件,需要统计分析,但数据量很大,并且直接在文件中看很不直观,这时可以将文件中的内容导入到数据库,入库后的数据就可以按照需求进行统计分析了。

这个是以服务器的访问日志作为示例,一个日志文件中一行的数据格式如下(文件夹中有多个日志文件):

[/Aug/::: +] ******* - "-" "GET https://****/****/image57.png" HIT "******" "image/png"

下面就是具体的读取文件,然后插入到数据库的过程,代码如图:

package com.mobile.web.api; import com.mobile.commons.JsonResp;

import com.mobile.model.LogInfo;

import com.mobile.service.LogInfoService;

import org.apache.commons.lang3.StringUtils;

import org.apache.log4j.Logger;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.transaction.annotation.Transactional;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RequestMethod;

import org.springframework.web.bind.annotation.RestController; import java.io.*;

import java.text.ParseException;

import java.text.SimpleDateFormat;

import java.util.ArrayList;

import java.util.Date;

import java.util.List;

import java.util.Locale; @RestController

@RequestMapping(value = "/test")

@Transactional

public class ImportController {

Logger log = Logger.getLogger(this.getClass()); @Autowired

private LogInfoService logInfoService; @RequestMapping(value = "/importTxt", method = RequestMethod.GET)

public JsonResp importTxt() throws IOException, ParseException {

log.debug("开始导入数据"); String encoding = "GBK";

List logInfoList = new ArrayList();

String dir = "E:\\test\\log";

File[] files = new File(dir).listFiles();

for (File file : files){ //循环文件夹中的文件

if (file.isFile() && file.exists()) { //判断文件是否存在

importFile(file, encoding, logInfoList); //将文件中的数据读取出来,并存放进集合中

} else {

return JsonResp.toFail("文件不存在,请检查文件位置!");

}

} Boolean insertFlag = logInfoService.insertBatch(logInfoList); //将集合中的数据批量入库

if (!insertFlag) {

return JsonResp.toFail("保存失败");

}

return JsonResp.ok();

} /** 读取数据,存入集合中 */

public static void importFile(File file, String encoding, List logInfoList) throws IOException, ParseException {

InputStreamReader read = null;//考虑到编码格式

try {

read = new InputStreamReader(

new FileInputStream(file), encoding); //输入流

} catch (UnsupportedEncodingException e) {

e.printStackTrace();

} catch (FileNotFoundException e) {

e.printStackTrace();

}

BufferedReader bufferedReader = new BufferedReader(read);

String lineTxt = null;

SimpleDateFormat sdf = new SimpleDateFormat("[dd/MMM/yyyy:HH:mm:ss Z]", Locale.US); //时间格式化,此处有坑,下边会说到

while ((lineTxt = bufferedReader.readLine()) != null) { //读取文件内容

String[] lineArr = lineTxt.split(" ");

int len = lineArr.length;

LogInfo logInfo = new LogInfo(); //封装实体对象做入库准备

String logDate = lineArr[] + " " + lineArr[];

System.out.println(sdf.parse(logDate)); //.............时间转换问题

logInfo.setLog1(sdf.parse(logDate));

logInfo.setLog2(lineArr[]);

logInfo.setLog3(lineArr[]);

logInfo.setLog4(lineArr[]);

logInfo.setLog5(lineArr[].substring(, lineArr[].length() - ));

logInfo.setLog6(lineArr[].substring());

logInfo.setLog8(lineArr[].substring(, lineArr[].length() - ));

String accessUrl = lineArr[];

String[] accessUrlArr = accessUrl.split("/");

logInfo.setItemName(accessUrlArr[]);

logInfo.setLog9(lineArr[]);

logInfo.setLog10(lineArr[]);

logInfo.setLog11(lineArr[]);

logInfo.setLog12(lineArr[]);

String[] uaHead = new String[len - ];

System.arraycopy(lineArr, , uaHead, , len - );//数组拷贝,a表示源数组,b表示源数组要复制的起始位置,c表示目标数组,d表示目标数组起始位置,e表示要复制的长度。

logInfo.setLog13(StringUtils.join(uaHead));

logInfo.setFileType(lineArr[len - ]); logInfoList.add(logInfo);

}

read.close(); //输入流关闭 } }

文件导入,成功;

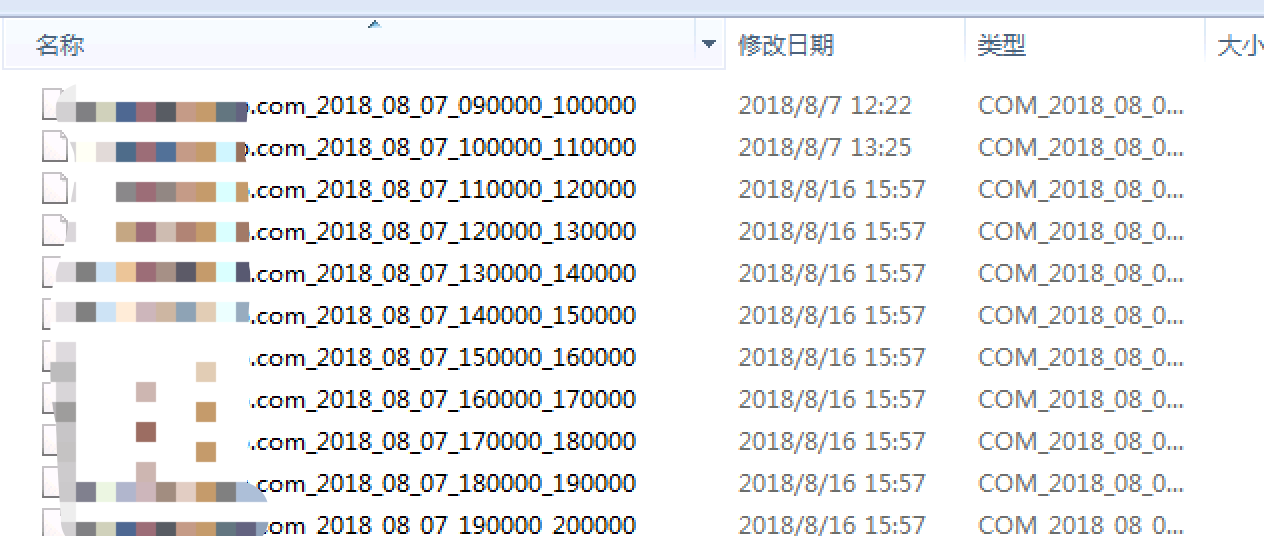

log文件夹下的结构如下图:

时间转换时的坑:

SimpleDateFormat sdf = new SimpleDateFormat("[dd/MMM/yyyy:HH:mm:ss Z]", Locale.US);

字符串转时间时:英文简写为英文格式,而转换时JRE会按照当前地区的语言格式,所以转换失败

解决方法:带上Locale.US参数

详细解决可参考:https://www.cnblogs.com/mufengforward/p/9480102.html

此时,如果数据量特别大时,会出现入库慢的情况,有另一种方法是:读取文件后,将数据按照想要的格式存如新文件中,然后用sql语句(或navicat客户端)导入文件;

java批量读取多个文件并存入数据库的更多相关文章

- Spark1.6.2 java实现读取json数据文件插入MySql数据库

public class Main implements Serializable { /** * */ private static final long serialVersionUID = -8 ...

- 使用JAVA API读取HDFS的文件数据出现乱码的解决方案

使用JAVA api读取HDFS文件乱码踩坑 想写一个读取HFDS上的部分文件数据做预览的接口,根据网上的博客实现后,发现有时读取信息会出现乱码,例如读取一个csv时,字符串之间被逗号分割 英文字符串 ...

- Java项目读取resources资源文件路径那点事

今天在Java程序中读取resources资源下的文件,由于对Java结构了解不透彻,遇到很多坑.正常在Java工程中读取某路径下的文件时,可以采用绝对路径和相对路径,绝对路径没什么好说的,相对路径, ...

- java使用stream流批量读取并合并文件,避免File相关类导致单文件过大造成的内存溢出。

import java.io.BufferedReader; import java.io.File; import java.io.FileInputStream; import java.io.F ...

- java读取本地txt文件并插入数据库

package com.cniia.ny.web.control.configManage; import java.io.BufferedReader; import java.io.File; i ...

- Java中读取properties资源文件

一.通过ResourceBundle来读取.properties文件 /** * 通过java.util.resourceBundle来解析properties文件. * @param String ...

- stream流批量读取并合并文件

import java.io.BufferedReader; import java.io.File; import java.io.FileInputStream; import java.io.F ...

- Java 批量反编译class文件,并保持目录结构

jad -o -r -d d:\src -s java C:\Users\spring\Desktop\egorder3.0\WEB-INF\classes\**\*.class -o - overw ...

- java nio读取和写入文件

读取 package com.test; import java.io.File; import java.io.FileInputStream; import java.io.FileOutputS ...

随机推荐

- Java语法基础动手动脑

仔细阅读示例:EnumTest.Java,运行它,分析运行结果? 你能得到什么结论?你掌握了枚举类型的基本用法了吗? EnumTest.java public class EnumTest { pub ...

- python递归和二分法

一.递归 1.递归就是自己调用自己 def fn(n): print(n) fn(n+1) fn(1) #递归深度官方1000 一般都递归到998 2.树形结构的遍历 import os def fn ...

- 牛客训练三:处女座和小姐姐(三)(数位dp)

题目链接:传送门 思路:数位dp的记忆化搜索模板 从高位向低位枚举,逐位确定每一位的6的个数,dp[i][s]表示处理到第i条边,状态为s时的数字的个数. 注意,要使用long long类型. #in ...

- MySql Cast与Convert函数

两者具体的语法如下: Cast(value as type): Convert(value ,type): type不是都可以滴,可以转换的type如下: 二进制,同带binary前缀的效果 : BI ...

- Andrew机器学习第一课

批梯度下降算法: 训练样本为一个时:更新Θi 让代价函数最小,利用沿梯度下降方向函数会变得越来越小.这个函数是代价函数J关于(Θi )的.这里并没有在讨论x,y. 关于为什么式子(图是复制的 ...

- BZOJ 1024 [SCOI2009]生日快乐 (搜索)

1024: [SCOI2009]生日快乐 Time Limit: 1 Sec Memory Limit: 162 MBSubmit: 3025 Solved: 2201[Submit][Statu ...

- call和apply的作用实例

<script> var scopeTest = function(){ //考察了 this 的含义 window.a=2; function fn(b){ this.b = b; co ...

- 时间控件My97简单用法

my97的用法很是简单,项目中用到,查了资料才找到的,简单使用,记一下,方便查阅. 1.添加依赖. <script language="javascript" type=&q ...

- ubuntu16.04 编译安卓4.2

1. root@ge-Lenovo:/usr/lib/jvm# cd /home/material/install/jdk/ jdk-6u29-linux-x64.bin jdk-6u45-l ...

- 容器,表格 ,div,元素可左右拖动,滚动 css

<!DOCTYPE html> <html lang="en"> <head> <meta charset="utf-8&quo ...