sklearn的GridSearchCV例子

class sklearn.model_selection.GridSearchCV(estimator, param_grid, scoring=None, fit_params=None, n_jobs=1, iid=True, refit=True, cv=None, verbose=0, pre_dispatch='2*n_jobs', error_score='raise', return_train_score=True)

1.estimator:

传入估计器与不需要调参的参数,每一个估计器都需要一个scoring参数。

2.param_grid:

需要最优化的参数的取值,值为字典或者列表。

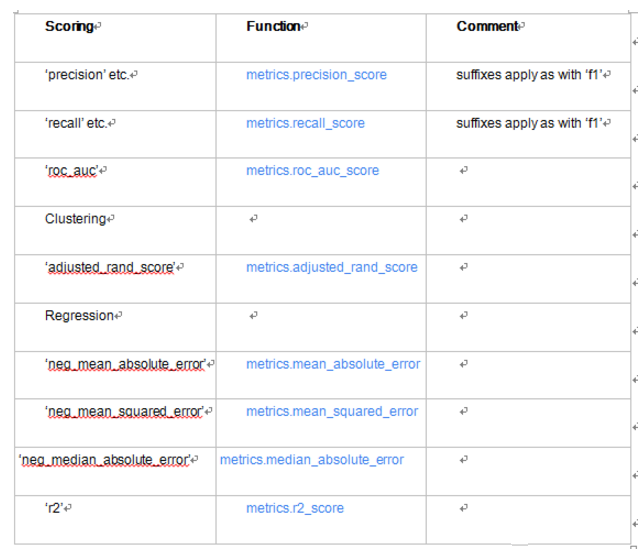

3.scoring:

模型评价标准,默认None,这时需要使用score函数,根据所选模型不同,评价准则不同。字符串或者自定义形如:scorer(estimator, X, y);如果是None,则使用estimator的误差估计函数。

4.n_jobs

n_jobs: 并行数,int:个数,-1:跟CPU核数一致。

5.refit=True

默认为True,程序将会以交叉验证训练集得到的最佳参数,重新对所有可用的训练集与开发集进行,作为最终用于性能评估的最佳模型参数。即在搜索参数结束后,用最佳参数结果再次fit一遍全部数据集。

6.pre_dispatch=‘2*n_jobs’

指定总共分发的并行任务数。当n_jobs大于1时,数据将在每个运行点进行复制,这可能导致OOM,而设置pre_dispatch参数,则可以预先划分总共的job数量,使数据最多被复制pre_dispatch次。

from sklearn.datasets import load_iris

import pandas as pd

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import GridSearchCV

from sklearn.metrics import classification_report X,y = load_iris(return_X_y=True)

df_X = pd.DataFrame(X,columns=list("ABCD")) #gridSearchCV

parameters = [{'n_estimators':[10,100,1000],

'criterion':['entropy','gini'],

'max_depth':[10,50,100,200],

'min_samples_split':[2,5,10],

'min_weight_fraction_leaf':[0.0,0.1,0.2,0.3,0.4,0.5]}] parameters = [{'n_estimators':[10,20]}] #scoring="precision"或者"recall"或者"roc_auc","accuracy"或者None clf = GridSearchCV(RandomForestClassifier(), parameters,cv=2,scoring="accuracy")

clf.fit(df_X,y) clf.cv_results_

# =============================================================================

# {'mean_fit_time': array([0.0089916 , 0.01695275]),

# 'mean_score_time': array([0.00099409, 0.00148273]),

# 'mean_test_score': array([0.94666667, 0.96 ]),

# 'mean_train_score': array([0.98666667, 1. ]),

# 'param_n_estimators': masked_array(data=[10, 20],

# mask=[False, False],

# fill_value='?',

# dtype=object),

# 'params': [{'n_estimators': 10}, {'n_estimators': 20}],

# 'rank_test_score': array([2, 1]),

# 'split0_test_score': array([0.96, 0.96]),

# 'split0_train_score': array([1., 1.]),

# 'split1_test_score': array([0.93333333, 0.96 ]),

# 'split1_train_score': array([0.97333333, 1. ]),

# 'std_fit_time': array([1.01363659e-03, 9.53674316e-07]),

# 'std_score_time': array([4.17232513e-06, 5.05685806e-04]),

# 'std_test_score': array([0.01333333, 0. ]),

# 'std_train_score': array([0.01333333, 0. ])}

# =============================================================================

clf.best_estimator_

# =============================================================================

# RandomForestClassifier(bootstrap=True, class_weight=None, criterion='gini',

# max_depth=None, max_features='auto', max_leaf_nodes=None,

# min_impurity_decrease=0.0, min_impurity_split=None,

# min_samples_leaf=1, min_samples_split=2,

# min_weight_fraction_leaf=0.0, n_estimators=20, n_jobs=1,

# oob_score=False, random_state=None, verbose=0,

# warm_start=False)

# ============================================================================= clf.best_score_

# =============================================================================

# Out[42]: 0.96

#

# ============================================================================= clf.best_params_ # =============================================================================

# Out[43]: {'n_estimators': 20}

#

# =============================================================================

clf.grid_scores_ # =============================================================================

# [mean: 0.94667, std: 0.01333, params: {'n_estimators': 10},

# mean: 0.96000, std: 0.00000, params: {'n_estimators': 20}]

# =============================================================================

参考:http://blog.51cto.com/emily18/2088128

sklearn的GridSearchCV例子的更多相关文章

- sklearn参数优化方法

学习器模型中一般有两个参数:一类参数可以从数据中学习估计得到,还有一类参数无法从数据中估计,只能靠人的经验进行指定,后一类参数就叫超参数 比如,支持向量机里的C,Kernel,gama,朴素贝叶斯里的 ...

- 《转》sklearn参数优化方法

sklearn参数优化方法 http://www.cnblogs.com/nolonely/p/7007961.html 学习器模型中一般有两个参数:一类参数可以从数据中学习估计得到,还有一类参 ...

- GridSearchCV 与 RandomizedSearchCV 调参

GridSearchCV GridSearchCV的名字其实可以拆分为两部分,GridSearch和CV,即网格搜索和交叉验证. 这两个概念都比较好理解,网格搜索,搜索的是参数,即在指定的参数范 ...

- sklearn参数优化

学习器模型中一般有两个参数:一类参数可以从数据中学习估计得到,还有一类参数无法从数据中估计,只能靠人的经验进行指定,后一类参数就叫超参数 比如,支持向量机里的C,Kernel,gama,朴素贝叶斯里的 ...

- 机器学习之sklearn——SVM

sklearn包对于SVM可输出支持向量,以及其系数和数目: print '支持向量的数目: ', clf.n_support_ print '支持向量的系数: ', clf.dual_coef_ p ...

- 使用sklearn优雅地进行数据挖掘【转】

目录 1 使用sklearn进行数据挖掘 1.1 数据挖掘的步骤 1.2 数据初貌 1.3 关键技术2 并行处理 2.1 整体并行处理 2.2 部分并行处理3 流水线处理4 自动化调参5 持久化6 回 ...

- 使用sklearn优雅地进行数据挖掘

目录 1 使用sklearn进行数据挖掘 1.1 数据挖掘的步骤 1.2 数据初貌 1.3 关键技术2 并行处理 2.1 整体并行处理 2.2 部分并行处理3 流水线处理4 自动化调参5 持久化6 回 ...

- 【转】使用sklearn优雅地进行数据挖掘

这里是原文 目录 使用sklearn进行数据挖掘 1.1 数据挖掘的步骤 1.2 数据初貌 1.3 关键技术并行处理 并行处理 2.1 整体并行处理 2.2 部分并行处理流水线处理自动化调参持久化回顾 ...

- 转载:使用sklearn进行数据挖掘

目录 1 使用sklearn进行数据挖掘 1.1 数据挖掘的步骤 1.2 数据初貌 1.3 关键技术2 并行处理 2.1 整体并行处理 2.2 部分并行处理3 流水线处理4 自动化调参5 持久化6 回 ...

随机推荐

- websevice之三要素

SOAP(Simple Object Access Protocol).WSDL(WebServicesDescriptionLanguage).UDDI(UniversalDescriptionDi ...

- vs2010将写好的软件打包安装包经验

(1) 用VS2010打开已经编写好准备做安装包的软件程序,右击解决方案,添加新建项目. (2) 在“新建项目”对话框中,选择“其他项目类型”,再选择“安装和部署”,然后在模板中选择“安装项目” (3 ...

- vue2.0分页组件,

pagination.vue <!-- 表格分页组件 --> <template> <nav class="boot-nav"> <ul ...

- 怎样取消老毛桃软件赞助商---只需在输入框中输入老毛桃官网网址“laomaotao.org”

来源:www.laomaotao.org 时间:2015-01-29 在众多网友和赞助商的支持下,迄今为止,老毛桃u盘启动盘制作工具已经推出了多个版本.如果有用户希望取消显示老毛桃软件中的赞助商,那不 ...

- POJ 3617:Best Cow Line(贪心,字典序)

Best Cow Line Time Limit: 1000MS Memory Limit: 65536K Total Submissions: 30684 Accepted: 8185 De ...

- 我的第一个Mybatis程序

第一个Mybatis程序 在JDBC小结中(可以参阅本人JDBC系列文章),介绍到了ORM,其中Mybatis就是一个不错的ORM框架 MyBatis由iBatis演化而来 iBATIS一词来源于“i ...

- setTimeout设置为0的作用

调用方式:iTimerID = window.setTimeout(vCode, iMilliSeconds [, sLanguage])功能:Evaluates an expression afte ...

- Mysql_connect报告”No such file or directory”错误的解决方法

写了个php脚本单独执行mysql_connect(),发现错误信息居然是“No such file or directory"! 首先确定是mysql_connect()和mysql_pc ...

- V4L2控制驱动

1.应用如何知道设备支持那些特性的控制?一种典型的做法,V4L2 API提供了一种机制可以让应用能枚举可用的控制操作.为此,他们要发出最终由驱动videoc_queryctrl()方法实现的ioctl ...

- subzero 基于postgrest && openresty && rabbitmq 的快速rest/graphql 开发平台

subzero是在postgrest 基础上开发的,提供了graphql 的支持,同时开发的cli 工具也很方便 集成了rabbitmq 可以让我们的应用具体实时的特性 参考架构图 使用 最简单的使用 ...