TensorFlow Activation Function 1

部分转自:https://blog.csdn.net/caicaiatnbu/article/details/72745156

激活函数(Activation Function)运行时激活神经网络中某一部分神经元,将激活信息向后传入下一层的神经网络。

神经网络的数学基础是处处可微的,所以选取激活函数要保证数据输入与输出也是可微的。TensorFlow中提供哪些激活函数的API。

激活函数不会改变数据的维度,也就是输入和输出的维度是相同的。TensorFlow中有如下激活函数:

tf.nn.relu()

tf.nn.sigmoid()

tf.nn.tanh()

tf.nn.elu()

tf.nn.bias_add()

tf.nn.crelu()

tf.nn.relu6()

tf.nn.softplus()

tf.nn.softsign()

tf.nn.dropout()#防止过拟合,用来舍弃某些神经元包括平滑的非线性的激活函数,如sigmoid、tanh、elu、softplus、softsign,也包括连续但不是处处可微的函数relu、relu6、crelu、relu_x,以及随机正则化函数dropout。

上述激活函数的输入均为要计算的x(一个张量),输出均为x数据类型相同的张量。常见的激活函数有sigmoid、tanh、relu、softplus这4种。

1. sigmoid 函数

- {\displaystyle S(x)={\frac {1}{1+e^{-x}}}.}

- 优点:它输出映射在(0,1)内,单调连续,非常适合用作输出层,并且求导比较容易;

- 缺点:具有软饱和性,一旦输入落入饱和区,一阶导数就变得接近于0,很容易产生梯度消失。

- 饱和性:当|x|>c时,其中c为某常数,此时一阶导数等于0,通俗的说一阶导数就是上图中的斜率,函数越来越水平。

2. tanh函数

tanh也是传统神经网络中比较常用的激活函数,公式和函数图像如下:

tanh函数也具有软饱和性。因为它的输出是以0为中心,收敛速度比sigmoid函数要快。但是仍然无法解决梯度消失问题。

3. relu 函数

4. softplus 函数

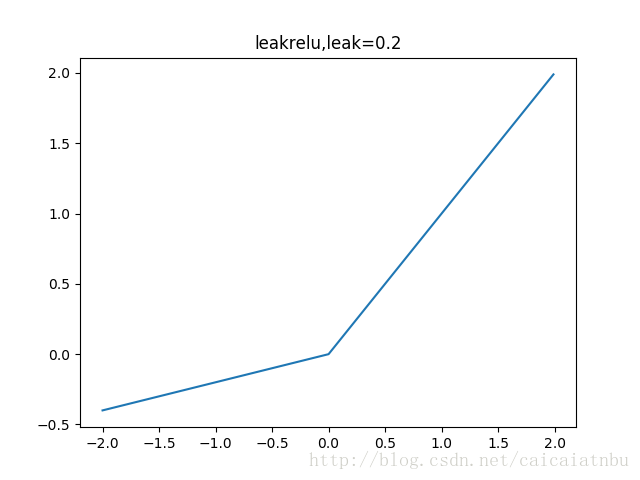

5. leakrelu 函数

6. ELU 函数

7. SELU 函数

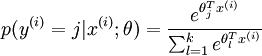

8. tf.nn.softmax 函数:n分类

关于softmax的详细说明,请看Softmax。

通过Softmax回归,将logistic的预测二分类的概率的问题推广到了n分类的概率的问题。通过公式

可以看出当月分类的个数变为2时,Softmax回归又退化为logistic回归问题。

下面的几行代码说明一下用法

# -*- coding: utf-8 -*-

import tensorflow as tf A = [1.0,2.0,3.0,4.0,5.0,6.0] with tf.Session() as sess:

print sess.run(tf.nn.softmax(A))

结果

[ 0.00426978 0.01160646 0.03154963 0.08576079 0.23312201 0.63369131]

参考:

李嘉璇 著 TensorFlow技术解析与实战

黄文坚 唐源 著 TensorFlow实战郑泽宇

顾思宇 著 TensorFlow实战Google深度学习框架

乐毅 王斌 著 深度学习-Caffe之经典模型详解与实战

TensorFlow中文社区 http://www.tensorfly.cn/

极客学院 著 TensorFlow官方文档中文版

TensorFlow官方文档英文版

TensorFlow Activation Function 1的更多相关文章

- TensorFlow实战第一课(session、Variable、Placeholder、Activation Function)

莫烦tensorflow教学 1.session会话控制 Tensorflow 中的Session, Session是 Tensorflow 为了控制,和输出文件的执行的语句. 运行session.r ...

- ML 激励函数 Activation Function (整理)

本文为内容整理,原文请看url链接,感谢几位博主知识来源 一.什么是激励函数 激励函数一般用于神经网络的层与层之间,上一层的输出通过激励函数的转换之后输入到下一层中.神经网络模型是非线性的,如果没有使 ...

- 浅谈深度学习中的激活函数 - The Activation Function in Deep Learning

原文地址:http://www.cnblogs.com/rgvb178/p/6055213.html版权声明:本文为博主原创文章,未经博主允许不得转载. 激活函数的作用 首先,激活函数不是真的要去激活 ...

- The Activation Function in Deep Learning 浅谈深度学习中的激活函数

原文地址:http://www.cnblogs.com/rgvb178/p/6055213.html 版权声明:本文为博主原创文章,未经博主允许不得转载. 激活函数的作用 首先,激活函数不是真的要去激 ...

- caffe中的sgd,与激活函数(activation function)

caffe中activation function的形式,直接决定了其训练速度以及SGD的求解. 在caffe中,不同的activation function对应的sgd的方式是不同的,因此,在配置文 ...

- 转载-聊一聊深度学习的activation function

目录 1. 背景 2. 深度学习中常见的激活函数 2.1 Sigmoid函数 2.2 tanh函数 2.3 ReLU函数 2.4 Leaky ReLu函数 2.5 ELU(Exponential Li ...

- 激活函数:Swish: a Self-Gated Activation Function

今天看到google brain 关于激活函数在2017年提出了一个新的Swish 激活函数. 叫swish,地址:https://arxiv.org/abs/1710.05941v1 pytorch ...

- 《Noisy Activation Function》噪声激活函数(一)

本系列文章由 @yhl_leo 出品,转载请注明出处. 文章链接: http://blog.csdn.net/yhl_leo/article/details/51736830 Noisy Activa ...

- MXNet 定义新激活函数(Custom new activation function)

https://blog.csdn.net/weixin_34260991/article/details/87106463 这里使用比较简单的定义方式,只是在原有的激活函数调用中加入. 准备工作下载 ...

随机推荐

- 关于shader的学习

教程地址:https://onevcat.com/2013/07/shader-tutorial-1 因为想做一些特效,所以想稍微了解一下shader的代码,一下是一些笔记 // Upgrade NO ...

- SSH下shiro的基本使用

1.引入依赖 <!-- 权限控制 框架 --> <dependency> <groupId>org.apache.shiro</groupId> ...

- 分布式理论基础(一)一致性及解决一致性的两种方式:2PC和3PC (转载 不错)

分布式理论基础(一)一致性及解决一致性的两种方式:2PC和3PC 1 一致性 1.1 简述 一致性,是指对每个节点一个数据的更新,整个集群都知道更新,并且是一致的 假设一个具有N个节点的分布式系统,当 ...

- “使用IDEA,配置文件是yml,无法获取[环境变量],值是null”的问题处理

为了便于隐藏用户名和密码,我们有时会用到“环境变量”. Spring Boot提供了很好的机制,可以在配置文件中,如application.yml书写以下格式,然后在代码中@Value就可以获取“环境 ...

- MySQL的异步复制、全同步复制与半同步复制

异步复制 异步复制,主库将事务 Binlog 事件写入到 Binlog 文件中,此时主库只会通知一下 Dump 线程发送这些新的 Binlog,然后主库就会继续处理提交操作,而此时不会保证这些 Bin ...

- Jquery全选系列操作(锋利的jQuery)

Jquery全选系列操作(锋利的jQuery) <!DOCTYPE html> <html xmlns="http://www.w3.org/1999/xhtml" ...

- jQuery筛选结果等于true的筛选

一般来说,使用jQuery筛选器的筛选结果都是数组,可以用length>0来判断是否筛选到:但是有一些筛选结果是布尔值,需要注意: 1.hasClass 2.is

- Chrome浏览器取消INPUT自动记忆下拉框

项目中有一个搜索框,每次聚焦就会出现如下图自动记忆框,遮挡了项目的搜索列表 差了很多资料想要去掉它,最后发现在input上加上autocomplete="off"就可以了!

- android中的textview显示汉字不能自动换行的一个解决办法

<TableLayout xmlns:android="http://schemas.android.com/apk/res/android" android:layout_ ...

- Pig parallel reduce并行执行数

parallel语句可以附加到Pig Latin中任一个关系操作符后面,然后它会控制reduce阶段的并行,因此只有对与可以触发reduce过程的操作符才有意义. 可以触发reduce过程的操 ...