logstash日志采集工具的安装部署

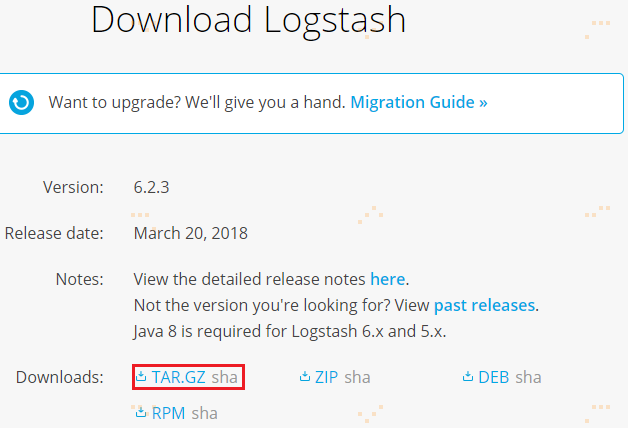

1.从官网下载安装包,并通过Xftp5上传到机器集群上

下载logstash-6.2.3.tar.gz版本,并通过Xftp5上传到hadoop机器集群的第一个节点node1上的/opt/uploads/目录:

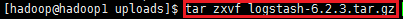

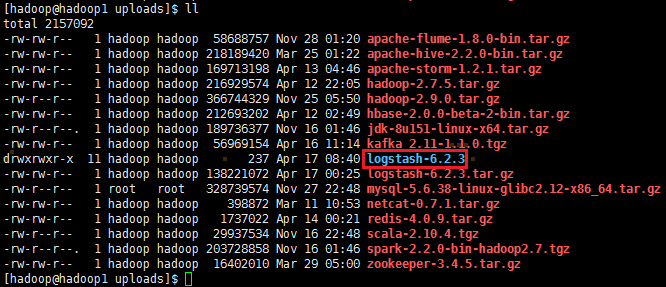

2、解压logstash-6.2.3.tar.gz,并把解压的安装包移动到/opt/app/目录上

tar zxvf logstash-6.2.3.tar.gz

mv logstash-6.2.3 /opt/app/ && cd /opt/app/

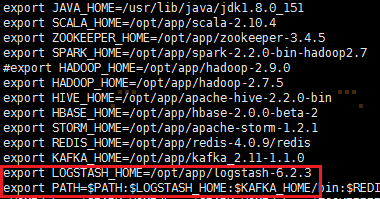

3、修改环境变量,编辑/etc/profile,并生效环境变量,输入如下命令:

sudo vi /etc/profile

添加如下内容:

export LOGSTASH_HOME=/opt/app/logstash-6.2.3

export PATH=:$PATH:$LOGSTASH_HOME/bin

使环境变量生效:source /etc/profile

4、配置文件类型

4.1 log-kafka配置文件

输入源为nginx的日志文件,输出源为kafka

input {

file {

path => "/var/logs/nginx/*.log"

discover_interval => 5

start_position => "beginning"

}

}

output {

kafka {

topic_id => "accesslog"

codec => plain {

format => "%{message}"

charset => "UTF-8"

}

bootstrap_servers => "hadoop1:9092,hadoop2:9092,hadoop3:9092"

}

}

4.2 file-kafka配置文件

输入源为txt文件,输出源为kafka

input {

file {

codec => plain {

charset => "GB2312"

}

path => "D:/GameLog/BaseDir/*/*.txt"

discover_interval => 30

start_position => "beginning"

}

}

output {

kafka {

topic_id => "gamelog"

codec => plain {

format => "%{message}"

charset => "GB2312"

}

bootstrap_servers => "hadoop1:9092,hadoop2:9092,hadoop3:9092"

}

}

4.3 log-elasticsearch配置文件

输入源为nginx的日志文件,输出源为elasticsearch

input {

file {

type => "flow"

path => "var/logs/nginx/*.log"

discover_interval => 5

start_position => "beginning"

}

}

output {

if [type] == "flow" {

elasticsearch {

index => "flow-%{+YYYY.MM.dd}"

hosts => ["hadoop1:9200", "hadoop2:9200", "hadoop3:9200"]

}

}

}

4.4 kafka-elasticsearch配置文件

输入源为kafka的accesslog和gamelog主题,并在中间分别针对accesslog和gamelog进行过滤,输出源为elasticsearch。当input里面有多个kafka输入源时,client_id => "es*"必须添加且需要不同,否则会报错javax.management.InstanceAlreadyExistsException: kafka.consumer:type=app-info,id=logstash-0。

input {

kafka {

type => "accesslog"

codec => "plain"

auto_offset_reset => "earliest"

client_id => "es1"

group_id => "es1"

topics => ["accesslog"]

bootstrap_servers => "hadoop1:9092,hadoop2:9092,hadoop3:9092"

}

kafka {

type => "gamelog"

codec => "plain"

auto_offset_reset => "earliest"

client_id => "es2"

group_id => "es2"

topics => ["gamelog"]

bootstrap_servers => "hadoop1:9092,hadoop2:9092,hadoop3:9092"

}

}

filter {

if [type] == "accesslog" {

json {

source => "message"

remove_field => ["message"]

target => "access"

}

}

if [type] == "gamelog" {

mutate {

split => { "message" => " " }

add_field => {

"event_type" => "%{message[3]}"

"current_map" => "%{message[4]}"

"current_x" => "%{message[5]}"

"current_y" => "%{message[6]}"

"user" => "%{message[7]}"

"item" => "%{message[8]}"

"item_id" => "%{message[9]}"

"current_time" => "%{message[12]}"

}

remove_field => ["message"]

}

}

}

output {

if [type] == "accesslog" {

elasticsearch {

index => "accesslog"

codec => "json"

hosts => ["hadoop1:9200","hadoop2:9200","hadoop3:9200"]

}

}

if [type] == "gamelog" {

elasticsearch {

index => "gamelog"

codec => plain {

charset => "UTF-16BE"

}

hosts => ["hadoop1:9200","hadoop2:9200","hadoop3:9200"]

}

}

}

注:UTF-16BE为解决中文乱码,而不是UTF-8

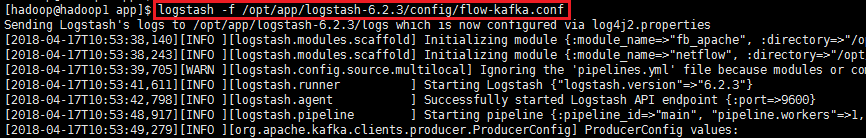

5、logstash启动

logstash -f /opt/app/logstash-6.2.3/conf/flow-kafka.conf

6、logstash遇到的问题

1) 在使用logstash采集日志时,如果我们采用file为input类型,采用不能反复对一份文件进行测试!第一次会成功,之后就会失败!

参考资料:

https://blog.csdn.net/lvyuan1234/article/details/78653324

logstash日志采集工具的安装部署的更多相关文章

- 日志采集客户端 filebeat 安装部署

linux----------------1. 下载wget https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-5.5.1- ...

- filebeat + logstash 日志采集链路配置

1. 概述 一个完整的采集链路的流程如下: 所以要进行采集链路的部署需要以下几个步聚: nginx的配置 filebeat部署 logstash部署 kafka部署 kudu部署 下面将详细说明各个部 ...

- Hadoop生态圈-flume日志收集工具完全分布式部署

Hadoop生态圈-flume日志收集工具完全分布式部署 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 目前为止,Hadoop的一个主流应用就是对于大规模web日志的分析和处理 ...

- docker可视化集中管理工具shipyard安装部署

docker可视化集中管理工具shipyard安装部署 Shipyard是在Docker Swarm实现对容器.镜像.docker集群.仓库.节点进行管理的web系统. 1.Shipyard功能 Sh ...

- 大数据应用日志采集之Scribe 安装配置指南

大数据应用日志采集之Scribe 安装配置指南 大数据应用日志采集之Scribe 安装配置指南 1.概述 Scribe是Facebook开源的日志收集系统,在Facebook内部已经得到大量的应用.它 ...

- flume 日志采集工具

Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集.聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据:同时,Flume提供对数据进行简单处理,并 ...

- 运维工具Ansible安装部署

http://blog.51cto.com/liqingbiao/1875921 centos7安装部署ansible https://www.cnblogs.com/bky185392793/p/7 ...

- 日志采集工具Flume的安装与使用方法

安装Flume,参考厦门大学林子雨教程:http://dblab.xmu.edu.cn/blog/1102/ 并完成案例1 1.案例1:Avro source Avro可以发送一个给定的文件给Flum ...

- Filebeat轻量级日志采集工具

Beats 平台集合了多种单一用途数据采集器.这些采集器安装后可用作轻量型代理,从成百上千或成千上万台机器向 Logstash 或 Elasticsearch 发送数据. 一.架构图 此次试验基于前几 ...

随机推荐

- wstngfw IKEv2服务器配置示例

wstngfw IKEv2服务器配置示例 移动客户端的服务器配置有几个组件: 为***创建一个证书结构 配置IPsec移动客户端设置 为客户端连接创建阶段1和阶段2 添加IPsec防火墙规则 创建** ...

- kubernetes 基础命令及操作

获取集群的基本信息kubectl cluster-infokubectl get nodeskubectl get namespaceskubectl get deployment --all-nam ...

- PHP安装-phpMyAdmin+Discuz

PHP安装-phpMyAdmin+Discuz基于Apache和MySQL安装完成之后继续安装PHP.以构建LAMP动态网站平台.http:./configure --prefix=/usr/loca ...

- [NOI2014]购票(斜率优化+线段树)

题目描述 今年夏天,NOI在SZ市迎来了她30周岁的生日.来自全国 n 个城市的OIer们都会从各地出发,到SZ市参加这次盛会. 全国的城市构成了一棵以SZ市为根的有根树,每个城市与它的父亲用道路连接 ...

- [ZJOI2016]小星星&[SHOI2016]黑暗前的幻想乡(容斥)

这两道题思路比较像,所以把他们放到一块. [ZJOI2016]小星星 题目描述 小Y是一个心灵手巧的女孩子,她喜欢手工制作一些小饰品.她有n颗小星星,用m条彩色的细线串了起来,每条细线连着两颗小星星. ...

- 用python批量向数据库(MySQL)中导入数据

用python批量向数据库(MySQL)中导入数据 现有数十万条数据,如下的经过打乱处理过的数据进行导入 数据库内部的表格的数据格式如下与下面的表格结构相同 Current database: pyt ...

- BZOJ 1042: [HAOI2008]硬币购物 (详解)(背包&容斥原理)

题面:https://www.cnblogs.com/fu3638/p/6759919.html 硬币购物一共有4种硬币.面值分别为c1,c2,c3,c4.某人去商店买东西,去了tot次.每次带di枚 ...

- Linux下VMware在更新完内核无法启动

该问题尚未解决,我已经换Oracle VM VirtualBox

- 【SPOJ10707】COT2 - Count on a tree II

题目大意:给定一棵 N 个节点的无根树,每个节点有一个颜色.现有 M 个询问,每次询问一条树链上的不同颜色数. 题解:学会了树上莫队. 树上莫队是将节点按照欧拉序进行排序,将树上问题转化成序列上的问题 ...

- git的使用命令

git archive --format zip --output "./test.zip" master -0 将项目的代码通过上述命令打包压缩为test文件夹 ssh-keyg ...