python 斗图图片爬虫

捣鼓了三小时,有一些小Bug,望大佬指导

废话不说,直接上代码:

#!/usr/bin/python3

# -*- coding:UTF-8 -*-

import os,re,requests

from urllib import request,parse class Doutu_api(object):

def __init__(self):

self.api_html = r'http://www.doutula.com/search?keyword=%s'

self.headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 '

'(KHTML, like Gecko) Chrome/66.0.3359.181 Safari/537.36'}

self.path = os.path.dirname(os.path.realpath(__file__))+'\\temp' def make_path(self,path=''):#返回假为已创建,否则创建新文件夹

self.path = self.path+'\\'+path

if os.path.exists(self.path): # 判断文件夹是否存在

return False

else:

os.mkdir(self.path) # 创建文件夹

return True def get_img_html(self,html):

self.make_path(path=html)

html = self.api_html%parse.quote(html)

pattern = re.compile(u'<a.*?class="col-xs-6 col-md-2".*?href="(.*?)".*?style="padding:5px;">.*?</a>',re.S)

pattern_img = re.compile(u'<td>.*?<img.*?src="(.*?)".*?alt="(.*?)".*?onerror=".*?">.*?</td>',re.S)

try:

req = request.Request(html, headers=self.headers)

imgs = request.urlopen(req)

imgs = imgs.read().decode('utf-8')

imgs = re.findall(pattern, imgs)

for img in imgs:

req = request.Request(img, headers=self.headers)

imgurl = request.urlopen(req).read().decode('utf-8')

imgurl =re.findall(pattern_img, imgurl)

with open(self.path+'\\{}.png'.format(imgurl[0][1].replace('/','-')), 'wb') as file:

response = requests.get(imgurl[0][0]).content # 下载图片

file.write(response) # 读取图片

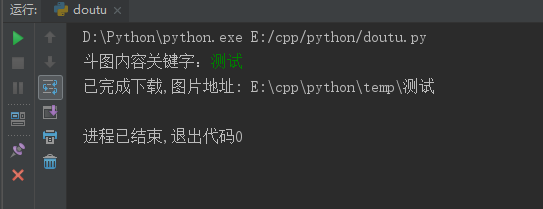

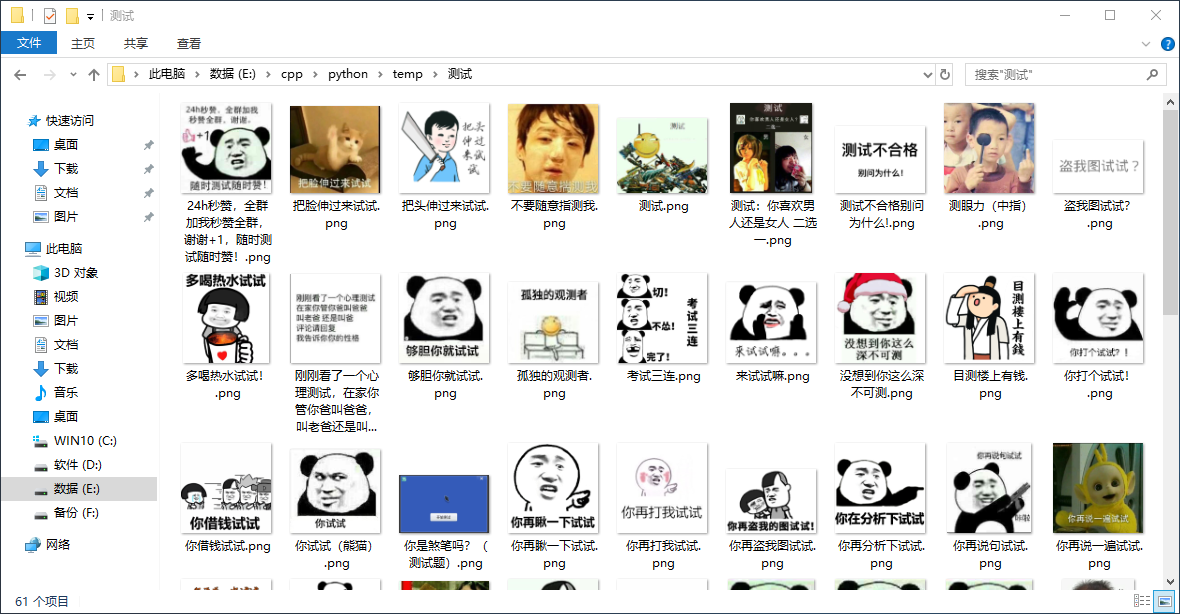

print('已完成下载,图片地址:',self.path)

except Exception as e:

print(e)

return None doutu = Doutu_api()

doutu.get_img_html(input('斗图内容关键字:'))

测试成功

python 斗图图片爬虫的更多相关文章

- py3+requests+urllib+bs4+threading,爬取斗图图片

实现原理及思路请参考我的另外几篇爬虫实践博客 py3+urllib+bs4+反爬,20+行代码教你爬取豆瓣妹子图:http://www.cnblogs.com/UncleYong/p/6892688. ...

- python+tkinter+动画图片+爬虫(查询天气)的GUI图形界面设计

1.完整代码: import time import urllib.request #发送网络请求,获取数据 import gzip #压缩和解压缩模块 import json #解析获得的数据 fr ...

- 【Python】:简单爬虫作业

使用Python编写的图片爬虫作业: #coding=utf-8 import urllib import re def getPage(url): #urllib.urlopen(url[, dat ...

- python多线程爬虫+批量下载斗图啦图片项目(关注、持续更新)

python多线程爬虫项目() 爬取目标:斗图啦(起始url:http://www.doutula.com/photo/list/?page=1) 爬取内容:斗图啦全网图片 使用工具:requests ...

- python爬虫我是斗图之王

python爬虫我是斗图之王 本文会以斗图啦网站为例,爬取所有表情包. 阅读之前需要对线程池.连接池.正则表达式稍作了解. 分析网站 页面url分析 打开斗图啦网站,简单翻阅之后发现最新表情每页包含的 ...

- Python爬虫入门教程 13-100 斗图啦表情包多线程爬取

斗图啦表情包多线程爬取-写在前面 今天在CSDN博客,发现好多人写爬虫都在爬取一个叫做斗图啦的网站,里面很多表情包,然后瞅了瞅,各种实现方式都有,今天我给你实现一个多线程版本的.关键技术点 aioht ...

- 【Python爬虫实战】 图片爬虫-淘宝图片爬虫--千图网图片爬虫

所谓图片爬虫,就是从互联网中自动把对方服务器上的图片爬下来的爬虫程序.有些图片是直接在html文件里面,有些是隐藏在JS文件中,在html文件中只需要我们分析源码就能得到如果是隐藏在JS文件中,那么就 ...

- python 爬虫系列09-异步斗图来一波

斗图斗图,妈妈再也不怕我都不赢了 import requests from lxml import etree from urllib import request import os import ...

- python多线程爬取斗图啦数据

python多线程爬取斗图啦网的表情数据 使用到的技术点 requests请求库 re 正则表达式 pyquery解析库,python实现的jquery threading 线程 queue 队列 ' ...

随机推荐

- IDEA/Eclipse安装 Alibaba Java Coding Guidelines 插件

为了让开发者更加方便.并且达到快速规范代码格式的目的并实行起来,阿里巴巴基于<阿里巴巴Java开发规约>手册内容,研发了一套自动化的IDE检测插件(IDEA.Eclipse).它就是Ali ...

- 2019年我的nodejs项目选型

选型项目比较激进.发现基于 go 语言的工具变多了.

- hibernate课程 初探单表映射1-3 hibernate简介

1 hibernate定义: Java领域一项开源的orm框架技术: hibernate对jdbc进行轻量级的封装. hibernate 作为持久层存在.就是通过对象关系映射把项目中的对象持久化到数据 ...

- ngnix反向代理

https://blog.csdn.net/sherry_chan/article/details/79055211

- Caused by: java.lang.NoSuchMethodError: org.objectweb.asm.ClassWriter.<init>(I)V

项目中各种缺包现象... Caused by: java.lang.NoSuchMethodError: org.objectweb.asm.ClassWriter.<init>(I)V ...

- 条件注解@Conditional

通过活动的profile,可以获得不同的Bean.Spring4提供了一个更通用的基于条件的Bean的创建,即使用@Conditonal注解 @Conditional根据满足某一个特定条件创建一个特定 ...

- python之__init__使用方法

定义类的时候,若是添加__init__方法,那么在创建类的实例的时候,实例会自动调用这个方法,一般用来对实例的属性进行初使化.比如:class testClass: def __init__(self ...

- 新版graylog2安装过程

Graylog是一个开源的 log 收容器,背后的储存是搭配 mongodb,而搜寻引擎则由 elasticsearch 提供.以前版本主要有两个部分集合而成 server 与 web interfa ...

- tomcat 启动显示指定的服务未安装

解决方法: 命令行进入tomcat的bin目录 输入“service.bat install” 重启,OK

- 【51nod1299】监狱逃离(树形DP)

点此看题面 大致题意: 在一棵树中有\(N\)条边连接\(N+1\)个节点,现在已知这棵树上的\(M\)个节点,要求封住最少的节点,使这\(M\)个节点中的任意一个节点无法到达叶子节点,若能办到输出最 ...