开始学习tensorflow

搭建神经网络:

- 准备数据

- 定义数据输入层

- 定义网络隐藏层和预测层

- 定义loss 表达式

- 选择optimizer使得loss 最小

import tensorflow as tf

import numpy as np # 定义一个添加层的函数为网络构建做准备

# 默认情况下没有激活函数,input 是神经元输入, in_size 输入神经元的个数,out_size输出的个数。

def add_layer(inputs, in_size,out_size,activation_function=None):

weights=tf.Variable(tf.random_normal([in_size,out_size]))

# 定义权重是变量,在tensorflow中定义是一个变量才是变量

biase=tf.Variable(tf.zeros([1,out_size])+0.1)

# 矩阵乘法

w_plus_b=tf.matmul(inputs,weights)+biase

# 定义运算

if activation_function is None:

outputs=w_plus_b

else:

outputs=activation_function(w_plus_b)

return outputs #1. 准备训练数据

x_data=np.linspace(-1,1,300)[:,np.newaxis]

# linspace 类似matlab 中的[-1:1:300],生成一个数组从-1 到300 每次加1,

# np.newaxis 等价于None,np.linspace 生成的是一个行向量,使用newaxis 增加一个维度大小为1 的新维度。x=[1,2,3],x.shape=3.,x[:,newaxis].shape=(3,1)在3后加一维

noise=np.random.normal(0,0.05,x_data.shape)

# 获得一个正态分布的值,和x_data大小相同, mu=0,v=0.05

y_data=np.square(x_data)-0.5+noise #2. 定义节点接受数据

# 要给节点输入数据时,要用placeholder 占位符,类似于函数的参数描述待输入的节点,在运行时传入,和feed_dict是绑定使用的。

xs=tf.placeholder(tf.float32,[None,1])

ys=tf.placeholder(tf.float32,[None,1]) #3.定义网络结构

l1=add_layer(xs,1,10,activation_function=tf.nn.relu)

prediction=add_layer(l1,10,1,activation_function=None) #4.定义loss

# reduce_sum 是求和,求和的对象时tensor,沿着tensor的某些维度求和。 本质是降维,reduce_sum 以求和的手段降维, reduce_mean 以求平均手段降维。 这种操作都有reduce_indices, 默认值为None,将tensor 降到0维 loss=tf.reduce_mean(tf.reduce_sum(tf.square(ys-prediction),reduction_indices=[1])) #5.选择optimizer

# 使用梯度下降的方法,学习率为0.1,最小化loss

train_step=tf.train.GradientDescentOptimizer(0.1).minimize(loss) #

# 初始化参数, 如果有变量一定要给变量初始化

init=tf.initialize_all_variables()

# 定义一个Session对象, 在session 中执行

sess=tf.Session()

sess.run(init) # 迭代1000次,在sess中run optimizer

for i in range(1000):

# train_step 中loss 是由 placeholder 定义的运算,要用feed 传入参数

sess.run(train_step,feed_dict={xs:x_data,ys:y_data})

if i%50==0:

print(sess.run(loss,feed_dict={xs:x_data,ys:y_data}))

reduce_sum:

在tensorflow 1.0 中,reduction_indices 改为axis,

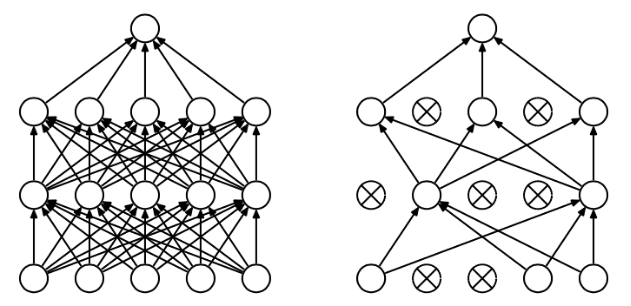

dropout 是训练过程中,按照一定概率将一部分神经单元暂时从网络中丢弃。

在tensorflow 中实现就是在add layer 函数中加上dropout,keep_prob保存多少不被drop

Wx_plus_b = tf.nn.dropout(Wx_plus_b, keep_prob)使用tensorboard: 要用with tf.name_scope 定义各个框架,

开始学习tensorflow的更多相关文章

- 学习TensorFlow,打印输出tensor的值

在学习TensorFlow的过程中,我们需要知道某个tensor的值是什么,这个很重要,尤其是在debug的时候.也许你会说,这个很容易啊,直接print就可以了.其实不然,print只能打印输出sh ...

- 学习TensorFlow,浅析MNIST的python代码

在github上,tensorflow的star是22798,caffe是10006,torch是4500,theano是3661.作为小码农的我,最近一直在学习tensorflow,主要使用pyth ...

- 学习TensorFlow,线性回归模型

学习TensorFlow,在MNIST数据集上建立softmax回归模型并测试 一.代码 <span style="font-size:18px;">from tens ...

- 学习Tensorflow的LSTM的RNN例子

学习Tensorflow的LSTM的RNN例子 基于TensorFlow一次简单的RNN实现 极客学院-递归神经网络 如何使用TensorFlow构建.训练和改进循环神经网络

- gcp上使用gpu来学习tensorflow

1080ti显卡实在是太贵了,8k一张的价格,让我感到无耐.还好,有gcp的gpu来训练,最有意思的是,他还提供300美元,让你挥霍. 1.当然是申请gcp的账号. 2.登录后,左侧->&quo ...

- 深度学习-tensorflow学习笔记(1)-MNIST手写字体识别预备知识

深度学习-tensorflow学习笔记(1)-MNIST手写字体识别预备知识 在tf第一个例子的时候需要很多预备知识. tf基本知识 香农熵 交叉熵代价函数cross-entropy 卷积神经网络 s ...

- 深度学习-tensorflow学习笔记(2)-MNIST手写字体识别

深度学习-tensorflow学习笔记(2)-MNIST手写字体识别超级详细版 这是tf入门的第一个例子.minst应该是内置的数据集. 前置知识在学习笔记(1)里面讲过了 这里直接上代码 # -*- ...

- 深度学习Tensorflow相关书籍推荐和PDF下载

深度学习Tensorflow相关书籍推荐和PDF下载 baihualinxin关注 32018.03.28 10:46:16字数 481阅读 22,673 1.机器学习入门经典<统计学习方法&g ...

- 学习TensorFlow,调用预训练好的网络(Alex, VGG, ResNet etc)

视觉问题引入深度神经网络后,针对端对端的训练和预测网络,可以看是特征的表达和任务的决策问题(分类,回归等).当我们自己的训练数据量过小时,往往借助牛人已经预训练好的网络进行特征的提取,然后在后面加上自 ...

- 学习TensorFlow,TensorBoard可视化网络结构和参数

在学习深度网络框架的过程中,我们发现一个问题,就是如何输出各层网络参数,用于更好地理解,调试和优化网络?针对这个问题,TensorFlow开发了一个特别有用的可视化工具包:TensorBoard,既可 ...

随机推荐

- 洛谷 P3657 [USACO17FEB]Why Did the Cow Cross the Road II P

题面 大意:让你把两个n的排列做匹配,连线不想交,而且匹配的数字的差<=4,求最大匹配数 sol:(参考了kczno1的题解)对于第一个排列从左往右枚举,用树状数组维护到达另一个序列第i个数字的 ...

- BZOJ5338[TJOI2018]xor——主席树+dfs序

题目描述 现在有一颗以1为根节点的由n个节点组成的树,树上每个节点上都有一个权值vi. 现在有Q 次操作,操作如下: 1 x y 查询节点x的子树中与y异或结果的最大值 2 x y z ...

- BZOJ2124 等差子序列(树状数组+哈希)

容易想到一种暴力的做法:枚举中间的位置,设该位置权值为x,如果其两边存在权值关于x对称即合法. 问题是如何快速寻找这个东西是否存在.考虑仅将该位置左边出现的权值标1.那么若在值域上若关于x对称的两权值 ...

- VMware配置Linux虚拟机访问外网

[虚拟机版本] 系统版本 : Centos 6.8 [连接方法] 网络模式:桥接模式 ps:本人比较喜欢用桥接,直接NAT也是可以的 [配置步骤] 1.配置网卡 #配置命令 vi /etc/sysco ...

- String类型的特殊之处

String是一种特殊的引用类型,那么它究竟特殊在哪里? 请看看下面这个程序,输出什么结果? public static void changeStr(String str) { str = &quo ...

- 自学Zabbix12.3 Zabbix命令-zabbix_agentd

点击返回:自学Zabbix之路 点击返回:自学Zabbix4.0之路 点击返回:自学zabbix集锦 自学Zabbix12.3 Zabbix命令-zabbix_agentd 1. zabbix_age ...

- NOIP2013题解

NOIP2013题解 Day1 转圈游戏 circle 快速幂模板题. #include<iostream> using namespace std; int n,m,k,x; int f ...

- LOJ [#115. 无源汇有上下界可行流](https://loj.ac/problem/115)

#115. 无源汇有上下界可行流 先扔个板子,上下界的东西一点点搞,写在奇怪的合集里面 Code: #include <cstdio> #include <cstring> # ...

- CISCN2018-WP

MISC: 验证码: 用token登录 输入好验证码就可以得到flag Picture: 图片隐写,一下就想到binwalk或者winhex打开试试 binwalk打开无果 将这段数据ctrl+shi ...

- JS数组冒泡排序&去重

冒泡排序: var a = [2,1,4,3,6,5]; for(var d = 0 ; d< a.length; d++){ for(var b = d+1; b < a.length; ...