python3百度指数抓取

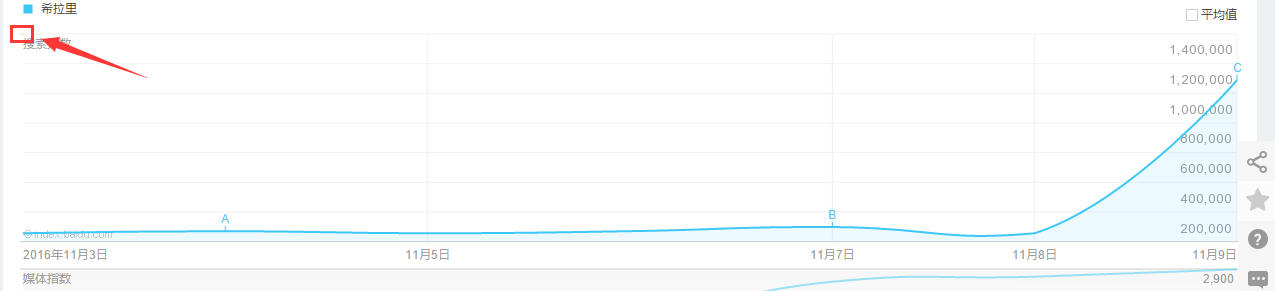

百度指数抓取,再用图像识别得到指数

前言:

土福曾说,百度指数很难抓,在淘宝上面是20块1个关键字:

哥那么叼的人怎么会被他吓到,于是乎花了零零碎碎加起来大约2天半搞定,在此鄙视一下土福

安装的库很多:

谷歌图像识别tesseract-ocr

pip3 install pillow

pip3 install pyocr

selenium2.45

Chrome47.0.2526.106 m or Firebox32.0.1

chromedriver.exe

图像识别验证码请参考我的博客:

selenium用法请参考我的博客:

进入百度指数需要登陆,登陆的账号密码写在文本account里面:

万能登陆代码如下:

# 打开浏览器

def openbrowser():

global browser

# https://passport.baidu.com/v2/?login

url = "https://passport.baidu.com/v2/?login&tpl=mn&u=http%3A%2F%2Fwww.baidu.com%2F"

# 打开谷歌浏览器

# Firefox()

# Chrome()

browser = webdriver.Chrome()

# 输入网址

browser.get(url)

# 打开浏览器时间

# print("等待10秒打开浏览器...")

# time.sleep(10)

# 找到id="TANGRAM__PSP_3__userName"的对话框

# 清空输入框

browser.find_element_by_id("TANGRAM__PSP_3__userName").clear()

browser.find_element_by_id("TANGRAM__PSP_3__password").clear()

# 输入账号密码

# 输入账号密码

account = []

try:

fileaccount = open("../baidu/account.txt")

accounts = fileaccount.readlines()

for acc in accounts:

account.append(acc.strip())

fileaccount.close()

except Exception as err:

print(err)

input("请正确在account.txt里面写入账号密码")

exit()

browser.find_element_by_id("TANGRAM__PSP_3__userName").send_keys(account[0])

browser.find_element_by_id("TANGRAM__PSP_3__password").send_keys(account[1])

# 点击登陆登陆

# id="TANGRAM__PSP_3__submit"

browser.find_element_by_id("TANGRAM__PSP_3__submit").click()

# 等待登陆10秒

# print('等待登陆10秒...')

# time.sleep(10)

print("等待网址加载完毕...")

select = input("请观察浏览器网站是否已经登陆(y/n):")

while 1:

if select == "y" or select == "Y":

print("登陆成功!")

print("准备打开新的窗口...")

# time.sleep(1)

# browser.quit()

break

elif select == "n" or select == "N":

selectno = input("账号密码错误请按0,验证码出现请按1...")

# 账号密码错误则重新输入

if selectno == "0":

# 找到id="TANGRAM__PSP_3__userName"的对话框

# 清空输入框

browser.find_element_by_id("TANGRAM__PSP_3__userName").clear()

browser.find_element_by_id("TANGRAM__PSP_3__password").clear()

# 输入账号密码

account = []

try:

fileaccount = open("../baidu/account.txt")

accounts = fileaccount.readlines()

for acc in accounts:

account.append(acc.strip())

fileaccount.close()

except Exception as err:

print(err)

input("请正确在account.txt里面写入账号密码")

exit()

browser.find_element_by_id("TANGRAM__PSP_3__userName").send_keys(account[0])

browser.find_element_by_id("TANGRAM__PSP_3__password").send_keys(account[1])

# 点击登陆sign in

# id="TANGRAM__PSP_3__submit"

browser.find_element_by_id("TANGRAM__PSP_3__submit").click()

elif selectno == "1":

# 验证码的id为id="ap_captcha_guess"的对话框

input("请在浏览器中输入验证码并登陆...")

select = input("请观察浏览器网站是否已经登陆(y/n):")

else:

print("请输入“y”或者“n”!")

select = input("请观察浏览器网站是否已经登陆(y/n):")

登陆的页面:

登陆过后需要打开新的窗口,也就是打开百度指数,并且切换窗口,在selenium用:

# 新开一个窗口,通过执行js来新开一个窗口

js = 'window.open("http://index.baidu.com");'

browser.execute_script(js)

# 新窗口句柄切换,进入百度指数

# 获得当前打开所有窗口的句柄handles

# handles为一个数组

handles = browser.window_handles

# print(handles)

# 切换到当前最新打开的窗口

browser.switch_to_window(handles[-1])

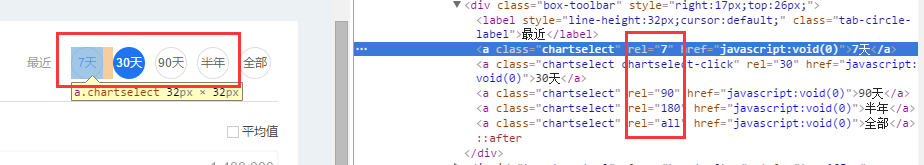

清空输入框,构造点击天数:

# 清空输入框

browser.find_element_by_id("schword").clear()

# 写入需要搜索的百度指数

browser.find_element_by_id("schword").send_keys(keyword)

# 点击搜索

# <input type="submit" value="" id="searchWords" onclick="searchDemoWords()">

browser.find_element_by_id("searchWords").click()

time.sleep(2)

# 最大化窗口

browser.maximize_window()

# 构造天数

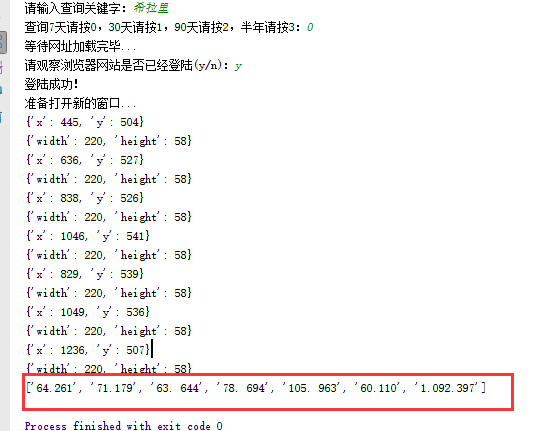

sel = int(input("查询7天请按0,30天请按1,90天请按2,半年请按3:"))

day = 0

if sel == 0:

day = 7

elif sel == 1:

day = 30

elif sel == 2:

day = 90

elif sel == 3:

day = 180

sel = '//a[@rel="' + str(day) + '"]'

browser.find_element_by_xpath(sel).click()

# 太快了

time.sleep(2)

天数也就是这里:

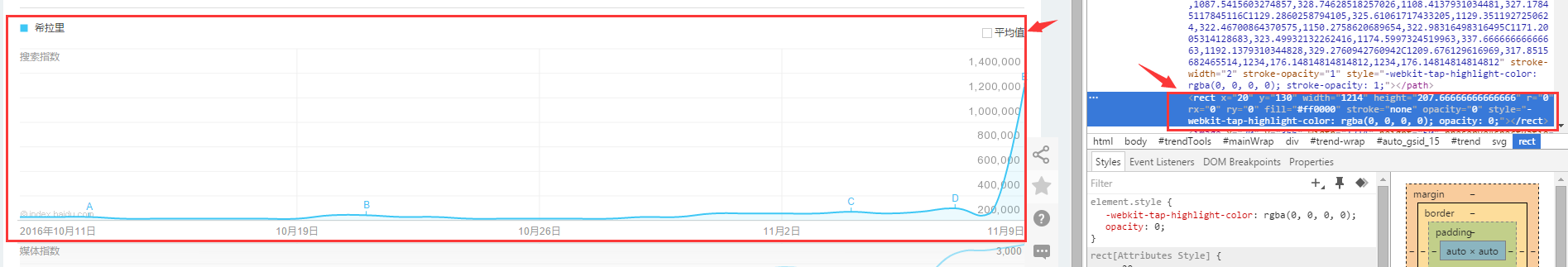

找到图形框:

xoyelement = browser.find_elements_by_css_selector("#trend rect")[2]

图形框就是:

根据坐标点的不同构造偏移量:

选取7天的坐标来观察:

第一个点的横坐标为1031.66666

第二个点的横坐标为1234

所以7天两个坐标之间的差为:202.33,其他的天数类似

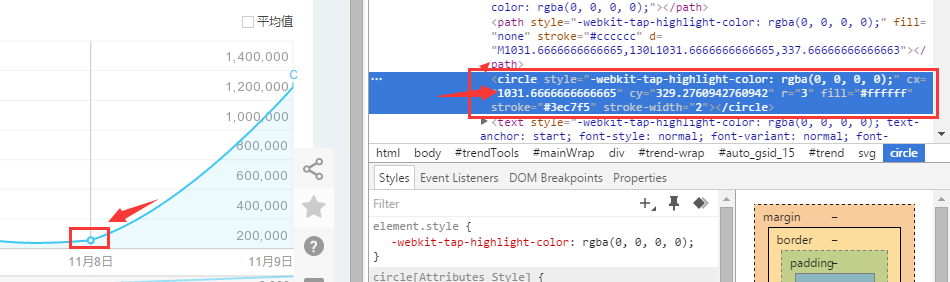

用selenium库来模拟鼠标滑动悬浮:

from selenium.webdriver.common.action_chains import ActionChains

ActionChains(browser).move_to_element_with_offset(xoyelement,x_0,y_0).perform()

但是这样子确定的点指出是在这个位置:

也就是矩形的左上角,这里是不会加载js显示弹出框的,所以要给横坐标+1:

x_0 = 1

y_0 = 0

写个按照天数的循环,让横坐标累加:

# 按照选择的天数循环

for i in range(day):

# 构造规则

if day == 7:

x_0 = x_0 + 202.33

elif day == 30:

x_0 = x_0 + 41.68

elif day == 90:

x_0 = x_0 + 13.64

elif day == 180:

x_0 = x_0 + 6.78

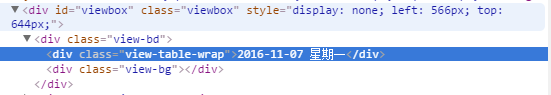

鼠标横移时会弹出框,在网址里面找到这个框:

selenium自动识别之...:

# <div class="imgtxt" style="margin-left:-117px;"></div>

imgelement = browser.find_element_by_xpath('//div[@id="viewbox"]')

并且确定这个框的大小位置:

# 找到图片坐标

locations = imgelement.location

print(locations)

# 找到图片大小

sizes = imgelement.size

print(sizes)

# 构造指数的位置

rangle = (int(locations['x']), int(locations['y']), int(locations['x'] + sizes['width']),

int(locations['y'] + sizes['height']))

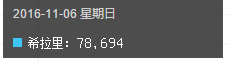

截取的图形为:

下面的思路就是:

- 将整个屏幕截图下来

- 打开截图用上面得到的这个坐标rangle进行裁剪

但是最后裁剪出来的是上面的那个黑框,我想要的效果是:

本次更新加入了对于关键词长度的判断,能够自动识别关键词长度而进行截取:

add_length = (len(keyword) - 2) * sizes['width'] / 15

找到位置:

# 构造指数的位置

rangle = (

int(locations['x'] + sizes['width'] / 4 + add_length), int(locations['y'] + sizes['height'] / 2 - 40),

int(locations['x'] + sizes['width'] * 2 / 3), int(locations['y'] + sizes['height'] - 40))

后面的完整代码是:

# <div class="imgtxt" style="margin-left:-117px;"></div>

imgelement = browser.find_element_by_xpath('//div[@id="viewbox"]')

# 找到图片坐标

locations = imgelement.location

print(locations)

# 找到图片大小

sizes = imgelement.size

print(sizes)

# 构造关键词长度

add_length = (len(keyword) - 2) * sizes['width'] / 15

# 构造指数的位置

rangle = (

int(locations['x'] + sizes['width'] / 4 + add_length), int(locations['y'] + sizes['height'] / 2 - 40),

int(locations['x'] + sizes['width'] * 2 / 3), int(locations['y'] + sizes['height'] - 40))

# 截取当前浏览器

path = "../baidu/" + str(num)

browser.save_screenshot(str(path) + ".png")

# 打开截图切割

img = Image.open(str(path) + ".png")

jpg = img.crop(rangle)

jpg.save(str(path) + ".jpg")

但是后面发现裁剪的图片太小,识别精度太低,所以需要对图片进行扩大:

# 将图片放大一倍

# 原图大小73.29

jpgzoom = Image.open(str(path) + ".jpg")

(x, y) = jpgzoom.size

x_s = 146

y_s = 58

out = jpgzoom.resize((x_s, y_s), Image.ANTIALIAS)

out.save(path + 'zoom.jpg', 'png', quality=95)

原图大小请 右键->属性->详细信息 查看,我的是长73像素,宽29像素

最后就是图像识别

# 图像识别

index = []

image = Image.open(str(path) + "zoom.jpg")

code = pytesseract.image_to_string(image)

if code:

index.append(code)

最后效果图:

代码在我的github上面:

python3百度指数抓取的更多相关文章

- Python3.x:抓取百事糗科段子

Python3.x:抓取百事糗科段子 实现代码: #Python3.6 获取糗事百科的段子 import urllib.request #导入各类要用到的包 import urllib import ...

- Python3.x+Fiddler抓取APP数据

随着移动互联网的市场份额逐步扩大,手机APP已经占据我们的生活,以往的数据分析都借助于爬虫爬取网页数据进行分析,但是新兴的产品有的只有APP,并没有网页端这对于想要提取数据的我们就遇到了些问题,本章以 ...

- Python3简单爬虫抓取网页图片

现在网上有很多python2写的爬虫抓取网页图片的实例,但不适用新手(新手都使用python3环境,不兼容python2), 所以我用Python3的语法写了一个简单抓取网页图片的实例,希望能够帮助到 ...

- 【源码】Python3使用Requests抓取和检测电光代理API,并查询ip代理是否成功

电光代理成立后,做一篇笔记,记录我使用Requests抓取和测试电光代理的方法 很多人学习python,不知道从何学起.很多人学习python,掌握了基本语法过后,不知道在哪里寻找案例上手.很多已经做 ...

- python3+beautifulSoup4.6抓取某网站小说(四)多线程抓取

上一篇多文章,是二级目录,根目录"小说",二级目录"作品名称",之后就是小说文件. 本篇改造了部分代码,将目录设置为根目录->作者目录->作品目录- ...

- python3用BeautifulSoup抓取id='xiaodeng',且正则包含‘elsie’的标签

# -*- coding:utf-8 -*- #python 2.7 #XiaoDeng #http://tieba.baidu.com/p/2460150866 #使用多个指定名字的参数可以同时过滤 ...

- python3用BeautifulSoup抓取a标签

# -*- coding:utf-8 -*- #python 2.7 #XiaoDeng #http://tieba.baidu.com/p/2460150866 from bs4 import Be ...

- python3+beautifulSoup4.6抓取某网站小说(三)网页分析,BeautifulSoup解析

本章学习内容:将网站上的小说都爬下来,存储到本地. 目标网站:www.cuiweijuxs.com 分析页面,发现一共4步:从主页进入分版打开分页列表.打开分页下所有链接.打开作品页面.打开单章内容. ...

- python3+beautifulSoup4.6抓取某网站小说(二)基础功能设计

本章学习内容:1.网页编码还原读取2.功能设计 stuep1:网页编码还原读取 本次抓取对象: http://www.cuiweijuxs.com/jingpinxiaoshuo/ 按照第一篇的代码来 ...

随机推荐

- Ajax中return false无效 怎么解决?

var flag=0; $.ajax({ url:"widget?type=member_register&ajax=yes&action=checkname&use ...

- Centos7下搭建LAMP平台环境 (转载)

1.启用Apache(httpd) Centos7默认已经安装httpd服务,只是没有启动.如果你需要全新安装,可以yum install -y httpd 启动服务:systemctl start ...

- html5获取经纬度,百度api获取街区名,并使用JS保存进cookie

引用js<script type="text/javascript" src="http://api.map.baidu.com/api?v=2.0&ak= ...

- Git基础操作

配置秘钥 1.检查本机有没有秘钥 检查~/.ssh看看是否有名为d_rsa.pub和id_dsa.pub的2个文件. $ ~/.sshbash: /c/Users/lenovo/.ssh: Is a ...

- redhat网络基础配置

添加浮动IP: ifconfig eth0:1 192.168.1.106 IP配置文件: BOOTPROTO: 采用的启动协议,有三种选择: (1) none:不使用启动协议 (2) static: ...

- 【html5】常见标签使用说明(持续更新)

说明: 所谓常见,是指我在优秀网页源码中见到的. 1.viewport 我见到的时候是这样: <meta name="viewport" content="widt ...

- 学习PYTHON之路, DAY 2 - PYTHON 基础 2(基础数据类型)

一 字符串格式化输出 name = 'nikita' age = 18 print ("I'am %s, age is %d") % (name, age) PS: 字符串是 %s ...

- Java:多线程<四> Lock、停止线程、守护线程、join、优先级&yield

Java1.5以后,Condition将Object监视器方法(wait, notify, notifyAll)分解成截然不同的对象,以便通过这些对象与任意Lock实现组合使用为每个对像提供多个等待s ...

- sql server 子找父和父找子

父找子 with RTD1 as( select Id,pid from Sys_XCode ), RTD2 as( select * from RTD1 where id=1 union all s ...

- debug实战:COM组件GetToSTA导致高内存+GC被阻塞

最近花了好几周解决一个WPF高内存的问题,问题的表象是内存不断增加.未被回收,根源是GC的FinalizeThread被阻塞,导致整个GC挂掉.从以下几步来分析这个问题: 1.用ANTS Memory ...