精准营销、批量提取QQ群成员号码

需要具备以下工具:

1、大量精准QQ群

2、Fiddler抓包工具

3、QQ号批量提取工具

1、大量精准的QQ群

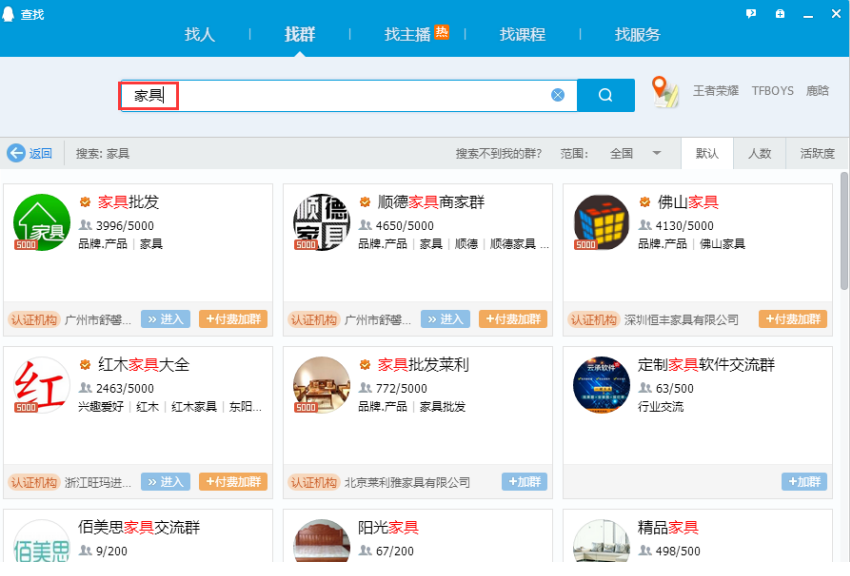

QQ群,大家可以根据自己的营销行业去搜索目标群。

随便加几个2000人的群就过万了。

例如:我要查找“家具”行业的,一搜索一大堆。

2、Fiddler抓包工具

下载地址:https://www.telerik.com/download/fiddler

如果没有这方面的工具,我们是无法取得QQ号的,因为我们不知道QQ成员的获取地址。

使用Fiddler工具:

具体的安装过程这里就不再详细说了,安装过程大家可以百度一下。

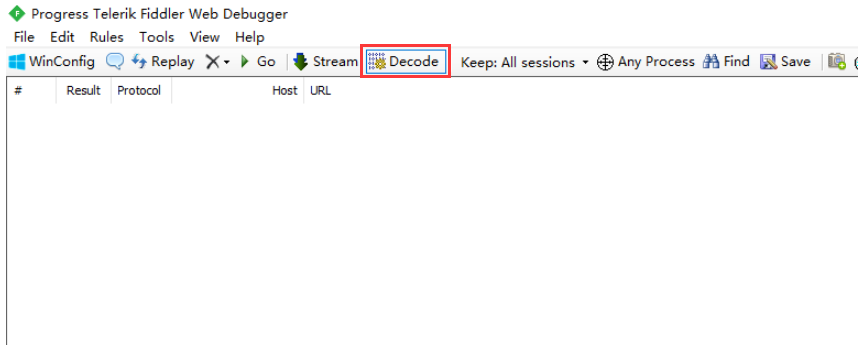

运行Fiddler:

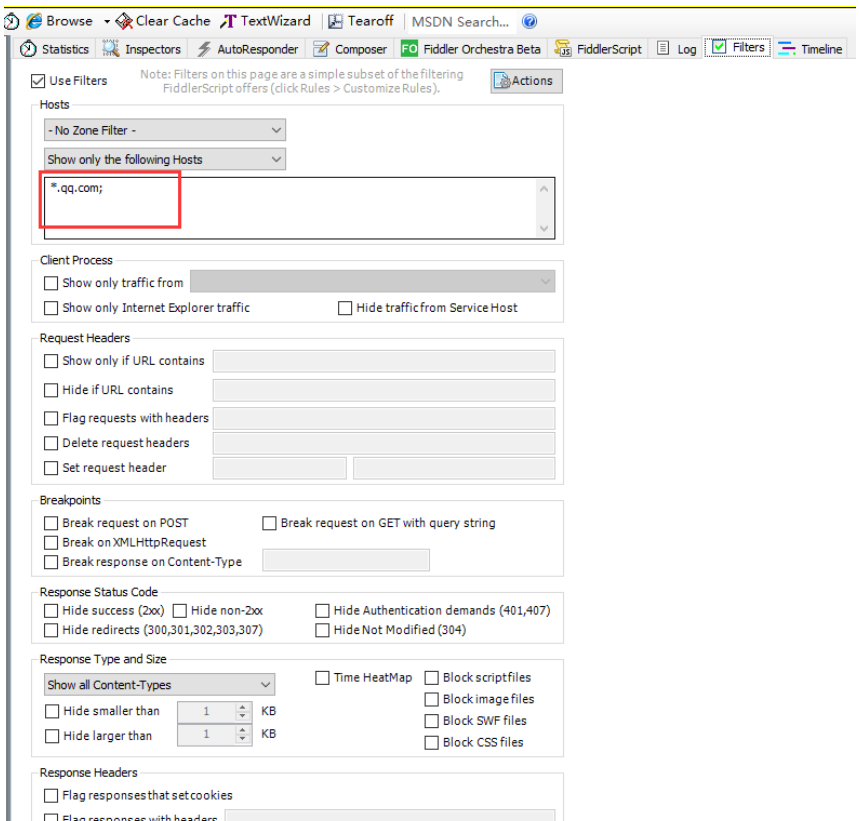

这里要设置一下,HOST过滤,因为太多请求了,要不然看不过来。

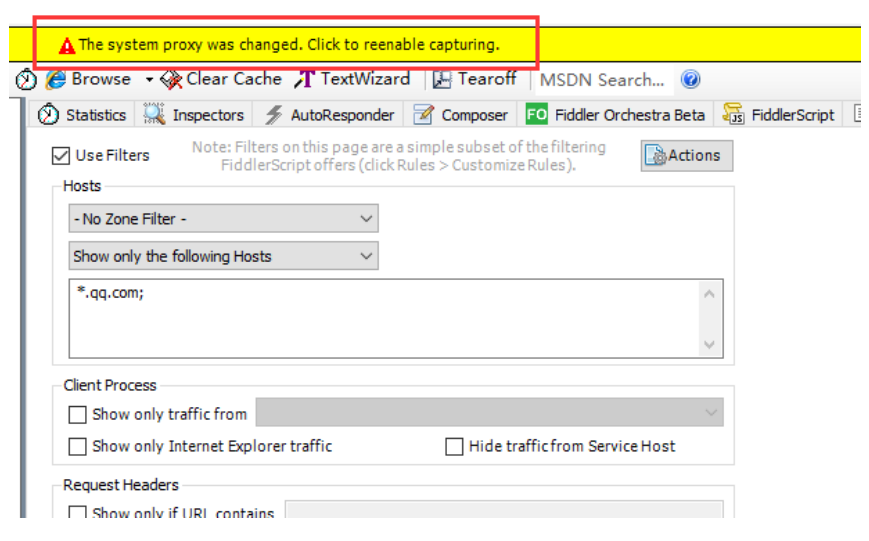

启用代理,因为都是通过代理的模式去抓包的。

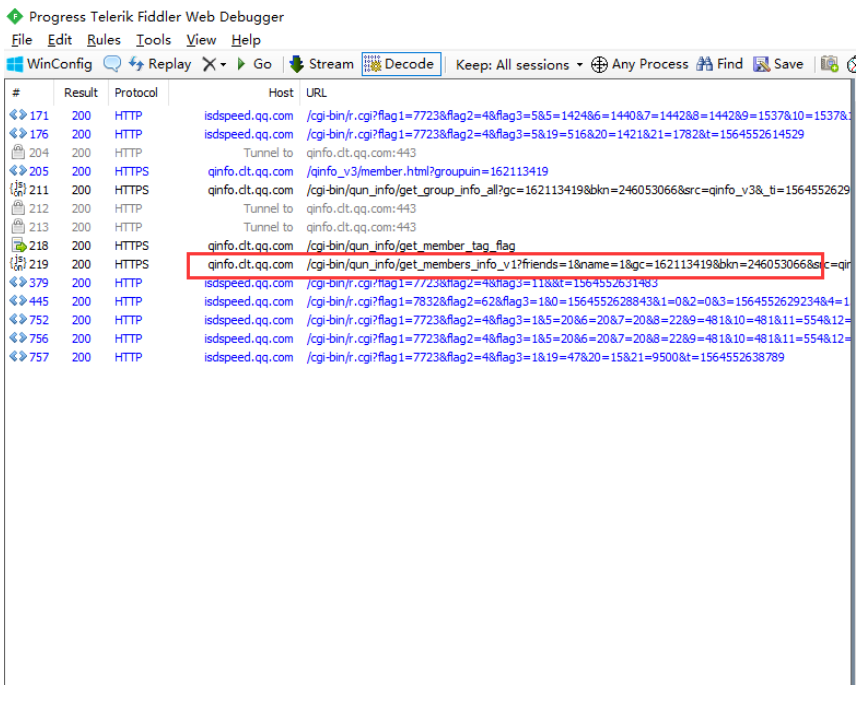

点击刚刚加入的QQ群,开始抓包,如图:

Fiddler会显示相关请求页面的过程,包括请求的数据和服务端相应的数据,如下图:

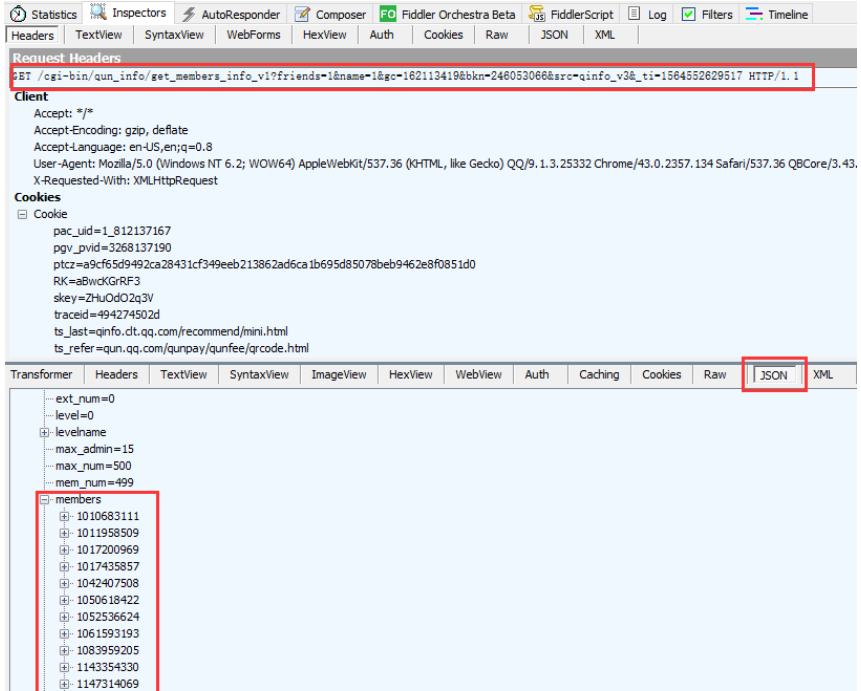

点击红色的框框请求的地址,就是获取QQ群成员的地址,如图返回的JSON数据:

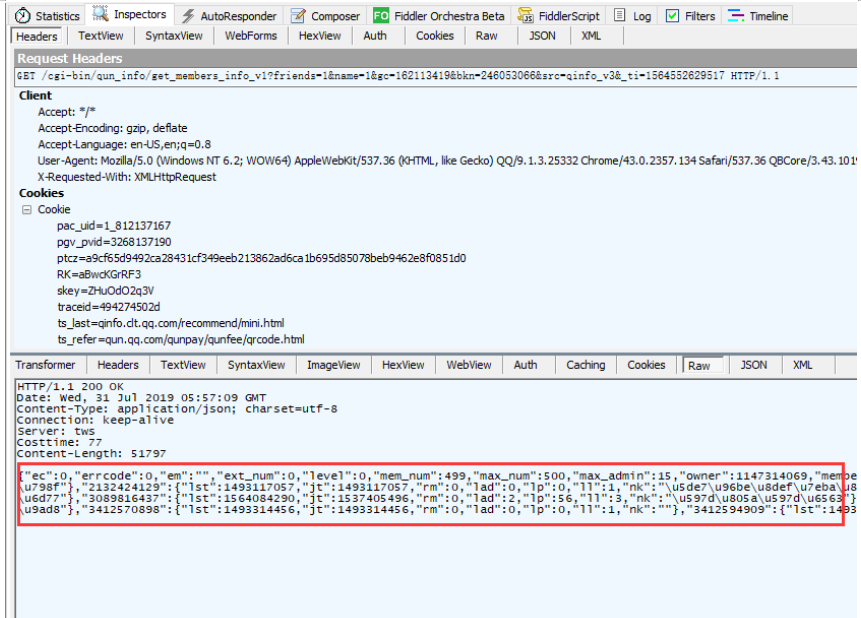

其中members就是群的QQ成员号码。点击Raw(原始数据)可以看到JSON数据:

复制这段JSON数据,然后使用工具提取,提取号码的工具需要自己开发,我这里就已C#为例写了主要的代码:

[TestClass]

public class UnitTest1

{

[TestMethod]

public void TestMethod1()

{

string[] files = Directory.GetFiles(@"E:\test\test1\UnitTestProject1\qq");

string outputFile = @"E:\test\test1\UnitTestProject1\qq\outputs\output.txt"; foreach (var path in files)

{

PickQQ(path, outputFile);

}

} private static void PickQQ(string inputPath,string outputPath)

{

StreamReader reader = new StreamReader(inputPath);

StreamWriter writer = new StreamWriter(outputPath,true); string content = reader.ReadToEnd();

var jObj = (JObject)JsonConvert.DeserializeObject(content);

var jObjMembers = (JObject)jObj["members"];

foreach (var item in jObjMembers)

{

writer.WriteLine(item.Key);

} writer.Close();

writer.Dispose(); reader.Close();

reader.Dispose();

}

}

这样就完成了提取过程,多个QQ群提取,原理一样,先将JSON数据抓出来,然后写代码实现提取。本次的QQ群成员提取就写到这里,今后将会为大家献上更精彩的案例。

来个趣味题,大家放松放松:

精准营销、批量提取QQ群成员号码的更多相关文章

- 关于一键提取QQ群成员信息的记录

问题情境 昨天晚上回宿舍看到舍友在吐槽:天哪,我要把70多个人的QQ号全统计出来,只能一个一个地在咱们学院的学院群里找.吐了. 当时我第一反应是用python写个脚本之类的去做,因此查阅了一下资料,找 ...

- QQ群成员发言次数统计(正则表达式版)

1.先将QQ群的消息记录以.txt文件格式导出来,保存路径及名称自己定义(在本文我导出到Y盘,命名为test.txt) 2.程序如下: data statistics1; if _n_=1 then ...

- 9 行 javascript 代码获取 QQ 群成员

昨天看到一条微博:「22 行 JavaScript 代码实现 QQ 群成员提取器」. 本着好奇心点击进去,发现没有达到效果,一是 QQ 版本升级了,二是博客里面的代码也有些繁琐. 于是自己试着写了一个 ...

- QQ群成员发言次数统计(词云制作)

所用数据来自于之前的一篇博客: <QQ群成员发言次数统计(正则表达式版)> 链接:http://www.cnblogs.com/liyongzhao/p/3324026.html 1.首先 ...

- 利用Python获取统计自己的qq群成员信息

利用python获取自己的qq群成员信息! 首先说明一下需要使用的工具以及技术:python3 + selenium selenium安装方法:pip install selenium 前提:获取自己 ...

- 利用python获取自己的qq群成员信息

利用python获取自己的qq群成员信息! 首先说明一下需要使用的工具以及技术:python3 + selenium selenium安装方法:pip install selenium 前提:获取自己 ...

- PHP获取QQ群成员QQ号码

.加入某个群 .进入群空间http://qun.qzone.qq.com/group#!/25998059/member 备注:25998059为群号码 .进入群成员列表 .使用浏览,在某个群成员头像 ...

- 火车头采集器如何采集QQ群成员中的QQ号

如何采集QQ群群员QQ号,采集QQ号,批量采集QQ号 众所周知,QQ群群员QQ号无法导出,即使会员也不可以,那我们只能通过三方工具来实现我们的要求,那今天我们讲讲如何通过火车采集器来采集QQ群群员QQ ...

- 【淘宝客】批量提取QQ号

1:打开QQ群官方,网址:http://qun.qq.com/ 2.点击导航栏:群管理 3.点击成员管理,选择需要提取QQ号的群 4.全选复制群成员 5.打开网址:http://tool.oschin ...

随机推荐

- JS 数据类型分析及字符串的方法

1.js数据类型分析 (1)基础类型:string.number.boolean.null.undefined (2)引用类型:object-->json.array... 2.点运算 xxx ...

- 请使用迭代查找一个list中最小和最大值,并返回一个tuple

如果给定一个list或tuple,我们可以通过for循环来遍历这个list或tuple,这种遍历我们称为迭代(Iteration). 在Python中,迭代是通过for ... in来完成的,而很多语 ...

- 常用的方法论-SWOT

- 大数据虚拟混算平台Moonbox配置指南

一.环境准备 已安装Apache Spark 2.2.0(此版本仅支持Apache Spark 2.2.0, 其他Spark 版本后续会兼容) 已安装MySQL并启动,且开启远程访问 各安装节点已经配 ...

- Oracle数据库----函数

--大小写控制函数--upperselect * from emp where job = upper('salesman'); --lowerselect * from emp where lowe ...

- WPF 入门笔记之布局

一.布局原则: 1. 不应显示的设定元素的尺寸,反而元素可以改变它的尺寸,并适应它们的内容 2. 不应使用平布的坐标,指定元素的位置. 3. 布局容器和它的子元素是共享可以使用的空间 4. 可以嵌套的 ...

- Java异常与处理机制

Java的异常层次体系 Java的所有异常对象都派生自Throwable类,下层有两个分支:error和exception. Error分支描述Java运行时系统内部错误或资源耗尽错误,遇到派生自Er ...

- jsp页面中将CST时间格式化为年月日

引入: <%@ taglib prefix="fmt" uri="http://java.sun.com/jsp/jstl/fmt"%> 格式化: ...

- SpringBoot解决cors跨域问题

1.使用@CrossOrigin注解实现 (1).对单个接口配置CORS @CrossOrigin(origins = {"*"}) @PostMapping("/hel ...

- C#4.0新增功能03 泛型中的协变和逆变

连载目录 [已更新最新开发文章,点击查看详细] 协变和逆变都是术语,前者指能够使用比原始指定的派生类型的派生程度更大(更具体的)的类型,后者指能够使用比原始指定的派生类型的派生程度更小(不太具体 ...