神经网络权值初始化方法-Xavier

https://blog.csdn.net/u011534057/article/details/51673458

https://blog.csdn.net/qq_34784753/article/details/78668884

https://blog.csdn.net/kangroger/article/details/61414426

https://www.cnblogs.com/lindaxin/p/8027283.html

神经网络中权值初始化的方法

《Understanding the difficulty of training deep feedforward neural networks》

可惜直到近两年,这个方法才逐渐得到更多人的应用和认可。

为了使得网络中信息更好的流动,每一层输出的方差应该尽量相等。

基于这个目标,现在我们就去推导一下:每一层的权重应该满足哪种条件。

文章先假设的是线性激活函数,而且满足0点处导数为1,即

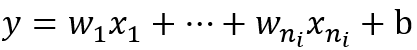

现在我们先来分析一层卷积:

其中ni表示输入个数。

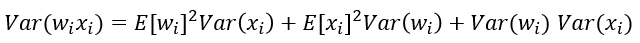

根据概率统计知识我们有下面的方差公式:

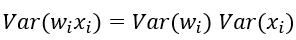

特别的,当我们假设输入和权重都是0均值时(目前有了BN之后,这一点也较容易满足),上式可以简化为:

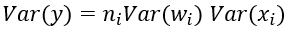

进一步假设输入x和权重w独立同分布,则有:

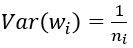

于是,为了保证输入与输出方差一致,则应该有:

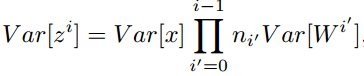

对于一个多层的网络,某一层的方差可以用累积的形式表达:

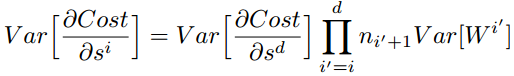

特别的,反向传播计算梯度时同样具有类似的形式:

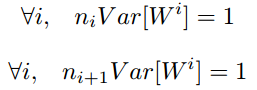

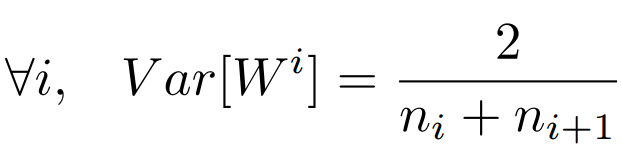

综上,为了保证前向传播和反向传播时每一层的方差一致,应满足:

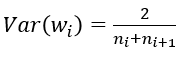

但是,实际当中输入与输出的个数往往不相等,于是为了均衡考量,最终我们的权重方差应满足:

———————————————————————————————————————

———————————————————————————————————————

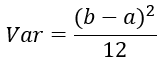

学过概率统计的都知道 [a,b] 间的均匀分布的方差为:

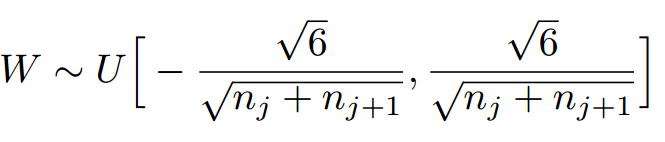

因此,Xavier初始化的实现就是下面的均匀分布:

——————————————————————————————————————————

caffe的Xavier实现有三种选择

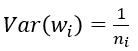

(1) 默认情况,方差只考虑输入个数:

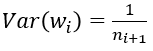

(2) FillerParameter_VarianceNorm_FAN_OUT,方差只考虑输出个数:

(3) FillerParameter_VarianceNorm_AVERAGE,方差同时考虑输入和输出个数:

之所以默认只考虑输入,我个人觉得是因为前向信息的传播更重要一些

———————————————————————————————————————————

Tensorflow 调用接口

https://www.tensorflow.org/api_docs/python/tf/glorot_uniform_initializer

tf.glorot_uniform_initializer

Aliases:

tf.glorot_uniform_initializertf.keras.initializers.glorot_uniform

tf.glorot_uniform_initializer(

seed=None,

dtype=tf.float32

)

Defined in tensorflow/python/ops/init_ops.py.

The Glorot uniform initializer, also called Xavier uniform initializer.

It draws samples from a uniform distribution within [-limit, limit] where limit is sqrt(6 / (fan_in + fan_out))where fan_in is the number of input units in the weight tensor and fan_out is the number of output units in the weight tensor.

Reference: http://jmlr.org/proceedings/papers/v9/glorot10a/glorot10a.pdf

Args:

seed: A Python integer. Used to create random seeds. Seetf.set_random_seedfor behavior.dtype: The data type. Only floating point types are supported.

Returns:

An initializer.

Mxnet 调用接口

https://mxnet.apache.org/api/python/optimization/optimization.html#mxnet.initializer.Xavier

class mxnet.initializer.Xavier(rnd_type='uniform', factor_type='avg', magnitude=3)[source]

Returns an initializer performing “Xavier” initialization for weights.

This initializer is designed to keep the scale of gradients roughly the same in all layers.

By default, rnd_type is 'uniform' and factor_type is 'avg', the initializer fills the weights with random numbers in the range of [−c,c][−c,c], where c=3.0.5∗(nin+nout)−−−−−−−−−√c=3.0.5∗(nin+nout). ninnin is the number of neurons feeding into weights, and noutnout is the number of neurons the result is fed to.

If rnd_type is 'uniform' and factor_type is 'in', the c=3.nin−−−√c=3.nin. Similarly when factor_type is 'out', the c=3.nout−−−√c=3.nout.

If rnd_type is 'gaussian' and factor_type is 'avg', the initializer fills the weights with numbers from normal distribution with a standard deviation of 3.0.5∗(nin+nout)−−−−−−−−−√3.0.5∗(nin+nout).

| Parameters: |

|

|---|

神经网络权值初始化方法-Xavier的更多相关文章

- caffe中权值初始化方法

首先说明:在caffe/include/caffe中的 filer.hpp文件中有它的源文件,如果想看,可以看看哦,反正我是不想看,代码细节吧,现在不想知道太多,有个宏观的idea就可以啦,如果想看代 ...

- [PyTorch 学习笔记] 4.1 权值初始化

本章代码:https://github.com/zhangxiann/PyTorch_Practice/blob/master/lesson4/grad_vanish_explod.py 在搭建好网络 ...

- pytorch(14)权值初始化

权值的方差过大导致梯度爆炸的原因 方差一致性原则分析Xavier方法与Kaiming初始化方法 饱和激活函数tanh,非饱和激活函数relu pytorch提供的十种初始化方法 梯度消失与爆炸 \[H ...

- 权值初始化 - Xavier和MSRA方法

设计好神经网络结构以及loss function 后,训练神经网络的步骤如下: 初始化权值参数 选择一个合适的梯度下降算法(例如:Adam,RMSprop等) 重复下面的迭代过程: 输入的正向传播 计 ...

- PyTorch 学习笔记(四):权值初始化的十种方法

pytorch在torch.nn.init中提供了常用的初始化方法函数,这里简单介绍,方便查询使用. 介绍分两部分: 1. Xavier,kaiming系列: 2. 其他方法分布 Xavier初始化方 ...

- python面向对象的基础语法(dir内置函数、self参数、初始化方法、内置方法和属性)

面相对象基础语法 目标 dir 内置函数 定义简单的类(只包含方法) 方法中的 self 参数 初始化方法 内置方法和属性 01. dir 内置函数(知道) 在 Python 中 对象几乎是无所不在的 ...

- 深度学习----Xavier初始化方法

“Xavier”初始化方法是一种很有效的神经网络初始化方法,方法来源于2010年的一篇论文<Understanding the difficulty of training deep feedf ...

- 网络权重初始化方法总结(下):Lecun、Xavier与He Kaiming

目录 权重初始化最佳实践 期望与方差的相关性质 全连接层方差分析 tanh下的初始化方法 Lecun 1998 Xavier 2010 ReLU/PReLU下的初始化方法 He 2015 for Re ...

- 深度学习——Xavier初始化方法

“Xavier”初始化方法是一种很有效的神经网络初始化方法,方法来源于2010年的一篇论文<Understanding the difficulty of training deep feedf ...

随机推荐

- AdminLTE, Color Admin

AdminLTE, Color Adminhttps://github.com/almasaeed2010/AdminLTE/http://www.seantheme.com/color-admin- ...

- 浅谈hibernate的sessionFactory和session

一.hibernate是什么? Hibernate是一个开放源代码的对象关系映射框架,它对JDBC进行了非常轻量级的对象封装,使得Java程序员可以随心所欲的使用对象编程思维来操纵数据库. Hiber ...

- vim学习笔记(9):vim显示文件名

如何让vim在编辑模式下显示文件名 在根目录下:~/.vimrc 中追加一行: set laststatus=2 shell 下执行命令: echo "set laststatus=2&qu ...

- 【内核】linux2.6版本内核编译配置选项(二)

目录 Linux2.6版本内核编译配置选项(一):http://infohacker.blog.51cto.com/6751239/1203633 Linux2.6版本内核编译配置选项(二):http ...

- [Java]随记--HttpClient发送put请求

http://blog.csdn.net/u010989191/article/details/52852155 ******************************************* ...

- django HttpResponse对象

HttpResponse对象 概述: 作用:给浏览器返回数据 HttpRequest对象是由Django创建的,HttpResponse对象是由程序员创建 用法: 不用模板,直接返回数据 语句示例:r ...

- 初步理解Python进程的信号通讯

Reference: http://www.jb51.net/article/63787.htm 信号的概念 信号(signal)-- 进程之间通讯的方式,是一种软件中断.一个进程一旦接收到信 ...

- 基于CSS3鼠标滑过放大突出效果

还记得之前分享过一款CSS3图片悬停放大特效,效果非常不错.今天我们要再来分享一款类似的CSS鼠标滑过放大突出效果,只不过之前那个是图片,这次是色块,其实掌握了其CSS原理,任何网页元素都可以实现这种 ...

- JedisConnectionPool scala

/** * Created by lq on 2017/8/29. */ object JedisConnectionPool { val config = new JedisPoolConfig() ...

- Jackson学习笔记(三)<转>

概述 使用jackson annotations简化和增强的json解析与生成. Jackson-2.x通用annotations列表:https://github.com/FasterXML/jac ...