Prometheus时序数据库-磁盘中的存储结构

Prometheus时序数据库-磁盘中的存储结构

前言

之前的文章里,笔者详细描述了监控数据在Prometheus内存中的结构。而其在磁盘中的存储结构,也是非常有意思的,关于这部分内容,将在本篇文章进行阐述。

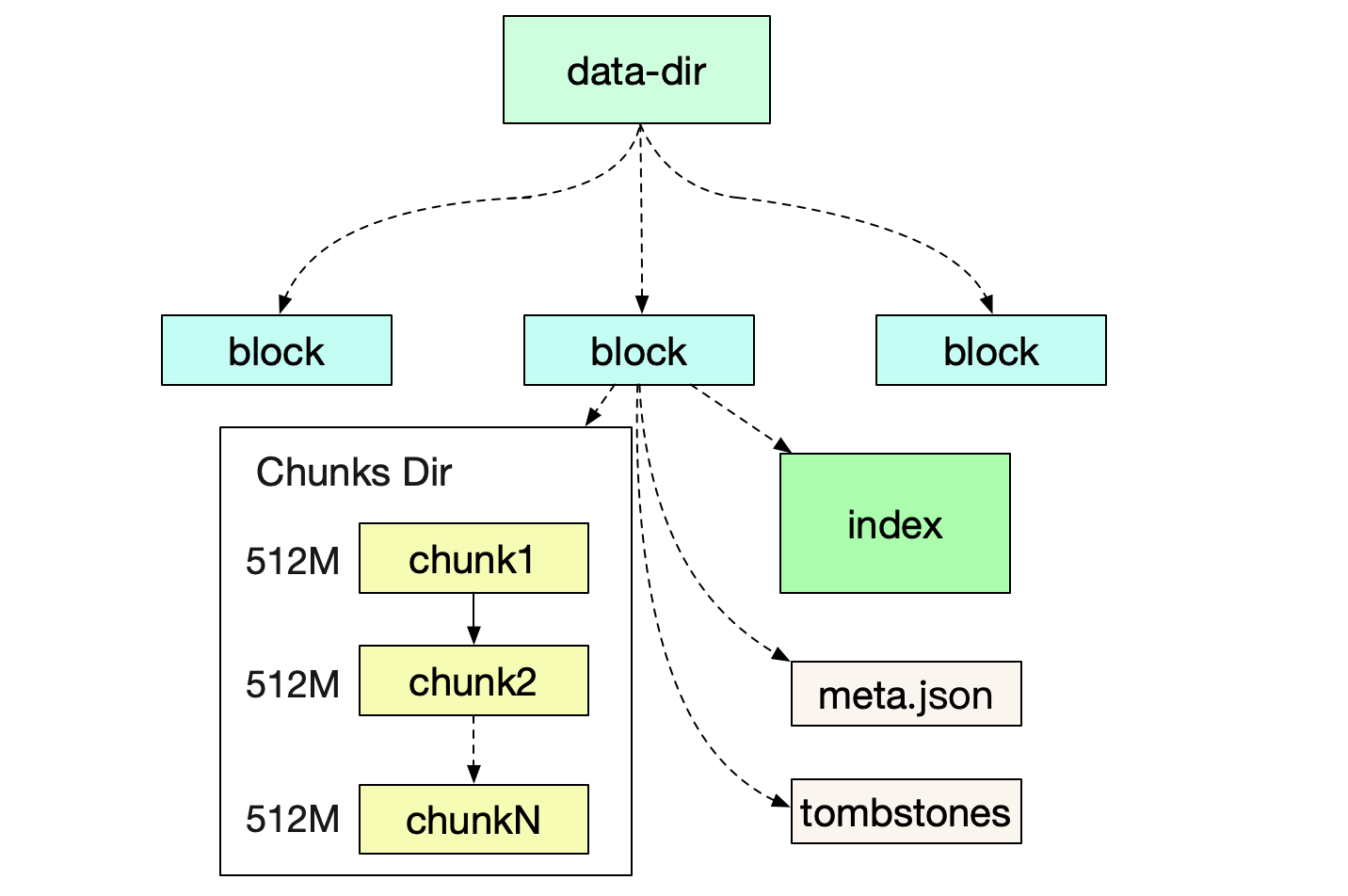

磁盘目录结构

首先我们来看Prometheus运行后,所形成的文件目录结构

在笔者自己的机器上的具体结构如下:

prometheus-data

|-01EY0EH5JA3ABCB0PXHAPP999D (block)

|-01EY0EH5JA3QCQB0PXHAPP999D (block)

|-chunks

|-000001

|-000002

.....

|-000021

|-index

|-meta.json

|-tombstones

|-wal

|-chunks_head

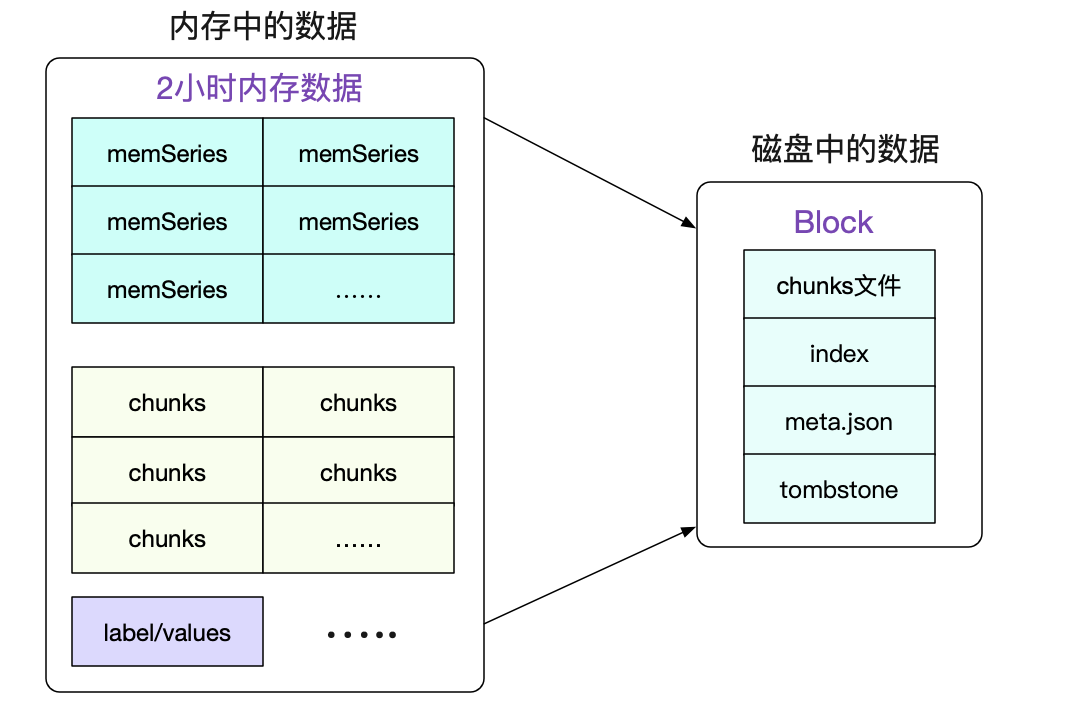

Block

一个Block就是一个独立的小型数据库,其保存了一段时间内所有查询所用到的信息。包括标签/索引/符号表数据等等。Block的实质就是将一段时间里的内存数据组织成文件形式保存下来。

最近的Block一般是存储了2小时的数据,而较为久远的Block则会通过compactor进行合并,一个Block可能存储了若干小时的信息。值得注意的是,合并操作只是减少了索引的大小(尤其是符号表的合并),而本身数据(chunks)的大小并没有任何改变。

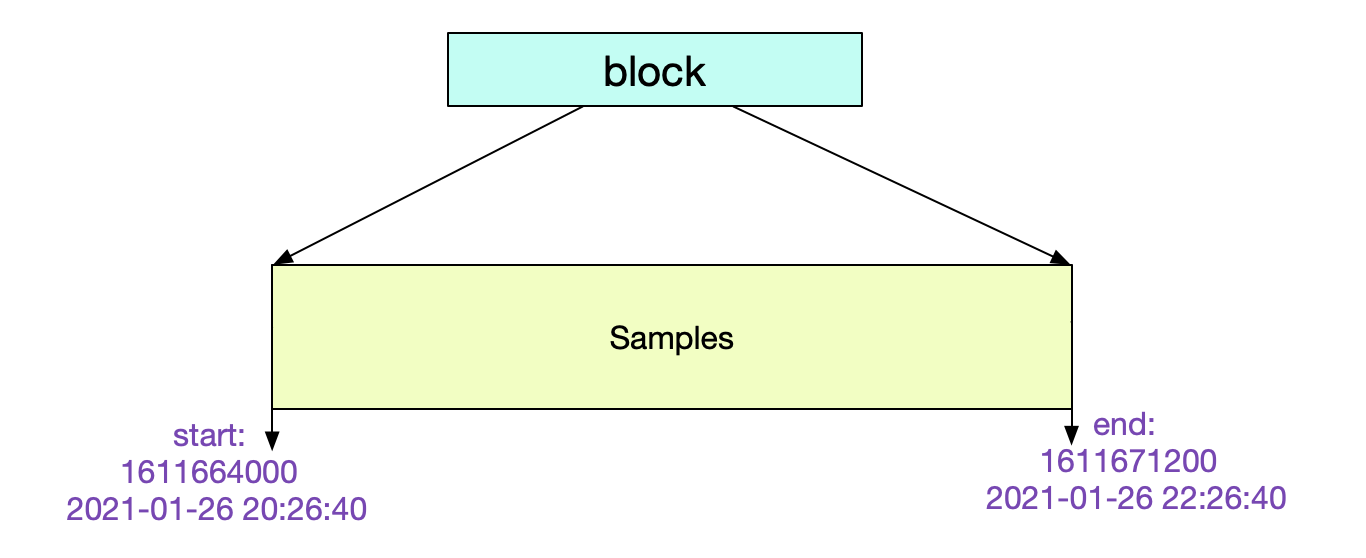

meta.json

我们可以通过检查meta.json来得到当前Block的一些元信息。

{

"ulid":"01EY0EH5JA3QCQB0PXHAPP999D"

// maxTime-minTime = 7200s => 2 h

"minTime": 1611664000000

"maxTime": 1611671200000

"stats": {

"numSamples": 1505855631,

"numSeries": 12063563,

"numChunks": 12063563

}

"compaction":{

"level" : 1

"sources: [

"01EY0EH5JA3QCQB0PXHAPP999D"

]

}

"version":1

}

其中的元信息非常清楚明了。这个Block记录了从2个小时的数据。

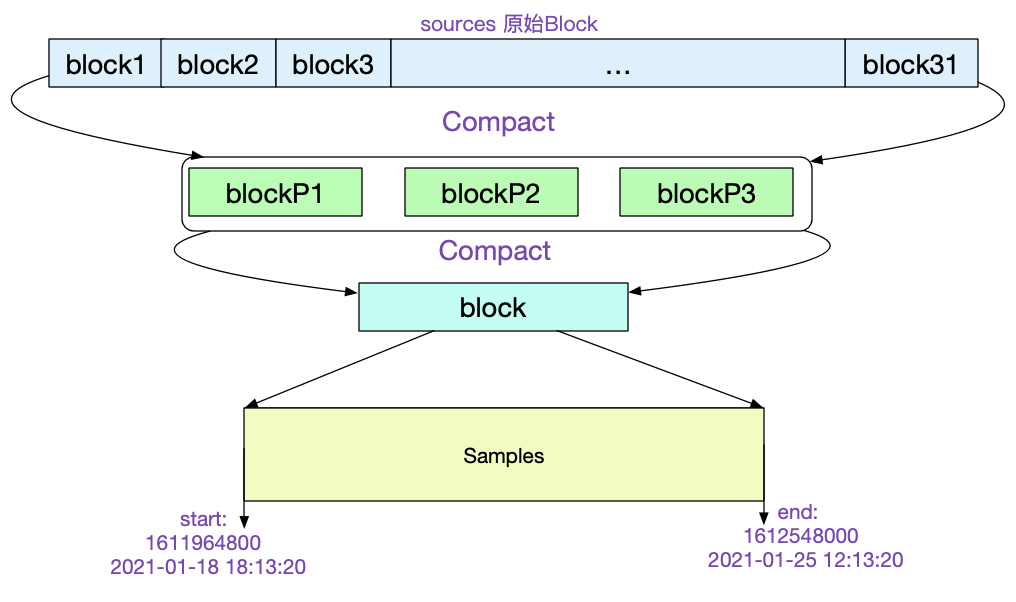

让我们再找一个比较陈旧的Block看下它的meta.json.

"ulid":"01EXTEH5JA3QCQB0PXHAPP999D",

// maxTime - maxTime =>162h

"minTime":1610964800000,

"maxTime":1611548000000

......

"compaction":{

"level": 5,

"sources: [

31个01EX......

]

},

"parents: [

{

"ulid": 01EXTEH5JA3QCQB1PXHAPP999D

...

}

{

"ulid": 01EXTEH6JA3QCQB1PXHAPP999D

...

}

{

"ulid": 01EXTEH5JA31CQB1PXHAPP999D

...

}

]

从中我们可以看到,该Block是由31个原始Block经历5次压缩而来。最后一次压缩的三个Block ulid记录在parents中。如下图所示:

Chunks结构

CUT文件切分

所有的Chunk文件在磁盘上都不会大于512M,对应的源码为:

func (w *Writer) WriteChunks(chks ...Meta) error {

......

for i, chk := range chks {

cutNewBatch := (i != 0) && (batchSize+SegmentHeaderSize > w.segmentSize)

......

if cutNewBatch {

......

}

......

}

}

当写入磁盘单个文件超过512M的时候,就会自动切分一个新的文件。

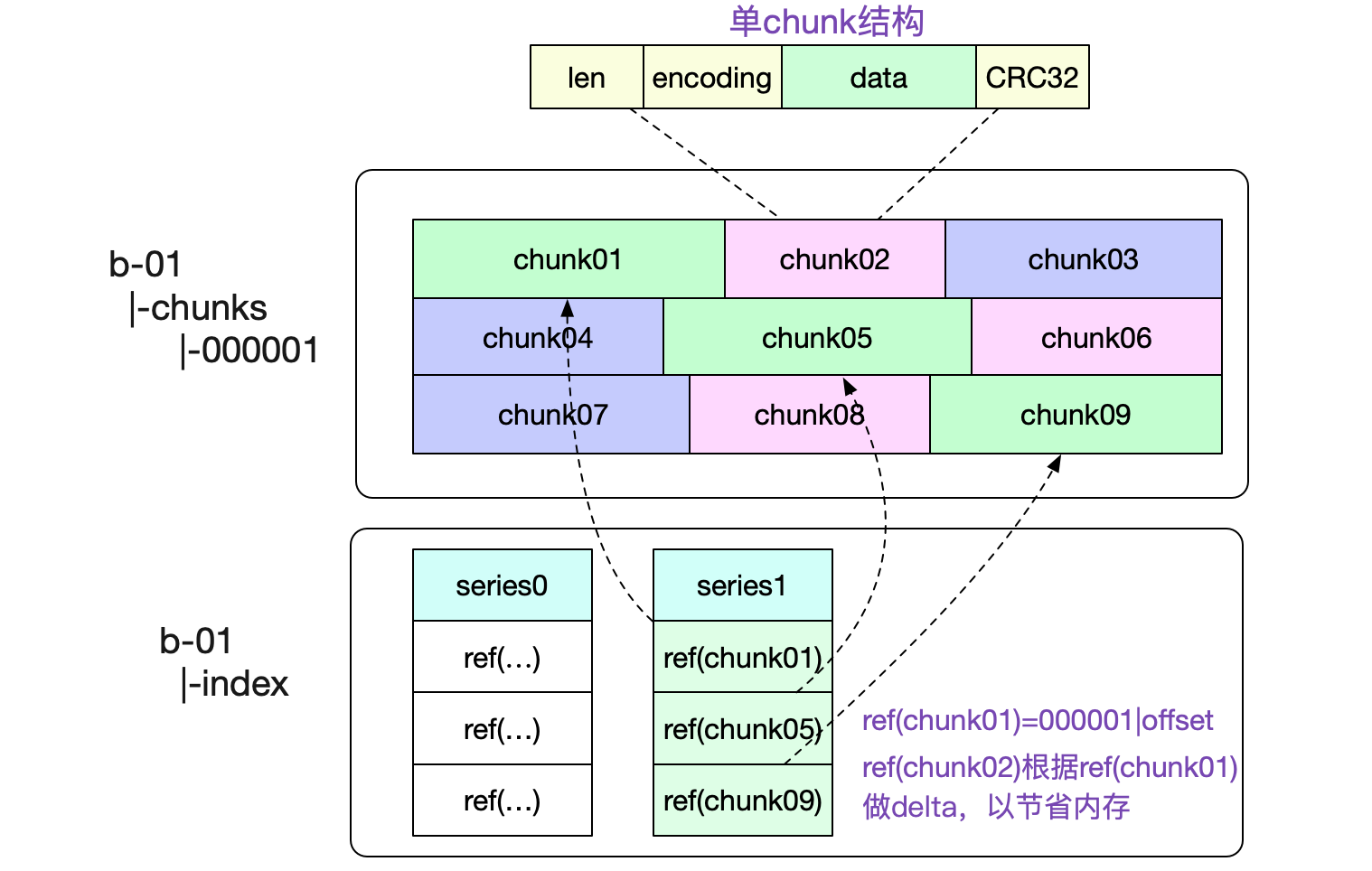

一个Chunks文件包含了非常多的内存Chunk结构,如下图所示:

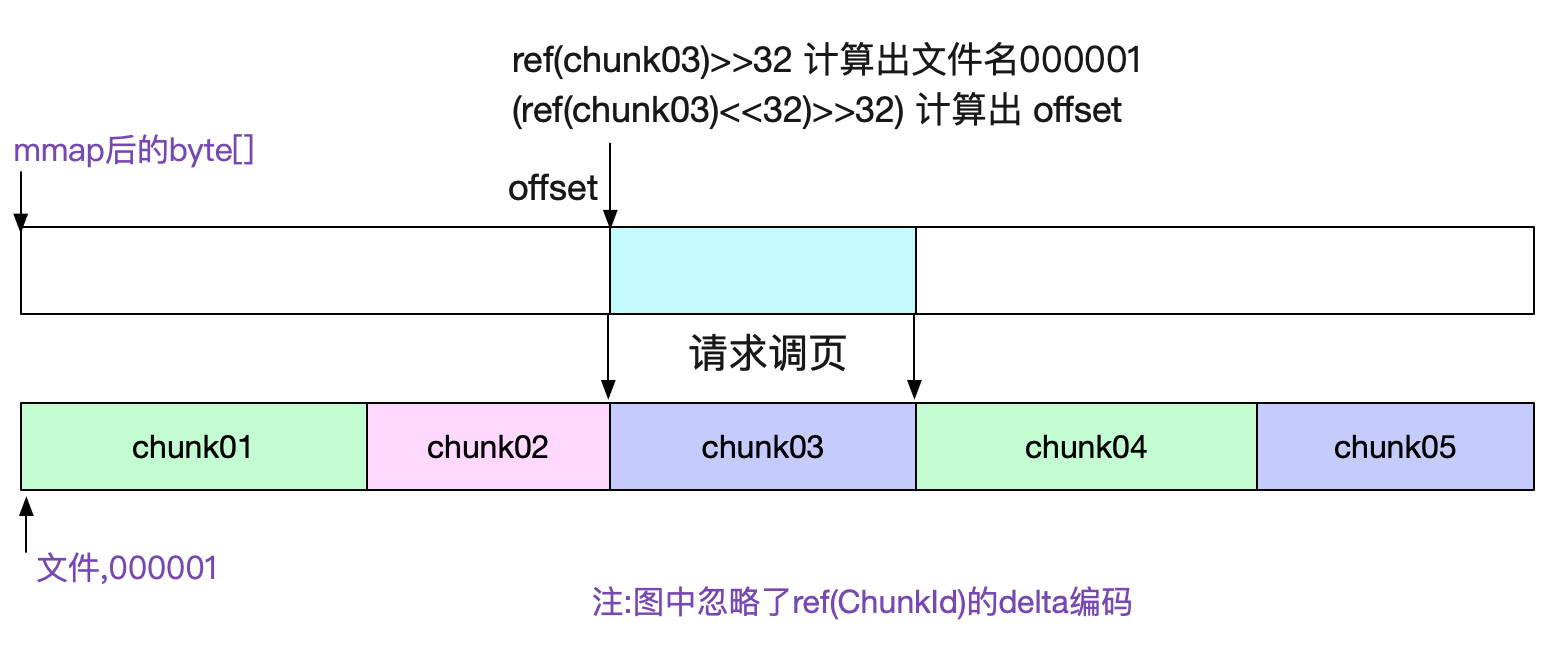

图中也标出了,我们是怎么寻找对应Chunk的。通过将文件名(000001,前32位)以及(offset,后32位)编码到一个int类型的refId中,使得我们可以轻松的通过这个id获取到对应的chunk数据。

chunks文件通过mmap去访问

由于chunks文件大小基本固定(最大512M),所以我们很容易的可以通过mmap去访问对应的数据。直接将对应文件的读操作交给操作系统,既省心又省力。对应代码为:

func NewDirReader(dir string, pool chunkenc.Pool) (*Reader, error) {

......

for _, fn := range files {

f, err := fileutil.OpenMmapFile(fn)

......

}

......

bs = append(bs, realByteSlice(f.Bytes()))

}

通过sgmBytes := s.bs[offset]就直接能获取对应的数据

index索引结构

前面介绍完chunk文件,我们就可以开始阐述最复杂的索引结构了。

寻址过程

索引就是为了让我们快速的找到想要的内容,为了便于理解。笔者就通过一次数据的寻址来探究Prometheus的磁盘索引结构。考虑查询一个

拥有系列三个标签

({__name__:http_requests}{job:api-server}{instance:0})

且时间为start/end的所有序列数据

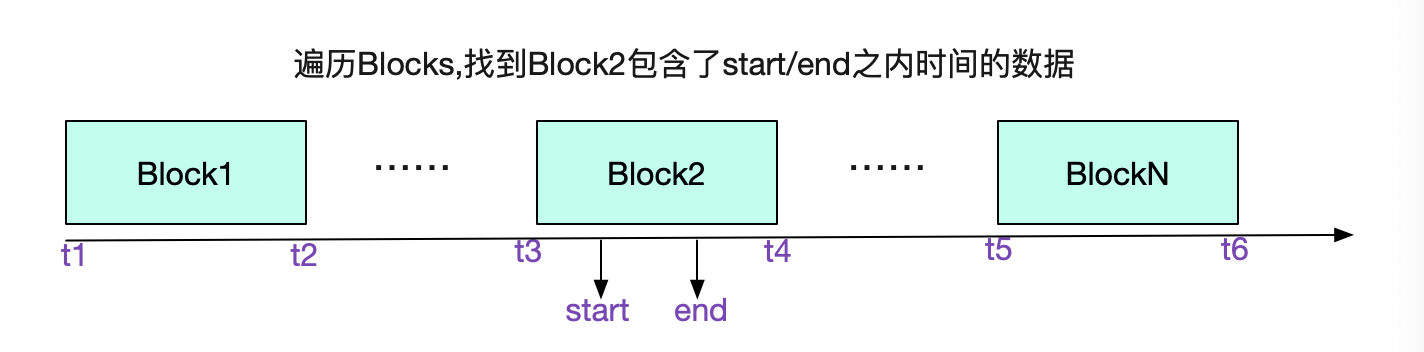

我们先从选择Block开始,遍历所有Block的meta.json,找到具体的Block

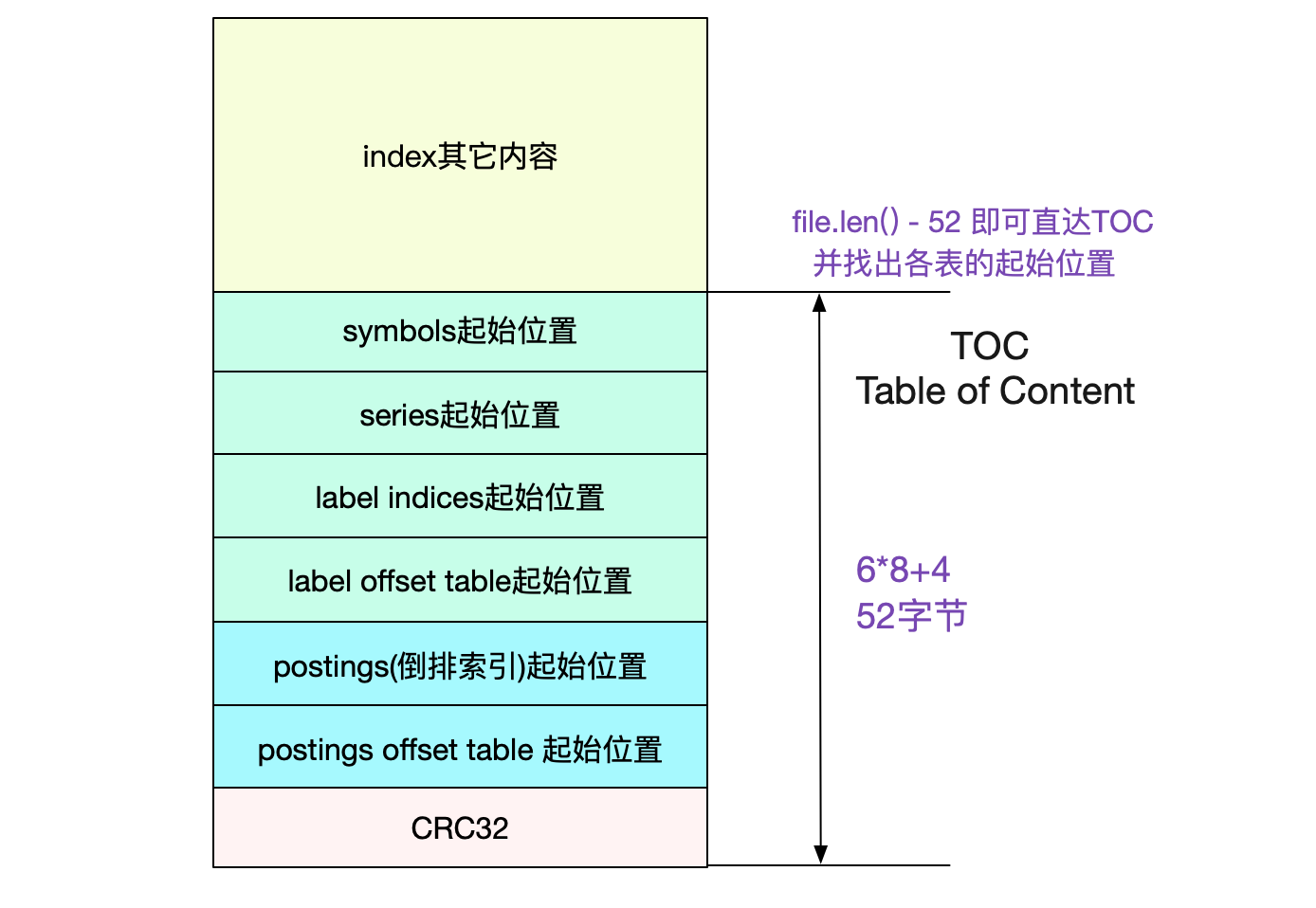

前文说了,通过Labels找数据是通过倒排索引。我们的倒排索引是保存在index文件里面的。 那么怎么在这个单一文件里找到倒排索引的位置呢?这就引入了TOC(Table Of Content)

TOC(Table Of Content)

由于index文件一旦形成之后就不再会改变,所以Prometheus也依旧使用mmap来进行操作。采用mmap读取TOC非常容易:

func NewTOCFromByteSlice(bs ByteSlice) (*TOC, error) {

......

// indexTOCLen = 6*8+4 = 52

b := bs.Range(bs.Len()-indexTOCLen, bs.Len())

......

return &TOC{

Symbols: d.Be64(),

Series: d.Be64(),

LabelIndices: d.Be64(),

LabelIndicesTable: d.Be64(),

Postings: d.Be64(),

PostingsTable: d.Be64(),

}, nil

}

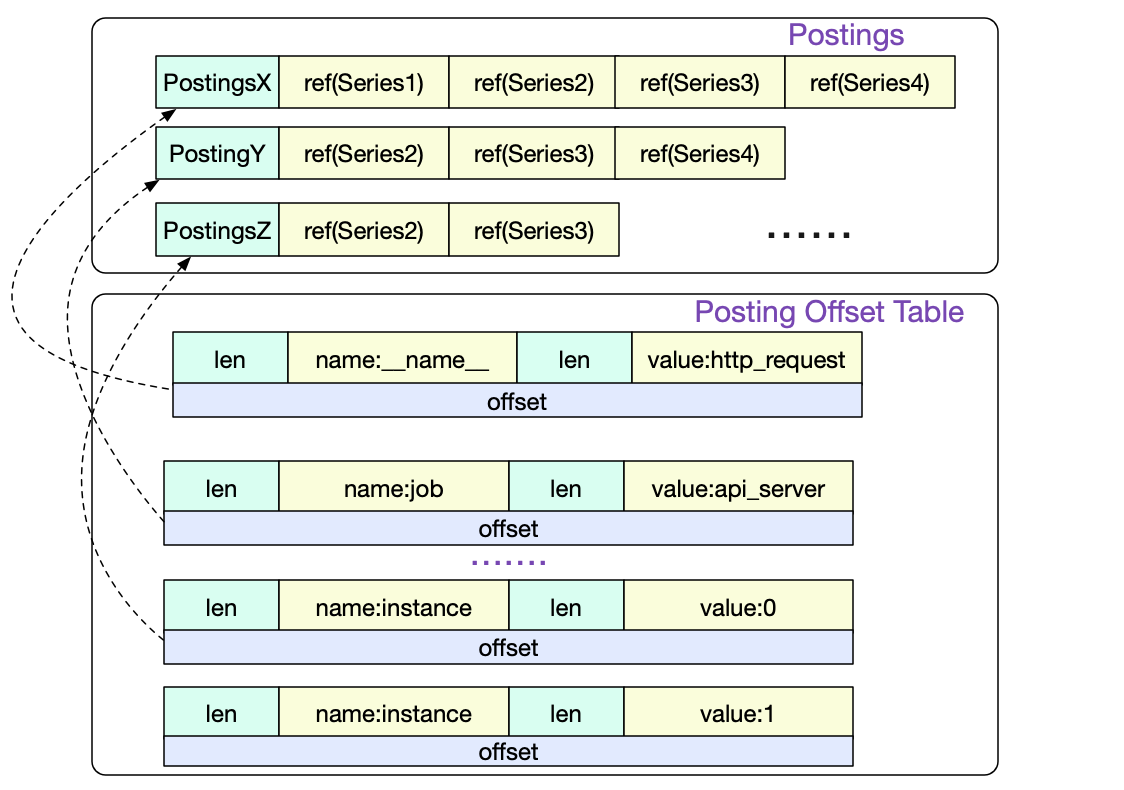

Posting offset table 以及 Posting倒排索引

首先我们访问的是Posting offset table。由于倒排索引按照不同的LabelPair(key/value)会有非常多的条目。所以Posing offset table就是决定到底访问哪一条Posting索引。offset就是指的这一Posting条目在文件中的偏移。

Series

我们通过三条Postings倒排索引索引取交集得出

{series1,Series2,Series3,Series4}

∩

{series1,Series2,Series3}

∩

{Series2,Series3}

=

{Series2,Series3}

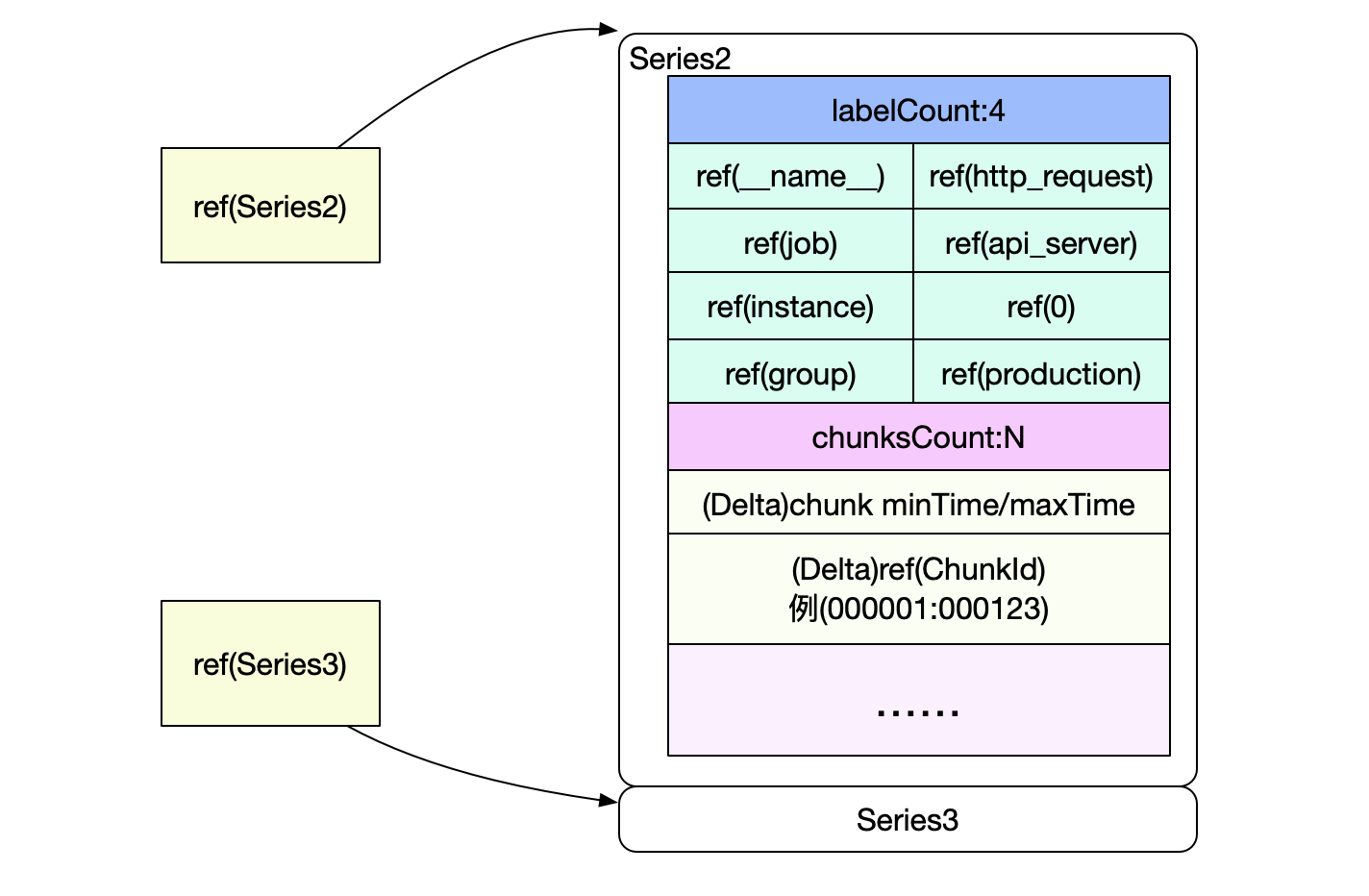

也就是要读取Series2和Serie3中的数据,而Posting中的Ref(Series2)和Ref(Series3)即为这两Series在index文件中的偏移。

Series以Delta的形式记录了chunkId以及该chunk包含的时间范围。这样就可以很容易过滤出我们需要的chunk,然后再按照chunk文件的访问,即可找到最终的原始数据。

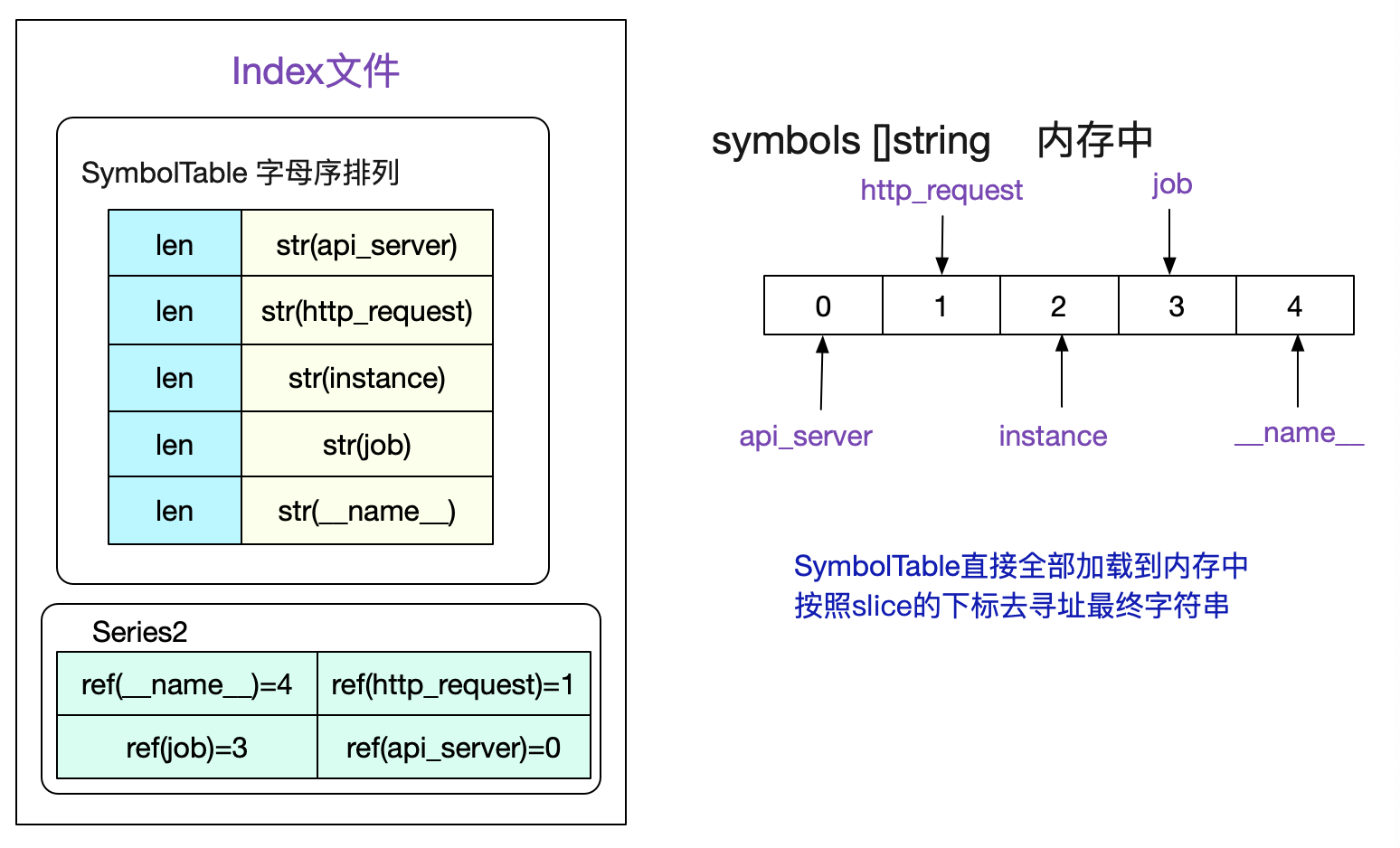

SymbolTable

值得注意的是,为了尽量减少我们文件的大小,对于Label的Name和Value这些有限的数据,我们会按照字母序存在符号表中。由于是有序的,所以我们可以直接将符号表认为是一个

[]string切片。然后通过切片的下标去获取对应的sting。考虑如下符号表:

读取index文件时候,会将SymbolTable全部加载到内存中,并组织成symbols []string这样的切片形式,这样一个Series中的所有标签值即可通过切片下标访问得到。

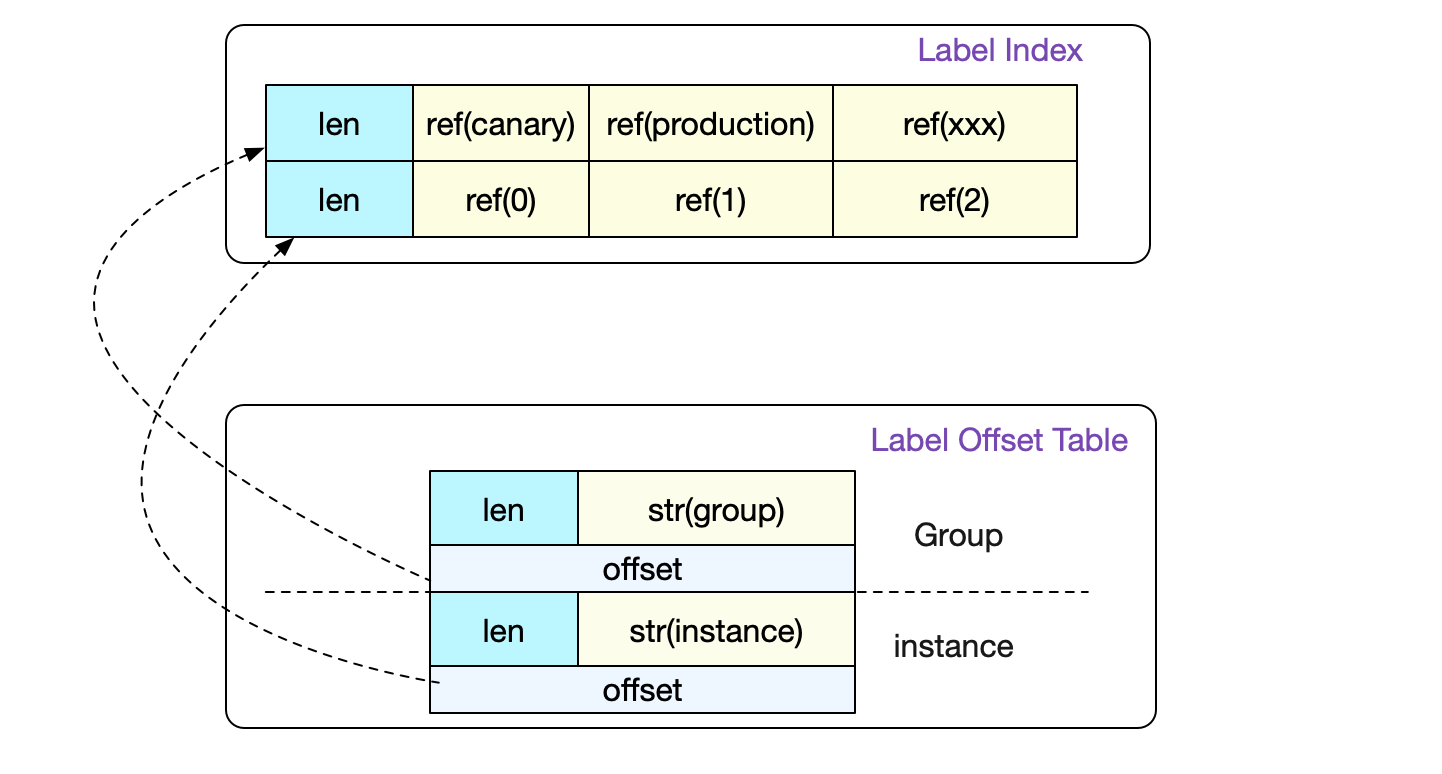

Label Index以及Label Table

事实上,前面的介绍已经将一个普通数据寻址的过程全部讲完了。但是index文件中还包含label索引以及label Table,这两个是用来记录一个Label下面所有可能的值而存在的。

这样,在正则的时候就可以非常容易的找到我们需要哪些LabelPair。详情可以见前篇。

事实上,真正的Label Index比图中要复杂一点。它设计成一条LabelIndex可以表示(多个标签组合)的所有数据。不过在Prometheus代码中只会采用存储一个标签对应所有值的形式。

完整的index文件结构

这里直接给出完整的index文件结构,摘自Prometheus中index.md文档。

┌────────────────────────────┬─────────────────────┐

│ magic(0xBAAAD700) <4b> │ version(1) <1 byte> │

├────────────────────────────┴─────────────────────┤

│ ┌──────────────────────────────────────────────┐ │

│ │ Symbol Table │ │

│ ├──────────────────────────────────────────────┤ │

│ │ Series │ │

│ ├──────────────────────────────────────────────┤ │

│ │ Label Index 1 │ │

│ ├──────────────────────────────────────────────┤ │

│ │ ... │ │

│ ├──────────────────────────────────────────────┤ │

│ │ Label Index N │ │

│ ├──────────────────────────────────────────────┤ │

│ │ Postings 1 │ │

│ ├──────────────────────────────────────────────┤ │

│ │ ... │ │

│ ├──────────────────────────────────────────────┤ │

│ │ Postings N │ │

│ ├──────────────────────────────────────────────┤ │

│ │ Label Index Table │ │

│ ├──────────────────────────────────────────────┤ │

│ │ Postings Table │ │

│ ├──────────────────────────────────────────────┤ │

│ │ TOC │ │

│ └──────────────────────────────────────────────┘ │

└──────────────────────────────────────────────────┘

tombstones

由于Prometheus Block的数据一般在写完后就不会变动。如果要删除部分数据,就只能记录一下删除数据的范围,由下一次compactor组成新block的时候删除。而记录这些信息的文件即是tomstones。

总结

Prometheus作为时序数据库,设计了各种文件结构来保存海量的监控数据,同时还兼顾了性能。只有彻底了解其存储结构,才能更好的指导我们应用它!

欢迎大家关注我公众号,里面有各种干货,还有大礼包相送哦!

Prometheus时序数据库-磁盘中的存储结构的更多相关文章

- Prometheus时序数据库-内存中的存储结构

Prometheus时序数据库-内存中的存储结构 前言 笔者最近担起了公司监控的重任,而当前监控最流行的数据库即是Prometheus.按照笔者打破砂锅问到底的精神,自然要把这个开源组件源码搞明白才行 ...

- Prometheus时序数据库-数据的插入

Prometheus时序数据库-数据的插入 前言 在之前的文章里,笔者详细的阐述了Prometheus时序数据库在内存和磁盘中的存储结构.有了前面的铺垫,笔者就可以在本篇文章阐述下数据的插入过程. 监 ...

- Prometheus时序数据库-数据的查询

Prometheus时序数据库-数据的查询 前言 在之前的博客里,笔者详细阐述了Prometheus数据的插入过程.但我们最常见的打交道的是数据的查询.Prometheus提供了强大的Promql来满 ...

- 0160 十分钟看懂时序数据库(I)-存储

摘要:2017年时序数据库忽然火了起来.开年2月Facebook开源了beringei时序数据库:到了4月基于PostgreSQL打造的时序数据库TimeScaleDB也开源了,而早在2016年7月, ...

- Prometheus时序数据库-报警的计算

Prometheus时序数据库-报警的计算 在前面的文章中,笔者详细的阐述了Prometheus的数据插入存储查询等过程.但作为一个监控神器,报警计算功能是必不可少的.自然的Prometheus也提供 ...

- Atitit.数据库表的物理存储结构原理与架构设计与实践

Atitit.数据库表的物理存储结构原理与架构设计与实践 1. Oracle和DB2数据库的存储模型如图: 1 1.1. 2. 表数据在块中的存储以及RowId信息3 2. 数据表的物理存储结构 自然 ...

- MySQL索引(二)B+树在磁盘中的存储

MySQL索引(二)B+树在磁盘中的存储 回顾  上一篇文章<MySQL索引为什么要用B+树>讲了MySQL为什么选择用B+树来作为底层存储结构,提了两个知识点: B+树索引并不能直接找 ...

- (续)一个demo弄清楚位图在内存中的存储结构

本来续---数字图像处理之位图在计算机中的存储结构一文,通过参考别人的代码,进行修改和测试终于成功运行. 该实例未使用任何API和相关类,相信如果对此实例能够完全理解那么将有进一步进行数字图像处理的能 ...

- 时序数据库连载系列: 时序数据库一哥InfluxDB之存储机制解析

InfluxDB 的存储机制解析 本文介绍了InfluxDB对于时序数据的存储/索引的设计.由于InfluxDB的集群版已在0.12版就不再开源,因此如无特殊说明,本文的介绍对象都是指 InfluxD ...

随机推荐

- Spring学习笔记2

一.什么是AOP 面向切面编程,通过预编译方式和运行期动态代理实现程序功能的统一维护的一种技术.在不影响原来功能代码的基础上,使用动态代理加入自己需要的一些功能(比如权限的验证,事务的控制,日志的记录 ...

- CF-1445 C - Division 数论,质因数,唯一分解定理

题意 给定一个 \(p (p\le 10^{18})\), 一个 \(q(q \le 10^9)\), 要找到一个最大的 \(x\) 满足: \(p \%x = 0\) \(q \% x \neq 0 ...

- 2019牛客暑期多校训练营(第七场)F-Energy stones(思维+树状数组)

>传送门< 题意:有n块能量石,每秒钟会增加Li的能量,但是一旦增长到了Ci它就不会增长了,它初始的能量为Ei. 现在有若干个时刻ti,会选择下标在[Si,Ti]的能量石吸取它们的能量,这 ...

- 使用 Tye 辅助开发 k8s 应用竟如此简单(二)

续上篇,这篇我们来进一步探索 Tye 更多的使用方法.本篇我们来了解一下如何在 Tye 中使用服务发现. Newbe.Claptrap 是一个用于轻松应对并发问题的分布式开发框架.如果您是首次阅读本系 ...

- CF1400-C. Binary String Reconstruction

CF1400-C. Binary String Reconstruction 题意: 对于一个二进制字符串\(s\),以及一个给定的\(x\),你可以通过一下操作来得到字符串\(w\): 对于字符串\ ...

- windows创建p12格式的ios开发证书的流程

现在做ios开发,原生的开发已经不是第一选择,现在有很多不同的H5开发框架,在性能上都不输原生开发,而UI方便却能做得比原生更炫,比如CSS得灵活度肯定是比原生开发出来得应用更灵活的. 我们在开发IO ...

- shapefile 输出的地理处理注意事项(转载)

来源:http://resources.arcgis.com/zh-cn/help/main/10.1/index.html#//005600000013000000 多年来,Esri 为存储地理信息 ...

- Ruby on Rails

Ruby on Rails 是一个可以使你开发,部署,维护 web 应用程序变得简单的框架.在2004年7月,由Rails的创始人大卫·海纳梅尔·韩森从37signals公司的项目管理工具Baseca ...

- Web 前端如何一键开启上帝模式

Web 前端如何一键开启上帝模式 God Mode document.designMode = `on`; refs https://www.cnblogs.com/xgqfrms/tag/desig ...

- console.clear

console.clear Chrome console.clear && console.clear() refs xgqfrms 2012-2020 www.cnblogs.com ...