回归树(Regression Tree)

说到决策树(Decision tree),我们很自然会想到用其做分类,每个叶子代表有限类别中的一个。但是对于决策树解决回归问题,一直是一知半解,很多时候都是一带而过。

对于一个回归问题,我们第一时间想到的可能就是线性回归(linear regression),当线性回归不好的时候,可能想着用 SVR(Support Vector Regression)试试。但回归树(regression tree)也很重要,现在 shallow learning 被 SVM 和树模型统治,随机森林、GBDT、xgboost、lightGBM 大行其道,所以知道什么是回归树很有必要。

常用的决策树有 ID3、C4.5、CART 等,其中 CART 就可以用来做回归问题,CART 全称就是 Classification And Regression Tree(分类和回归树)。至于 ID3 和 C4.5,能不能用来做回归问题,等了解完 CART 回归树再讨论。

接下来我们介绍将 CART 用于回归问题。

回归树

回归树(regression tree),顾名思义,就是用树模型做回归问题,每一片叶子都输出一个预测值。预测值一般是该片叶子所含训练集元素输出的均值,即 \(c_{m} = ave(y_i | \bm x_i \in leaf_m)\)。

CART 在分类问题和回归问题中的相同和差异:

- 相同:

- 在分类问题和回归问题中,CART 都是一棵二叉树,除叶子节点外的所有节点都有且仅有两个子节点;

- 所有落在同一片叶子中的输入都有同样的输出。

- 差异:

- 在分类问题中,CART 使用基尼指数(Gini index)作为选择特征(feature)和划分(split)的依据;在回归问题中,CART 使用 mse(mean square error)或者 mae(mean absolute error)作为选择 feature 和 split 的 criteria。

- 在分类问题中,CART 的每一片叶子都代表的是一个 class;在回归问题中,CART 的每一片叶子表示的是一个预测值,取值是连续的。

下面以 criteria = 'mse' 为例,介绍 CART 回归树。

理论解释

给定一个数据集 \(D = \{(\bm x_1, y_1), (\bm x_2, y_2), ..., (\bm x_i, y_i), ...,(\bm x_n, y_n)\}\),其中 \(\bm x_i\) 是一个 m 维的向量,即 \(x_i\) 含有 m 个 features。

回归问题的目标就是构造一个函数 \(f(\bm x)\) 能够拟合数据集 \(D\) 中的元素,使得 mse 最小,即:

\[

\min \frac{1}{n} \sum_{i = 1}^{n} (f(\bm x_i) - y_i)^2

\tag{1}

\]

用 CART 进行回归,目标自然也是一样的,最小化 mse。

假设一棵构建好的 CART 回归树有 \(M\) 片叶子,这意味着 CART 将输入空间 \(\bm x\) 划分成了 \(M\) 个单元 \(R_1, R_2, ..., R_M\),同时意味着 CART 至多会有 \(M\) 个不同的预测值。CART 最小化 mse 公式如下:

\[

\min \frac{1}{n} \sum_{m = 1}^{M}\sum_{\bm x_i \in R_m} (c_m - y_i)^2

\tag{2}

\]

其中,\(c_m\) 表示第 \(m\) 片叶子的预测值。

想要最小化 CART 总体的 mse,只需要最小化每一片叶子的 mse 即可,而最小化一片叶子的 mse,只需要将预测值设定为叶子中含有的训练集元素的均值,即:

\[

c_{m} = ave(y_i | \bm x_i \in leaf_m)

\tag{3}

\]

所以,在每一次的划分中,选择切分变量(splitting variable)和切分点(splitting point)时(也就是选择 feature 和将该 feature space 一分为二的 split),使得模型在训练集上的 mse 最小,也就是每片叶子的 mse 之和最小。

这里采用启发式的方法,遍历所有的切分变量和切分点,然后选出 叶子节点 mse 之和最小 的那种情况作为划分。选择第 \(j\) 个 feature \(\bm x^{(j)}\) 和它取的值 \(s\),作为切分变量和切分点,则切分变量和切分点将父节点的输入空间一分为二:

\[

\begin{split}

R_1\{j, s\} = \{\bm x| \bm x^{(j)} \le s\} \\

R_2\{j, s\} = \{\bm x| \bm x^{(j)} > s\}

\end{split}

\tag{4}

\]

CART 选择切分变量 \(j\) 和 切分点 \(s\) 的公式如下:

\[

\min_{j, s} \left[\min_{c_1} \sum_{\bm x_i \in R_1\{j, s\}} (y_i - c_1)^2 + \min_{c_2} \sum_{\bm x_i \in R_2\{j, s\}} (y_i - c_2)^2 \right]

\tag{5}

\]

采取遍历的方式,我们可以将 \(j\) 和 \(s\) 找出来:先固定 feature \(j\) 再选出在该 feature 下的最佳划分 \(s\);对每一个 feature 都这样做,那么有 \(m\) 个feature,我们就能得到 \(m\) 个 feature 对应的最佳划分,从这 \(m\) 个值中取最小值即可得到令全局最优的 \((j, s)\)。式(5)中,第一项 \(\min_{c_1} \sum_{x_i \in R_1\{j, s\}} (y_i - c_1)^2\) 得到的 \(c_1\) 值按照式(3)就是 \(ave(y_i | \bm x_i \in R_1\{j, s\})\),同理,第二项中 \(c_2 = ave(y_i | \bm x_i \in R_2\{j, s\})\) 。

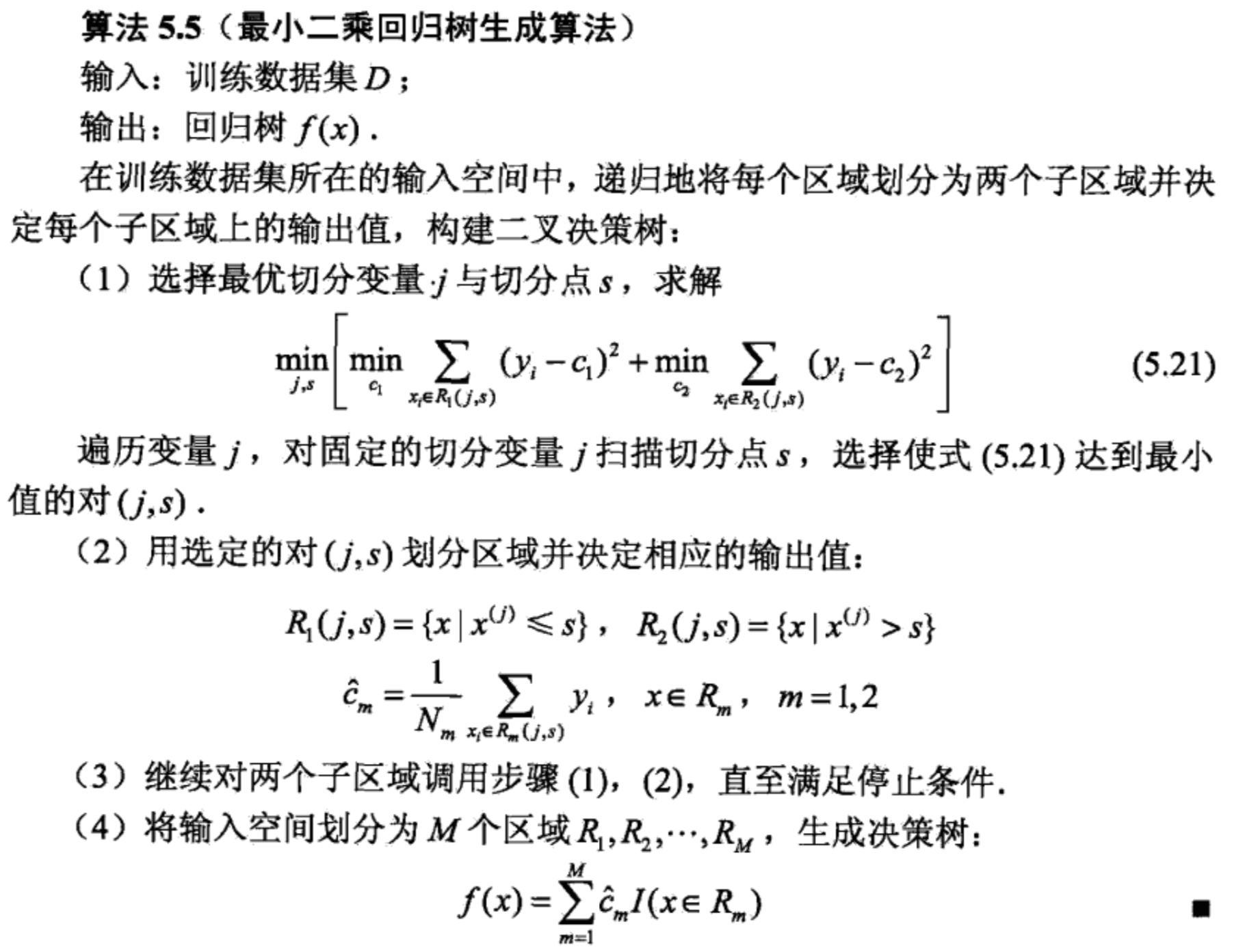

算法流程

ID3 和 C4.5 能不能用来回归?

CART 是一棵二叉树,那么只要回归树不是一棵二叉树,那么就不是 CART 树了。

在分类问题中,ID3、C4.5 和 CART 的区别就在与划分子节点的策略不同,信息增益、增益比、基尼指数;而在回归问题中,criteria 是 mse 或者 mae,这种情况下,分类时的 ID3、C4.5、CART 之间的区别就没了,那么就是每个父节点划分成多少个子节点的问题了,如果还是二叉树,那么就认为是 CART 回归树,否则就不是了。

如果你在同一个时刻对某一个 feature \(\bm x^{(j)}\) 选择两个切分点 \(s_1\) 和 \(s_2\) 来划分父节点,那么就将产生三个区间 \(R_1\{j, s_1\}, R_2\{j, s_1, s_2\}, R_3\{j, s_2\}\),这种做法无疑增大了遍历的难度,如果选择更多个切分点,那么遍历的难度会指数上升。如果我们想要细分多个区域,让 CART 回归树更深即可,这样遍历的难度会小很多。

所以,固然可以构建非 CART 回归树,但是不如 CART 回归树来的更简单。

回归树示例

Decision Tree Regression -- scikit-learn

References

《统计学习方法》-- 李航

Decision Tree Regression -- scikit-learn

回归树(Regression Tree)的更多相关文章

- CART分类与回归树与GBDT(Gradient Boost Decision Tree)

一.CART分类与回归树 资料转载: http://dataunion.org/5771.html Classification And Regression Tree(CART)是决策 ...

- 集成方法:渐进梯度回归树GBRT(迭代决策树)

http://blog.csdn.net/pipisorry/article/details/60776803 单决策树C4.5由于功能太简单.而且非常easy出现过拟合的现象.于是引申出了很多变种决 ...

- 用决策树模型求解回归问题(regression tree)

How do decision trees for regression work? 决策树模型既可以求解分类问题(对应的就是 classification tree),也即对应的目标值是类别型数据, ...

- 利用CART算法建立分类回归树

常见的一种决策树算法是ID3,ID3的做法是每次选择当前最佳的特征来分割数据,并按照该特征所有可能取值来切分,也就是说,如果一个特征有四种取值,那么数据将被切分成4份,一旦按某特征切分后,该特征在之后 ...

- CART分类与回归树 学习笔记

CART:Classification and regression tree,分类与回归树.(是二叉树) CART是决策树的一种,主要由特征选择,树的生成和剪枝三部分组成.它主要用来处理分类和回归问 ...

- class-决策树Decision Tree

顾名思义,决策树model是树形结构,在分类中,表示基于特征对实例进行分类的过程.可以认为是"if-else"的合集,也可以认为是特征空间,类空间上条件概率分布.主要优点是分类速度 ...

- CART决策树(分类回归树)分析及应用建模

一.CART决策树模型概述(Classification And Regression Trees) 决策树是使用类似于一棵树的结构来表示类的划分,树的构建可以看成是变量(属性)选择的过程,内部节 ...

- 决策树的剪枝,分类回归树CART

决策树的剪枝 决策树为什么要剪枝?原因就是避免决策树“过拟合”样本.前面的算法生成的决策树非常的详细而庞大,每个属性都被详细地加以考虑,决策树的树叶节点所覆盖的训练样本都是“纯”的.因此用这个决策树来 ...

- 【机器学习】迭代决策树GBRT(渐进梯度回归树)

一.决策树模型组合 单决策树C4.5由于功能太简单,并且非常容易出现过拟合的现象,于是引申出了许多变种决策树,就是将单决策树进行模型组合,形成多决策树,比较典型的就是迭代决策树GBRT和随机森林RF. ...

随机推荐

- Java并发-对象共享

我们不仅希望防止某个线程正在使用对象状态而其他的线程正在修改该状态,而且希望当一个线程修改了对象状态后,其他的线程能够看到发生的状态变化. 可见性:当读操作和写操作在不同的线程中进行时,他们的动作是共 ...

- Urlparse模块

urlparse模块主要是把url拆分为6部分,并返回元组.并且可以把拆分后的部分再组成一个url.主要有函数有urljoin.urlsplit.urlunsplit.urlparse等. urlpa ...

- UE4学习心得:蓝图间信息通信的几种方法

蓝图间通信是一个复杂关卡能否正常运行的关键,笔者在这里提供几种蓝图类之间的信息交互方法,希望能对读者有所帮助. 1.类引用 这是最直接的一种蓝图类之间的信息交互方式.首先在Editor中创建2个Act ...

- 分布式消息队列XXL-MQ

<分布式消息队列XXL-MQ> 一.简介 1.1 概述 XXL-MQ是一款轻量级分布式消息队列,支持串行.并行和广播等多种消息模型.现已开放源代码,开箱即用. 支持三种消息模式: ...

- 解决0% [Waiting for headers] 导致的unable to lock the administration directory (/var/lib/dpkg/) is another process using it

这是我在配置vim的YouCompleteMe时遇到的问题,我需要使用CMake来编译YCM. 在我输入 $ sudo apt install cmake 由于网络原因导致安装一直卡在0% [Wait ...

- IP路由及静态路由配置

IP路由及静态路由配置 qianghaohao(CodingNutter) 链接来源:http://www.cnblogs.com/codingnutter/p/5654271.html 一.IP路由 ...

- MySQL事务的的介绍及使用

事务的特性 1.原子性(Atomicity):原子性是指事务是一个不可分割的工作单位,事务中的操作要么都发生,要么都不发生. 2.一致性(Consistency):在一个事务中,事务前后数据的完整性必 ...

- 0513JS数组遍历、内置方法、训练

一.定义一个数组把其中的偶数取出,组成一个新的数组 var attr = [9,34,80,27,56]; var attr1 = []; for(var i in attr){ if(attr[i] ...

- ubuntu18.04安装搜狗拼音

1.下载好搜狗安装包http://pinyin.sogou.com/linux/ ,注意位数! 2.打开终端安装依赖 sudo apt install libfcitx-qt0 3.提取下载好的 ...

- 怎么解决你的小程序有“bug”的问题?

为了避免小程序在开发运行之后出现"bug"无法知晓,Fundebug研发的小程序bug监控服务作为小程序的运维中心,很好的解决了这个问题. 该插件可以监控小程序中的所有函数调用: ...