Seq2Seq模型与注意力机制

Seq2Seq模型

基本原理

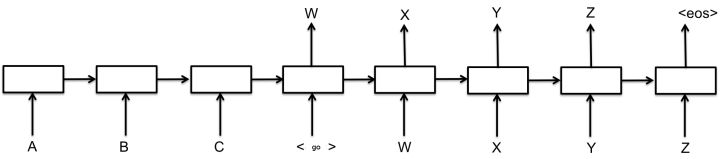

- 核心思想:将一个作为输入的序列映射为一个作为输出的序列

- 编码输入

- 解码输出

- 解码第一步,解码器进入编码器的最终状态,生成第一个输出

- 以后解码器读入上一步的输出,生成当前步输出

- 组成部件:

- Encoder

- Decoder

- 连接两者的固定大小的State Vector

解码方法

- 最核心部分,大部分的改进

- 贪心法

- 选取一种度量标准后,在当前状态下选择最佳的一个结果,直到结束

- 计算代价低

- 局部最优解

- 选取一种度量标准后,在当前状态下选择最佳的一个结果,直到结束

- 集束搜索(Beam Search)

- 启发式算法

- 保存beam size个当前较佳选择,决定了计算量,8~12最佳

- 解码时每一步根据保存的结果选择下一步扩展和排序,选择前beam size个保存

- 循环迭代,直到结束。选择最佳结果输出

- 改进

- 堆叠RNN

- Dropout机制

- 与编码器之间建立残差连接

- 注意力机制

- 记忆网络

注意力机制

Seq2Seq模型中的注意力机制

- 在实际发现,随着输入序列增长,模型性能发生显著下降

- 小技巧

- 将源语言句子逆序输入,或者重复输入两遍,得到一定的性能提升

- 解码时当前词及对应的源语言词的上下文信息和位置信息在编解码过程中丢失了

- 引入注意力机制解决上述问题:

- 解码时,每一个输出词都依赖于前一个隐状态以及输入序列每一个对应的隐状态

\[s_i = f(s_{i-1}, y_{i-1},c_i)\]

\[p(y_i|y_1,\cdots,y_{i-1})=g(y_{i-1},s_i,c_i)\]

其中,\(y\)是输出词,\(s\)是当前隐状态,\(f,g\)是非线性变换,通常为神经网络 - 语境向量\(c_i\)是输入序列全部隐状态\(h_1,\cdots,h_T\)的加权和

\[c_i=\sum \limits_{j=1}^T a_{ij}h_j \]

\[a_{ij} = \frac{\exp(e_{ij})}{\sum_k \exp(e_{ij})} \]

\[e_{ij}=a(s_{i-1},h_j) \] - 神经网络\(a\)将上一个输出序列隐状态\(s_{i-1}\)和输入序列隐状态\(h_j\)作为输入,计算出一个\(x_j,y_i\)对齐的值\(e_{ij}\)

- 考虑每个输入词与当前输出词的对齐关系,对齐越好的词,会有更大权重,对当前输出影响更大

- 双向循环神经网络

- 单方向:\(h_i\)只包含了\(x_0\)到\(x_i\)的信息,\(a_{ij}\)丢失了\(x_i\)后面的信息

双方向:第\(i\)个输入词对应的隐状态包括了\(\overrightarrow{h}_i\)和\(\overleftarrow{h}_i\),前者编码了\(x_0\)到\(x_i\)的信息,后者编码了\(x_i\)及之后的信息,防止信息丢失

- 解码时,每一个输出词都依赖于前一个隐状态以及输入序列每一个对应的隐状态

常见Attention形式

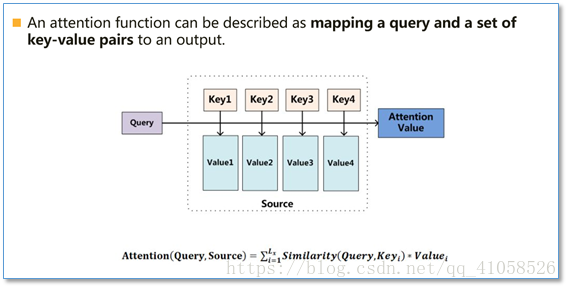

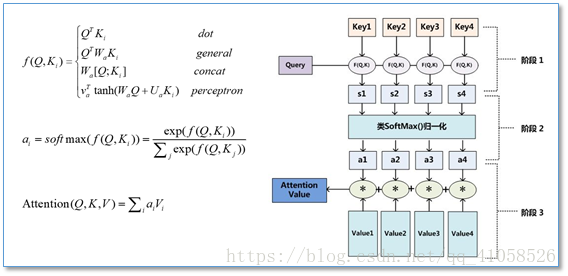

本质:一个查询(query)到一系列(键key-值value)对的映射

- 计算过程

- 将query和每个key进行相似度计算得到权重,常用的相似度函数有点积,拼接,感知机等

- 使用一个softmax函数对这些权重进行归一化

- 权重和相应的键值value进行加权求和得到最后的attention

Seq2Seq模型与注意力机制的更多相关文章

- 深度学习教程 | Seq2Seq序列模型和注意力机制

作者:韩信子@ShowMeAI 教程地址:http://www.showmeai.tech/tutorials/35 本文地址:http://www.showmeai.tech/article-det ...

- 深度学习之seq2seq模型以及Attention机制

RNN,LSTM,seq2seq等模型广泛用于自然语言处理以及回归预测,本期详解seq2seq模型以及attention机制的原理以及在回归预测方向的运用. 1. seq2seq模型介绍 seq2se ...

- 吴恩达《深度学习》-第五门课 序列模型(Sequence Models)-第三周 序列模型和注意力机制(Sequence models & Attention mechanism)-课程笔记

第三周 序列模型和注意力机制(Sequence models & Attention mechanism) 3.1 序列结构的各种序列(Various sequence to sequence ...

- Pytorch系列教程-使用Seq2Seq网络和注意力机制进行机器翻译

前言 本系列教程为pytorch官网文档翻译.本文对应官网地址:https://pytorch.org/tutorials/intermediate/seq2seq_translation_tutor ...

- DeepLearning.ai学习笔记(五)序列模型 -- week2 序列模型和注意力机制

一.基础模型 假设要翻译下面这句话: "简将要在9月访问中国" 正确的翻译结果应该是: "Jane is visiting China in September" ...

- ng-深度学习-课程笔记-17: 序列模型和注意力机制(Week3)

1 基础模型(Basic models) 一个机器翻译的例子,比如把法语翻译成英语,如何构建一个神经网络来解决这个问题呢? 首先用RNN构建一个encoder,对法语进行编码,得到一系列特征 然后用R ...

- Coursera Deep Learning笔记 序列模型(三)Sequence models & Attention mechanism(序列模型和注意力机制)

参考 1. 基础模型(Basic Model) Sequence to sequence模型(Seq2Seq) 从机器翻译到语音识别方面都有着广泛的应用. 举例: 该机器翻译问题,可以使用" ...

- DLNg第三周:序列模型和注意力机制

1.基础模型 将法语翻译为英语,分为编码和解码阶段,将一个序列变为另一个序列.即序列对序列模型. 从图中识别出物体的状态,将图片转换为文字. 先使用CNN处理图片,再使用RNN将其转换为语言描述. 2 ...

- NLP教程(6) - 神经机器翻译、seq2seq与注意力机制

作者:韩信子@ShowMeAI 教程地址:http://www.showmeai.tech/tutorials/36 本文地址:http://www.showmeai.tech/article-det ...

随机推荐

- js判断当前时区【TimeZone】是否是夏令时

var d1 = new Date(2009, 0, 1); var d2 = new Date(2009, 6, 1); if (d1.getTimezoneOffset() != d2.getTi ...

- [Luogu] 受欢迎的牛

https://www.luogu.org/problemnew/show/P2341 Tarjan 缩点 + 判断出度 #include <iostream> #include < ...

- 好久木来了,一直忙于项目(加懒惰),今天讲讲vuecli3.0的使用

vue更新换代很快,马上vue都要出3.0了,这是一个巨大的变革,不过今天讲的是vuecli3.0,里面使用的vue仍然是2的,所有可以放心大胆使用. Vue CLI 是一个基于 Vue.js 进行快 ...

- Smali语法基础

Smali是什么 Smali是Android虚拟机的反汇编语言. 我们都知道,Android代码一般是用java编写的,执行java程序一般需要用到java虚拟机,在Android平台上也不例外,但是 ...

- AT2306 Rearranging

有一个显然的,就是不互质的数的相对位置是不会改变的,那么我们把它们放到一个连通块里面去,然后我交换就是交换两个里面最小的对吧.直接连起来然后跑\(TopSort\)就行了. #include<s ...

- 深入理解WebRTC

Web Real-Time Communication(Web实时通信,WebRTC)由一组标准.协议和JavaScript API组成,用于实现浏览器之间(端到端)的音频.视频及数据共享. WebR ...

- ListView / GirdView Adpater的getView方法,首项多次调用

通过Adapter为AbslistView提供内容是一个常见的做法:在ListView或者GridView的Adapter中的getView()方法中,加入一行日志,看getView()被调用的情况 ...

- redis5种数据结构讲解及使用场景

string list hash set zset 探究 Redis 4 的 stream 类型 redis提供了5中数据结构,理解每种数据结构的特点对于redis开发运维非常重要. 一.字符 ...

- OR(Convex_Optimization_读书杂记)

今天心血来潮,看了一下ConvexOptimization,看到一开始描述直线的部分,真的感觉翻译得很棒.$$ y = \theta x_1 + (1-\theta) x_2 \qquad x1, ...

- OAuth 2.0 的四种方式

上一篇文章介绍了 OAuth 2.0 是一种授权机制,主要用来颁发令牌(token).本文接着介绍颁发令牌的实务操作. 下面我假定,你已经理解了 OAuth 2.0 的含义和设计思想,否则请先阅读这个 ...