创建function实现hive表结果导出到mysql

1. 创建临时function (这里两个包都是hive自带的,不需要自己开发的,可以根据名称查找对应的版本)

add jar /opt/local/hive/lib/hive-contrib-2.3..jar;

add jar /opt/local/hive/lib/mysql-connector-java-5.1.-bin.jar; CREATE TEMPORARY FUNCTION dboutput AS 'org.apache.hadoop.hive.contrib.genericudf.example.GenericUDFDBOutput';

2. dboutput使用方法

select dboutput(jdbc数据库链接, 用户名, 密码, sql语句, hive字段值) from hive表

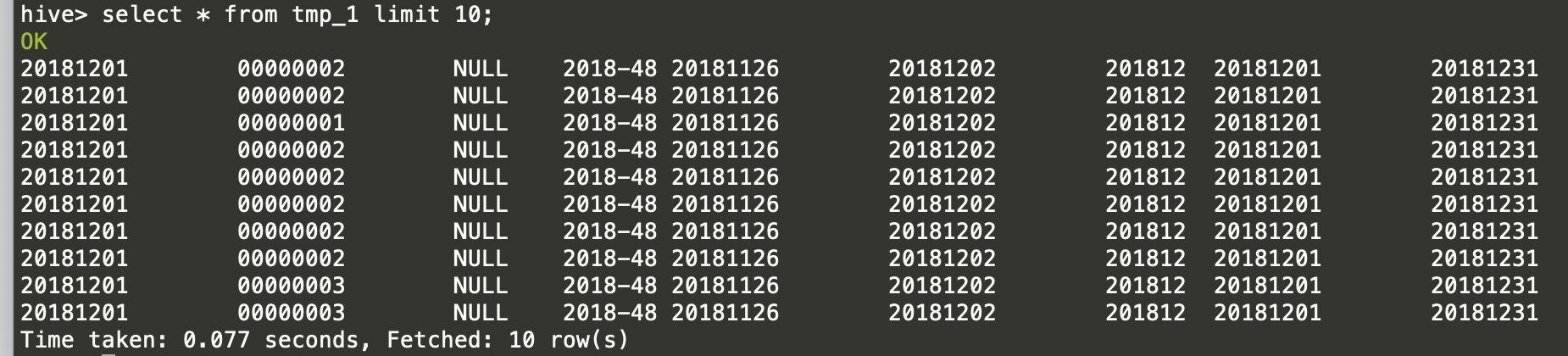

准备一张hive表记录如下,然后在mysql中创建相同字段的表.

根据上面到规则,完整的hive脚本如下, 保存到script.q文件中:

--定义临时function,用于导出到mysql

add jar /opt/local/hive/lib/hive-contrib-2.3..jar;

add jar /opt/local/hive/lib/mysql-connector-java-5.1.-bin.jar;

CREATE TEMPORARY FUNCTION dboutput AS 'org.apache.hadoop.hive.contrib.genericudf.example.GenericUDFDBOutput'; --查询hive并将结果写入mysql

select dboutput('${url}','${username}','${password}',

'INSERT INTO dm_index_pv_uv

(dt,tenantcode,deviceid,bourse_week,week_begin,week_end, yrmm, month_begin, month_end)

VALUES(?,?,?,?,?,?,?,?,?)',

dt,tenantcode,deviceid,bourse_week,week_begin,week_end, yrmm, month_begin, month_end

)from dw_stg.tmp_1 where dt=${dt};

这里只能insert into记录,无法删除。下面这种写法是错误的

select dboutput('${url}','${username}','${password}',

'delete from dm_index_pv_uv where dt=${dt};##这行错误!!

INSERT INTO dm_index_pv_uv

(dt,tenantcode,deviceid,bourse_week,week_begin,week_end, yrmm, month_begin, month_end)

VALUES(?,?,?,?,?,?,?,?,?)',

dt,tenantcode,deviceid,bourse_week,week_begin,week_end, yrmm, month_begin, month_end

)from dw_stg.tmp_1 where dt=${dt};

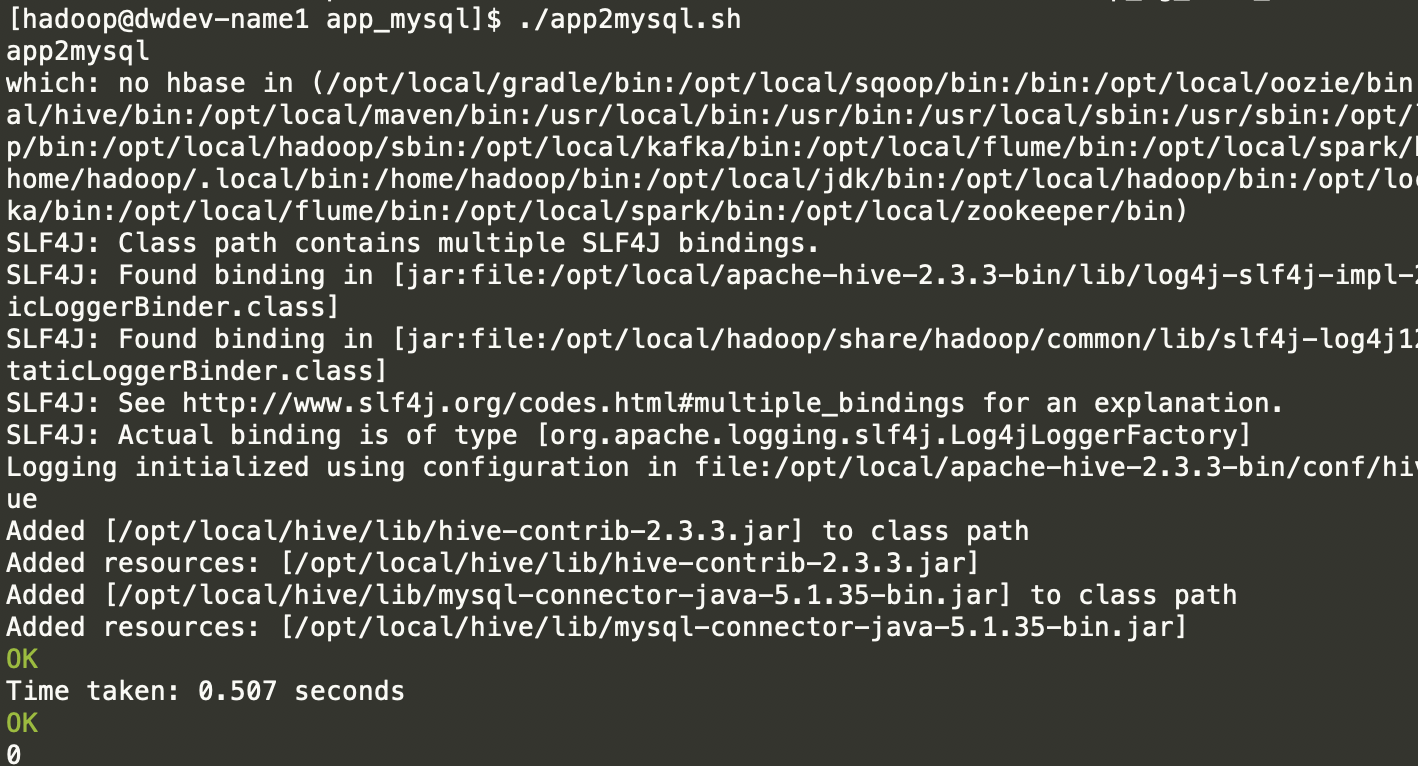

使用hive -f脚本执行。

#!/bin/sh

echo 'app2mysql' hive -f script.q \

-hivevar dt= \

-hivevar url=jdbc:mysql://dwdev-name2/bigdata \

-hivevar username=mysql \

-hivevar password=123456

执行过程如下:

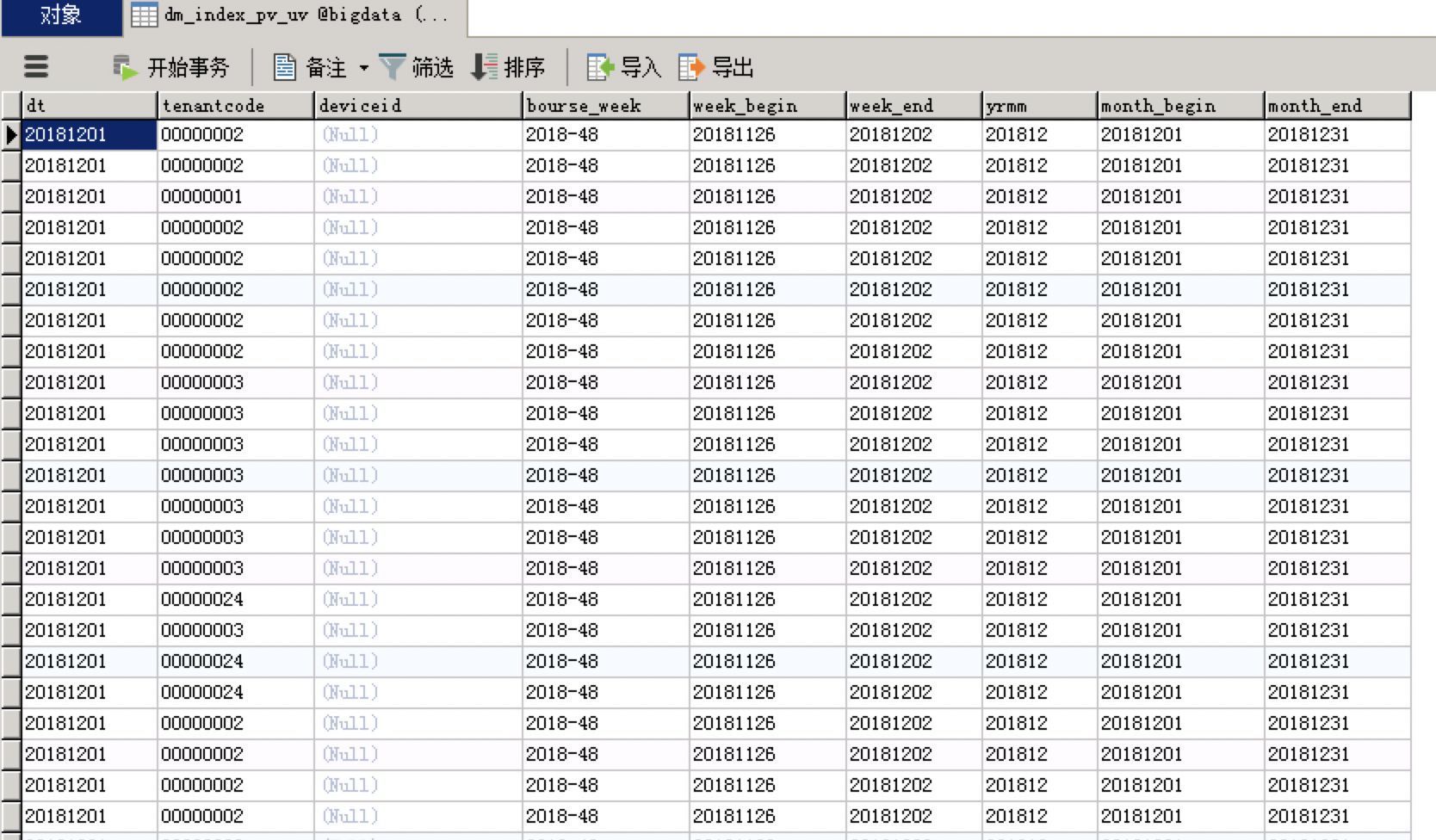

查看mysql 中记录:

一般数据量不大的情况下,可以直接使用,还是比较方便的。省去了使用sqoop或者自己开发的麻烦。

创建function实现hive表结果导出到mysql的更多相关文章

- 从hive将数据导出到mysql(转)

从hive将数据导出到mysql http://abloz.com 2012.7.20 author:周海汉 在上一篇文章<用sqoop进行mysql和hdfs系统间的数据互导>中,提到s ...

- hive表数据导出到csv乱码原因及解决方案

转载自http://blog.csdn.net/lgdlxc/article/details/42126225 Hive表中的数据使用hive - e"select * from table ...

- 根据JSON创建对应的HIVE表

本文提供一种用SCALA把JSON串转换为HIVE表的方法,由于比较简单,只贴代码,不做解释.有问题可以留言探讨 package com.gabry.hiveimport org.json4s._im ...

- hive表增量抽取到mysql(关系数据库)的通用程序(三)

hive表增量抽取到oracle数据库的通用程序(一) hive表增量抽取到oracle数据库的通用程序(二) 这几天又用到了该功能了,所以又改进了一版,增加了全量抽取和批量抽取两个参数.并且可以设置 ...

- Hive表数据导出

方式一: hadoop命令导出 hadoop fs -get hdfs://hadoop000:8020/data/page_views2 pv2 方式二:通过insert...directory导 ...

- 将Hive统计分析结果导入到MySQL数据库表中(一)——Sqoop导入方式

https://blog.csdn.net/niityzu/article/details/45190787 交通流的数据分析,需求是对于海量的城市交通数据,需要使用MapReduce清洗后导入到HB ...

- 利用sqoop将hive数据导入导出数据到mysql

一.导入导出数据库常用命令语句 1)列出mysql数据库中的所有数据库命令 # sqoop list-databases --connect jdbc:mysql://localhost:3306 ...

- 使用 sqoop 将mysql数据导入到hive表(import)

Sqoop将mysql数据导入到hive表中 先在mysql创建表 CREATE TABLE `sqoop_test` ( `id` ) DEFAULT NULL, `name` varchar() ...

- flume的sink写入hive表

flume的配置文件如下: a1.sources=r1 a1.channels=c1 a1.sinks=s1 a1.sources.r1.type=netcat a1.sources.r1.bind= ...

随机推荐

- Redis介绍及安装

官网:https://redis.io/ Redis中文社区:http://www.redis.net.cn/ Redis教程:http://www.redis.net.cn/tutorial/350 ...

- ISO GPS定位,坐标转换以及如何显示

这个写的公共类叫做:GPScombineClass类主要展示GPS位置的定位,GPS坐标的获取,然后从手机坐标转换成火星坐标,继而在需要的情况下,由火星转百度 ,百度转火星的详细算法: 在GPSc ...

- ios block一定会犯的几个错误

贴几段斯坦福大学关于gcd的代码,这段代码逐步演示了如何修正错误,其中用到的既是串行队列 1.这个是原始代码 - (void)viewWillAppear:(BOOL)animated { NSD ...

- 事件,委托,action与func文章不错的

https://www.cnblogs.com/yinqixin/p/5056307.html https://www.cnblogs.com/BLoodMaster/archive/2010/07/ ...

- Debugging the Java HotSpot VM

Open Heart Surgery: Analyzing and Debugging the Java HotSpot VM at the OS Level https://www.youtube. ...

- IBM研究院找到度量安全性方法:容器与虚拟机,谁更安全?

https://zhuanlan.zhihu.com/p/40446759 虚拟机比容器更安全吗?你可能会有自己的答案,但IBM研究院发现容器的安全性与虚拟机一样,甚至更加安全. 一般来说,从接口宽度 ...

- 模拟 SQLSERVER 死锁

环境: sqlserver 2008 事务(进程 ID (n))与另一个进程被死锁在锁资源上,并且已被选作死锁牺牲品.请重新运行 死锁原理: 如两个任务 任务1,已经锁定R1,再进行请求R2& ...

- 使用HttpClient配置代理服务器模拟浏览器发送请求调用接口测试

在调用公司的某个接口时,直接通过浏览器配置代理服务器可以请求到如下数据: 请求url地址:http://wwwnei.xuebusi.com/rd-interface/getsales.jsp?cid ...

- 使用PostgreSQL遇到的一个问题[column does not exist]字段不存在:

表结构: 在我上面的表结构中,明明有一个叫做"fromdeviceId"的字段,但是查询的时候却提示找不到该字段: 仔细观察错误信息,发现,我的字段明明是有一个大写字母(fromd ...

- VMware vCenter 资源池

VMware vCenter 资源池 1.简介 资源池是灵活管理资源的逻辑抽象.资源池可以分组为层次结构,用于对可用的 CPU 和内存资源按层次结构进行分区. 每台独立主机和每个DRS 群集都具有一个 ...