Python脚本模拟登陆DVWA

目录

环境:python3.7 windows

requests模拟登陆

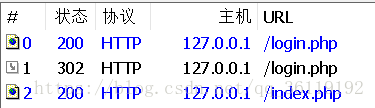

我们登陆DVWA的时候,看似只有一步:访问网站,输入用户名和密码,登陆成功则跳转到新页面。

其实这中间分了三步。

1、访问网站的瞬间,浏览器会先向网站的登录页面发送GET请求,然后服务器会返回带有 token 和 cookies 的信息给浏览器

2、浏览器收到服务器返回的信息后,从中提取token和cookie。

当我们输入用户名和密码登录页面的时候,这次请求信息包含了我们输入的用户名和密码还有之前提取到的cookie和token信息。

如果输入的用户名和密码正确的话,服务器回复302重定向,将浏览器重定向到index.php页面。

如果输入的用户名和密码错误的话,服务器回复302重定向,将浏览器重定向到login.php登录页面

3、如果用户名和密码正常,浏览器发送GET请求,请求index.php页面

如果用户名和密码错误,浏览器发送GET请求,请求login.php页面

所以,我们用python模拟登录DVWA的时候,先模拟向服务器发送登录请求,然后提取出服务器返回的 token 和 cookie。再利用获得到的cookie和token结合我们的用户名和密码进行登录。

代码实现:

# -*- coding: utf-8 -*-

"""

Created on Sat Oct 6 17:01:15 2018

@author: 小谢

"""

import urllib

import requests

from bs4 import BeautifulSoup

##第一步,先访问 http://127.0.0.1/login.php页面,获得服务器返回的cookie和token

def get_cookie_token():

headers={'Host':'127.0.0.1',

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64; rv:55.0) Gecko/20100101 Firefox/55.0',

'Accept':'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Lanuage':'zh-CN,zh;q=0.8,en-US;q=0.5,en;q=0.3',

'Connection':'keep-alive',

'Upgrade-Insecure-Requests':'1'}

res=requests.get("http://127.0.0.1/login.php",headers=headers)

cookies=res.cookies

a=[(';'.join(['='.join(item)for item in cookies.items()]))] ## a为列表,存储cookie和token

html=res.text

soup=BeautifulSoup(html,"html.parser")

token=soup.form.contents[3]['value']

a.append(token)

return a

a=get_cookie_token() ##a列表中存储了服务器返回的cookie和toke

##第二步模拟登陆

def Two():

headers={'Host':'127.0.0.1',

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64; rv:55.0) Gecko/20100101 Firefox/55.0',

'Accept':'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Lanuage':'zh-CN,zh;q=0.8,en-US;q=0.5,en;q=0.3',

'Connection':'keep-alive',

'Content-Length':'88',

'Content-Type':'application/x-www-form-urlencoded',

'Upgrade-Insecure-Requests':'1',

'Cookie':a[0],

'Referer':'http://127.0.0.1/login.php'}

values={'username':'admin',

'password':'password',

'Login':'Login',

'user_token':a[1]

}

data=urllib.parse.urlencode(values)

resp=requests.post("http://127.0.0.1/login.php",data=data,headers=headers)

return

Two()

#重定向到index.php

headers={'Host':'127.0.0.1',

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64; rv:55.0) Gecko/20100101 Firefox/55.0',

'Accept':'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Lanuage':'zh-CN,zh;q=0.8,en-US;q=0.5,en;q=0.3',

'Connection':'keep-alive',

'Upgrade-Insecure-Requests':'1',

'Cookie':a[0],

'Referer':'http://127.0.0.1/login.php'}

response=requests.get("http://127.0.0.1/index.php",headers=headers)

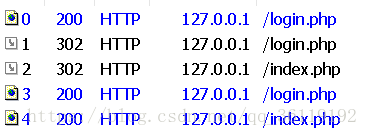

print(response.text)实际用python模拟的话,他会多发两个包,具体为什么多发包我也不是很清楚,但是最后效果是达到了。成功用python模拟登录了DVWA。

Selenium自动化测试登陆

代码实现:

# -*- coding: utf-8 -*-

"""

Created on Sun Oct 7 16:35:22 2018

@author: 小谢

"""

from selenium import webdriver

import time

driver=webdriver.Chrome("G:\Anaconda3-5.3.0\chromedriver.exe")

print("Login DVWA GO!")

driver.get("http://127.0.0.1/login.php")

print("get web in ")

time.sleep(3)

driver.find_element_by_name("username").send_keys("admin") ##找到输入用户名的input框,并且输入用户名

driver.find_element_by_name("password").send_keys("password") ##找到输入密码的input框,并且输入密码

driver.find_element_by_name("Login").click()

print("登录成功...")

time.sleep(10) ##登录成功后延时十秒退出

driver.close()Python脚本模拟登陆DVWA的更多相关文章

- Python实现模拟登陆

大家经常会用Python进行数据挖掘的说,但是有些网站是需要登陆才能看到内容的,那怎么用Python实现模拟登陆呢?其实网路上关于这方面的描述很多,不过前些日子遇到了一个需要cookie才能登陆的网站 ...

- 【小白学爬虫连载(10)】–如何用Python实现模拟登陆网站

Python如何实现模拟登陆爬取Python实现模拟登陆的方式简单来说有三种:一.采用post请求提交表单的方式实现.二.利用浏览器登陆网站记录登陆成功后的cookies,采用get的请求方式,传入c ...

- python爬虫模拟登陆

python爬虫模拟登陆 学习了:https://www.cnblogs.com/chenxiaohan/p/7654667.html 用的这个 学习了:https://www.cnblogs.co ...

- python+requests模拟登陆 学校选课系统

最近学校让我们选课,每天都有不同的课需要选....然后突发奇想试试用python爬学校选课系统的课程信息 先把自己的浏览器缓存清空,然后在登陆界面按f12 如图: 可以看到登陆时候是需要验证码的,验证 ...

- Python 爬虫模拟登陆知乎

在之前写过一篇使用python爬虫爬取电影天堂资源的博客,重点是如何解析页面和提高爬虫的效率.由于电影天堂上的资源获取权限是所有人都一样的,所以不需要进行登录验证操作,写完那篇文章后又花了些时间研究了 ...

- python爬虫 模拟登陆校园网-初级

最近跟同学学习爬虫的时候看到网上有个帖子,好像是山大校园网不稳定,用py做了个模拟登陆很有趣,于是我走上了一条不归路..... 先上一张校园网截图 首先弄清一下模拟登陆的原理: 1:服务器判定浏览器登 ...

- Python脚本模拟僵尸进程与孤儿进程

最近一台机器的systemd内存高达30%多,一直不变,后来排查是僵尸进程,什么是僵尸进程呢,只能google,百度等先了解,然后自己总结了一下,虽然这是基础的东西,但是对于我来说就如新大陆一样.花了 ...

- Python作业模拟登陆(第一周)

模拟登陆:1. 用户输入帐号密码进行登陆2. 用户信息保存在文件内3. 用户密码输入错误三次后锁定用户 思路: 1. 用户名密码文件为passwd,锁定用户文件为lock 2. 用户输入账号密码采用i ...

- python selenium模拟登陆163邮箱。

selenium是可以模拟浏览器操作. 有些爬虫是异步加载的,通过爬取网页源码是得不到需要的内容.所以可以模拟浏览器去登陆该网站进行爬取操作. 需要安装selenium通过pip install xx ...

随机推荐

- Linux速通 大纲

1.Linux操作系统安装及初始化配置(熟悉) 2.Linux操作系统目录组成结构及文件级增删改查操作(重点) 3.Linux操作系统用户.权限管理(重点) 4.开源软件及Linux下软件包的管理(重 ...

- 微服务分布式事务之LCN、TCC

在亿级流量架构之分布式事务解决方案对比中, 已经简单阐明了从本机事务到分布式事务的演变过程, 文章的最后简单说明了TCC事务, 这儿将会深入了解TCC事务是原理, 以及理论支持, 最后会用Demo举例 ...

- LeetCode 175. Combine Two Tables 【MySQL中连接查询on和where的区别】

一.题目 175. Combine Two Tables 二.分析 连接查询的时候要考虑where和on的区别 where : 查询时,连接的时候是必须严格满足条件的,满足了才会加入到临时表中. on ...

- Codeforces Round #541 F. Asya And Kittens

题面: 传送门 题目描述: Asya把N只(从1-N编号)放到笼子里面,笼子是由一行N个隔间组成.两个相邻的隔间有一个隔板. Asya每天观察到有一对想一起玩,然后就会把相邻的隔间中的隔板取出来,使两 ...

- 2019 GDUT Rating Contest I : Problem B. Teamwork

题面: 传送门 B. Teamwork Input file: standard input Output file: standard output Time limit: 1 second Memor ...

- python基础之流程控制(2)

今天将是基础篇的最后一篇,咱们来补上最后一个内容,流程控制for循环 For 循环 一.为什么有for循环? for循环能做的事情,while循环全都可以实现,但是在某些情境下,for循环相对于whi ...

- Java 学习记录

•Eclipse相关 Eclipse常用设置 解决 Eclipse 项目中有红色感叹号的详细方法(图文) JRE System Library [JavaSE-1.8](unbound) •Java ...

- Android学习之服务初体验

•概念 Service(服务)是一个长期运行在后台,没有用户界面的应用组件,即使切换到另一个应用程序或者后台,服务也可以正常运行: 因此,服务适合执行一些不需要显示界面的后台耗时操作,比如下载网络数据 ...

- (原创)高DPI适配经验系列:(一)缩放比例与DPI对应关系

一.前言 当下,2K分辨率已成为主流标配,3K.4K也已经广泛应用. 在屏幕尺寸不变的情况下,高分辨率也就意味着高DPI,对于桌面程序而言,除了先天就支持高DPI的框架外(如UWP.Electron等 ...

- Distributed | MapReduce

最近终于抽出时间开始学习MIT 6.824,本文为我看MapReduce论文和做lab后的总结. [MapReduce英文论文] lab要用到go语言,这也是我第一次接触.可以参考go语言圣经学习基本 ...