爬虫入门【10】Pyspider框架简介及安装说明

Pyspider是python中的一个很流行的爬虫框架系统,它具有的特点如下:

1、可以在Python环境下写脚本

2、具有WebUI,脚本编辑器,并且有项目管理和任务监视器以及结果查看。

3、支持多种数据库

4、支持定义任务优先级,自动重试链接。。。

5、分布式架构

等等优点。

pyspider的设计基础是:以python脚本驱动的抓取环模型爬虫。

教程: http://docs.pyspider.org/en/latest/tutorial/

文档: http://docs.pyspider.org/

发布版本: https://github.com/binux/pyspider/releases

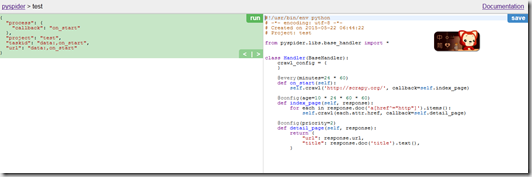

入门范例

from pyspider.libs.base_handler import *

class Handler(BaseHandler):

crawl_config = {

}

@every(minutes=24 * 60)

def on_start(self):

self.crawl('http://scrapy.org/', callback=self.index_page)

@config(age=10 * 24 * 60 * 60)

def index_page(self, response):

for each in response.doc('a[href^="http"]').items():

self.crawl(each.attr.href, callback=self.detail_page)

def detail_page(self, response):

return {

"url": response.url,

"title": response.doc('title').text(),

}

【插入图片,Pyspider界面】

代码简单介绍

def on_start(self):

这是脚本的入口节点,当我们点击run的时候,程序会自动调用这个函数。

self.crawl(url, callback=self.index_page):

这时最重要的API,将会添加新任务,大部分选项使用crawl的参数来指定。

def index_page(self, response):

这个方法得到一个response对象,然后通过PyQuery的doc命令来解析。

def detail_page(self, response):

返回一个dict对象作为结果。这个结果可以保存到数据库中。

我们还可以在脚本中自定义函数或者对象。

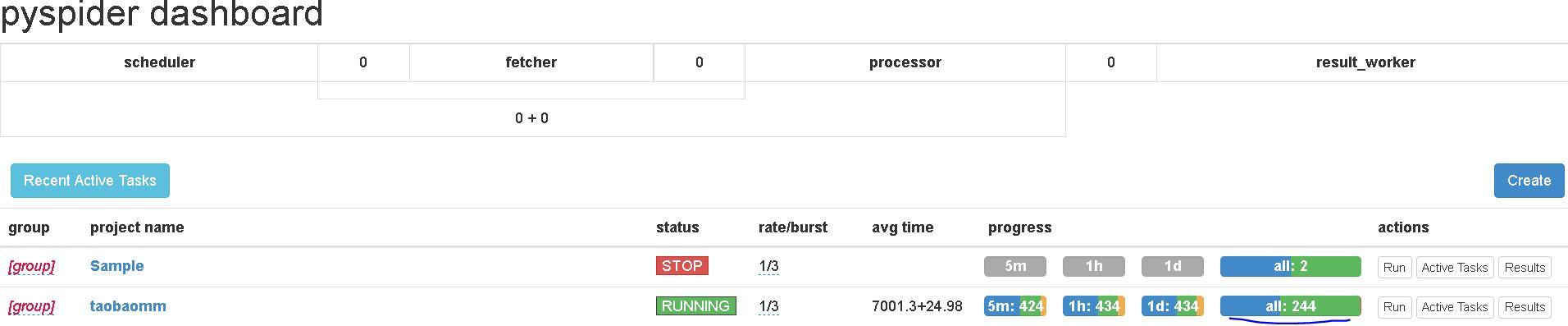

【插入图片,运行界面】

安装

推荐使用Pycharm,在Project Interpreter里面添加pyspider,目前最新的版本是0.3.9.

或者使用pip命令安装。

今天来不及把整个项目内容讲完了,明天继续。

爬虫入门【10】Pyspider框架简介及安装说明的更多相关文章

- 爬虫基础(五)-----scrapy框架简介

---------------------------------------------------摆脱穷人思维 <五> :拓展自己的视野,适当做一些眼前''无用''的事情,防止进入只关 ...

- 爬虫开发7.scrapy框架简介和基础应用

scrapy框架简介和基础应用阅读量: 1432 scrapy 今日概要 scrapy框架介绍 环境安装 基础使用 今日详情 一.什么是Scrapy? Scrapy是一个为了爬取网站数据,提取结构性数 ...

- 10.scrapy框架简介和基础应用

今日概要 scrapy框架介绍 环境安装 基础使用 今日详情 一.什么是Scrapy? Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架,非常出名,非常强悍.所谓的框架就是一个已经被 ...

- python爬虫入门(六) Scrapy框架之原理介绍

Scrapy框架 Scrapy简介 Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量,用户只需要定制开发几个模块就可以轻松的实现一个爬 ...

- 爬虫入门之Scrapy 框架基础功能(九)

Scrapy是用纯Python实现一个为了爬取网站数据.提取结构性数据而编写的应用框架,用途非常广泛. 框架的力量,用户只需要定制开发几个模块就可以轻松的实现一个爬虫,用来抓取网页内容以及各种图片,非 ...

- python爬虫入门10分钟爬取一个网站

一.基础入门 1.1什么是爬虫 爬虫(spider,又网络爬虫),是指向网站/网络发起请求,获取资源后分析并提取有用数据的程序. 从技术层面来说就是 通过程序模拟浏览器请求站点的行为,把站点返回的HT ...

- 人工智能 tensorflow框架-->简介及安装01

简介:Tensorflow是google于2015年11月开源的第二代机器学习框架. Tensorflow名字理解:图形边中流动的数据叫张量(Tensor),因此叫Tensorflow 既 张量流动 ...

- 爬虫入门之Scrapy框架实战(新浪百科豆瓣)(十二)

一 新浪新闻爬取 1 爬取新浪新闻(全站爬取) 项目搭建与开启 scrapy startproject sina cd sina scrapy genspider mysina http://roll ...

- 爬虫入门之Scrapy框架基础框架结构及腾讯爬取(十)

Scrapy终端是一个交互终端,我们可以在未启动spider的情况下尝试及调试代码,也可以用来测试XPath或CSS表达式,查看他们的工作方式,方便我们爬取的网页中提取的数据. 如果安装了 IPyth ...

随机推荐

- 轻松学,浅析依赖倒置(DIP)、控制反转(IOC)和依赖注入(DI) 依赖注入和控制反转的理解,写的太好了。

轻松学,浅析依赖倒置(DIP).控制反转(IOC)和依赖注入(DI) 2017年07月13日 22:04:39 frank909 阅读数:14269更多 所属专栏: Java 反射基础知识与实战 ...

- photoshop 动作 自己定义快捷键 播放选定的动作

今天在制作一组效果图.要用到动作.而且是同一个动作,便在网上寻找"播放选定的动作"就是那个三角形播放button的快捷键. 预期这样会大大加快制作过程. 首先制作好动作. 然后,在 ...

- Ant—使用Ant构建简单Java项目(三)

博客<Ant-使用Ant构建简单Java项目(二)>我们简化了运行Test类中main方法须要运行的命令,本博客来介绍一下如何使build.xml文件和当中使用property标签定义的属 ...

- Linux 基础学习(第二节)

free命令用于显示当前系统中内存的使用量信息,格式为:“free [-h]”. 为了保证Linux系统不会突然卡住宕机,因此内存使用量应该是运维人员时刻要关注的数据啦,咱们可以使用-h参数来以更人性 ...

- zookeeper(二):linux centos下安装zookeeper(单机和集群)

下载 http://zookeeper.apache.org/releases.html 解压 tar –zxvf zookeeper-3.4.6.tar.gz 解压文件到"/usr/loc ...

- NGUI ScrollView中的Bounds

获取到的Bounds值是固定的,是因为Bounds区域的计算是被动计算,需要主动调用使其刷新 scrollView.InvalidateBounds(); 另外Bounds的Min和Max似乎和NGU ...

- linux下时间操作1

本文是对我之前写的文章:C++时间操作 的更深入补充.之前那个文章就是一个快速入门的东西,后面力图把一些更深入的细节补充完整. 时间分类的基本介绍 在介绍一些时间相关的操作函数之前,先来介绍一下lin ...

- 1.2.3 Task and Back Stack - 任务和回退堆

一个应用通常包含多个Activities.每个activity的设计应该围绕着某种指定类型的action,如果这样做了,用户就可以执行该action,也可以用它来开启另外的activity.例如,邮件 ...

- WebService 页面重定向错误

“/”应用程序中的服务器错误. 由于连接方在一段时间后没有正确答复或连接的主机没有反应,连接尝试失败. xxx.xxx.xxx.xxx:xx 说明: 执行当前 Web 请求期间,出现未经处理的异常.请 ...

- P3P解决cookie跨域

P3P是什么 P3P(Platform for Privacy Preferences)是W3C公布的一项隐私保护推荐标准,以为用户提供隐私保护. P3P标准的构想是:Web 站点的隐私策略应该告 ...