spark集群安装配置

spark集群安装配置

一. Spark简介

Spark是一个通用的并行计算框架,由UCBerkeley的AMP实验室开发。Spark基于map reduce 算法模式实现的分布式计算,拥有Hadoop MapReduce所具有的优点;但不同于Hadoop MapReduce的是Job中间输出和结果可以保存在内存中,从而不再需要读写HDFS,节省了磁盘IO耗时,性能比Hadoop更快。 所以,相对来说Hadoop更适合做批处理,而Spark更适合做需要反复迭代的机器学习。下面是我在ubuntu14.04中配置Spark的整个流程以及遇到的问题的,一方面当做自己的备忘录,另一方面也希望能够给像我一样初次配置的新手提供一些帮助~╮(╯▽╰)╭

二. 安装配置

2.1 准备工作

注意:确保你之前已经安装配置好了hadoop集群(YARN方式),可以参考我的另一篇博文:Linux中安装配置hadoop集群

我所使用的环境:

ubuntu 14.04 LTS 计算机两台,一个当作Master,一个作slave。

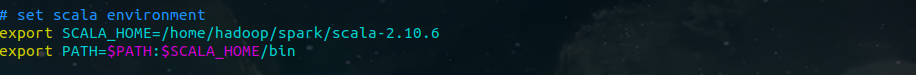

Scala版本:scala-2.10.6

Hadoop版本:hadoop-2.7.1

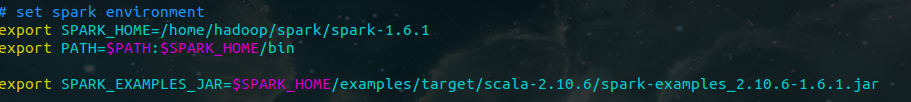

Spark版本:spark-1.6.1 (记得下载预编译版本的)

我的安装目录:

Scala:/home/hadoop/spark/scala-2.10.6

Spark:/home/hadoop/spark/spark-1.6.1

Java:/home/javafile/jdk1.7.0_79

2.2 具体安装步骤

1. 安装scala

1 2 tar zxvf scala-2.10.6.tgz

然后,修改:/etc/profile

2. 安装Spark

同样,还是先去Spark官网下载:spark-1.6.1-bin-hadoop2.6.tgz,解压到:/home/hadoop/spark下;

1 cd /home/hadoop/spark

2 tar zxvf spark-1.6.1-bin-hadoop2.6.tgz

然后,修改:/etc/profile

3. 配置Spark

01. 修改配置文件spark-env.sh

1 cd /home/hadoop/spark/spark-1.6.1/conf

2 cp spark-env.sh.template spark-env.sh

修改spark-env.sh如下:

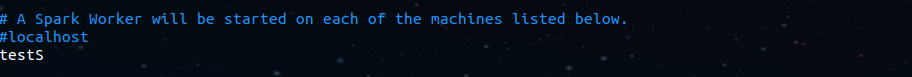

02. 修改配置文件slaves

在slaves中添加你的slave主机名:我只有一个slave,所以只添加了一个。

03. 配置slave

至此,master节点上的Spark已配置完毕。把master上Spark相关配置copy到slave中。(注意,三台机器spark所在目录必须一致,因为master会登陆到worker上执行命令,master认为worker的spark路径与自己一样)

三. 启动Spark

3.1 启动

启动命令非常简单:

1 cd /home/hadoop/spark/spark-1.6.1

2 sbin/start-all.sh

3.2 验证Spark是否启动成功

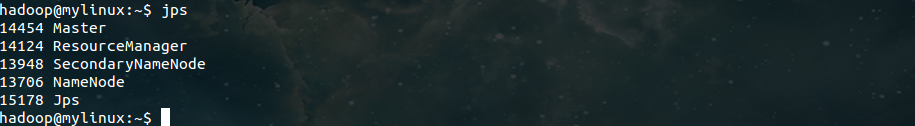

使用 jps 命令,查看master和slave上的进程:

master:

slave:

进入Spark的Web管理页面: http://master:8080 (将master替换成你的master主机名即可)

四. 总结

至此,Spark集群的安装配置就完成了,有什么不对的地方还请大家指正,一起交流讨论~

参考:

http://www.tuicool.com/articles/MbuaUv

http://wuchong.me/blog/2015/04/04/spark-on-yarn-cluster-deploy/

http://www.ibm.com/developerworks/cn/opensource/os-cn-spark-deploy1/index.html

spark集群安装配置的更多相关文章

- Hadoop2.2集群安装配置-Spark集群安装部署

配置安装Hadoop2.2.0 部署spark 1.0的流程 一.环境描写叙述 本实验在一台Windows7-64下安装Vmware.在Vmware里安装两虚拟机分别例如以下 主机名spark1(19 ...

- CentOS下Hadoop-2.2.0集群安装配置

对于一个刚开始学习Spark的人来说,当然首先需要把环境搭建好,再跑几个例子,目前比较流行的部署是Spark On Yarn,作为新手,我觉得有必要走一遍Hadoop的集群安装配置,而不仅仅停留在本地 ...

- [bigdata] spark集群安装及测试

在spark安装之前,应该已经安装了hadoop原生版或者cdh,因为spark基本要基于hdfs来进行计算. 1. 下载 spark: http://mirrors.cnnic.cn/apache ...

- 大数据技术之_19_Spark学习_01_Spark 基础解析 + Spark 概述 + Spark 集群安装 + 执行 Spark 程序

第1章 Spark 概述1.1 什么是 Spark1.2 Spark 特点1.3 Spark 的用户和用途第2章 Spark 集群安装2.1 集群角色2.2 机器准备2.3 下载 Spark 安装包2 ...

- CentOS6安装各种大数据软件 第十章:Spark集群安装和部署

相关文章链接 CentOS6安装各种大数据软件 第一章:各个软件版本介绍 CentOS6安装各种大数据软件 第二章:Linux各个软件启动命令 CentOS6安装各种大数据软件 第三章:Linux基础 ...

- Spark入门:第2节 Spark集群安装:1 - 3;第3节 Spark HA高可用部署:1 - 2

三. Spark集群安装 3.1 下载spark安装包 下载地址spark官网:http://spark.apache.org/downloads.html 这里我们使用 spark-2.1.3-bi ...

- 3 Spark 集群安装

第3章 Spark集群安装 3.1 Spark安装地址 1.官网地址 http://spark.apache.org/ 2.文档查看地址 https://spark.apache.org/docs/2 ...

- hbase单机环境的搭建和完全分布式Hbase集群安装配置

HBase 是一个开源的非关系(NoSQL)的可伸缩性分布式数据库.它是面向列的,并适合于存储超大型松散数据.HBase适合于实时,随机对Big数据进行读写操作的业务环境. @hbase单机环境的搭建 ...

- hive集群安装配置

hive 是JAVA写的的一个数据仓库,依赖hadoop.没有安装hadoop的,请参考http://blog.csdn.net/lovemelovemycode/article/details/91 ...

随机推荐

- Windows Phone 8初学者开发—第12部分:改进视图模型和示例数据

原文 Windows Phone 8初学者开发—第12部分:改进视图模型和示例数据 第12部分:改进视图模型和示例数据 原文地址:http://channel9.msdn.com/Series/Win ...

- UNIX 缩写风格

构建于图形界面之上的操作系统,使用鼠标作为主输入设备, 是否使用缩写并不重要.比如 Windows 系统中的目录,几乎都是全称…… 点击两次鼠标进入文件夹 pf, 并不意味着点击13次才能进入文件夹 ...

- icon-font自己探索得到的经验

1. 引入的时候字体类型分为:

- Linux下批量转换文件编码

find -iname "*.java" -exec enca {} + |grep -v ASCI |grep -v -i utf |awk -F':' '{print $1}' ...

- POJ 2455 Secret Milking Machine(搜索-二分,网络流-最大流)

Secret Milking Machine Time Limit: 1000MS Memory Limit: 65536K Total Submissions: 9658 Accepted: ...

- TCP/IP之坚持定时器、报活定时器

TCP中的四个定时器: 1.超时定时器(最复杂的一个) 2.坚持定时器 3.保活定时器 4.2MSL定时器 坚持定时器用于防止通告窗口为0以后c/s双方相互等待死锁的情况:而保活定时器则用于处理半开发 ...

- ThreadLocal 和 InheritableThreadLocal (引用)

ThreadLocal:http://www.cnblogs.com/moonandstar08/p/4912673.html InheritableThreadLocal: http://www. ...

- iPhone开发技巧之日志保存教程

http://mobile.51cto.com/iphone-283337.htm Objective-C开发程序的时候,有专门的日志操作类NSLog,它将指定的输出到标准的错误输出上(stderr) ...

- 第2次增加ssh 主机信任脚本

dr-mysql01:/root# cat a1.sh #用户名 uname="$1" #密码 passwd="$2" #执行检测并安装expect模块 ep= ...

- zabbix 添加主机接口

http://192.168.32.101:3000/api/zabbix/add_Host?env=test&host=zjtest9-app&ip=192.168.32.250&a ...