Big Data(三)伪分布式和完全分布式的搭建

关于伪分布式的配置全程

伪分布式图示

1.安装VMWare WorkStation,直接下一步,输入激活码即可安装

2.安装Linux(需要100GB)

引导分区Boot200MB

交换分区Swap2048MB

其余分配到/

3.配置网络服务

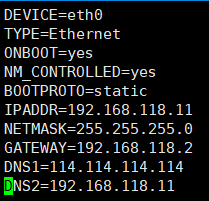

vim /etc/sysconfig/network-scripts/ifcfg-eth0

DEVICE=eth0

TYPE=Ethernet

ONBOOT=yes

NM_CONTROLLED=yes

BOOTPROTO=static

IPADDR=192.168.118.11

NETMASK=255.255.255.0

GATEWAY=192.168.118.2

DNS1=114.114.114.114

DNS2=192.168.118.11

注意点:

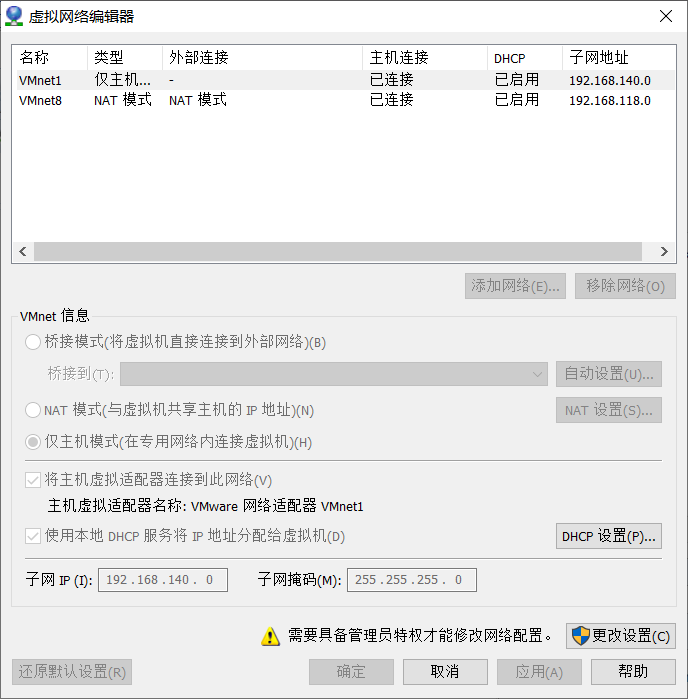

1.关于IPADDR的前三个网关,要与虚拟网络编辑器的VMnet8的子网IP的前三个网关一样

2.关于GATEWAY要与NAT下的GATEWAY一样,详情如下

虚拟网络编辑器:在VMWare编辑下打开

点击NAT设置,查看GATEWAY

4.修改主机名称

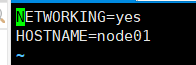

vi /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=node01

5.设置Host(关于Host,是指IP和主机名的映射关系)

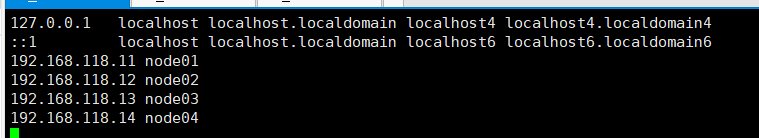

vi /etc/hosts

192.168.150.11 node01

192.168.150.12 node02

6.关闭防火墙,开机不启动防火墙

service iptables stop

chkconfig iptables off

7.关闭selinux(selinux是Linux下一种安全模式,打开可能会连不上XShell)

vi /etc/selinux/config

SELINUX=disabled

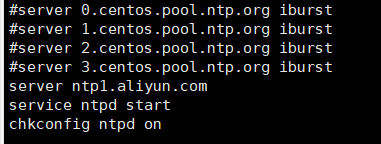

8.时间同步

使用yum安装ntp,并把原有的server注释,替换成

server ntp1.aliyun.com

service ntpd start

chkconfig ntpd on

9.安装jdk,使用xftp上传rpm文件

jdk-8u181-linux-x64.rpm

修改JAVA_HOME

vi /etc/profile

export JAVA_HOME=/usr/java/default

export PATH=$PATH:$JAVA_HOME/bin

source /etc/profile

10.安装ssh免密

(1)检验ssh是否可以登录

ssh localhost

需要输入密码,则不免密

(2)设置免密

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

ssh-keygen -t dsa表示使用dsa算法加密 -p ''表示密码为空 -f ~/ .ssh/id_dsa 将公钥放在/home/.ssh/id_dsa下

不能自己私自创建目录,关于ssh的目录权限,必须为755或者700,不能是777,否则不能使用免密

11.安装Hadoop

mkdir /opt/bigdata

tar xf hadoop-2.6..tar.gz

mv hadoop-2.6. /opt/bigdata/

pwd

/opt/bigdata/hadoop-2.6.

设置Hadoop的环境变量

vi /etc/profile

export JAVA_HOME=/usr/java/default

export HADOOP_HOME=/opt/bigdata/hadoop-2.6.

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

source /etc/profile

12.修改hadoop-env.sh,此文件为hadoop启动脚本,将JAVA_HOME改为具体的环境变量

cd $HADOOP_HOME/etc/hadoop

vi hadoop-env.sh

export JAVA_HOME=/usr/java/default

13.给出NN角色在哪里启动vi core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://node01:9000</value>

</property>

14.配置一个hdfs副本

<!-- 副本数量为1 -->

<property>

<name>dfs.replication</name>

<value></value>

</property>

<!-- NameNode的路径-->

<property>

<name>dfs.namenode.name.dir</name>

<value>/var/bigdata/hadoop/local/dfs/name</value>

</property>

<!-- DataNode的路径-->

<property>

<name>dfs.datanode.data.dir</name>

<value>/var/bigdata/hadoop/local/dfs/data</value>

</property>

<!-- SecondaryNameNode在哪个端口启动-->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>node01:</value>

</property>

<!-- SecondaryNameNode的路径-->

<property>

<name>dfs.namenode.checkpoint.dir</name>

<value>/var/bigdata/hadoop/local/dfs/secondary</value>

</property>

15.配置Slave

vi slaves

node01

16.初始化&启动

hdfs namenode -format

创建目录,并且初始化一个空的fsimage

VERSION CID

start-dfs.sh

17.修改windows: C:\Windows\System32\drivers\etc\hosts(注意这边IP要与端口一样)

192.168.150.11 node01

192.168.150.12 node02

192.168.150.13 node03

192.168.150.14 node04

18.简单创建目录

hdfs dfs -mkdir /bigdata

hdfs dfs -mkdir -p /user/root

19.HDFS的常见命令

hadoop fs == hdfs dfs 命令的执行要在bin目录下

例:./hadoop fs -ls /

hadoop fs -ls / 查看

hadoop fs -lsr

hadoop fs -mkdir /user/haodop 创建文件夹

hadoop fs -put a.txt /user/hadoop 上传到hdfs

hadoop fs -get /user/hadoop/a.txt 从hdfs下载

hadoop fs -cp src dst 复制

hadoop fs -mv src dst 移动

hadoop fs -cat /user/hadoop/a.txt 查看文件内容

hadoop fs -rm /user/hadoop/a.txt 删除文件

hadoop fs -rmr /user/hadoop 删除文件夹

hadoop fs -text /user/hadoop/a.txt 查看文件内容

hadoop fs -copyFromLocal localsrc dst 与hadoop fs -put功能类似

hadoop fs -moveFromLocal localsrc dst 将本地文件上传到hdfs,同时删除本地文件

、帮助命令查看 hadoop帮助命令查看,不需要输入help,只需要在bin目录下输入即可。

例:./hadoop

./hadoop fs

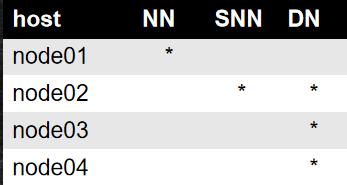

关于完全分布式的修改

完全分布式图示

1.建立4台Linux主机

2.修改自己的主机名和网关

vim /etc/sysconfig/network-scripts/ifcfg-eth0

IPADDR分配4个不一样的IP

分配4个主机名

vim /etc/sysconfig/network

3.重启网卡

service network restart

4.重启网卡要记住删除文件

rm -f /etc/udev/rules.d/-persistent-net.rules

5.文件命令

scp xxx node:0x/xx scp是一种远程拷贝

6.`pwd`可以在另一台主机同样位置进行定位

Big Data(三)伪分布式和完全分布式的搭建的更多相关文章

- Hadoop三种安装模式:单机模式,伪分布式,真正分布式

Hadoop三种安装模式:单机模式,伪分布式,真正分布式 一 单机模式standalone单 机模式是Hadoop的默认模式.当首次解压Hadoop的源码包时,Hadoop无法了解硬件安装环境,便保守 ...

- 单机,伪分布式,完全分布式-----搭建Hadoop大数据平台

Hadoop大数据——随着计算机技术的发展,互联网的普及,信息的积累已经到了一个非常庞大的地步,信息的增长也在不断的加快.信息更是爆炸性增长,收集,检索,统计这些信息越发困难,必须使用新的技术来解决这 ...

- 使用Docker搭建Hadoop集群(伪分布式与完全分布式)

之前用虚拟机搭建Hadoop集群(包括伪分布式和完全分布式:Hadoop之伪分布式安装),但是这样太消耗资源了,自学了Docker也来操练一把,用Docker来构建Hadoop集群,这里搭建的Hado ...

- 三、Linux部署MinIO分布式集群

MinIO的官方网站非常详细,以下只是本人学习过程的整理 一.MinIO的基本概念 二.Windows安装与简单使用MinIO 三.Linux部署MinIO分布式集群 四.C#简单操作MinIO 一. ...

- 第三百四十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—爬虫数据保存

第三百四十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—爬虫数据保存 注意:数据保存的操作都是在pipelines.py文件里操作的 将数据保存为json文件 spider是一个信号检测 ...

- 第三百三十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—深度优先与广度优先原理

第三百三十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—深度优先与广度优先原理 网站树形结构 深度优先 是从左到右深度进行爬取的,以深度为准则从左到右的执行(递归方式实现)Scrapy默认 ...

- Ping CAP CTO、Codis作者谈redis分布式解决方案和分布式KV存储

此文根据[QCON高可用架构群]分享内容,由群内[编辑组]志愿整理,转发请注明出处. 苏东旭,Ping CAP CTO,Codis作者 开源项目Codis的co-author黄东旭,之前在豌豆荚从事i ...

- Elastic Stack之ElasticSearch分布式集群yum方式搭建

Elastic Stack之ElasticSearch分布式集群yum方式搭建 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.搜索引擎及Lucene基本概念 1>.什么 ...

- 3.高并发教程-基础篇-之分布式全文搜索引擎elasticsearch的搭建

高并发教程-基础篇-之分布式全文搜索引擎elasticsearch的搭建 如果大家看了我的上一篇<2.高并发教程-基础篇-之nginx+mysql实现负载均衡和读写分离>文章,如果能很好的 ...

- 分布式文件系统FastDFS简介、搭建、与SpringBoot整合实现图片上传

之前大学时搭建过一个FastDFS的图片服务器,当时只是抱着好奇的态度搭着玩一下,当时搭建采用了一台虚拟机,tracker和storage服务在一台机器上放着,最近翻之前的博客突然想着在两台机器上搭建 ...

随机推荐

- vuefor循环

<!DOCTYPE html><html lang="en"><head> <meta charset="UTF-8" ...

- PDFCrop裁剪PDF文档使用方法

使用VISIO画图,然后生成PDF文档插入到LaTeX文档中,会出现黑边框的问题.通过对PDF文件进行裁剪可以去掉黑边框,之前我是通过Acrobat进行裁剪,后来激活失效了..只好找其他方法.今天发现 ...

- Android地图开发获取sHA1值方法

public static String sHA1(Context context) { try { PackageInfo info = context.getPackageManager().ge ...

- Javadoc常见的标记和含义

1.@param 方法参数的说明 2.@return 对 方法返回值的说明 3.@throws 方法抛出异常的描述 4.@version模块的版本号 5.see参数转向 6.@deprecated标记 ...

- Git入门之常用命令(转载阮一峰老师)

流程图 下面是我整理的常用 Git 命令清单.几个专用名词的译名如下. Workspace:工作区 Index / Stage:暂存区 Repository:仓库区(或本地仓库) Remote:远程仓 ...

- CentOS7环境下yum方式安装MySQL5.7

这篇博文主要是从网上摘抄的,做个记录,以后如果有同样的需求,可以直接翻自己的记录.感谢两位大神: https://www.cnblogs.com/luohanguo/p/9045391.html ht ...

- zk 两阶段提交(待完善)

zk 节点是一个 QuorumPeer,选举结束后,leader 和 follower 各自执行自己的逻辑: org.apache.zookeeper.server.quorum.QuorumPeer ...

- JavaScript日常学习5

JavaScript字符串属性和方法 eg :var txt = "ABCDEFGHIJKLMNOPQRSTUVWXYZ"; var sln = txt.length; ...

- Web09_MySQL多表&JDBC

使用JDBC发送insert语句完成单表[添加]操作 使用JDBC发送update语句完成单表[更新]操作 使用JDBC发送delete语句完成单表[删除]操作 使用JDBC发送select语句完成单 ...

- java:easyui(jQueryEasyUI,分页)

1.介绍: jQuery EasyUI是一组基于jQuery的UI插件集合体,而jQuery EasyUI的目标就是帮助web开发者更轻松的打造出功能丰富并且美观的UI界面.开发者不需要编写复杂的ja ...