高斯混合模型参数估计的EM算法

介绍摘自李航《统计学习方法》

EM算法

EM算法是一种迭代算法,1977年由Dempster等人总结提出,用于含有隐变量(hidden variable)的概率模型参数的极大似然估计,或极大后验概率估计。EM算法的每次迭代由两步组成:E步,求期望(expectation);M步,求极大(maximization)。所以这一算法称为期望极大算法(expectation maximization algorithm),简称EM算法。本章首先叙述EM算法,然后讨论EM算法的收敛性;作为EM算法的应用,介绍高斯混合模型的学习;最后叙述EM算法的推广——GEM算法。

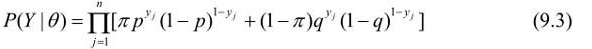

将观测数据表示为Y=(Y1,Y2,…,Yn)T,未观测数据表示为Z=(Z1,Z2,…,Zn)T,则观测数据的似然函数为

即

考虑求模型参数 =(

=( Π,p,q)的极大似然估计,即

Π,p,q)的极大似然估计,即

这个问题没有解析解,只有通过迭代的方法求解。EM算法就是可以用于求解这个问题的一种迭代算法。下面给出针对以上问题的EM算法,其推导过程省略。

EM算法首先选取参数的初值,记作 (0)=(

(0)=( Π(0),p(0),q(0)),然后通过下面的步骤迭代计算参数的估计值,直至收敛为止。第i次迭代参数的估计值为

Π(0),p(0),q(0)),然后通过下面的步骤迭代计算参数的估计值,直至收敛为止。第i次迭代参数的估计值为 (i)=(

(i)=( (i),p(i),q(i))。EM算法的第i+1次迭代如下。

(i),p(i),q(i))。EM算法的第i+1次迭代如下。

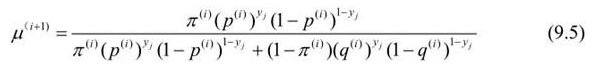

E步:计算在模型参数Π (i),p(i),q(i)下观测数据yj来自掷硬币B的概率

(i),p(i),q(i)下观测数据yj来自掷硬币B的概率

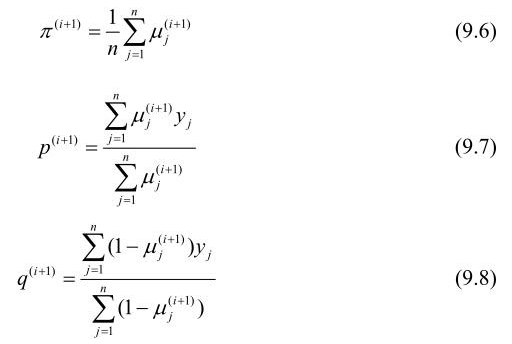

M步:计算模型参数的新估计值

M步:计算模型参数的新估计值

EM算法在高斯混合模型学习中的应用

EM算法的一个重要应用是高斯混合模型的参数估计。高斯混合模型应用广泛,在许多情况下,EM算法是学习高斯混合模型(Gaussian misture model)的有效方法。

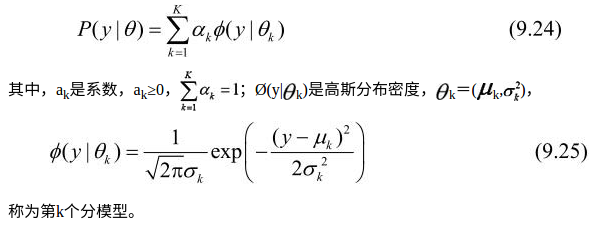

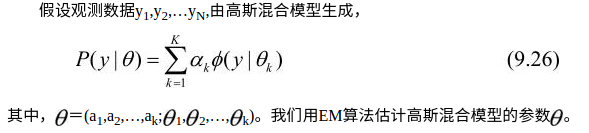

定义9.2(高斯混合模型) 高斯混合模型是指具有如下形式的概率分布模型:

高斯混合模型参数估计的EM算法

1.明确隐变量,写出完全数据的对数似然函数

可以设想观测数据yj,j=1,2,…,N,是这样产生的:首先依概率ak选择第k个高斯分布分模型Ø(y| θk);然后依第k个分模型的概率分布Ø(y|

θk);然后依第k个分模型的概率分布Ø(y| θk)生成观测数据yj。这时观测数据yj,j=1,2,…,N,是已知的;反映观测数据yj来自第k个分模型的数据是未知的,k=1,2,…,K,以隐变量

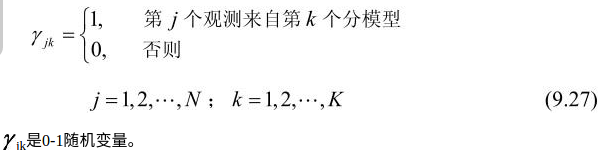

θk)生成观测数据yj。这时观测数据yj,j=1,2,…,N,是已知的;反映观测数据yj来自第k个分模型的数据是未知的,k=1,2,…,K,以隐变量 γjk表示,其定义如下:

γjk表示,其定义如下:

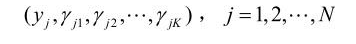

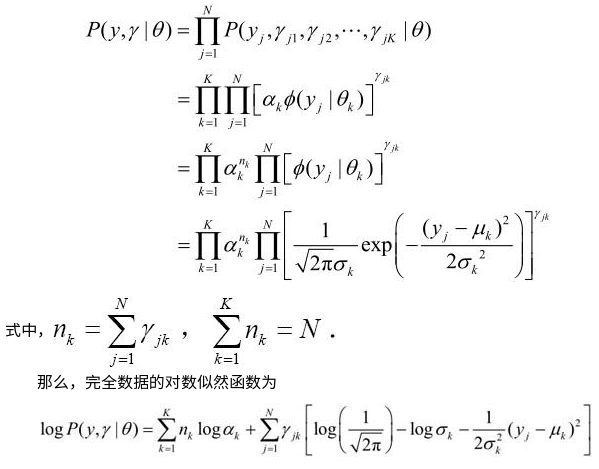

有了观测数据yj及未观测数据γ jk,那么完全数据是

jk,那么完全数据是

于是,可以写出完全数据的似然函数:

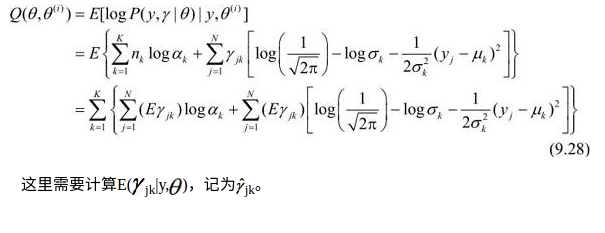

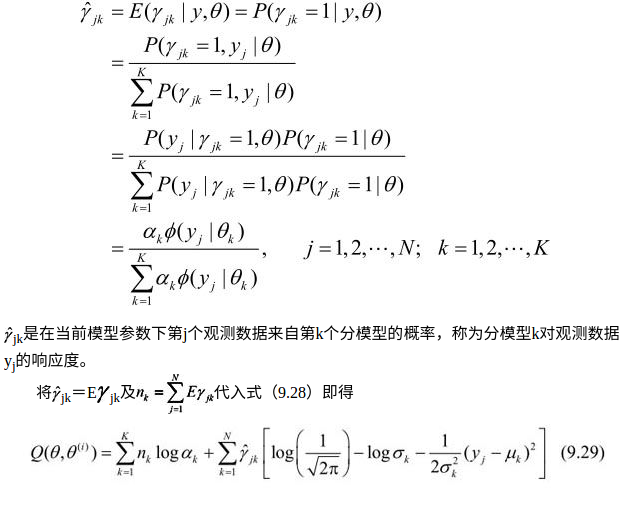

2.EM算法的E步:确定Q函数

3.确定EM算法的M步

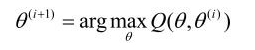

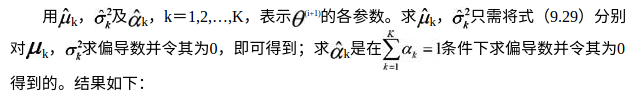

迭代的M步是求函数Q( θ,θ

θ,θ (i))对

(i))对 的极大值,即求新一轮迭代的模型参数:

的极大值,即求新一轮迭代的模型参数:

重复以上计算,直到对数似然函数值不再有明显的变化为止。

# coding:utf-8

import numpy as np def qq(y,alpha,mu,sigma,K,gama):#计算Q函数

gsum=[]

n=len(y)

for k in range(K):

gsum.append(np.sum([gama[j,k] for j in range(n)]))

return np.sum([g*np.log(ak) for g,ak in zip(gsum,alpha)])+\

np.sum([[np.sum(gama[j,k]*(np.log(1/np.sqrt(2*np.pi))-np.log(np.sqrt(sigma[k]))-1/2/sigma[k]*(y[j]-mu[k])**2))

for j in range(n)] for k in range(K)]) #《统计学习方法》中公式9.29有误 def phi(mu,sigma,y): #计算phi

return 1/(np.sqrt(2*np.pi*sigma)*np.exp(-(y-mu)**2/2/sigma)) def gama(alpha,mu,sigma,i,k): #计算gama

sumak=np.sum([[a*phi(m,s,i)] for a,m,s in zip(alpha,mu,sigma)])

return alpha[k]*phi(mu[k],sigma[k],i)/sumak def dataN(length,k):#生成数据

y=[np.random.normal(5*j,j+5,length/k) for j in range(k)]

return y def EM(y,K,iter=1000): #EM算法

n = len(y)

sigma=[10]*K

mu=range(K)

alpha=np.ones(K)

qqold,qqnew=0,0

for it in range(iter):

gama2=np.ones((n,K))

for k in range(K):

for i in range(n):

gama2[i,k]=gama(alpha,mu,sigma,y[i],k)

for k in range(K):

sum_gama=np.sum([gama2[j,k] for j in range(n)])

mu[k]=np.sum([gama2[j,k]*y[j] for j in range(n)])/sum_gama

sigma[k]=np.sum([gama2[j,k]*(y[j]-mu[k])**2 for j in range(n)])/sum_gama

alpha[k]=sum_gama/n

qqnew=qq(y,alpha,mu,sigma,K,gama2)

if abs(qqold-qqnew)<0.000001:

break

qqold=qqnew

return alpha,mu,sigma N = 500

k=2

data=dataN(N,k)

y=np.reshape(data,(1,N))

a,b,c = EM(y[0], k)

print a,b,c

# iter=180

#[ 0.57217609 0.42782391] [4.1472879054766887, 0.72534713118155769] [44.114682884921415, 24.676116557533351] sigma = 6 #网上的数据

miu1 = 40

miu2 = 20

X = np.zeros((1, N))

for i in xrange(N):

if np.random.random() > 0.5:

X[0, i] = np.random.randn() * sigma + miu1

else:

X[0, i] = np.random.randn() * sigma + miu2

a,b,c = EM(X[0], k)

print a,b,c

# iter=114

#[ 0.44935959 0.55064041] [40.561782615819361, 21.444533254494189] [33.374144230703514, 51.459622219329155]

高斯混合模型参数估计的EM算法的更多相关文章

- 高斯混合模型GMM与EM算法的Python实现

GMM与EM算法的Python实现 高斯混合模型(GMM)是一种常用的聚类模型,通常我们利用最大期望算法(EM)对高斯混合模型中的参数进行估计. 1. 高斯混合模型(Gaussian Mixture ...

- 高斯混合模型和EM算法

使用期望最大化算法(Expectation-Maximization)来进行密度估计(density estimation). 与k-means一样,给定的训练样本是,我们将隐含类别标签用表示.与k- ...

- 聚类之高斯混合模型与EM算法

一.高斯混合模型概述 1.公式 高斯混合模型是指具有如下形式的概率分布模型: 其中,αk≥0,且∑αk=1,是每一个高斯分布的权重.Ø(y|θk)是第k个高斯分布的概率密度,被称为第k个分模型,参数为 ...

- 学习笔记——EM算法

EM算法是一种迭代算法,用于含有隐变量(hidden variable)的概率模型参数的极大似然估计,或极大后验概率估计.EM算法的每次迭代由两步组成:E步,求期望(expectation):M步,求 ...

- Python实现机器学习算法:EM算法

''' 数据集:伪造数据集(两个高斯分布混合) 数据集长度:1000 ------------------------------ 运行结果: ---------------------------- ...

- EM算法及其推广

概述 EM算法是一种迭代算法,用于含有隐变量(hidden variable)的概率模型参数的极大似然估计,或极大后验概率估计. EM算法的每次迭代由两步组成:E步,求期望(expectation): ...

- 《统计学习方法》笔记九 EM算法及其推广

本系列笔记内容参考来源为李航<统计学习方法> EM算法是一种迭代算法,用于含有隐变量的概率模型参数的极大似然估计或极大后验概率估计.迭代由 (1)E步:求期望 (2)M步:求极大 组成,称 ...

- EM算法及其应用: K-means 与 高斯混合模型

EM算法及其应用(一) EM算法及其应用(二): K-means 与 高斯混合模型 上一篇阐述了EM算法的主要原理,这一篇来看其两大应用 -- K-means 与 高斯混合模型,主要由EM算法的观点出 ...

- 5. EM算法-高斯混合模型GMM+Lasso

1. EM算法-数学基础 2. EM算法-原理详解 3. EM算法-高斯混合模型GMM 4. EM算法-GMM代码实现 5. EM算法-高斯混合模型+Lasso 1. 前言 前面几篇博文对EM算法和G ...

随机推荐

- objectARX获取当前图层所有文字样式

void GetAllTextStyle(std::vector<CString> &textStyle) { textStyle.clear(); AcDbTextStyleTa ...

- <em>标签

<em> 标签告诉浏览器把其中的文本表示为强调的内容.对于所有浏览器来说,这意味着要把这段文字用斜体来显示.

- EventBus vs Otto vs LiteEventBus

http://blog.chengyunfeng.com/?p=449 http://litesuits.com/

- The ShortCuts in the ADT (to be continued)

1. automatically add all the namespace which need to be include in the class. ctrl+shift+o

- Ubuntu系统下运行Eclipse出现找不到jre的问题的解决方法

在Ubuntu的某些版本下,比如10.10,会出现以下奇怪问题: 1. 安装jdk 我下载的jdk是bin格式的,直接运行解压,得到一个文件夹. 这个文件夹作为jdk的安装目录,可以拷贝到任意目录. ...

- iOS:开发者中心证书创建流程

一,首先点击开发者首页(https://developer.apple.com/)里面的Member Center.二,输入开发者账号和密码,点击sign in登录.三,点击Certificates, ...

- IOS开发-几种截屏方法

IOS开发-几种截屏方法 1. UIGraphicsBeginImageContextWithOptions(pageView.page.bounds.size, YES, zoomSc ...

- oracle 修改字段类型的方法(转)

今天公司因为业务需要,修要修改某个字段数据类型有number(5),变为number(5,2)型 要是没有数据的话直接用以下语句即可 alter table tb_test modify pe ...

- git回滚

Git回滚的常用手法 07net01.com 发布于 4小时前 评论 传统VCS的回滚操作 对于版本控制系统VCS来说,回滚这个操作应该是个很普通也是很重要的需求. 如果你是传统VCS,比如SVN或者 ...

- ubuntu中常用快捷键

本文转自 http://yife.im/ubuntu-terminal-shortcode/ 原文的格式会比较好看. Ubuntu终端常用的快捷键 Oct 3, 2013 • 23,469 views ...