图卷积神经网络分类的pytorch实现

图神经网络(GNN)目前的主流实现方式就是节点之间的信息汇聚,也就是类似于卷积网络的邻域加权和,比如图卷积网络(GCN)、图注意力网络(GAT)等。下面根据GCN的实现原理使用Pytorch张量,和调用torch_geometric包,分别对Cora数据集进行节点分类实验。

Cora是关于科学文献之间引用关系的图结构数据集。数据集包含一个图,图中包括2708篇文献(节点)和10556个引用关系(边)。其中每个节点都有一个1433维的特征向量,即文献内容的嵌入向量。文献被分为七个类别:计算机科学、物理学等。

GCN计算流程

对于某个GCN层,假设输入图的节点特征为$X\in R^{|V|\times F_{in}}$,边索引表示为序号数组$Ei\in R^{2\times |E|}$,GCN层输出$Y\in R^{|V|\times F_{out}}$。计算流程如下:

0、根据$Ei$获得邻接矩阵$A_0\in R^{|V|\times |V|}$。

1、为了将节点自身信息汇聚进去,每个节点添加指向自己的边,即 $A=A_0+I$,其中$I$为单位矩阵。

2、计算度(出或入)矩阵 $D$,其中 $D_{ii}=\sum_j A_{ij}$ 表示第 $i$ 个节点的度数。$D$为对角阵。

3、计算对称归一化矩阵 $\hat{D}$,其中 $\hat{D}_{ii}=1/\sqrt{D_{ii}}$。

4、构建对称归一化邻接矩阵 $\tilde{A}$,其中 $\tilde{A}= \hat{D} A \hat{D}$。

5、计算节点特征向量的线性变换,即 $Y = \tilde{A} X W$,其中 $X$ 表示输入的节点特征向量,$W\in R^{F_{in}\times F_{out}}$ 为GCN层中待训练的权重矩阵。

即:

$Y=D^{-0.5}(A_0+I)D^{-0.5}XW$

在torch_geometric包中,normalize参数控制是否使用度矩阵$D$归一化;cached控制是否缓存$D$,如果每次输入都是相同结构的图,则可以设置为True,即所谓转导学习(transductive learning)。另外,可以看到GCN的实现只考虑了节点的特征,没有考虑边的特征,仅仅通过聚合引入边的连接信息。

GCN实验

调包实现

Cora的图数据存放在torch_geometric的Data类中。Data主要包含节点特征$X\in R^{|V|\times F_v}$、边索引$Ei\in R^{2\times |E|}$、边特征$Ea\in R^{|E|\times F_e}$等变量。首先导出Cora数据:

from torch_geometric.datasets import Planetoid cora = Planetoid(root='./data', name='Cora')[0]

print(cora)

构建GCN,训练并测试。

import torch

from torch import nn

from torch_geometric.nn import GCNConv

import torch.nn.functional as F

from torch.optim import Adam class GCN(nn.Module):

def __init__(self, in_channels, hidden_channels, class_n):

super(GCN, self).__init__()

self.conv1 = GCNConv(in_channels, hidden_channels)

self.conv2 = GCNConv(hidden_channels, class_n) def forward(self, x, edge_index):

x = torch.relu(self.conv1(x, edge_index))

x = torch.dropout(x, p=0.5, train=self.training)

x = self.conv2(x, edge_index)

return torch.log_softmax(x, dim=1) model = GCN(cora.num_features, 16, cora.y.unique().shape[0]).to('cuda')

opt = Adam(model.parameters(), 0.01, weight_decay=5e-4) def train(its):

model.train()

for i in range(its):

y = model(cora.x, cora.edge_index)

loss = F.nll_loss(y[cora.train_mask], cora.y[cora.train_mask])

loss.backward()

opt.step()

opt.zero_grad() def test():

model.eval()

y = model(cora.x, cora.edge_index)

right_n = torch.argmax(y[cora.test_mask], 1) == cora.y[cora.test_mask]

acc = right_n.sum()/cora.test_mask.sum()

print("Acc: ", acc) for i in range(15):

train(1)

test()

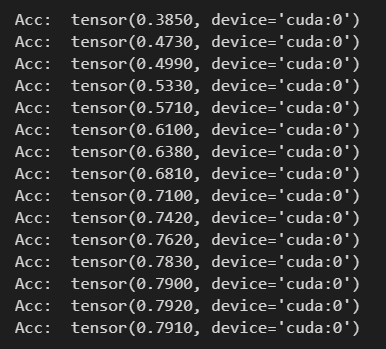

仅15次迭代就收敛,测试精度如下:

张量实现

主要区别就是自定义一个My_GCNConv来代替GCNConv,My_GCNConv定义如下:

from torch import nn

from torch_geometric.utils import to_dense_adj class My_GCNConv(nn.Module):

def __init__(self, in_channels, out_channels):

super(My_GCNConv, self).__init__()

self.weight = torch.nn.Parameter(nn.init.xavier_normal(torch.zeros(in_channels, out_channels)))

self.bias = torch.nn.Parameter(torch.zeros([out_channels])) def forward(self, x, edge_index):

adj = to_dense_adj(edge_index)[0]

adj += torch.eye(x.shape[0]).to(adj)

dgr = torch.diag(adj.sum(1)**-0.5)

y = torch.matmul(dgr, adj)

y = torch.matmul(y, dgr)

y = torch.matmul(y, x)

y = torch.matmul(y, self.weight) + self.bias

return y

其它代码仅将GCNConv修改为My_GCNConv。

对比实验

MLP实现

下面不使用节点之间的引用关系,仅使用节点特征向量在MLP中进行实验,来验证GCN的有效性。

import torch

from torch import nn

import torch.nn.functional as F

from torch.optim import Adam class MLP(nn.Module):

def __init__(self, in_channels, hidden_channels, class_n):

super(MLP, self).__init__()

self.l1 = nn.Linear(in_channels, hidden_channels)

self.l2 = nn.Linear(hidden_channels, hidden_channels)

self.l3 = nn.Linear(hidden_channels, class_n) def forward(self, x):

x = torch.relu(self.l1(x))

x = torch.relu(self.l2(x))

x = torch.dropout(x, p=0.5, train=self.training)

x = self.l3(x)

return torch.log_softmax(x, dim=1) model = MLP(cora.num_features, 512, cora.y.unique().shape[0]).to('cuda')

opt = Adam(model.parameters(), 0.01, weight_decay=5e-4) def train(its):

model.train()

for i in range(its):

y = model(cora.x[cora.train_mask])

loss = F.nll_loss(y, cora.y[cora.train_mask])

loss.backward()

opt.step()

opt.zero_grad() def test():

model.eval()

y = model(cora.x[cora.test_mask])

right_n = torch.argmax(y, 1) == cora.y[cora.test_mask]

acc = right_n.sum()/cora.test_mask.sum()

print("Acc: ", acc) for i in range(15):

train(30)

test()

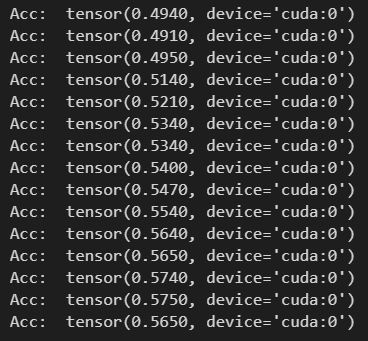

可以看出MLP包含了3层,并且隐层参数比GCN多得多。结果如下:

精度收敛在57%左右,效果比GCN的79%差。说明节点之间的链接关系对节点类别的划分有促进作用,以及GCN的有效性。

图卷积神经网络分类的pytorch实现的更多相关文章

- 图卷积神经网络(GCN)入门

图卷积网络Graph Convolutional Nueral Network,简称GCN,最近两年大热,取得不少进展.不得不专门为GCN开一个新篇章,表示其重要程度.本文结合大量参考文献,从理论到实 ...

- 论文解读丨基于局部特征保留的图卷积神经网络架构(LPD-GCN)

摘要:本文提出一种基于局部特征保留的图卷积网络架构,与最新的对比算法相比,该方法在多个数据集上的图分类性能得到大幅度提升,泛化性能也得到了改善. 本文分享自华为云社区<论文解读:基于局部特征保留 ...

- Graph 卷积神经网络:概述、样例及最新进展

http://www.52ml.net/20031.html [新智元导读]Graph Convolutional Network(GCN)是直接作用于图的卷积神经网络,GCN 允许对结构化数据进行端 ...

- 最全面的图卷积网络GCN的理解和详细推导,都在这里了!

目录 目录 1. 为什么会出现图卷积神经网络? 2. 图卷积网络的两种理解方式 2.1 vertex domain(spatial domain):顶点域(空间域) 2.2 spectral doma ...

- Graph Neural Networks:谱域图卷积

以下学习内容参考了:1,2, 0.首先回忆CNN,卷积神经网络的结构和特点 处理的数据特征:具有规则的空间结构(Euclidean domains),都可以采用一维或者二维的矩阵描述.(Convolu ...

- 卷积神经网络概念及使用 PyTorch 简单实现

卷积神经网络 卷积神经网络(CNN)是深度学习的代表算法之一 .具有表征学习能力,能够按其阶层结构对输入信息进行平移不变分类,因此也被称为“平移不变人工神经网络”.随着深度学习理论的提出和数值计算设备 ...

- 基于卷积神经网络的面部表情识别(Pytorch实现)----台大李宏毅机器学习作业3(HW3)

一.项目说明 给定数据集train.csv,要求使用卷积神经网络CNN,根据每个样本的面部图片判断出其表情.在本项目中,表情共分7类,分别为:(0)生气,(1)厌恶,(2)恐惧,(3)高兴,(4)难过 ...

- PyTorch基础——使用卷积神经网络识别手写数字

一.介绍 实验内容 内容包括用 PyTorch 来实现一个卷积神经网络,从而实现手写数字识别任务. 除此之外,还对卷积神经网络的卷积核.特征图等进行了分析,引出了过滤器的概念,并简单示了卷积神经网络的 ...

- Pytorch实现基于卷积神经网络的面部表情识别(详细步骤)

文章目录 一.项目背景 二.数据处理 1.标签与特征分离 2.数据可视化 3.训练集和测试集 三.模型搭建 四.模型训练 五.完整代码 一.项目背景数据集cnn_train.csv包含人类面部表情的图 ...

- [DL学习笔记]从人工神经网络到卷积神经网络_3_使用tensorflow搭建CNN来分类not_MNIST数据(有一些问题)

3:用tensorflow搭个神经网络出来 为什么用tensorflow呢,应为谷歌是亲爹啊,虽然有些人说caffe更适合图像啊mxnet效率更高等等,但爸爸就是爸爸,Android都能那么火,一个道 ...

随机推荐

- LINQ to Entities 不识别方法“System.String get_Item(System.String)”,因此该方法无法转换为存储表达式。

在使用EF的FirstOrDefault时出现异常.原因是EF的查询条件需要是一个变量否者就会出现这个原因 错误的代码 var userid= db.UserList.Where(u => u. ...

- 【Advanced Installer】打包winfrom程序出现您没有任何数字签名的实用程序。请安装平台 SDK。错误

出现这个问题的原因是设置了磁铁,此功能只会在win8.1上有效.也就是开始菜单里面的磁铁图 只需要把这个删除掉就可以解决了

- eval解析的函数传参 object array

1 const fn = (...args) => { 2 console.log(...args) 3 } 4 5 const handleEval = (fnName,...args) =& ...

- 多种方法实现单例模式 pickle模块

目录 单例模式 类方法@classmethod实现 元类实现 模块实现 装饰器实现 双下call.反射实现 pickle序列化模块 单例模式 比如系统调用打印机,不管你要打印几次,都是调用同一个打印机 ...

- 【QT开发问题】使用自定义的QGroupBox,重写绘图事件paintEvent后边框消失的问题

问题描述 Qt界面开发过程中,使用自定义的QGroupBox,重写绘图事件paintEvent时,出现边框被覆盖的情况,或边框消失的问题. 左图是原始状态,直接重写绘图事件后,会变成右图空白状态. ...

- 1+X Web初级笔记查漏补缺+练习题

学习笔记: position:relative是相对定位,是相对于自身位置移动,但是占据原有空间 absolute是绝对定位,原有空间不保留会被其他元素挤占 绝对定位 absolute不占位置完全浮动 ...

- 《HelloGitHub》第 81 期

兴趣是最好的老师,HelloGitHub 让你对编程感兴趣! 简介 HelloGitHub 分享 GitHub 上有趣.入门级的开源项目. https://github.com/521xueweiha ...

- [WPF]使用Fody提高效率

下载安装及使用 代码实例 public class Person:INotifyPropertyChanged { public event PropertyChangedEventHandler P ...

- SQL29 计算用户的平均次日留存率

SQL29 计算用户的平均次日留存率 困难 通过率:48.58% 时间限制:1秒 空间限制:256M 描述 题目:现在运营想要查看用户在某天刷题后第二天还会再来刷题的平均概率.请你取出相应数据. 示例 ...

- Spring Boot通过Actuator显示git和build的信息

1 简介 为了更好的版本控制和问题定位,我们需要知道正在运行的应用是什么版本,什么时候打包的,Git的相关信息等.通过/actuator/info可以帮助我们获取这些信息. 2 配置 首先要有actu ...