Flink WordCount入门

下面通过一个单词统计的案例,快速上手应用 Flink,进行流处理(Streaming)和批处理(Batch)

单词统计(批处理)

- 引入依赖

<!--flink核心包-->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-java</artifactId>

<version>1.7.2</version>

</dependency>

<!--flink流处理包-->

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-streaming-java_2.12</artifactId>

<version>1.7.2</version>

</dependency>

- 代码实现

public class WordCountBatch {

public static void main(String[] args) throws Exception {

String inputFile= "E:\\data\\word.txt";

String outPutFile= "E:\\data\\wordResult.txt";

ExecutionEnvironment executionEnvironment = ExecutionEnvironment.getExecutionEnvironment();

//1. 读取数据

DataSource<String> dataSource = executionEnvironment.readTextFile(inputFile);

//2. 对数据进行处理,转成word,1的格式

FlatMapOperator<String, Tuple2<String, Integer>> flatMapOperator = dataSource.flatMap(new FlatMapFunction<String, Tuple2<String, Integer>>() {

@Override

public void flatMap(String s, Collector<Tuple2<String, Integer>> collector) throws Exception {

String[] words = s.split(" ");

for (String word : words) {

collector.collect(new Tuple2<>(word, 1));

}

}

});

//3. 对数据分组,相同word的一个组

UnsortedGrouping<Tuple2<String, Integer>> tuple2UnsortedGrouping = flatMapOperator.groupBy(0);

//4. 对分组后的数据求和

AggregateOperator<Tuple2<String, Integer>> sum = tuple2UnsortedGrouping.sum(1);

//5. 写出数据

sum.writeAsCsv(outPutFile).setParallelism(1);

//执行

executionEnvironment.execute("wordcount batch process");

}

}

执行 main 方法,得出结果。我测试的 word.txt 内容如下:

ni hao hi

wang mei mei

liu mei

ni hao

wo hen hao

this is a good idea

Apache Flink

输出的文件结果:

a,1

mei,3

Apache,1

Flink,1

good,1

hen,1

hi,1

idea,1

ni,2

is,1

liu,1

this,1

wo,1

hao,3

wang,1

单词统计(流数据)

需求:Socket 模拟实时发送单词,使用 Flink 实时接收数据,对指定时间窗口内(如 5s)的数据进行聚合统计,每隔 1s 汇总计算一次,并且把时间窗口内计算结果打印出来

public class WordCountStream {

public static void main(String[] args) throws Exception {

int port = 7000;

StreamExecutionEnvironment executionEnvironment = StreamExecutionEnvironment.getExecutionEnvironment();

DataStreamSource<String> textStream = executionEnvironment.socketTextStream("192.168.56.103", port, "\n");

SingleOutputStreamOperator<Tuple2<String, Integer>> tuple2SingleOutputStreamOperator = textStream.flatMap(new FlatMapFunction<String, Tuple2<String, Integer>>() {

@Override

public void flatMap(String s, Collector<Tuple2<String, Integer>> collector) throws Exception {

String[] split = s.split("\\s");

for (String word : split) {

collector.collect(Tuple2.of(word, 1));

}

}

});

SingleOutputStreamOperator<Tuple2<String, Integer>> word = tuple2SingleOutputStreamOperator.keyBy(0)

.timeWindow(Time.seconds(5),Time.seconds(1)).sum(1);

word.print();

executionEnvironment.execute("wordcount stream process");

}

}

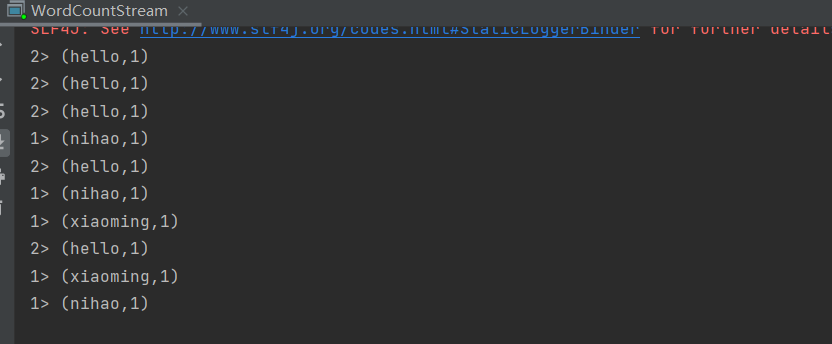

运行起来之后,我们就可以开始发送 socket 请求过去。我们测试可以使用 netcat 工具。

在 linux 上安装好后,使用下面的命令:

nc -lk 7000

然后发送数据即可。

Flink WordCount入门的更多相关文章

- [转帖]Flink(一)Flink的入门简介

Flink(一)Flink的入门简介 https://www.cnblogs.com/frankdeng/p/9400622.html 一. Flink的引入 这几年大数据的飞速发展,出现了很多热门的 ...

- Flink从入门到放弃(入门篇2)-本地环境搭建&构建第一个Flink应用

戳更多文章: 1-Flink入门 2-本地环境搭建&构建第一个Flink应用 3-DataSet API 4-DataSteam API 5-集群部署 6-分布式缓存 7-重启策略 8-Fli ...

- Flink从入门到放弃(入门篇3)-DataSetAPI

戳更多文章: 1-Flink入门 2-本地环境搭建&构建第一个Flink应用 3-DataSet API 4-DataSteam API 5-集群部署 6-分布式缓存 7-重启策略 8-Fli ...

- Flink从入门到放弃(入门篇1)-Flink是什么

戳更多文章: 1-Flink入门 2-本地环境搭建&构建第一个Flink应用 3-DataSet API 4-DataSteam API 5-集群部署 6-分布式缓存 7-重启策略 8-Fli ...

- Flink从入门到放弃(入门篇4) DataStreamAPI

戳更多文章: 1-Flink入门 2-本地环境搭建&构建第一个Flink应用 3-DataSet API 4-DataSteam API 5-集群部署 6-分布式缓存 7-重启策略 8-Fli ...

- Flink从入门到精通系列文章

戳更多文章: 1-Flink入门 2-本地环境搭建&构建第一个Flink应用 3-DataSet API 4-DataSteam API 5-集群部署 6-分布式缓存 7-重启策略 8-Fli ...

- Flink快速入门--安装与示例运行

flink是一款开源的大数据流式处理框架,他可以同时批处理和流处理,具有容错性.高吞吐.低延迟等优势,本文简述flink在windows和linux中安装步骤,和示例程序的运行. 首先要想运行Flin ...

- 「Flink」使用Java lambda表达式实现Flink WordCount

本篇我们将使用Java语言来实现Flink的单词统计. 代码开发 环境准备 导入Flink 1.9 pom依赖 <dependencies> <dependency> < ...

- Flink(一)Flink的入门简介

一. Flink的引入 这几年大数据的飞速发展,出现了很多热门的开源社区,其中著名的有 Hadoop.Storm,以及后来的 Spark,他们都有着各自专注的应用场景.Spark 掀开了内存计算的先河 ...

随机推荐

- devops-2:Jenkins的使用及Pipeline语法讲解

DevOps-Jenkins Jenkins简介 Jenkins是一个开源软件项目,是基于Java开发的一种持续集成工具,用于监控持续重复的工作,旨在提供一个开放易用的软件平台,使软件项目可以进行持续 ...

- 9. 利用Docker快速构建MGR | 深入浅出MGR

目录 1.安装Docker 2.拉取GreatSQL镜像,并创建容器 2.1 拉取镜像 2.2 创建新容器 2.3 容器管理 3.构建MGR集群 3.1 创建专用子网 3.2 创建3个新容器 3.3 ...

- 技术分享 | 为什么MGR一致性模式不推荐AFTER

GreatSQL社区原创内容未经授权不得随意使用,转载请联系小编并注明来源. 1.引子 2.AFTER 的写一致性 3.AFTER 的读一致性 4.AFTER 执行流程 5.BEFORE 执行流程 6 ...

- GreatSQL MGR FAQ

欢迎来到 GreatSQL社区分享的MySQL技术文章,如有疑问或想学习的内容,可以在下方评论区留言,看到后会进行解答 目录 0. GreatSQL简介 1. GreatSQL的特色有哪些 2. Gr ...

- Windows 查看端口占用并关闭

在启动服务的时候,可能会遇到端口被占用的情况. 这时候就需要知道哪个服务占用了这个端口,并将其关闭. 然后再启动服务就不会存在端口占用了. 这里以 Tomcat 的默认端口 8080 为例. 打开命令 ...

- Word 文字多选方式有哪些?

Ctrl + 鼠标左键:不连续地选择文字. Shift + 鼠标左键:连续地选择文字. Alt + 鼠标左键:自由选择文字.

- python爬虫之BeautifulSoup4使用

钢铁知识库,一个学习python爬虫.数据分析的知识库.人生苦短,快用python. 上一章我们讲解针对结构化的html.xml数据,使用Xpath实现网页内容爬取.本章我们再来聊另一个高效的神器:B ...

- java数组---稀疏数组与数组之间的相互转化

public static void main(String[] args) { int[][]array1=new int[11][11]; array1[1][2]=1; array1[2][3] ...

- Rust 从入门到精通06-语句和表达式

1.语句和表达式 语句和表达式是 Rust 语言实现逻辑控制的基本单元. 在 Rust 程序里面,语句(Statement)是执行一些操作但不返回的指令,表达式(Expressions)计算并产生一个 ...

- KingbaseES 参数 - ora_statement_level_rollback

参数 ora_statement_level_rollback 控制KingbaseES 是否实现类似oracle 语句级的回滚.当该参数打开时,如果事务操作失败,仅会回滚最后一条操作,避免了全部操作 ...