Pytorch-卷积神经网络CNN之ResNet的Pytorch代码实现

先说一个小知识,助于理解代码中各个层之间维度是怎么变换的。

卷积函数:一般只用来改变输入数据的维度,例如3维到16维。

Conv2d()

Conv2d(in_channels:int,out_channels:int,kernel_size:Union[int,tuple],stride=1,padding=o):

"""

:param in_channels: 输入的维度

:param out_channels: 通过卷积核之后,要输出的维度

:param kernel_size: 卷积核大小

:param stride: 移动步长

:param padding: 四周添多少个零

"""

一个小例子:

import torch

import torch.nn

# 定义一个16张照片,每个照片3个通道,大小是28*28

x= torch.randn(16,3,32,32)

# 改变照片的维度,从3维升到16维,卷积核大小是5

conv= torch.nn.Conv2d(3,16,kernel_size=5,stride=1,padding=0)

res=conv(x)

print(res.shape)

# torch.Size([16, 16, 28, 28])

# 维度升到16维,因为卷积核大小是5,步长是1,所以照片的大小缩小了,变成28

卷积神经网络实战之ResNet18:

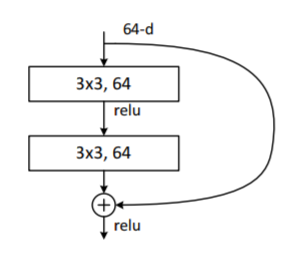

下面放一个ResNet18的一个示意图,

ResNet18主要是在层与层之间,加入了一个短接层,可以每隔k个层,进行一次短接。网络层的层数不是 越深就越好。

ResNet18就是,如果在原先的基础上再加上k层,如果有小优化,则保留,如果比原先结果还差,那就利用短接层,直接跳过。

ResNet18的构造如下:

ResNet18(

(conv1): Sequential(

(0): Conv2d(3, 64, kernel_size=(3, 3), stride=(3, 3))

(1): BatchNorm2d(64, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

)

(blk1): ResBlk(

(conv1): Conv2d(64, 128, kernel_size=(3, 3), stride=(2, 2), padding=(1, 1))

(bn1): BatchNorm2d(128, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(conv2): Conv2d(128, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(bn2): BatchNorm2d(128, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(extra): Sequential(

(0): Conv2d(64, 128, kernel_size=(1, 1), stride=(2, 2))

(1): BatchNorm2d(128, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

)

)

(blk2): ResBlk(

(conv1): Conv2d(128, 256, kernel_size=(3, 3), stride=(2, 2), padding=(1, 1))

(bn1): BatchNorm2d(256, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(conv2): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(bn2): BatchNorm2d(256, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(extra): Sequential(

(0): Conv2d(128, 256, kernel_size=(1, 1), stride=(2, 2))

(1): BatchNorm2d(256, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

)

)

(blk3): ResBlk(

(conv1): Conv2d(256, 512, kernel_size=(3, 3), stride=(2, 2), padding=(1, 1))

(bn1): BatchNorm2d(512, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(conv2): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(bn2): BatchNorm2d(512, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(extra): Sequential(

(0): Conv2d(256, 512, kernel_size=(1, 1), stride=(2, 2))

(1): BatchNorm2d(512, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

)

)

(blk4): ResBlk(

(conv1): Conv2d(512, 512, kernel_size=(3, 3), stride=(2, 2), padding=(1, 1))

(bn1): BatchNorm2d(512, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(conv2): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1))

(bn2): BatchNorm2d(512, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(extra): Sequential()

)

(outlayer): Linear(in_features=512, out_features=10, bias=True)

)

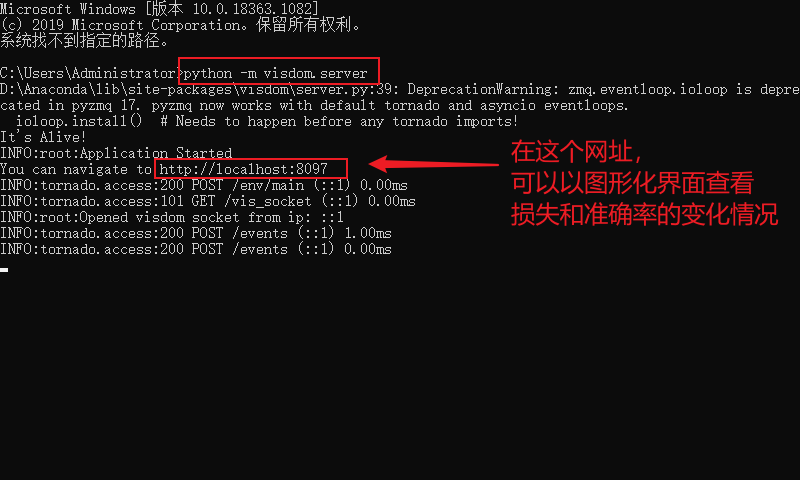

程序运行前,先启动visdom,如果没有配置好visdom环境的,先百度安装好visdom环境

- 1.使用快捷键win+r,在输入框输出cmd,然后在命令行窗口里输入

python -m visdom.server,启动visdom

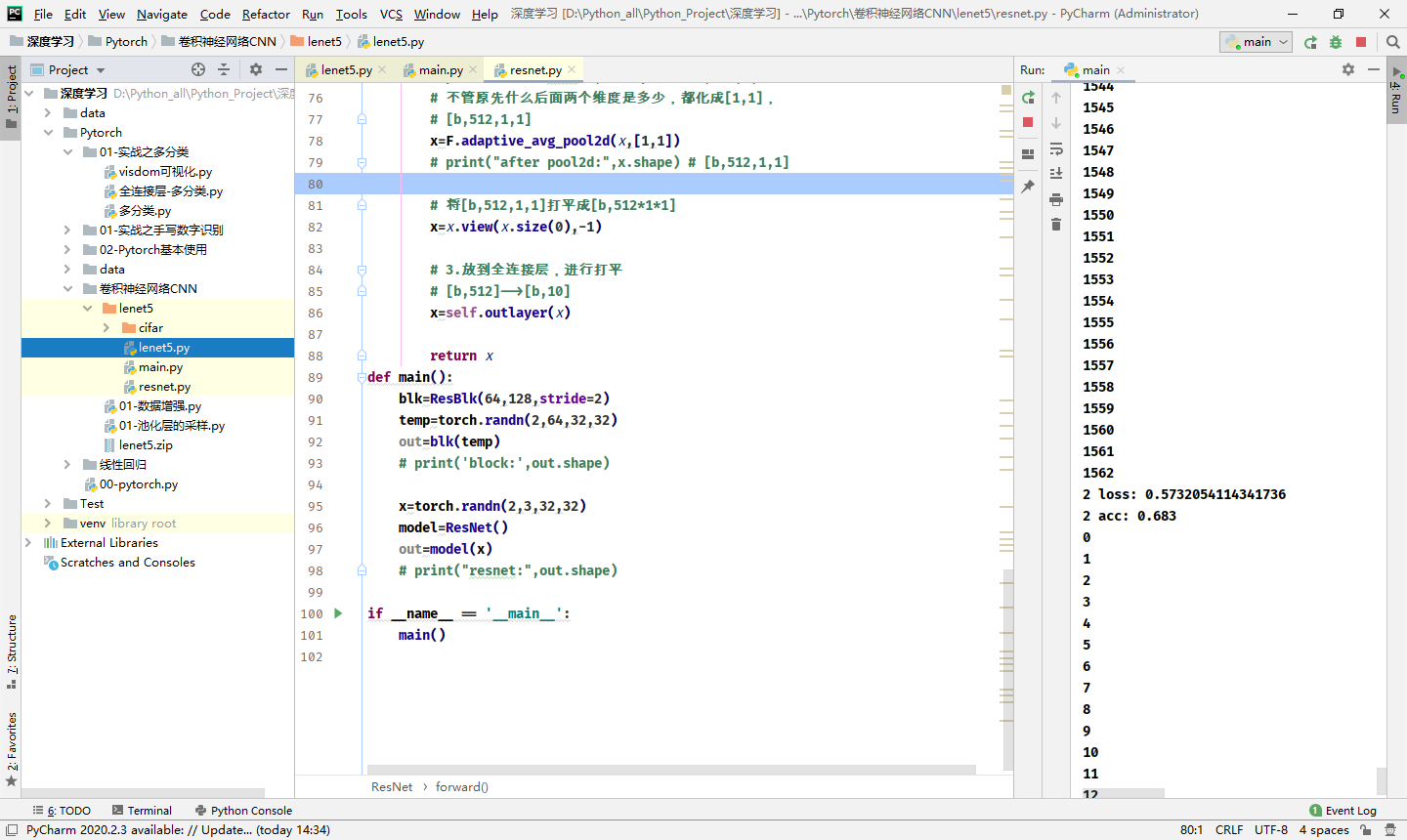

代码实战

定义一个名为

resnet.py的文件,代码如下

import torch

from torch import nn

from torch.nn import functional as F

# 定义两个卷积层 + 一个短接层

class ResBlk(nn.Module):

def __init__(self,ch_in,ch_out,stride=1):

super(ResBlk, self).__init__()

# 两个卷积层

self.conv1=nn.Conv2d(ch_in,ch_out,kernel_size=3,stride=stride,padding=1)

self.bn1=nn.BatchNorm2d(ch_out)

self.conv2=nn.Conv2d(ch_out,ch_out,kernel_size=3,stride=1,padding=1)

self.bn2=nn.BatchNorm2d(ch_out)

# 短接层

self.extra=nn.Sequential()

if ch_out != ch_in:

self.extra=nn.Sequential(

nn.Conv2d(ch_in,ch_out,kernel_size=1,stride=stride),

nn.BatchNorm2d(ch_out)

)

def forward(self,x):

"""

:param x: [b,ch,h,w]

:return:

"""

out=F.relu(self.bn1(self.conv1(x)))

out=self.bn2(self.conv2(out))

# 短接层

# element-wise add: [b,ch_in,h,w]=>[b,ch_out,h,w]

out=self.extra(x)+out

return out

class ResNet18(nn.Module):

def __init__(self):

super(ResNet18, self).__init__()

# 定义预处理层

self.conv1=nn.Sequential(

nn.Conv2d(3,64,kernel_size=3,stride=3,padding=0),

nn.BatchNorm2d(64)

)

# 定义堆叠ResBlock层

# followed 4 blocks

# [b,64,h,w]-->[b,128,h,w]

self.blk1=ResBlk(64,128,stride=2)

# [b,128,h,w]-->[b,256,h,w]

self.blk2=ResBlk(128,256,stride=2)

# [b,256,h,w]-->[b,512,h,w]

self.blk3=ResBlk(256,512,stride=2)

# [b,512,h,w]-->[b,512,h,w]

self.blk4=ResBlk(512,512,stride=2)

# 定义全连接层

self.outlayer=nn.Linear(512,10)

def forward(self,x):

"""

:param x:

:return:

"""

# 1.预处理层

x=F.relu(self.conv1(x))

# 2. 堆叠ResBlock层:channel会慢慢的增加, 长和宽会慢慢的减少

# [b,64,h,w]-->[b,512,h,w]

x=self.blk1(x)

x=self.blk2(x)

x=self.blk3(x)

x=self.blk4(x)

# print("after conv:",x.shape) # [b,512,2,2]

# 不管原先什么后面两个维度是多少,都化成[1,1],

# [b,512,1,1]

x=F.adaptive_avg_pool2d(x,[1,1])

# print("after pool2d:",x.shape) # [b,512,1,1]

# 将[b,512,1,1]打平成[b,512*1*1]

x=x.view(x.size(0),-1)

# 3.放到全连接层,进行打平

# [b,512]-->[b,10]

x=self.outlayer(x)

return x

def main():

blk=ResBlk(64,128,stride=2)

temp=torch.randn(2,64,32,32)

out=blk(temp)

# print('block:',out.shape)

x=torch.randn(2,3,32,32)

model=ResNet()

out=model(x)

# print("resnet:",out.shape)

if __name__ == '__main__':

main()

定义一个名为

main.py的文件,代码如下

import torch

from torchvision import datasets

from torchvision import transforms

from torch.utils.data import DataLoader

from torch import nn,optim

from visdom import Visdom

# from lenet5 import Lenet5

from resnet import ResNet18

import time

def main():

batch_siz=32

cifar_train = datasets.CIFAR10('cifar',True,transform=transforms.Compose([

transforms.Resize((32,32)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225])

]),download=True)

cifar_train=DataLoader(cifar_train,batch_size=batch_siz,shuffle=True)

cifar_test = datasets.CIFAR10('cifar',False,transform=transforms.Compose([

transforms.Resize((32,32)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225])

]),download=True)

cifar_test=DataLoader(cifar_test,batch_size=batch_siz,shuffle=True)

x,label = iter(cifar_train).next()

print('x:',x.shape,'label:',label.shape)

# 指定运行到cpu //GPU

device=torch.device('cpu')

# model = Lenet5().to(device)

model = ResNet18().to(device)

# 调用损失函数use Cross Entropy loss交叉熵

# 分类问题使用CrossEntropyLoss比MSELoss更合适

criteon = nn.CrossEntropyLoss().to(device)

# 定义一个优化器

optimizer=optim.Adam(model.parameters(),lr=1e-3)

print(model)

viz=Visdom()

viz.line([0.],[0.],win="loss",opts=dict(title='Lenet5 Loss'))

viz.line([0.],[0.],win="acc",opts=dict(title='Lenet5 Acc'))

# 训练train

for epoch in range(1000):

# 变成train模式

model.train()

# barchidx:下标,x:[b,3,32,32],label:[b]

str_time=time.time()

for barchidx,(x,label) in enumerate(cifar_train):

# 将x,label放在gpu上

x,label=x.to(device),label.to(device)

# logits:[b,10]

# label:[b]

logits = model(x)

loss = criteon(logits,label)

# viz.line([loss.item()],[barchidx],win='loss',update='append')

# backprop

optimizer.zero_grad()

loss.backward()

optimizer.step()

# print(barchidx)

end_time=time.time()

print('第 {} 次训练用时: {}'.format(epoch,(end_time-str_time)))

viz.line([loss.item()],[epoch],win='loss',update='append')

print(epoch,'loss:',loss.item())

# 变成测试模式

model.eval()

with torch.no_grad():

# 测试test

# 正确的数目

total_correct=0

total_num=0

for x,label in cifar_test:

# 将x,label放在gpu上

x,label=x.to(device),label.to(device)

# [b,10]

logits=model(x)

# [b]

pred=logits.argmax(dim=1)

# [b] = [b'] 统计相等个数

total_correct+=pred.eq(label).float().sum().item()

total_num+=x.size(0)

acc=total_correct/total_num

print(epoch,'acc:',acc)

print("------------------------------")

viz.line([acc],[epoch],win='acc',update='append')

# viz.images(x.view(-1, 3, 32, 32), win='x')

if __name__ == '__main__':

main()

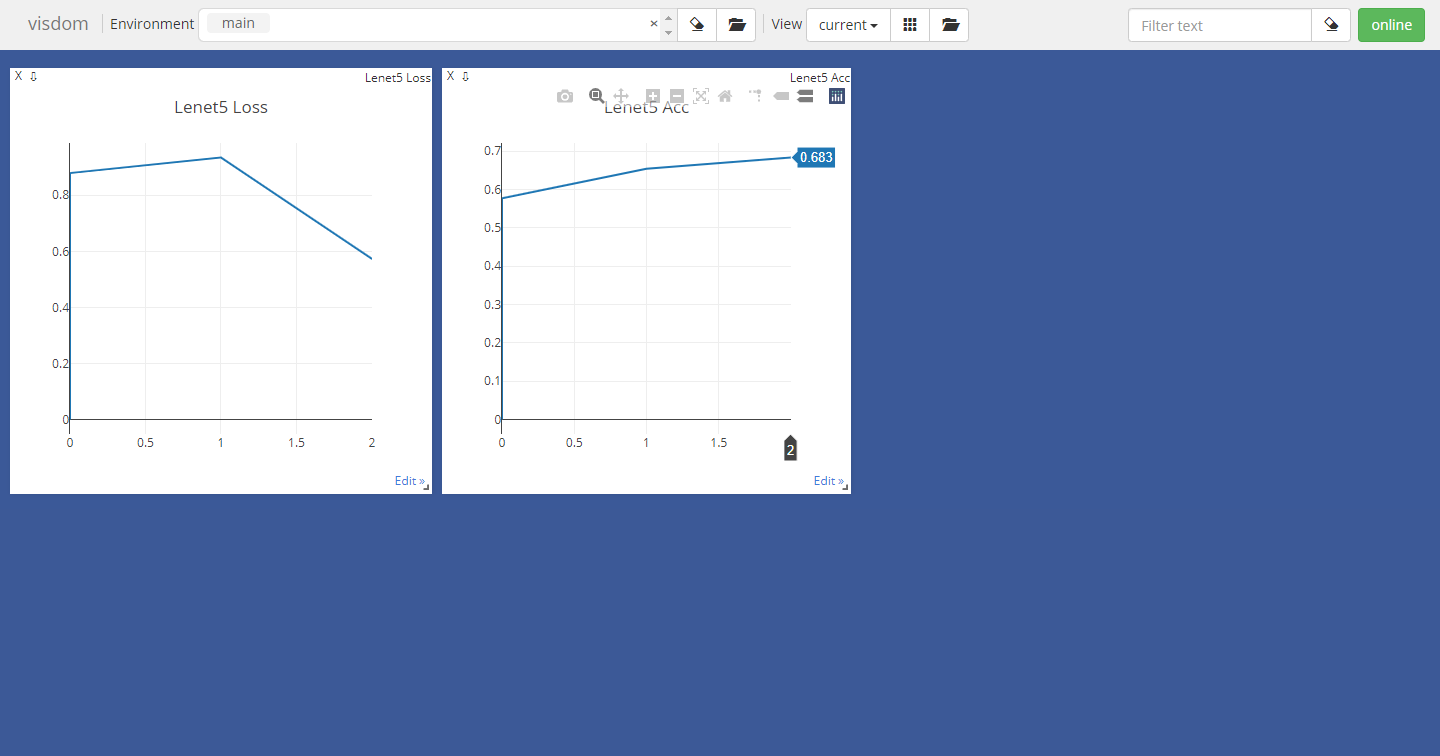

测试结果

ResNet跑起来太费劲了,需要用GPU跑,但是我的电脑不支持GPU,头都大了,用cpu跑二十多分钟学习一次,头都大了。

Pytorch-卷积神经网络CNN之ResNet的Pytorch代码实现的更多相关文章

- 写给程序员的机器学习入门 (八) - 卷积神经网络 (CNN) - 图片分类和验证码识别

这一篇将会介绍卷积神经网络 (CNN),CNN 模型非常适合用来进行图片相关的学习,例如图片分类和验证码识别,也可以配合其他模型实现 OCR. 使用 Python 处理图片 在具体介绍 CNN 之前, ...

- 深度学习之卷积神经网络CNN

转自:https://blog.csdn.net/cxmscb/article/details/71023576 一.CNN的引入 在人工的全连接神经网络中,每相邻两层之间的每个神经元之间都是有边相连 ...

- 深度学习之卷积神经网络CNN及tensorflow代码实例

深度学习之卷积神经网络CNN及tensorflow代码实例 什么是卷积? 卷积的定义 从数学上讲,卷积就是一种运算,是我们学习高等数学之后,新接触的一种运算,因为涉及到积分.级数,所以看起来觉得很复杂 ...

- 深度学习之卷积神经网络CNN及tensorflow代码实现示例

深度学习之卷积神经网络CNN及tensorflow代码实现示例 2017年05月01日 13:28:21 cxmscb 阅读数 151413更多 分类专栏: 机器学习 深度学习 机器学习 版权声明 ...

- paper 162:卷积神经网络(CNN)解析

卷积神经网络(CNN)解析: 卷积神经网络CNN解析 概揽 Layers used to build ConvNets 卷积层Convolutional layer 池化层Pooling Layer ...

- TensorFlow 2.0 深度学习实战 —— 浅谈卷积神经网络 CNN

前言 上一章为大家介绍过深度学习的基础和多层感知机 MLP 的应用,本章开始将深入讲解卷积神经网络的实用场景.卷积神经网络 CNN(Convolutional Neural Networks,Conv ...

- 卷积神经网络(CNN)前向传播算法

在卷积神经网络(CNN)模型结构中,我们对CNN的模型结构做了总结,这里我们就在CNN的模型基础上,看看CNN的前向传播算法是什么样子的.重点会和传统的DNN比较讨论. 1. 回顾CNN的结构 在上一 ...

- 卷积神经网络(CNN)反向传播算法

在卷积神经网络(CNN)前向传播算法中,我们对CNN的前向传播算法做了总结,基于CNN前向传播算法的基础,我们下面就对CNN的反向传播算法做一个总结.在阅读本文前,建议先研究DNN的反向传播算法:深度 ...

- 卷积神经网络CNN总结

从神经网络到卷积神经网络(CNN)我们知道神经网络的结构是这样的: 那卷积神经网络跟它是什么关系呢?其实卷积神经网络依旧是层级网络,只是层的功能和形式做了变化,可以说是传统神经网络的一个改进.比如下图 ...

- 【深度学习系列】手写数字识别卷积神经--卷积神经网络CNN原理详解(一)

上篇文章我们给出了用paddlepaddle来做手写数字识别的示例,并对网络结构进行到了调整,提高了识别的精度.有的同学表示不是很理解原理,为什么传统的机器学习算法,简单的神经网络(如多层感知机)都可 ...

随机推荐

- Codeforces Round 729 (Div. 2)B. Plus and Multiply(构造、数学)

题面 链接 B. Plus and Multiply 题意 给定\(n,a,b\) 可以进行的操作 \(*a\) \(+b\) 最开始的数是1 问能否经过上面的两种操作将1变为n 题解 这题的关键是能 ...

- 当未指定且存在多个构造器,实例化对象时Spring如何选择?

前言 在前面的讲解中,我们了解了如何获取构造器.当只有一个符合条件的构造器时,自然会选择它作为初始化的构造器.然而,在上一节中,我们遇到了一种特殊情况:当有多个符合条件的构造器时,返回的是一个数组.在 ...

- 虚拟机和开发板之间通过NFS互联

简介 NFS是Network File System的首字母缩写.它是一种分布式协议,使客户端可以访问远程服务器上的共享文件.它允许网络中的计算机之间通过TCP/IP网络共享资源. 配置过程 安装NF ...

- 【主流技术】日常工作中关于 JSON 转换的经验大全(Java)

目录 前言 一.JSON 回顾 1.1结构形式 二.其它类型 -> JSON相关 2.1 JavaBean 转 JsonObject 2.2 JavaBean 转 Json 字符串 2.3 Li ...

- KEIL5新建工程0810

在保存各种项目的文件夹内创建一个项目文件夹1新建工程到文件夹1 选择芯片添加工程的必要文件(固件库) STM32程序是从启动文件开始,复制这些文件到文件夹A的新建Start文件夹下 stm32f10x ...

- 怎么实现Redis的高可用?(主从、哨兵、集群)

高可用有两个含义:一是数据尽量不丢失,二是保证服务尽可能可用. AOF 和 RDB 数据持久化保证了数据尽量不丢失,那么多节点来保证服务尽可能提供服务. 一般在实际生产中,服务不会部署成单节点,主要是 ...

- drf(认证、权限、频率)

一. 认证组件 1. 流程 1. 写一个类,继承BaseAuthentication,重写authenticate,认证的逻辑写在里面. 认证通过,返回两个值,一个值最终给了包装以后的request对 ...

- 记录--工程化第一步这个package.json要真的搞明白才行

这里给大家分享我在网上总结出来的一些知识,希望对大家有所帮助 工程化最开始就是package.json开始的,很多人学了很多年也没搞清楚这个为什么这么神奇,其实有些字段是在特定场景才有效的,那每个属性 ...

- 记录--两行CSS让页面提升了近7倍渲染性能

这里给大家分享我在网上总结出来的一些知识,希望对大家有所帮助 前言 对于前端人员来讲,最令人头疼的应该就是页面性能了,当用户在访问一个页面时,总是希望它能够快速呈现在眼前并且是可交互状态.如果页面加载 ...

- 微信小程序中rich-text文本溢出(三个...)

小程序中当rich-text中数据较多时就会出现溢出的现象 如下 此时的页面效果并不是很理想 我们可以在数据中给个div <div style="overflow: hidden;wh ...