通过ELK快速搭建一个你可能需要的集中化日志平台

在项目初期的时候,大家都是赶着上线,一般来说对日志没有过多的考虑,当然日志量也不大,所以用log4net就够了,随着应用的越来越多,日志散

落在各个服务器的logs文件夹下,确实有点不大方便,这个时候就想到了,在log4net中配置 mysql的数据源,不过这里面有一个坑,熟悉log4net的同学知

道写入mysql有一个batch的阈值,比如说batchcache中有100条,才写入mysql,这样的话,就有一个延迟的效果,而且如果batchcache中不满100条的话,

你在mysql中是看不到最新的100条日志。。。而且采用中心化的mysql,涉及到tcp传输,其中的性能大家也应该明白,而且mysql没有一个好的日志界面,

只能自己去写UI,所以还还得继续寻找其他的解决方案,也就是本篇的ELK。

一:ELK名字解释

ELK就是ElasticSearch + LogStash + Kibana,这三样搭配起来确实非常不错,先画张图给大家看一下。

1. LogStash

它可以流放到各自的服务器上收集Log日志,通过内置的ElasticSearch插件解析后输出到ES中。

2.ElasticSearch

这是一个基于Lucene的分布式全文搜索框架,可以对logs进行分布式存储,有点像hdfs哈。。。

3. Kibana

所有的log日志都到ElasticSearch之后,我们需要给他展示出来,对吧? 这个时候Kibana就出手了,它可以多维度的展示es中的数据。这也解决了

用mysql存储带来了难以可视化的问题。

二:快速搭建

上面只是名词解释,为了演示,我只在一台centos上面搭建了。

1. 官方下载 :https://www.elastic.co/cn/products,在下面这张图上,我们找到对应的三个产品,进行下载就好了。

[root@slave1 myapp]# ls

elasticsearch kafka_2.-1.0..tgz nginx-1.13..tar.gz

elasticsearch-5.6.4.tar.gz kibana node

elasticsearch-head kibana-5.2.0-linux-x86_64.tar.gz node-v8.9.1-linux-x64.tar.xz

images logstash portal

java logstash-5.6.3.tar.gz service

jdk1. logstash-tutorial-dataset sql

jdk-8u144-linux-x64.tar.gz nginx

kafka nginx-1.13.

[root@slave1 myapp]#

我这里下载的是elasticsearch 5.6.4,kibana5.2.0 ,logstash5.6.3三个版本。。。然后用 tar -xzvf解压一下。

2. logstash配置

解压完之后,我们到config目录中新建一个logstash.conf配置。

[root@slave1 config]# ls

jvm.options log4j2.properties logstash.conf logstash.yml startup.options

[root@slave1 config]# pwd

/usr/myapp/logstash/config

[root@slave1 config]# vim logstash.conf

然后做好input ,filter,output三大块, 其中input是吸取logs文件下的所有log后缀的日志文件,filter是一个过滤函数,这里不用配置,output配置了导入到

hosts为127.0.0.1:9200的elasticsearch中,每天一个索引。

input {

file {

type => "log"

path => "/logs/*.log"

start_position => "beginning"

}

}

output {

stdout {

codec => rubydebug { }

}

elasticsearch {

hosts => "127.0.0.1"

index => "log-%{+YYYY.MM.dd}"

}

}

配置完了之后,我们就可以到bin目录下启动logstash了,配置文件设置为conf/logstash.conf,从下图中可以看到,当前开启的是9600端口。

[root@slave1 bin]# ls

cpdump logstash logstash.lib.sh logstash-plugin.bat setup.bat

ingest-convert.sh logstash.bat logstash-plugin ruby system-install

[root@slave1 bin]# ./logstash -f ../config/logstash.conf

Sending Logstash's logs to /usr/myapp/logstash/logs which is now configured via log4j2.properties

[--28T17::,][INFO ][logstash.modules.scaffold] Initializing module {:module_name=>"fb_apache", :directory=>"/usr/myapp/logstash/modules/fb_apache/configuration"}

[--28T17::,][INFO ][logstash.modules.scaffold] Initializing module {:module_name=>"netflow", :directory=>"/usr/myapp/logstash/modules/netflow/configuration"}

[--28T17::,][INFO ][logstash.outputs.elasticsearch] Elasticsearch pool URLs updated {:changes=>{:removed=>[], :added=>[http://127.0.0.1:9200/]}}

[--28T17::,][INFO ][logstash.outputs.elasticsearch] Running health check to see if an Elasticsearch connection is working {:healthcheck_url=>http://127.0.0.1:9200/, :path=>"/"}

[--28T17::,][WARN ][logstash.outputs.elasticsearch] Restored connection to ES instance {:url=>"http://127.0.0.1:9200/"}

[--28T17::,][INFO ][logstash.outputs.elasticsearch] Using mapping template from {:path=>nil}

[--28T17::,][INFO ][logstash.outputs.elasticsearch] Attempting to install template {:manage_template=>{"template"=>"logstash-*", "version"=>, "settings"=>{"index.refresh_interval"=>"5s"}, "mappings"=>{"_default_"=>{"_all"=>{"enabled"=>true, "norms"=>false}, "dynamic_templates"=>[{"message_field"=>{"path_match"=>"message", "match_mapping_type"=>"string", "mapping"=>{"type"=>"text", "norms"=>false}}}, {"string_fields"=>{"match"=>"*", "match_mapping_type"=>"string", "mapping"=>{"type"=>"text", "norms"=>false, "fields"=>{"keyword"=>{"type"=>"keyword", "ignore_above"=>}}}}}], "properties"=>{"@timestamp"=>{"type"=>"date", "include_in_all"=>false}, "@version"=>{"type"=>"keyword", "include_in_all"=>false}, "geoip"=>{"dynamic"=>true, "properties"=>{"ip"=>{"type"=>"ip"}, "location"=>{"type"=>"geo_point"}, "latitude"=>{"type"=>"half_float"}, "longitude"=>{"type"=>"half_float"}}}}}}}}

[--28T17::,][INFO ][logstash.outputs.elasticsearch] New Elasticsearch output {:class=>"LogStash::Outputs::ElasticSearch", :hosts=>["//127.0.0.1"]}

[--28T17::,][INFO ][logstash.pipeline ] Starting pipeline {"id"=>"main", "pipeline.workers"=>, "pipeline.batch.size"=>, "pipeline.batch.delay"=>, "pipeline.max_inflight"=>}

[--28T17::,][INFO ][logstash.pipeline ] Pipeline main started

[--28T17::,][INFO ][logstash.agent ] Successfully started Logstash API endpoint {:port=>}

3. elasticSearch

这个其实也是ELK中的核心,启动的时候一定要注意,因为es不可以进行root账户启动,所以你还需要开启一个elsearch账户。

groupadd elsearch #新建elsearch组

useradd elsearch -g elsearch -p elasticsearch #新建一个elsearch用户

chown -R elsearch:elsearch ./elasticsearch #指定elasticsearch所属elsearch组

接下来我们默认启动就好了,什么也不用配置,然后在日志中大概可以看到开启了9200,9300端口。

[elsearch@slave1 bin]$ ./elasticsearch

[--28T17::,][INFO ][o.e.n.Node ] [] initializing ...

[--28T17::,][INFO ][o.e.e.NodeEnvironment ] [0bC8MSi] using [] data paths, mounts [[/ (rootfs)]], net usable_space [.9gb], net total_space [.6gb], spins? [unknown], types [rootfs]

[--28T17::,][INFO ][o.e.e.NodeEnvironment ] [0bC8MSi] heap size [.9gb], compressed ordinary object pointers [true]

[--28T17::,][INFO ][o.e.n.Node ] node name [0bC8MSi] derived from node ID [0bC8MSi_SUywaqz_Zl-MFA]; set [node.name] to override

[--28T17::,][INFO ][o.e.n.Node ] version[5.6.], pid[], build[8bbedf5/--31T18::.105Z], OS[Linux/3.10.-.el7.x86_64/amd64], JVM[Oracle Corporation/Java HotSpot(TM) -Bit Server VM/1.8.0_144/25.144-b01]

[--28T17::,][INFO ][o.e.n.Node ] JVM arguments [-Xms2g, -Xmx2g, -XX:+UseConcMarkSweepGC, -XX:CMSInitiatingOccupancyFraction=, -XX:+UseCMSInitiatingOccupancyOnly, -XX:+AlwaysPreTouch, -Xss1m, -Djava.awt.headless=true, -Dfile.encoding=UTF-, -Djna.nosys=true, -Djdk.io.permissionsUseCanonicalPath=true, -Dio.netty.noUnsafe=true, -Dio.netty.noKeySetOptimization=true, -Dio.netty.recycler.maxCapacityPerThread=, -Dlog4j.shutdownHookEnabled=false, -Dlog4j2.disable.jmx=true, -Dlog4j.skipJansi=true, -XX:+HeapDumpOnOutOfMemoryError, -Des.path.home=/usr/myapp/elasticsearch]

[--28T17::,][INFO ][o.e.p.PluginsService ] [0bC8MSi] loaded module [aggs-matrix-stats]

[--28T17::,][INFO ][o.e.p.PluginsService ] [0bC8MSi] loaded module [ingest-common]

[--28T17::,][INFO ][o.e.p.PluginsService ] [0bC8MSi] loaded module [lang-expression]

[--28T17::,][INFO ][o.e.p.PluginsService ] [0bC8MSi] loaded module [lang-groovy]

[--28T17::,][INFO ][o.e.p.PluginsService ] [0bC8MSi] loaded module [lang-mustache]

[--28T17::,][INFO ][o.e.p.PluginsService ] [0bC8MSi] loaded module [lang-painless]

[--28T17::,][INFO ][o.e.p.PluginsService ] [0bC8MSi] loaded module [parent-join]

[--28T17::,][INFO ][o.e.p.PluginsService ] [0bC8MSi] loaded module [percolator]

[--28T17::,][INFO ][o.e.p.PluginsService ] [0bC8MSi] loaded module [reindex]

[--28T17::,][INFO ][o.e.p.PluginsService ] [0bC8MSi] loaded module [transport-netty3]

[--28T17::,][INFO ][o.e.p.PluginsService ] [0bC8MSi] loaded module [transport-netty4]

[--28T17::,][INFO ][o.e.p.PluginsService ] [0bC8MSi] no plugins loaded

[--28T17::,][INFO ][o.e.d.DiscoveryModule ] [0bC8MSi] using discovery type [zen]

[--28T17::,][INFO ][o.e.n.Node ] initialized

[--28T17::,][INFO ][o.e.n.Node ] [0bC8MSi] starting ...

[--28T17::,][INFO ][o.e.t.TransportService ] [0bC8MSi] publish_address {192.168.23.151:}, bound_addresses {[::]:}

[--28T17::,][INFO ][o.e.b.BootstrapChecks ] [0bC8MSi] bound or publishing to a non-loopback or non-link-local address, enforcing bootstrap checks

[--28T17::,][INFO ][o.e.c.s.ClusterService ] [0bC8MSi] new_master {0bC8MSi}{0bC8MSi_SUywaqz_Zl-MFA}{xcbC53RVSHajdLop7sdhpA}{192.168.23.151}{192.168.23.151:}, reason: zen-disco-elected-as-master ([] nodes joined)

[--28T17::,][INFO ][o.e.h.n.Netty4HttpServerTransport] [0bC8MSi] publish_address {192.168.23.151:}, bound_addresses {[::]:}

[--28T17::,][INFO ][o.e.n.Node ] [0bC8MSi] started

[--28T17::,][INFO ][o.e.g.GatewayService ] [0bC8MSi] recovered [] indices into cluster_state

[--28T17::,][INFO ][o.e.c.r.a.AllocationService] [0bC8MSi] Cluster health status changed from [RED] to [YELLOW] (reason: [shards started [[.kibana][]] ...]).

4. kibana

它的配置也非常简单,你需要在kibana.yml文件中指定一下你需要读取的elasticSearch地址和可供外网访问的bind地址就可以了。

[root@slave1 config]# pwd

/usr/myapp/kibana/config [root@slave1 config]# vim kibana.yml elasticsearch.url: "http://localhost:9200"

server.host: 0.0.0.0

然后就是启动,从日志中可以看出,当前开了5601端口。

[root@slave1 kibana]# cd bin

[root@slave1 bin]# ls

kibana kibana-plugin nohup.out

[root@slave1 bin]# ./kibana

log [::27.650] [info][status][plugin:kibana@5.2.] Status changed from uninitialized to green - Ready

log [::27.748] [info][status][plugin:elasticsearch@5.2.] Status changed from uninitialized to yellow - Waiting for Elasticsearch

log [::27.786] [info][status][plugin:console@5.2.] Status changed from uninitialized to green - Ready

log [::27.794] [warning] You're running Kibana 5.2.0 with some different versions of Elasticsearch. Update Kibana or Elasticsearch to the same version to prevent compatibility issues: v5.6.4 @ 192.168.23.151:9200 (192.168.23.151)

log [::27.811] [info][status][plugin:elasticsearch@5.2.] Status changed from yellow to green - Kibana index ready

log [::28.250] [info][status][plugin:timelion@5.2.] Status changed from uninitialized to green - Ready

log [01:23:28.255] [info][listening] Server running at http://0.0.0.0:5601

log [::28.259] [info][status][ui settings] Status changed from uninitialized to green - Ready

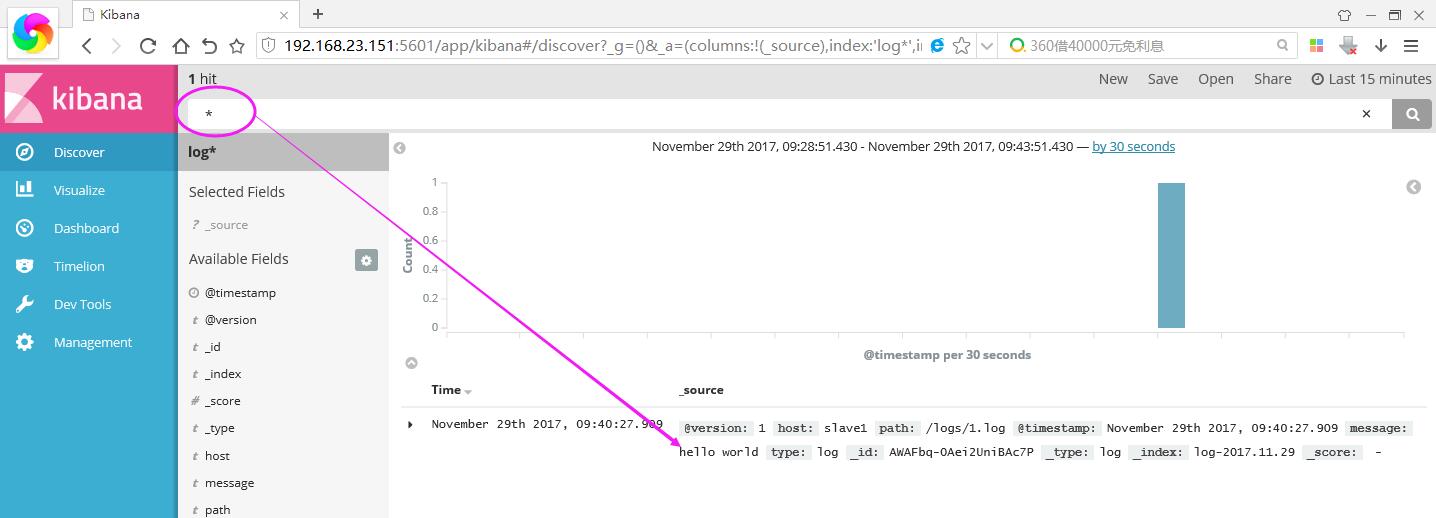

5. 浏览器中输入:http://192.168.23.151:5601/ 你就可以打开kibana页面了,,默认让我指定一个查看的Index。

接下来我们在本机的/logs文件夹下创建一个简单的1.log文件,内容为“hello world”,然后在kibana上将logstash-* 改成 log* ,Create按钮就会自动出来。

[root@slave1 logs]# echo 'hello world' > .log

进入之后,点击Discover,你就可以找到你输入的内容啦~~~~ 是不是很帅气。。。

如果你装了head安装包,你还可以看到它确实带了日期模式的Index索引,还自带5个默认分片数。

好了,本篇就说这么多吧,希望对你有帮助。

通过ELK快速搭建一个你可能需要的集中化日志平台的更多相关文章

- 快速搭建一个Quartz定时任务【转载,好文 ,值得收藏,亲身试用 效果不错】

Quartz.NET 入门 概述 Quartz.NET是一个开源的作业调度框架,非常适合在平时的工作中,定时轮询数据库同步,定时邮件通知,定时处理数据等. Quartz.NET允许开发人员根据时间间隔 ...

- NodeJS 最快速搭建一个HttpServer

最快速搭建一个HttpServer 在目录里放一个index.html cd D:\Web\InternalWeb start http-server -i -p 8081

- vuejsLearn---通过手脚架快速搭建一个vuejs项目

开始快速搭建一个项目 通过Webpack + vue-loader 手脚架 https://github.com/vuejs-templates/webpack 按照它的步骤一步一步来 $ npm i ...

- [原创] zabbix学习之旅五:如何快速搭建一个报警系统

通过之前的文章,我们已搭建好zabbix server.agent和mail客户端,现在万事俱备,只差在server的界面中进行相应配置,即可快速搭建一个报警系统.总的来说,快速搭建一个报警系统的顺序 ...

- 快速搭建一个本地的FTP服务器

快速搭建一个本地的FTP服务器 如果需要开发FTP文件上传下载功能,那么需要在本机上搭建一个本地FTP服务器,方便调试. 第一步:配置IIS Web服务器 1.1 控制面板中找到"程序& ...

- 快速搭建一个Spring Boot + MyBatis的开发框架

前言:Spring Boot的自动化配置确实非常强大,为了方便大家把项目迁移到Spring Boot,特意总结了一下如何快速搭建一个Spring Boot + MyBatis的简易文档,下面是简单的步 ...

- 快速搭建一个直播Demo

缘由 最近帮朋友看一个直播网站的源码,发现这份直播源码借助 阿里云 .腾讯云这些大公司提供的SDK 可以非常方便的搭建一个直播网站.下面我们来给大家讲解下如何借助 腾讯云 我们搭建一个简易的 直播示例 ...

- 快速搭建一个“微视”类短视频 App

欢迎大家前往腾讯云+社区,获取更多腾讯海量技术实践干货哦~ 本文由腾讯云视频发表于云+社区专栏 关注公众号"腾讯云视频",一键获取 技术干货 | 优惠活动 | 视频方案 " ...

- 【Head First Servlets and JSP】笔记6:什么是响应首部 & 快速搭建一个简单的测试环境

搭建简单的测试环境 什么是响应首部 最简单的响应首部——Content-Type 设置响应首部 请求重定向与响应首部 在浏览器中查看Response Headers 1.先快速搭建一个简单的测试环境, ...

随机推荐

- Linux系列教程(一)——Linux系统简介

本系列教程将完整的讲解整个Linux相关的知识,这是楼主学完之后重新对Linux知识体系的整理.从最基础的知识开始,对于一个完全不懂Linux系统的人,相信在看完整个系列教程之后,都能对Linux有一 ...

- 【转】FIO使用指南

原文地址:http://blog.csdn.net/yuesichiu/article/details/8722417 Fio压测工具和io队列深度理解和误区 这个文档是对fio-2.0.9 HOWT ...

- LINUX 笔记-DU 和 DF

du(disk usage)搜索文件统计文件大小 1.显示指定文件所占空间 du file1 file2 2.显示指定目录占的空间 du dir 3.只显示总和大小 du -s 4.以方便格式显示 d ...

- 学习SVG 重点汇总

什么是SVG? Δ SVG 指可伸缩矢量图形 (Scalable Vector Graphics) Δ SVG 用来定义用于网络的基于矢量的图形 Δ SVG使用XML格式来定义图形 Δ SVG ...

- angularJs 个人初探笔记

1.环境搭建与angular - phoneCat 安装可以通过git clone来下载源代码: git clone --depth=14 https://github.com/angular/ang ...

- 1_ROS学习

1_搭建树莓派环境 树莓派是一个嵌入式计算机,专门用来做嵌入式开发的.我们组上用的树莓派是raspberry pi 3 mode B,5V供电,最大电流不超过2A: 我们需要在树莓派上安装上操作系统. ...

- sqoop1.4.6配置安装

1.下载sqoop1.4.6 2.配置环境变量. 3.复制sqoop/conf/sqoop-env-template.sh为sqoop-env.sh 添加相关的配置 #Setpath to where ...

- Hive简单安装

数据库的创建 Hive1版本 在此之前要安装好JDK,HADOOP,下载解压Hive 在root下安装mysql:yum install mysql-server mysql-client //一般M ...

- AngularJS学习篇(二十三)

AngularJS 路由 AngularJS 路由允许我们通过不同的 URL 访问不同的内容. 通过 AngularJS 可以实现多视图的单页Web应用(single page web applica ...

- linux中安装Python3.x

首先了解几句Linux命令是必须的.例如 ls, vi, wget, rm, mv, cd, su, sudo, chmod, tar等等一些常用的语句命令是有必要知道它的用法的. 安装Python3 ...