11scrapy

一. Scrapy基础概念

Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架,我们只需要实现少量的代码,就能够快速的抓取。Scrapy 使用了 Twisted异步网络框架,可以加快我们的下载速度。

二. 操作

1. 基本操作

1)创建一个scrapy项目

scrapy startproject mySpider

2)生成一个爬虫

scrapy genspider itcast "itcast.cn”

3)提取数据

完善spider,使用xpath等方法

4)保存数据

pipeline中保存数据

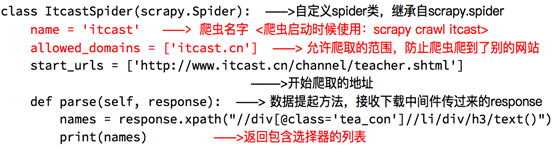

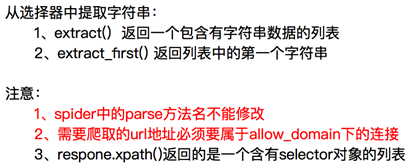

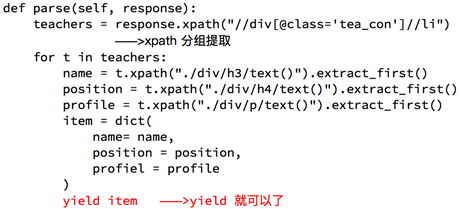

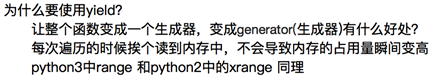

2. 完善spdier

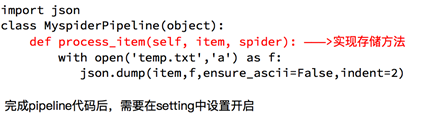

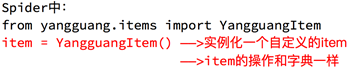

3. spdier数据传到pipeline

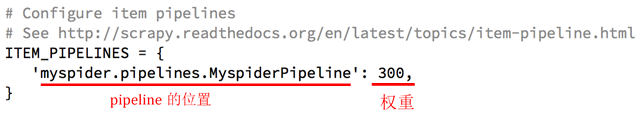

4. 使用·pipeline

5. 设置log

为了让我们自己希望输出到终端的内容能容易看一些:

我们可以在setting中设置log级别

在setting中添加一行(全部大写):LOG_LEVEL = "WARNING”

默认终端显示的是debug级别的log信息

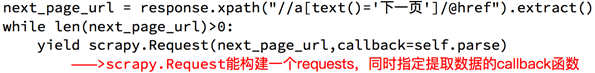

三. 实行翻页操作

1. 获取地址,使用scrapy.Request方法

需要传递数据时,可以在方法中传递meta:

yield scrapy.Request(next_page_url,callback=self.parse,meta=…)

dont_filter:让scrapy不会过滤当前url

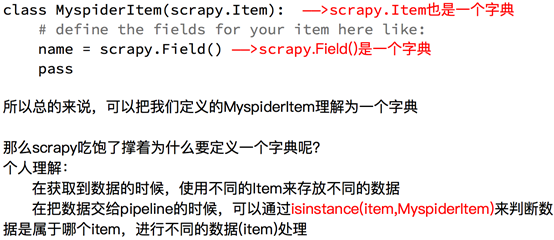

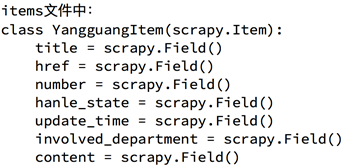

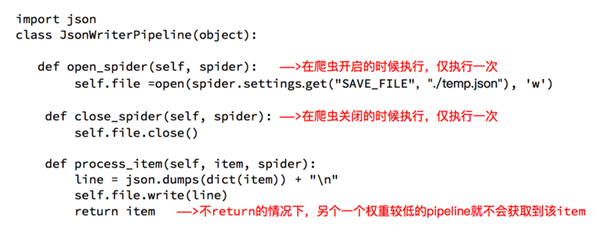

四. 定义Item

1. 方法

2. 实例

3. 在不同的解析函数中传递参数

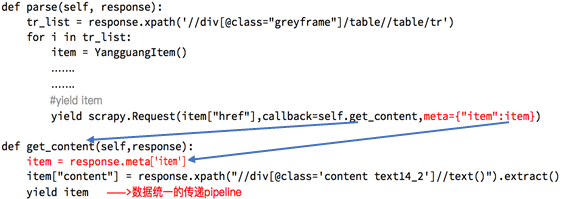

五. 深入pipeline

可以将一些需要初始化的数值添加在open_spider方法中

而close_spider可以做一些收尾工作

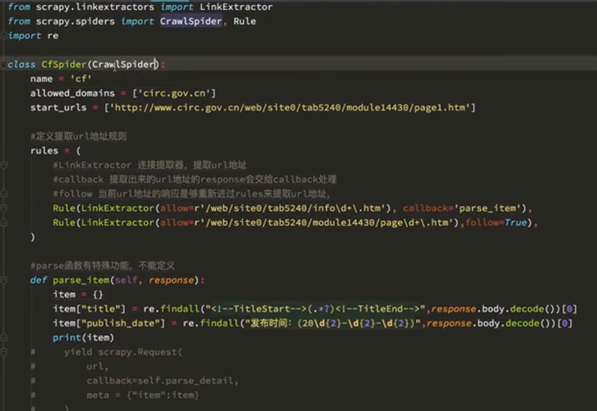

六. CrawlSpider

1. 功能

1)我们把满足某个条件的url地址传给rules,同时能够指定callback函数。不需要手动去找下一页的url地址,达到简化代码的目的

2)生成CrawlSpider的命令

scrapy genspider –t crawl 项目名 “域名”

2. 实例

rules内的几个参数:

1) LinkExtractor 连接提取器,提取url地址

2) callback 提取出来的url地址的response会交给callback来处理

3) follow 当前url地址的响应是否重新进rules来提取url地址

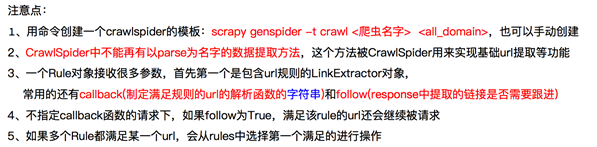

3. 注意点

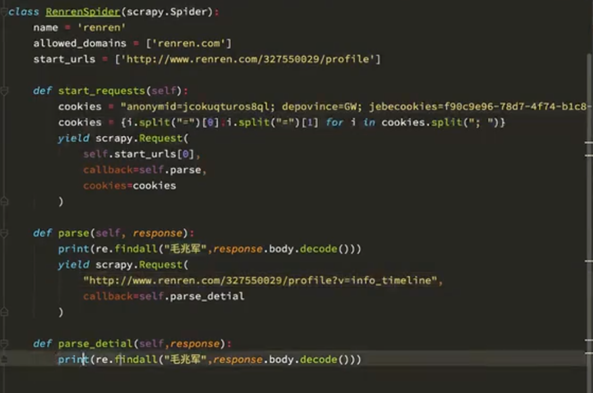

七. Scrapy模拟登录

1. 携带cookie登录

1)直接携带cookie,在浏览器登录之后获取检查里边cookies的值

2)找到发送post请求的url地址,带上信息,发送请求

可以在settings里边添加参数【COOKIES_DEBUG=True】观察cookies的传递过程。

不能把cookies放在headers中

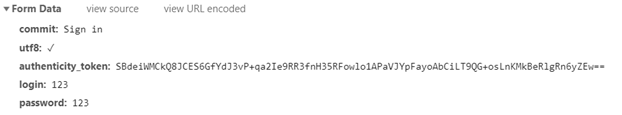

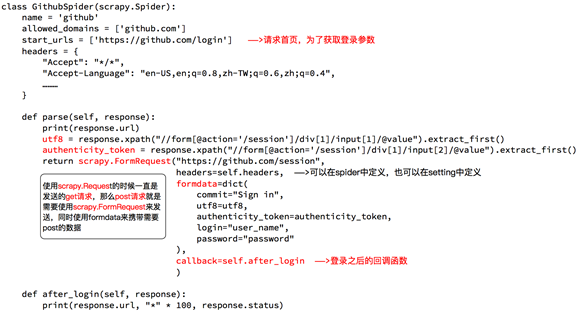

2. 使用FormRequest

1) scrapy.FormRequest(url,formdata={},callback) formdata请求体

2) formdata里边的数据,可以试着在浏览器输入用户名和密码之后,在session的Headers里边找到formdata,接着在Elements中查找对应的组件

3)示例

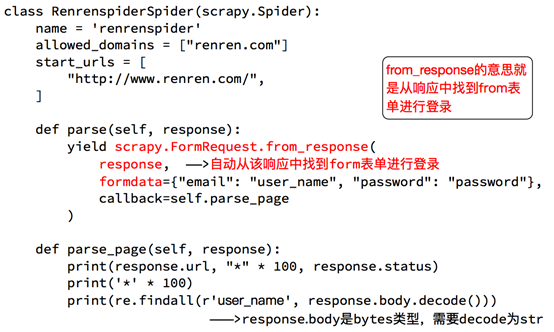

3. 自动寻找Form表单中action的url

1) scrapy.FormRequest.from_response(response,formdata={},callback)

2) 示例

八. 案例分析

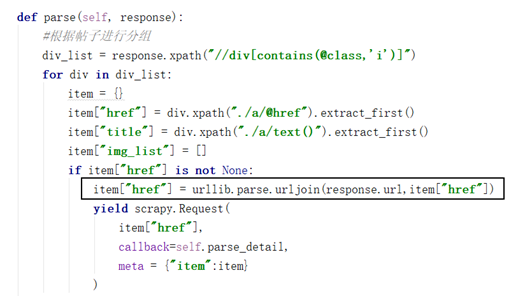

1. 贴吧爬虫

1.1 补充不完整的链接

注意:需要导入import urllib

通过urljoin方法自动把链接补全

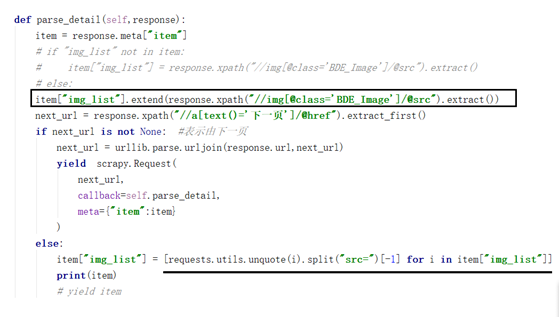

1.2 对图片解码以及翻页时处理内容覆盖的问题

1) 图片解码:需要import requests

item["img_list"] = [requests.utils.unquote(i).split("src=")[-1] for i in item["img_list"]]

2) 翻页使用extend()来处理

item["img_list"].extend(response.xpath("//img[@class='BDE_Image']/@src").extract())

1.3 spider下的tb.py完整代码

import scrapy

import urllib

import requests

class TbSpider(scrapy.Spider):

name = 'tb'

allowed_domains = ['tieba.baidu.com']

start_urls = ['http://tieba.baidu.com/mo/q----,sz@320_240-1-3---2/m?kw=%E6%9D%8E%E6%AF%85&lp=9001']

def parse(self, response):

#根据帖子进行分组

div_list = response.xpath("//div[contains(@class,'i')]")

for div in div_list:

item = {}

item["href"] = div.xpath("./a/@href").extract_first()

item["title"] = div.xpath("./a/text()").extract_first()

item["img_list"] = []

if item["href"] is not None:

item["href"] = urllib.parse.urljoin(response.url,item["href"])

yield scrapy.Request(

item["href"],

callback=self.parse_detail,

meta = {"item":item}

)

#列表页的翻页

next_url = response.xpath("//a[text()='下一页']/@href").extract_first()

if next_url is not None:

next_url = urllib.parse.urljoin(response.url,next_url)

yield scrapy.Request(

next_url,

callback=self.parse,

)

def parse_detail(self,response):

item = response.meta["item"]

# if "img_list" not in item:

#item["img_list"] = response.xpath("//img[@class='BDE_Image']/@src").extract()

# else:

item["img_list"].extend(response.xpath("//img[@class='BDE_Image']/@src").extract())

next_url = response.xpath("//a[text()='下一页']/@href").extract_first()

if next_url is not None: #表示由下一页

next_url = urllib.parse.urljoin(response.url,next_url)

yield scrapy.Request(

next_url,

callback=self.parse_detail,

meta={"item":item}

)

else:

item["img_list"] = [requests.utils.unquote(i).split("src=")[-1] for i in item["img_list"]]

print(item)

# yield item

11scrapy的更多相关文章

- 11-scrapy(递归解析,post请求,日志等级,请求传参)

一.递归解析: 需求:将投诉_阳光热线问政平台中的投诉标题和状态网友以及时间爬取下来永久储存在数据库中 url:http://wz.sun0769.com/index.php/question/que ...

随机推荐

- Goroutine被动调度之一(18)

本文是<Go语言调度器源代码情景分析>系列的第18篇,也是第四章<Goroutine被动调度>的第1小节. 前一章我们详细分析了调度器的调度策略,即调度器如何选取下一个进入运行 ...

- PTA QQ Account Manageme【map的巧妙应有】

5-27 QQ Account Management (25分) You are supposed to implement the functions of account "Log in ...

- ssh配置详解及公私钥批量分发

第一:ssh配置文件详解 第二:ssh公私密钥的生成 第三:ssh公钥分发之一:ssh自带工具ssh-copy-id工具分发 第四:ssh公钥分发之二:编写sshpass脚本批量分发 第五:ssh公钥 ...

- Fast Bit Calculations LightOJ - 1032

Fast Bit Calculations LightOJ - 1032 题意:求0到n的所有数的二进制表示中,"11"的总数量.(如果有连续的n(n>2)个1,记(n-1) ...

- 线段树(单点更新) HDOJ 4288 Coder

题目传送门 #include <cstdio> #include <cstring> #define lson l, m, rt << 1 #define rson ...

- android draw9patch工具使用

1.作用 将图片制作android .9图片xxx.9.png xxx.9.jpg xxx.9.gif 这些图片在android上拉伸时,边角不变形,不影响效果. 2.工具位置 Android的S ...

- Python+selenium定位不到元素的问题及解决方案

在操作过程中主要遇到两种阻塞的问题,总结如下: 1.页面中有iframe,定位元素时,需要用switch_to.frame()转换到元素所在的frame上再去定位 2.遇到一种新情况,有些按钮在htm ...

- nginx 80端口重定向到443端口

server { listen ; server_name www.域名.com; rewrite ^(.*)$ https://${server_name}$1 permanent; } serve ...

- 基于udp协议的套接字及udp协议粘包问题

udp协议的套接字 udp协议传输 服务端和客户端没有建立连接一说. import socket # 总结一下基础工作流程:服务端生成套接字并绑定ip_port,进入数据传输循环,服务端接受客户端发 ...

- 生成器的send方法

send 和next区别 next:唤醒并继续执行 send:唤醒并继续执行 发送信息到生成器内部. def fib(max): n,a,b = 0,0,1 while n < max: msg ...