莫烦大大TensorFlow学习笔记(8)----优化器

一、TensorFlow中的优化器

- tf.train.GradientDescentOptimizer:梯度下降算法

- tf.train.AdadeltaOptimizer

- tf.train.AdagradOptimizer

- tf.train.MomentumOptimizer:动量梯度下降算法

- tf.train.AdamOptimizer:自适应矩估计优化算法

- tf.train.RMSPropOptimizer

- tf.train.AdagradDAOptimizer

- tf.train.FtrlOptimizer

- tf.train.ProximalGradientDescentOptimizer

- tf.train.ProximalAdagradOptimizertf.train.RMSProOptimizer

(1)如果数据是稀疏的,使用自适应学习方法。

(2)RMSprop,Adadelta,Adam是非常相似的优化算法,Adam的bias-correction帮助其在最后优化期间梯度变稀疏的情况下略微战胜了RMSprop。整体来讲,Adam是最好的选择。

(3)很多论文中使用vanilla SGD without momentum。SGD通常能找到最小值,但是依赖健壮的初始化,并且容易陷入鞍点。因此,如果要获得更快的收敛速度和训练更深更复杂的神经网络,需要选择自适应学习方法。

https://blog.csdn.net/winycg/article/details/79363169

二、常用的种类:

1、tf.train.Optimizer:

2、tf.train.GradientDescentOptimizer:梯度下降

原理:

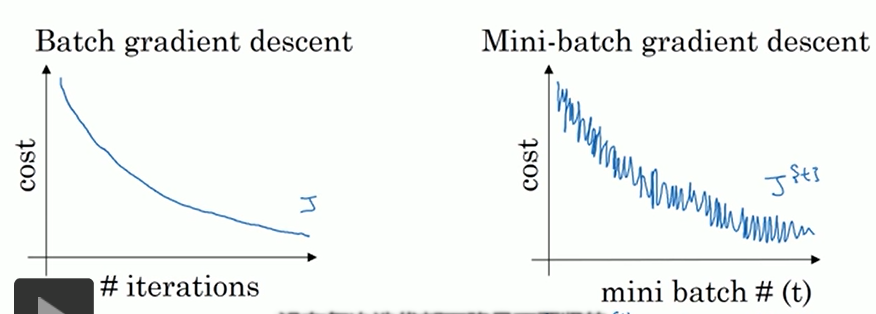

batch GD【全部样本,速度慢】

随机GD【随机一个样本,速度快,但局部最优】

mini-batch GD 【batch个样本,常在数据量较大时使用】

训练集样本数少【≤2000】:采用batchGD

训练集样本数多:采用mini-batch GD,batch大小一般为64-512. 训练时多尝试一下2的次方来找到最合适的batch大小。

应用:

这个类是实现梯度下降算法的优化器。这个构造函数需要的一个学习率就行了。

构造函数:tf.train.GradientDescentOptimizer(0.001).minimize(loss,global_step=None,var_list=None,gate_gradients=GATE_OP,aggregation_method=None,colocate_gradients_with_ops=False,name=None,grad_loss=None)

__init__(

learning_rate,

use_locking=False,

name='GradientDescent'

)

learning_rate: (学习率)张量或者浮点数

use_locking: 为True时锁定更新

name: 梯度下降名称,默认为"GradientDescent".

3、tf.train.AdadeltaOptimizer:

实现了 Adadelta算法的优化器,可以算是下面的Adagrad算法改进版本。

构造函数: tf.train.AdadeltaOptimizer.init(learning_rate=0.001, rho=0.95, epsilon=1e-08, use_locking=False, name=’Adadelta’)

4、tf.train.AdagradOptimizer:

构造函数:tf.train.AdagradOptimizer.__init__(learning_rate, initial_accumulator_value=0.1, use_locking=False, name=’Adagrad’)

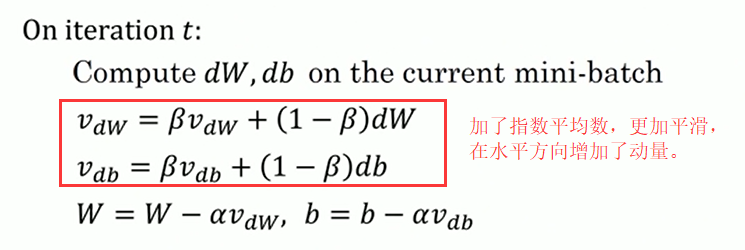

5、tf.train.MomentumOptimizer:

原理:

momentum表示要在多大程度上保留原来的更新方向,这个值在0-1之间,在训练开始时,由于梯度可能会很大,所以初始值一般选为0.5;当梯度不那么大时,改为0.9。 α是学习率,即当前batch的梯度多大程度上影响最终更新方向,跟普通的SGD含义相同。

应用:

构造函数:tf.train.MomentumOptimizer.__init__(learning_rate, momentum, use_locking=False, name=’Momentum’, use_nesterov=False)

__init__(

learning_rate,

momentum,

use_locking=False,

name='Momentum',

use_nesterov=False

)

learning_rate: (学习率)张量或者浮点数

momentum: (动量)张量或者浮点数

use_locking: 为True时锁定更新

name: 梯度下降名称,默认为 "Momentum".

use_nesterov: 为True时,使用 Nesterov Momentum.

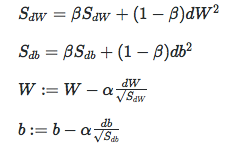

6、tf.train.RMSPropOptimizer

目的和动量梯度一样,减小垂直方向,增大水平方向。W为水平方向,b为垂直方向。

7、tf.train.AdamOptimizer:动量和RMSProp结合

应用:

__init__(

learning_rate=0.001,

beta1=0.9,

beta2=0.999,

epsilon=1e-08,

use_locking=False,

name='Adam'

)

构造函数:tf.train.AdamOptimizer.__init__(learning_rate=0.001, beta1=0.9, beta2=0.999, epsilon=1e-08, use_locking=False, name=’Adam’)

learning_rate: (学习率)张量或者浮点数,需要调试

beta1: 浮点数或者常量张量 ,表示 The exponential decay rate for the 1st moment estimates.【推荐使用0.9】

beta2: 浮点数或者常量张量 ,表示 The exponential decay rate for the 2nd moment estimates.【推荐使用0.999】

epsilon: A small constant for numerical stability. This epsilon is "epsilon hat" in the Kingma and Ba paper (in the formula just before Section 2.1), not the epsilon in Algorithm 1 of the paper.

use_locking: 为True时锁定更新

name: 梯度下降名称,默认为 "Adam".

莫烦大大TensorFlow学习笔记(8)----优化器的更多相关文章

- 莫烦大大TensorFlow学习笔记(9)----可视化

一.Matplotlib[结果可视化] #import os #os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2' import tensorflow as tf i ...

- 莫烦python教程学习笔记——总结篇

一.机器学习算法分类: 监督学习:提供数据和数据分类标签.--分类.回归 非监督学习:只提供数据,不提供标签. 半监督学习 强化学习:尝试各种手段,自己去适应环境和规则.总结经验利用反馈,不断提高算法 ...

- 莫烦python教程学习笔记——保存模型、加载模型的两种方法

# View more python tutorials on my Youtube and Youku channel!!! # Youtube video tutorial: https://ww ...

- 莫烦python教程学习笔记——validation_curve用于调参

# View more python learning tutorial on my Youtube and Youku channel!!! # Youtube video tutorial: ht ...

- 莫烦python教程学习笔记——learn_curve曲线用于过拟合问题

# View more python learning tutorial on my Youtube and Youku channel!!! # Youtube video tutorial: ht ...

- 莫烦python教程学习笔记——利用交叉验证计算模型得分、选择模型参数

# View more python learning tutorial on my Youtube and Youku channel!!! # Youtube video tutorial: ht ...

- 莫烦python教程学习笔记——数据预处理之normalization

# View more python learning tutorial on my Youtube and Youku channel!!! # Youtube video tutorial: ht ...

- 莫烦python教程学习笔记——线性回归模型的属性

#调用查看线性回归的几个属性 # Youtube video tutorial: https://www.youtube.com/channel/UCdyjiB5H8Pu7aDTNVXTTpcg # ...

- 莫烦python教程学习笔记——使用波士顿数据集、生成用于回归的数据集

# View more python learning tutorial on my Youtube and Youku channel!!! # Youtube video tutorial: ht ...

随机推荐

- mysql中的高级查询语句

此随笔用到的数据全是来自 关于mysql中表关系的一些理解(一对一,一对多,多对多) 提及的 学院表,学生表,学生详情表,选课表,课程表 单标查询:(查看学生表的学生名单) select st ...

- Spring MVC学习总结(2)——Spring MVC常用注解说明

使用Spring MVC的注解及其用法和其它相关知识来实现控制器功能. 02 之前在使用Struts2实现MVC的注解时,是借助struts2-convention这个插件,如今我们使 ...

- netty使用MessageToByteEncoder 自定义协议(四)

开发应用程序与应用程序之间的通信,程序之前通信 需要定义协议,比如http协议. 首先我们定义一个协议类 package com.liqiang.SimpeEcode; import java.sql ...

- PHP5.5下安装配置EcShop

建议用较旧的PHP版本与EcShop搭配,比如PHP5.3,新版的PHP有很多奇奇怪怪的问题... 错误描述: Deprecated: preg_replace(): The /e modifier ...

- ZOJ - 3483 - Gaussian Prime

先上题目: Gaussian Prime Time Limit: 3 Seconds Memory Limit: 65536 KB In number theory, a Gaussian ...

- cogs 10. 信号无错传输

10. 信号无错传输 ★★☆ 输入文件:dlj.in 输出文件:dlj.out 简单对比时间限制:1 s 内存限制:128 MB [问题描述] 为提高传递信息的保密性和可靠性,两个军事 ...

- POJ 1329

模板题,注意一下输出就可以. #include <iostream> #include <cstdio> #include <cmath> #include < ...

- [Javascript Crocks] Create a Maybe with a `safe` Utility Function

In this lesson, we’ll create a safe function that gives us a flexible way to create Maybes based on ...

- 使用java -jar运行jar包

使用java -jar运行jar包 摘要 其实不难,网上搜了不少,但是讲不全,或者讲得不少,有的细节却漏掉了, 在此,我想将详细点 java -jar 1.其实命令比较简单:进入相应的目录后,执行ja ...

- js实现原生Ajax的封装及ajax原理详解

原理及概念 AJAX即“Asynchronous Javascript And XML”(异步JavaScript和XML),是一种用于创建快速动态网页的技术. 动态网页:是指可以通过服务器语言结合数 ...