CS224d lecture 9札记

欢迎转载。转载注明出处:

http://blog.csdn.net/neighborhoodguo/article/details/47193885

近期几课的内容不是非常难。还有我的理解能力有所提高(自恋一下)。所以这几课完毕的都挺快。不知不觉lec9也完毕了。这一讲讲了还有一个RNN,当中R是Recursive不是之前的Recurrent。

课上老师使用Recursive NN来做NLP和CV的任务,我个人觉得做CV还是不错的。这个NLP怎么感觉有点不靠谱。无论怎么说这个model还是攻克了非常多实际问题的。并且性能也不错,如今就来记录记录喽。

首先来梳理一下这一课讲得内容吧。首先讲了怎样把一个sentence进行vector表示,再是怎样进行parsing,然后是构建object function的方法max-margin以及BPTS(Backpropagation Through Structure)。最后是Recursive NN的几个改良版还有这个model也能够进行computer vision的工作。

1.Semantic Vector Space for sentence

类似上一阶段的word vector space这次我们是将一整个sentence投影到semantic vector spaces中。

我们的模型是基于这样两个如果:一个句子的意思是基于1.这个句子所包括单词的意思;2.这个句子的构建方式。当中第二点还在争论中,我们这一讲讨论的模型能够同一时候完毕两个任务,第一能够学出来这个句子的tree模型,第二能够学出来这个句子在semantic vector space里的表示。

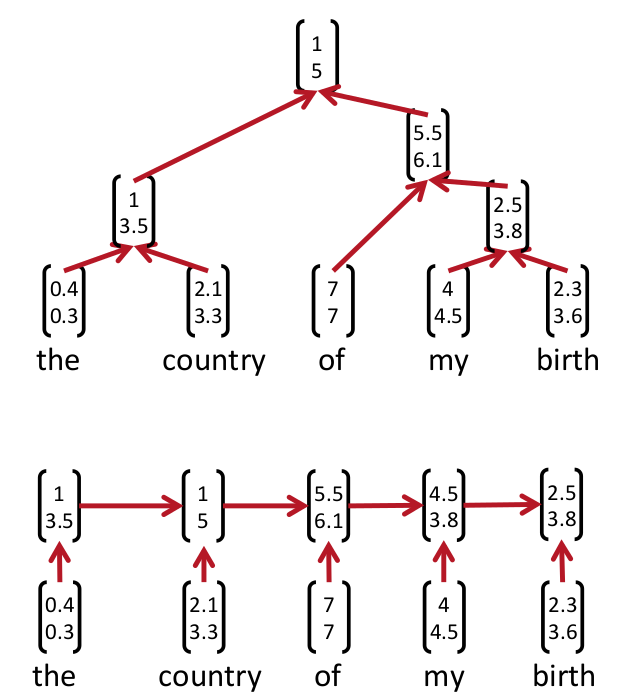

Parsing tree是什么呢?上图:

当中上面那个图就是在这一讲里所述的parsing tree。而上一讲的recurrent neural networks事实上类似以下的parsing tree它被视作是上一种parsing tree的特殊表示方式。

这两种表示方法究竟哪个正确如今还没有定论(still cognitively debatable)

如何学出来这个parsing tree呢?聪明的人类发明了一个方法叫beam search就是bottom-up的方法。从最低下開始,计算哪两个成为好基友的score最大,然后取出来最大的score的俩个node然后他俩就merge了(好邪恶)。最后一直到最上面所有都merge起来了就形成了一个parsing tree。

2.objection function?Max-margin framework

slide里的objection function我之后參阅了recommand reading里的object function发现不一样正负号是反的。

我推測是不是老师写得时候给写反了??

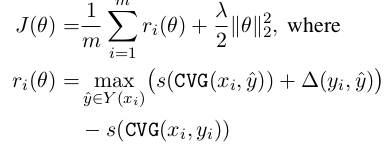

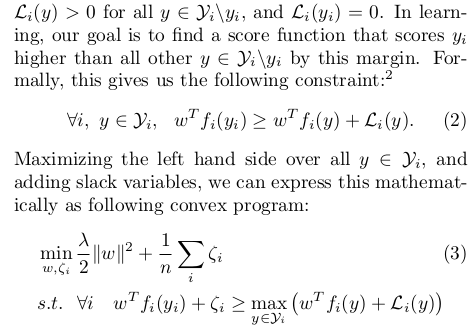

论文里给出的object function是这种。当中delta(yi, y_hat)是依据标记错误的node数量再乘以一个k得出的:

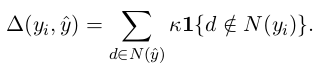

score有两个部分:

前半段的v是要通过我们的model学习出来的,后半段是log probability of the PCFG也就是这玩意发生的概率并转成log space下。

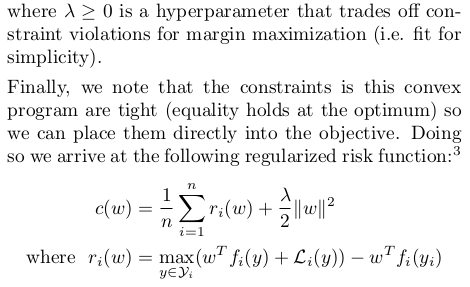

课上讲得max-margin不太具体。第二篇论文里面讲得挺好。这里摘抄出来:

最后得到max-margin的公式。我们的目的是使得c(w)最小

这样为什么就是最优的呢,我想了半天才想出来这里用通俗点的话记录一下:假设w不是最优的w那么max()里左边的score选出来的不是y_i,再加上L_i那么终于肯定是ri非常大,必定不是最小的。假设w是最优的呢?那肯定max()选出来的是yi。delta肯定为零。然后整体必定最小。这种w必定使得score(y_i)比其它全部的score(y)大,而且大出来一个L_i(y)的margin。

3.BPTS

BPTS论文里讲得比較少。slide里讲得还挺具体还有pset2的部分代码还是不错滴。

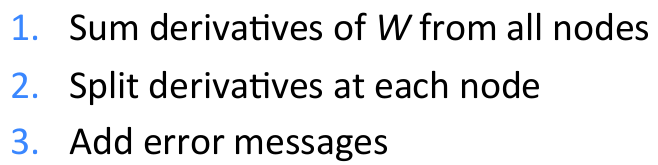

BPTS和之前的传统BP有三个差别:

第一点是说求w的gradient要sum全部node的;第二点我感觉是用来更新semantic vector space里的vector的。第三点还要加一个error message:Total error messages = error messages from parent + error message from own score

BPTS的parameters更新的改进方法能够调整learning rate或者使用subgradient(使用subgradient的方法论文里有讲,cs229里也有将一个smo方法比較类似)

4.Recursive NN的改良版

前半段讲得都是最简单的simple RNN。

最后讲了一个改良版的SU-RNN(syntactically-untied RNN)

也就是weight依据children的type的不同而进行不同的选择。

最后有一个CV的展示,就是说RNN对于NLP的操作和CV差点儿相同都是一步一步分解。

Website:

nlp.stanford.edu

http://repository.cmu.edu/robotics

www.socher.org

CS224d lecture 9札记的更多相关文章

- 【转载】 深度学习与自然语言处理(1)_斯坦福cs224d Lecture 1

版权声明:本文为博主原创文章,未经博主允许不得转载. 原文地址http://blog.csdn.net/longxinchen_ml/article/details/51567960 目录(?)[- ...

- 【深度学习Deep Learning】资料大全

最近在学深度学习相关的东西,在网上搜集到了一些不错的资料,现在汇总一下: Free Online Books by Yoshua Bengio, Ian Goodfellow and Aaron C ...

- DL4NLP——词表示模型(二)基于神经网络的模型:NPLM;word2vec(CBOW/Skip-gram)

本文简述了以下内容: 神经概率语言模型NPLM,训练语言模型并同时得到词表示 word2vec:CBOW / Skip-gram,直接以得到词表示为目标的模型 (一)原始CBOW(Continuous ...

- TensorFlow 中文资源全集,官方网站,安装教程,入门教程,实战项目,学习路径。

Awesome-TensorFlow-Chinese TensorFlow 中文资源全集,学习路径推荐: 官方网站,初步了解. 安装教程,安装之后跑起来. 入门教程,简单的模型学习和运行. 实战项目, ...

- 神经网络训练tricks

神经网络构建好,训练不出好的效果怎么办?明明说好的拟合任意函数(一般连续)(为什么?可以参考http://neuralnetworksanddeeplearning.com/),说好的足够多的数据(h ...

- 机器学习算法实现解析——word2vec源代码解析

在阅读本文之前,建议首先阅读"简单易学的机器学习算法--word2vec的算法原理"(眼下还没公布).掌握例如以下的几个概念: 什么是统计语言模型 神经概率语言模型的网络结构 CB ...

- Awesome TensorFlow

Awesome TensorFlow A curated list of awesome TensorFlow experiments, libraries, and projects. Inspi ...

- TensorFlow 中文资源精选,官方网站,安装教程,入门教程,实战项目,学习路径。

Awesome-TensorFlow-Chinese TensorFlow 中文资源全集,学习路径推荐: 官方网站,初步了解. 安装教程,安装之后跑起来. 入门教程,简单的模型学习和运行. 实战项目, ...

- [C2P3] Andrew Ng - Machine Learning

##Advice for Applying Machine Learning Applying machine learning in practice is not always straightf ...

随机推荐

- zoj 3820 Building Fire Stations (二分+树的直径)

Building Fire Stations Time Limit: 5 Seconds Memory Limit: 131072 KB Special Judge Marjar ...

- 前端到后台ThinkPHP开发整站--php开发案例

前端到后台ThinkPHP开发整站--php开发案例 总结 还是需要做几个案例,一天一个为佳,那样才能做得快. 从需求分析着手,任务体系要构建好,这样才能非常高效. 转自: 前端到后台ThinkPHP ...

- java9新特性-8-语法改进:钻石操作符(Diamond Operator)使用升级

1.使用说明 我们将能够与匿名实现类共同使用钻石操作符(diamond operator) 在java8中如下的操作是会报错的: 编译报错信息:'<>' cannot be used ...

- VS10的一个问题

今天遇到一个问题,LINK : fatal error LNK1123: 转换到 COFF 期间失败: 文件无效或损坏.转一下网上的解决办法http://bbs.csdn.net/topics/390 ...

- [ZJOI2012]旅游 对偶图 树的直径

Code: // luogu-judger-enable-o2 #include<cstdio> #include<iostream> #include<algorith ...

- whoami---打印当前有效的用户名称

whoami命令用于打印当前有效的用户名称,相当于执行id -un命令. 语法 whoami(选项) 选项 --help:在线帮助: --version:显示版本信息. 实例 [root@localh ...

- 紫书 例题 10-7 UVa 10820 (欧拉函数)

这道题要找二元组(x, y) 满足1 <= x, y <= n 且x与y互素 那么我就可以假设x < y, 设这时答案为f(n) 那么答案就为2 * f(n) +1(x与y反过来就乘 ...

- python中的装饰器decorator

python中的装饰器 装饰器是为了解决以下描述的问题而产生的方法 我们在已有的函数代码的基础上,想要动态的为这个函数增加功能而又不改变原函数的代码 例如有三个函数: def f1(x): retur ...

- 洛谷 P1293 班级聚会

P1293 班级聚会 题目描述 毕业25年以后,我们的主人公开始准备同学聚会.打了无数电话后他终于搞到了所有同学的地址.他们有些人仍在本城市,但大多数人分散在其他的城市.不过,他发现一个巧合,所有地址 ...

- 在启动php时,无法启动此程序,由于计算机中丢失MSVCR110.dll的解决方法

在启动php时,运行RunHiddenconsole.exe php-cgi.exe -b 127.0.0.1:9000 -c时,出现错误:无法启动此程序,由于计算机中丢失MSVCR110.dll 方 ...