Spark Streaming实时计算

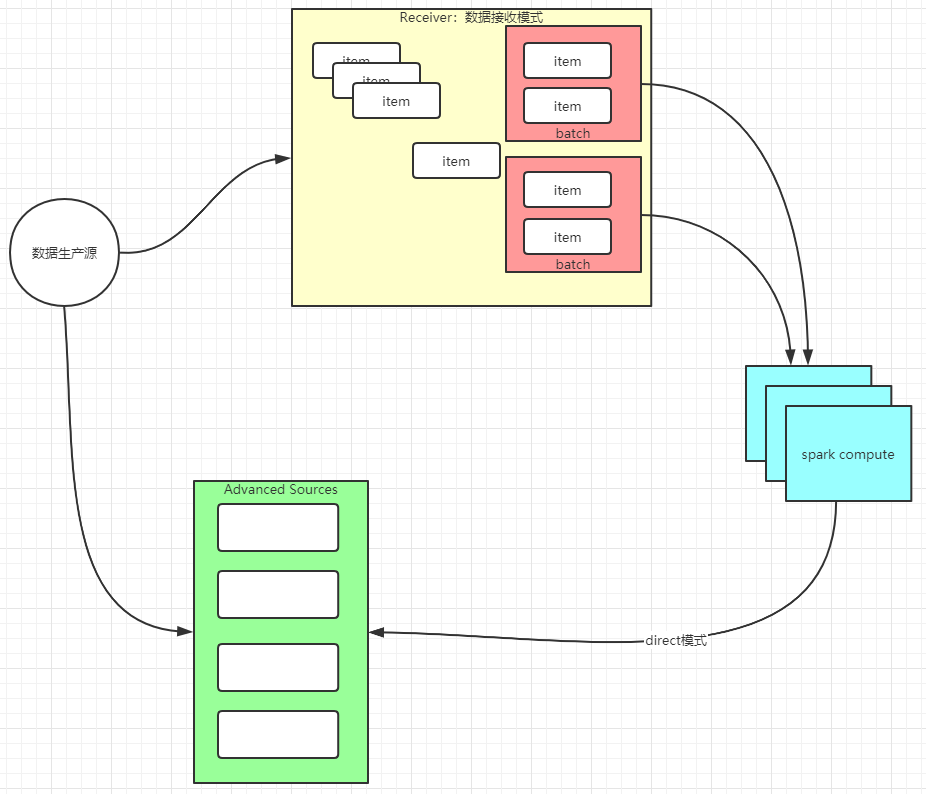

spark批处理模式:

receiver模式:接收数据流,负责数据的存储维护,缺点:数据维护复杂(可靠性,数据积压等),占用计算资源(core,memory被挤占)

direct模式:数据源由三方组件完成,spark只负责数据拉取计算,充分利用资源计算

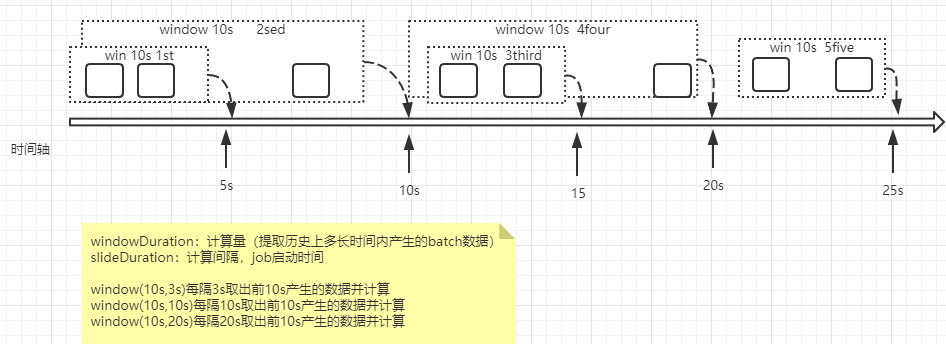

window计算:

def windowApi(): Unit = {

val conf: SparkConf = new SparkConf().setAppName("sparkstream").setMaster("local[2]")

val sc = new SparkContext(conf)

val ssc = new StreamingContext(sc, Duration(1000))

ssc.sparkContext.setLogLevel("ERROR")

val resource: ReceiverInputDStream[String] = ssc.socketTextStream("localhost",8889)

val format: DStream[(String, Int)] = resource.map(_.split(" ")).map(x=>(x(0),1))

//统计每次看到的10s的历史记录

//windowDuration窗口一次最多批次量,slideDuration滑动间隔(job启动间隔),最好等于winduration

val res: DStream[(String, Int)] = format.reduceByKeyAndWindow(_+_,Duration(10000),Duration(1000))//每一秒计算最后10s内的数据

res.print()

ssc.start()

ssc.awaitTermination()

}

window处理流程:

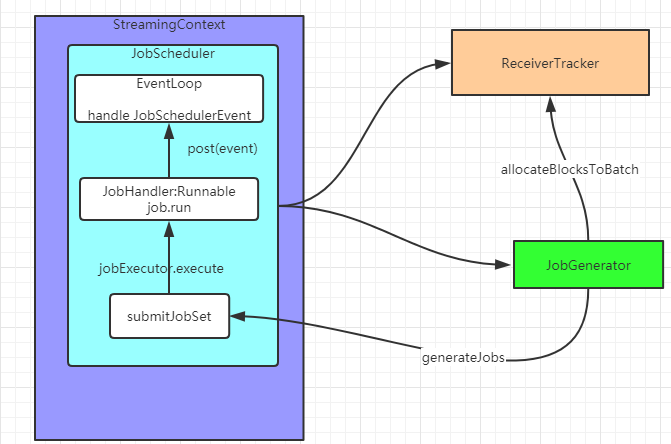

执行流程:

说明:Receiver模式下,接收器创建数据块,每间隔blockInterval 时间产生新的数据块,块的个数N = batchInterval/blockInterval。这些数据块由当前executor的BlockManager发送到其它executor的BlockManager,driver追踪块的位置为下一步计算准备

1,JobScheduler通过EventLoop消息处理机制处理job事件(jobStart,jobCompletion,jobError对job进行标记)使用ThreadPoolExecutor为每个job维护一个thread执行job.run

2,JobGenerator负责job生成,执行checkpoint,清理DStream产生的元数据,触发receiverTracker为下一批次数据建立block块的标记

stream合并与转换:

每个DStream对应一种处理,对于数据源有多种特征需要多个DStream分别处理,最后将结果在一起处理,val joinedStream = windowedStream1.join(windowedStream2)

val conf: SparkConf = new SparkConf().setAppName("sparkstream").setMaster("local[2]")

val sc = new SparkContext(conf)

val ssc = new StreamingContext(sc, Duration(1000))

ssc.sparkContext.setLogLevel("ERROR")

val resource: ReceiverInputDStream[String] = ssc.socketTextStream("localhost",8889)

val format: DStream[(String, Int)] = resource.map(_.split(" ")).map(x=>(x(0),1))

//transform 加工转换处理

val res: DStream[(String, Int)] = format.transform( //返回值是RDD

(rdd ) =>{

val rddres: RDD[(String, Int)] = rdd.map(x => (x._1, x._2 * 10))//做转换

rddres

}

)

//末端处理

format.foreachRDD( //StreamingContext 有一个独立的线程执行while(true)下面的代码是放到执行线程去执行

(rdd)=>{

rdd.foreachPartition { partitionOfRecords =>

// val connection = createNewConnection()

// to redis or mysql

// partitionOfRecords.foreach(record => connection.send(record))

// connection.close()

}

}

)

Caching / Persistence

在使用window统计时(reduceByWindow ,reduceByKeyAndWindow,updateStateByKey)Dstream会自动调用persist将结果缓存到内存(data serialized)

Checkpointing 保存两种类型数据存储

Metadata:driver端需要的数据

Configuration: application配置信息conf

DStream operations: 定义的Dstream操作集合

Incomplete batches:在队列内还没计算完成的bactch数据

Data checkpointing:已经计算完成的状态数据

设置checkpoint

val ssc = new StreamingContext(...)

ssc.checkpoint(checkpointDirectory)

dstream.checkpoint(checkpointInterval).

...... // Get StreamingContext from checkpoint data or create a new one

val context = StreamingContext.getOrCreate(checkpointDirectory, functionToCreateContext _)

context.

checkpoint依赖外存储,随着batch处理间隔的变短,会使吞吐量显著降低,因此存储间隔要合理设置,系统默认最少10s调用一次,官方建议5s-10s

Spark Streaming实时计算的更多相关文章

- Spark Streaming实时计算框架介绍

随着大数据的发展,人们对大数据的处理要求也越来越高,原有的批处理框架MapReduce适合离线计算,却无法满足实时性要求较高的业务,如实时推荐.用户行为分析等. Spark Streaming是建立在 ...

- 【Streaming】30分钟概览Spark Streaming 实时计算

本文主要介绍四个问题: 什么是Spark Streaming实时计算? Spark实时计算原理流程是什么? Spark 2.X下一代实时计算框架Structured Streaming Spark S ...

- Spark练习之通过Spark Streaming实时计算wordcount程序

Spark练习之通过Spark Streaming实时计算wordcount程序 Java版本 Scala版本 pom.xml Java版本 import org.apache.spark.Spark ...

- 【转】Spark Streaming 实时计算在甜橙金融监控系统中的应用及优化

系统架构介绍 整个实时监控系统的架构是先由 Flume 收集服务器产生的日志 Log 和前端埋点数据, 然后实时把这些信息发送到 Kafka 分布式发布订阅消息系统,接着由 Spark Streami ...

- spark streaming 实时计算

spark streaming 开发实例 本文将分以下几部分 spark 开发环境配置 如何创建spark项目 编写streaming代码示例 如何调试 环境配置: spark 原生语言是scala, ...

- 大数据开发实战:Spark Streaming流计算开发

1.背景介绍 Storm以及离线数据平台的MapReduce和Hive构成了Hadoop生态对实时和离线数据处理的一套完整处理解决方案.除了此套解决方案之外,还有一种非常流行的而且完整的离线和 实时数 ...

- 50、Spark Streaming实时wordcount程序开发

一.java版本 package cn.spark.study.streaming; import java.util.Arrays; import org.apache.spark.SparkCon ...

- Dream_Spark-----Spark 定制版:005~贯通Spark Streaming流计算框架的运行源码

Spark 定制版:005~贯通Spark Streaming流计算框架的运行源码 本讲内容: a. 在线动态计算分类最热门商品案例回顾与演示 b. 基于案例贯通Spark Streaming的运 ...

- 【慕课网实战】Spark Streaming实时流处理项目实战笔记八之铭文升级版

铭文一级: Spark Streaming is an extension of the core Spark API that enables scalable, high-throughput, ...

- 【慕课网实战】Spark Streaming实时流处理项目实战笔记二之铭文升级版

铭文一级: 第二章:初识实时流处理 需求:统计主站每个(指定)课程访问的客户端.地域信息分布 地域:ip转换 Spark SQL项目实战 客户端:useragent获取 Hadoop基础课程 ==&g ...

随机推荐

- Qt开发Active控件:如何使用ActiveQt Server开发大型软件的主框架(2)

Qt开发Active控件:如何使用ActiveQt Server开发大型软件的主框架 注:本文更多地是带着如何去思考答案,而不是纯粹的放一个答案上来,如果你需要直接看到完整的答案,请直接看实例和最后的 ...

- Javascript | 模拟mvc实现点餐程序

MVC模式是一个比较成熟的开发模式.M是指业务模型,V是指用户界面,C则是控制器,使用MVC的目的是将M和V的实现代码分离,从而使同一个程序可以使用不同的表现形式.其中,View的定义比较清晰,就是用 ...

- java顺序数组插入元素

本文主要阐明已知顺序数组,在数组中插入一个数据元素,使其仍然保持有序. 关键是寻找num在原数组中插入的位置: 当num在原数组中是最大的情况,num应该插入到原数组的末尾. 否则,应该遍历原数组,通 ...

- C#代码扫描工具Sonarqube + Win10+SqlServer2017

在之前的公司, 看到有用过代码扫描工具, 扫描C#代码, 最近公司也有考虑做这个,于是我便独自研究了一下,这里给大家做个分享 网上找了很多资料, 主要有以下问题: 1. Sonarqube用的是 旧版 ...

- vulnhub靶场之GROTESQUE: 3.0.1

准备: 攻击机:虚拟机kali.本机win10. 靶机:Grotesque: 3.0.1,下载地址:https://download.vulnhub.com/grotesque/grotesque3. ...

- go_json_learn

解析嵌套类型示例: func test3() { b := []byte(`{"Name":"tom","Age":20,"Ema ...

- 启动springboot项目报错Unable to start embedded Tomcat

1.问题描述 最近在学习springcloud的时候,在父工程下新建一个model后,引入dashboard相关依赖后启动报错 2.产生原因 产生原因有可能就是pom.xml中下载的jar包版本冲突 ...

- iOS14新特性

6月23日凌晨,苹果首次在线上举办全球开发者大会WWDC2020.在大会上,苹果对iOS.iPadOS.macOS.watchOS.tvOS进行更新,其中大家最关心的iOS14,主要更新了36个功能. ...

- Go读取yaml文件到struct类

1.yaml文件准备 common: secretid: AKIDxxxxx secretKey: 3xgGxxxx egion: ap-guangzhou zone: ap-guangzhou-7 ...

- 目标检测+双目测距——基于yolov5

效果 测试例子1 输入: 左图 右图 输出: 测试例子2 输入: 左图 右图 输出: 测试例子3 输入: 左图 右图 输出: 核心代码 基于yolov5-6.1版本和双目测距+点云--使用Middle ...