Hadoop学习问题记录之基础篇

目的

记录学习hadoop过程中遇到的基础问题,无关大小、无关困扰时间长短。

问题一 全分布式环境中运行mapred程序,报异常:java.net.NoRouteToHostException: 没有到主机的路由

在全分布式环境中运行mapred程序,报异常:java.net.NoRouteToHostException: 没有到主机的路由,但同样的配置、同样的程序,在伪分布式环境中是没有问题的。具体异常信息如下:

-- ::, INFO mapreduce.Job: Running job: job_1568442070466_0003

-- ::, INFO mapreduce.Job: Job job_1568442070466_0003 running in uber mode : false

-- ::, INFO mapreduce.Job: map % reduce %

-- ::, INFO mapreduce.Job: Job job_1568442070466_0003 failed with state FAILED due to: Application application_1568442070466_0003 failed times due to Error launching appattempt_1568442070466_0003_000002. Got exception: java.net.NoRouteToHostException: No Route to Host from master/192.168.212.132 to slave1: failed on socket timeout exception: java.net.NoRouteToHostException: 没有到主机的路由; For more details see: http://wiki.apache.org/hadoop/NoRouteToHost

at sun.reflect.GeneratedConstructorAccessor56.newInstance(Unknown Source)

at sun.reflect.DelegatingConstructorAccessorImpl.newInstance(DelegatingConstructorAccessorImpl.java:)

at java.lang.reflect.Constructor.newInstance(Constructor.java:)

at org.apache.hadoop.net.NetUtils.wrapWithMessage(NetUtils.java:)

at org.apache.hadoop.net.NetUtils.wrapException(NetUtils.java:)

at org.apache.hadoop.ipc.Client.getRpcResponse(Client.java:)

at org.apache.hadoop.ipc.Client.call(Client.java:)

at org.apache.hadoop.ipc.Client.call(Client.java:)

at org.apache.hadoop.ipc.ProtobufRpcEngine$Invoker.invoke(ProtobufRpcEngine.java:)

at org.apache.hadoop.ipc.ProtobufRpcEngine$Invoker.invoke(ProtobufRpcEngine.java:)

at com.sun.proxy.$Proxy83.startContainers(Unknown Source)

at org.apache.hadoop.yarn.api.impl.pb.client.ContainerManagementProtocolPBClientImpl.startContainers(ContainerManagementProtocolPBClientImpl.java:)

at sun.reflect.GeneratedMethodAccessor88.invoke(Unknown Source)

at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:)

at java.lang.reflect.Method.invoke(Method.java:)

at org.apache.hadoop.io.retry.RetryInvocationHandler.invokeMethod(RetryInvocationHandler.java:)

at org.apache.hadoop.io.retry.RetryInvocationHandler$Call.invokeMethod(RetryInvocationHandler.java:)

at org.apache.hadoop.io.retry.RetryInvocationHandler$Call.invoke(RetryInvocationHandler.java:)

at org.apache.hadoop.io.retry.RetryInvocationHandler$Call.invokeOnce(RetryInvocationHandler.java:)

at org.apache.hadoop.io.retry.RetryInvocationHandler.invoke(RetryInvocationHandler.java:)

at com.sun.proxy.$Proxy84.startContainers(Unknown Source)

at org.apache.hadoop.yarn.server.resourcemanager.amlauncher.AMLauncher.launch(AMLauncher.java:)

at org.apache.hadoop.yarn.server.resourcemanager.amlauncher.AMLauncher.run(AMLauncher.java:)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:)

at java.lang.Thread.run(Thread.java:)

Caused by: java.net.NoRouteToHostException: 没有到主机的路由

at sun.nio.ch.SocketChannelImpl.checkConnect(Native Method)

at sun.nio.ch.SocketChannelImpl.finishConnect(SocketChannelImpl.java:)

at org.apache.hadoop.net.SocketIOWithTimeout.connect(SocketIOWithTimeout.java:)

at org.apache.hadoop.net.NetUtils.connect(NetUtils.java:)

at org.apache.hadoop.ipc.Client$Connection.setupConnection(Client.java:)

at org.apache.hadoop.ipc.Client$Connection.setupIOstreams(Client.java:)

at org.apache.hadoop.ipc.Client$Connection.access$(Client.java:)

at org.apache.hadoop.ipc.Client.getConnection(Client.java:)

at org.apache.hadoop.ipc.Client.call(Client.java:)

... more

. Failing the application.

-- ::, INFO mapreduce.Job: Counters:

异常信息

问题定位

1、虽然异常信息中只提到了一个slave节点,但已知所有节点配置均一模一样,所以这应该是一个共性问题;

2、根据异常的字面意思,即当前提交工作的master节点找不到slave节点,而找不到无非是以下几种情况:

- 当前主机的hosts配置错误

经ping slave1命令测试成功,这个情况可以排除。 - 目标主机对应端口(45816)未打开

打开所有slave节点的45816端口后,重新提交一次作业观察运行情况。

再次提交作业,发现仍然报错,但此时的端口变成了43910,这个端口我们并未处理,自然也是关闭的。由端口的变化,可推测,每次提交作业调度运行时,用到的IPC端口是框架随机使用的,所以再用打开某个端口的方式来解决这个问题已经明显不可取了。

解决思路有两个:1、为slave节点添加对master节点的IP级别允许通过;2、使框架用到的ipc端口固定,然后用允许端口的方式开放。(暂未找到这种配置方法)

在使用解决思路1,使用以下命令开放给master节点访问:firewall-cmd --permanent --add-rich-rule='rule family="ipv4" source address="192.168.212.132" accept'

firewall-cmd --reload

再次提交作业,发现作业已经可以提交成功,并有成功的task运行,但仍存在NoRouteToHostException报错,错误信息如下:

-- ::, INFO mapreduce.Job: Task Id : attempt_1568452715996_0001_m_000013_2, Status : FAILED

Container launch failed for container_1568452715996_0001_01_000056 : java.net.NoRouteToHostException: No Route to Host from slave3/192.168.212.135 to slave1: failed on socket timeout exception: java.net.NoRouteToHostException: 没有到主机的路由; For more details see: http://wiki.apache.org/hadoop/NoRouteToHost

at sun.reflect.GeneratedConstructorAccessor39.newInstance(Unknown Source)

at sun.reflect.DelegatingConstructorAccessorImpl.newInstance(DelegatingConstructorAccessorImpl.java:)

at java.lang.reflect.Constructor.newInstance(Constructor.java:)

at org.apache.hadoop.net.NetUtils.wrapWithMessage(NetUtils.java:)

at org.apache.hadoop.net.NetUtils.wrapException(NetUtils.java:)

at org.apache.hadoop.ipc.Client.getRpcResponse(Client.java:)

at org.apache.hadoop.ipc.Client.call(Client.java:)

at org.apache.hadoop.ipc.Client.call(Client.java:)

at org.apache.hadoop.ipc.ProtobufRpcEngine$Invoker.invoke(ProtobufRpcEngine.java:)

at org.apache.hadoop.ipc.ProtobufRpcEngine$Invoker.invoke(ProtobufRpcEngine.java:)

at com.sun.proxy.$Proxy84.startContainers(Unknown Source)

at org.apache.hadoop.yarn.api.impl.pb.client.ContainerManagementProtocolPBClientImpl.startContainers(ContainerManagementProtocolPBClientImpl.java:)

at sun.reflect.GeneratedMethodAccessor12.invoke(Unknown Source)

at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:)

at java.lang.reflect.Method.invoke(Method.java:)

at org.apache.hadoop.io.retry.RetryInvocationHandler.invokeMethod(RetryInvocationHandler.java:)

at org.apache.hadoop.io.retry.RetryInvocationHandler$Call.invokeMethod(RetryInvocationHandler.java:)

at org.apache.hadoop.io.retry.RetryInvocationHandler$Call.invoke(RetryInvocationHandler.java:)

at org.apache.hadoop.io.retry.RetryInvocationHandler$Call.invokeOnce(RetryInvocationHandler.java:)

at org.apache.hadoop.io.retry.RetryInvocationHandler.invoke(RetryInvocationHandler.java:)

at com.sun.proxy.$Proxy85.startContainers(Unknown Source)

at org.apache.hadoop.mapreduce.v2.app.launcher.ContainerLauncherImpl$Container.launch(ContainerLauncherImpl.java:)

at org.apache.hadoop.mapreduce.v2.app.launcher.ContainerLauncherImpl$EventProcessor.run(ContainerLauncherImpl.java:)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:)

at java.lang.Thread.run(Thread.java:)

Caused by: java.net.NoRouteToHostException: 没有到主机的路由

at sun.nio.ch.SocketChannelImpl.checkConnect(Native Method)

at sun.nio.ch.SocketChannelImpl.finishConnect(SocketChannelImpl.java:)

at org.apache.hadoop.net.SocketIOWithTimeout.connect(SocketIOWithTimeout.java:)

at org.apache.hadoop.net.NetUtils.connect(NetUtils.java:)

at org.apache.hadoop.ipc.Client$Connection.setupConnection(Client.java:)

at org.apache.hadoop.ipc.Client$Connection.setupIOstreams(Client.java:)

at org.apache.hadoop.ipc.Client$Connection.access$(Client.java:)

at org.apache.hadoop.ipc.Client.getConnection(Client.java:)

at org.apache.hadoop.ipc.Client.call(Client.java:)

... more

异常信息之一

问题定位

看异常信息,虽然同为NoRouteToHostException,也都是在startContainer(启动容器)的时候报错,但与上一次的报错不同,这一次的异常并不是由master节点ipc调用slave1节点报错,而是slave1节点ipc调用slave3节点startContainer报错,可知由master到各个slave节点的通道已经打通,但slave间的通道还是堵塞的,即需要在各个salve节点的防火墙配置中,加入每一个salve节点的“通行许可”,如下

firewall-cmd --permanent --add-rich-rule='rule family="ipv4" source address="192.168.212.133" accept'

firewall-cmd --permanent --add-rich-rule='rule family="ipv4" source address="192.168.212.134" accept'

firewall-cmd --permanent --add-rich-rule='rule family="ipv4" source address="192.168.212.135" accept'

firewall-cmd --reload

其中,133、134、135分别是slave1、2、3节点的IP地址。

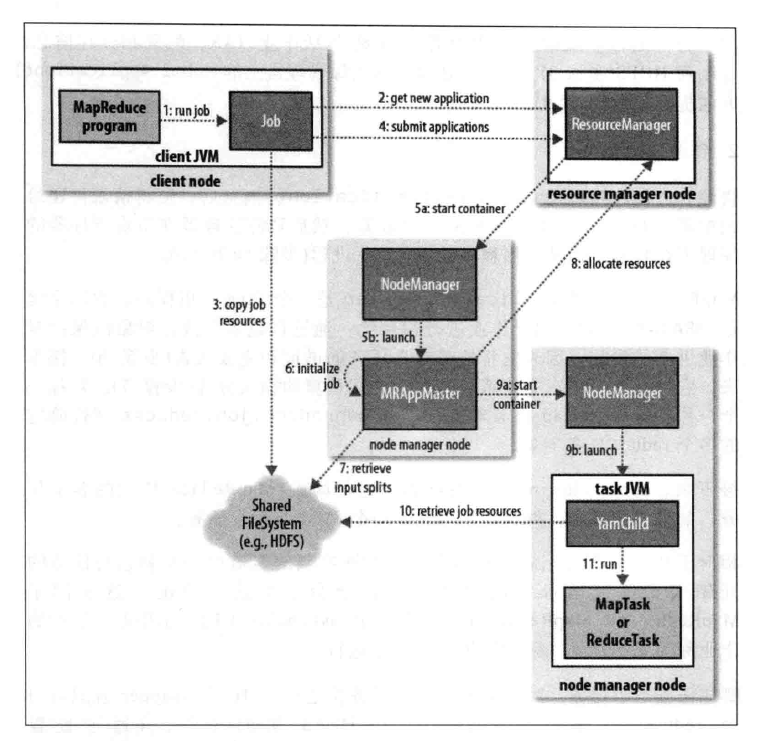

用以下“在Yarn上运行MapReduce程序的过程”图来说明的话,第一个NoRouteToHostException出在步骤5a,第二个NoRouteToHostException出在步骤9a。

重新提交作业,问题解决。

问题二、MR程序实现HDFS和Mysql数据库间倒数据时报错:java.io.IOException: com.mysql.jdbc.Driver

问题定位

该问题是由于程序找不到mysql连接驱动,网上找到三种方法:

1、将mysql连接驱动jar放入每个节点的{HADOOP_HOME}/lib/下;(在hadoop3.2.0环境下验证无效)

2、将mysql连接驱动jar放入hdfs中,在代码中将jar引入;(在hadoop3.2.0环境下验证可用)

3、将mysql连接驱动jar直接打入mr程序中。(过于粗暴未实验,理论上应该也可行)

问题三、MR程序实现HDFS和Mysql数据库间倒数据时报错:Error: java.io.IOException: null, message from server: "Host 'slave1' is not allowed to connect to this MySQL server"

详细错误栈信息如下:

Error: java.io.IOException: null, message from server: "Host 'slave1' is not allowed to connect to this MySQL server"

at org.apache.hadoop.mapreduce.lib.db.DBOutputFormat.getRecordWriter(DBOutputFormat.java:)

at org.apache.hadoop.mapred.MapTask$NewDirectOutputCollector.<init>(MapTask.java:)

at org.apache.hadoop.mapred.MapTask.runNewMapper(MapTask.java:)

at org.apache.hadoop.mapred.MapTask.run(MapTask.java:)

at org.apache.hadoop.mapred.YarnChild$.run(YarnChild.java:)

at java.security.AccessController.doPrivileged(Native Method)

at javax.security.auth.Subject.doAs(Subject.java:)

at org.apache.hadoop.security.UserGroupInformation.doAs(UserGroupInformation.java:)

at org.apache.hadoop.mapred.YarnChild.main(YarnChild.java:)

问题定位

从错误信息来看,大意是当前host允许连接到mysql服务,于是更改mysql的用户表中host列为%,意为允许任意host发起连接:

mysql> use mysql;

Reading table information for completion of table and column names

You can turn off this feature to get a quicker startup with -A Database changed

mysql> update user set host='%' where user='root';

Query OK, 0 rows affected (0.03 sec)

Rows matched: 1 Changed: 0 Warnings: 0

再次允许程序,仍然报该错误。检查程序,发现是mysql登录密码写错了(尴尬),把密码改正后,问题解决。

这里记录一下,登录账户密码不对也会报以上错误。

Hadoop学习问题记录之基础篇的更多相关文章

- (转)深度学习word2vec笔记之基础篇

深度学习word2vec笔记之基础篇 声明: 1)该博文是多位博主以及多位文档资料的主人所无私奉献的论文资料整理的.具体引用的资料请看参考文献.具体的版本声明也参考原文献 2)本文仅供学术交流,非商用 ...

- 深度学习word2vec笔记之基础篇

作者为falao_beiliu. 作者:杨超链接:http://www.zhihu.com/question/21661274/answer/19331979来源:知乎著作权归作者所有.商业转载请联系 ...

- SpringBoot学习(一)基础篇

目录 关于Springboot Springboot优势 快速入门 关于SpringBoot Spring Boot是由Pivotal团队提供的全新框架,其设计目的是用来简化新Spring应用的初始搭 ...

- Mongoose学习参考文档——基础篇

Mongoose学习参考文档 前言:本学习参考文档仅供参考,如有问题,师请雅正 一.快速通道 1.1 名词解释 Schema : 一种以文件形式存储的数据库模型骨架,不具备数据库的操作能力 Model ...

- 学习笔记三:基础篇Linux基础

Linux基础 直接选择排序>快速排序>基数排序>归并排序 >堆排序>Shell排序>冒泡排序=冒泡排序2 =直接插入排序 一.Linux磁盘分区表示 Linux中 ...

- HTML学习(一)基础篇

这篇文章有人比我总结的好,适用于新手,我就适当的铺垫一下,结尾处会给你们网站,我就不班门弄斧了. 一)HTML结构 1.<head>标签 <title> <base/&g ...

- 【angularjs】【学习心得】路由基础篇

原文:http://www.imooc.com/wenda/detail/236998 AngularJS自带有路由模块ngRoute,但是有经验的老师都推荐我们使用功能更完善更强大的ui-route ...

- Java反射学习总结一(基础篇)

Class类是Reflection API中核心的类,他位于Java.lang.Class 列出一些常用的方法. - getName() : 获得类的完整名字 - getFields() : 获得类的 ...

- 学习simple.data之基础篇

simple.data是一个轻量级的.动态的数据访问组件,支持.net4.0. 1.必须条件和依赖性: v4.0 or greater of the .NET framework, or v2.10 ...

随机推荐

- 重学 Java 设计模式:实战策略模式「模拟多种营销类型优惠券,折扣金额计算策略场景」

作者:小傅哥 博客:https://bugstack.cn - 原创系列专题文章 沉淀.分享.成长,让自己和他人都能有所收获! 一.前言 文无第一,武无第二 不同方向但同样努力的人,都有自身的价值和亮 ...

- HNOI 2014 米特运输(图论)

HNOI 2014 米特运输 题目大意 给一棵树,每个点有自己的权值,要求更改一些点的权值,使得整棵树满足两个条件: 同一个父亲的所有子节点权值相同 父节点的取值为所有子节点的和 答案输出最少要更改的 ...

- mac篇---mac安装jupyter

1.Jupyter搭建 pip install --user jupyter 如果是在python3中,则用如下命令: pip3 install --user jupyter 如下图所示: 2. Ju ...

- Mac搭建svn服务器环境

Mac搭建svn服务器环境 svn是Subversion的简称,是一个开放源代码的版本控制系统, Mac系统自带了svn的服务端和客户端功能, 因此不需要下载第三方软件,就可以支持svn进行版本的管控 ...

- java 数据结构(二):java常用类 二 StringBuffer、StringBuilder

1.String.StringBuffer.StringBuilder三者的对比String:不可变的字符序列:底层使用char[]存储StringBuffer:可变的字符序列:线程安全的,效率低:底 ...

- MySQL数据库修改表名

修改表名 例:把表user 修改为tenant,SQL如下: rename table user to tenant:

- 用Canvas定时显示摄像头捕获的画像(HTML5)

需要实现一个功能,大意嘛,就是标题写的那个意思.虽然用户只要求在微信中实现即可,也就是可以用JSSDK.但是前端小哥哥脑袋一根筋,就想用原生的H5和JS实现. 网上铺天盖地的资料,可惜没有一个是可以用 ...

- JVM系列-方法调用的原理

JVM系列-方法调用的原理 最近重新看了一些JVM方面的笔记和资料,收获颇丰,尤其解决了长久以来心中关于JVM方法管理的一些疑问.下面介绍一下JVM中有关方法调用的知识. 目的 方法调用,目的是选择方 ...

- nginx一个端口配置多个不同服务映射

upstream tomcat_server{ server 127.0.0.1:8087; server 192.168.149.117:8088; } server { listen 8088; ...

- OneinStack - 自动编译环境安装脚本

https://oneinstack.com/