动量法应用NASA测试不同飞机机翼噪音

%matplotlib inline

from mxnet import nd

import numpy as np

from mxnet import autograd,gluon,init,nd

from mxnet.gluon import nn,data as gdata,loss as gloss

import time def get_data():

data = np.genfromtxt('./data/airfoil_self_noise.dat', delimiter='\t')

data = (data - data.mean(axis=0)) / data.std(axis=0)

return nd.array(data[:1500, :-1]), nd.array(data[:1500, -1]) features, labels = get_data()

features[0]

labels[0] # 定义网络

def linreg(X,w,b):

return nd.dot(X,w) + b # 平方损失

def squared_loss(y_hat,y):

return (y_hat - y.reshape(y_hat.shape))**2/2 # 初始化参数

def init_momentum_states():

v_w = nd.zeros((features.shape[1], 1))

v_b = nd.zeros(1)

return (v_w, v_b) # params [w,b]

# states [v_w,v_b] 初始化状态

# hyperparams {'lr':0.02,'momentum':0.5}

def sgd_momentum(params, states, hyperparams):

for p, v in zip(params, states):

v[:] = hyperparams['momentum'] * v + hyperparams['lr'] * p.grad

p[:] -= v def train(trainer_fn, states, hyperparams, features, labels,

batch_size=10, num_epochs=2):

# 初始化模型。

net, loss = gb.linreg, gb.squared_loss

w = nd.random.normal(scale=0.01, shape=(features.shape[1], 1))

b = nd.zeros(1)

w.attach_grad()

b.attach_grad() def eval_loss():

return loss(net(features, w, b), labels).mean().asscalar() ls = [eval_loss()]

data_iter = gdata.DataLoader(

gdata.ArrayDataset(features, labels), batch_size, shuffle=True)

for _ in range(num_epochs):

start = time.time()

for batch_i, (X, y) in enumerate(data_iter):

with autograd.record():

l = loss(net(X, w, b), y).mean() # 使用平均损失。

l.backward()

trainer_fn([w, b], states, hyperparams) # 迭代模型参数。

if (batch_i + 1) * batch_size % 100 == 0:

ls.append(eval_loss()) # 每 100 个样本记录下当前训练误差。

# 打印结果和作图。

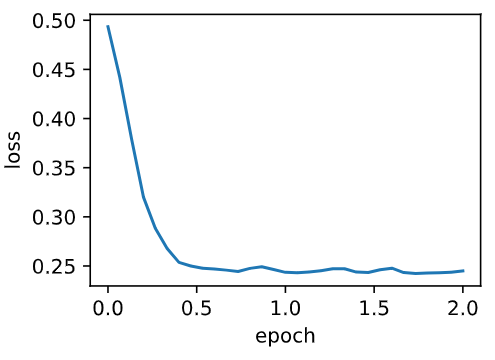

print('loss: %f, %f sec per epoch' % (ls[-1], time.time() - start))

gb.set_figsize()

gb.plt.plot(np.linspace(0, num_epochs, len(ls)), ls)

gb.plt.xlabel('epoch')

gb.plt.ylabel('loss') train(trainer_fn=sgd_momentum,states= init_momentum_states(),hyperparams={'lr': 0.02, 'momentum': 0.5}, features=features, labels=labels) train(sgd_momentum,init_momentum_states(),{'lr':0.02,'momentum':0.9},features,labels) train(sgd_momentum,init_momentum_states(),{'lr':0.004,'momentum':0.9},features,labels)

gluon 版:

def train_gluon(trainer_name,trainer_hyperparams,features,labels,batch_size=10,num_epochs=2):

# 初始化模型

net = nn.Sequential()

net.add(nn.Dense(1))

net.initialize(init.Normal(sigma=0.01))

loss = gloss.L2Loss() def eval_loss():

return loss(net(features),labels).mean().asscalar() ls = [eval_loss()]

data_iter = gdata.DataLoader(gdata.ArrayDataset(features,labels),batch_size,shuffle=True) # 创建 Trainer 实例迭代模型参数

trainer = gluon.Trainer(net.collect_params(),trainer_name,trainer_hyperparams) for _ in range(num_epochs):

start = time.time()

for batch_i, (X,y) in enumerate(data_iter):

with autograd.record():

l = loss(net(X),y)

l.backward()

trainer.step(batch_size)

if (batch_i + 1) * batch_size % 100 ==0:

ls.append(eval_loss()) # 打印结果和作图。

print('loss: %f, %f sec per epoch' % (ls[-1], time.time() - start))

gb.set_figsize()

gb.plt.plot(np.linspace(0, num_epochs, len(ls)), ls)

gb.plt.xlabel('epoch')

gb.plt.ylabel('loss') train_gluon('sgd',{'learning_rate':0.004,'momentum':0.9},features,labels)

动量法应用NASA测试不同飞机机翼噪音的更多相关文章

- NLP之基于Seq2Seq和注意力机制的句子翻译

Seq2Seq(Attention) @ 目录 Seq2Seq(Attention) 1.理论 1.1 机器翻译 1.1.1 模型输出结果处理 1.1.2 BLEU得分 1.2 注意力模型 1.2.1 ...

- NLP之基于Bi-LSTM和注意力机制的文本情感分类

Bi-LSTM(Attention) @ 目录 Bi-LSTM(Attention) 1.理论 1.1 文本分类和预测(翻译) 1.2 注意力模型 1.2.1 Attention模型 1.2.2 Bi ...

- 基于Seq2Seq和注意力机制的句子翻译

Seq2Seq(Attention) 目录 Seq2Seq(Attention) 1.理论 1.1 机器翻译 1.1.1 模型输出结果处理 1.1.2 BLEU得分 1.2 注意力模型 1.2.1 A ...

- NLP之基于Seq2Seq的单词翻译

Seq2Seq 目录 Seq2Seq 1.理论 1.1 基本概念 1.2 模型结构 1.2.1 Encoder 1.2.2 Decoder 1.3 特殊字符 2.实验 2.1 实验步骤 2.2 算法模 ...

- NLP之Bi-LSTM(在长句中预测下一个单词)

Bi-LSTM @ 目录 Bi-LSTM 1.理论 1.1 基本模型 1.2 Bi-LSTM的特点 2.实验 2.1 实验步骤 2.2 实验模型 1.理论 1.1 基本模型 Bi-LSTM模型分为2个 ...

- NLP之TextLSTM(预测单词下一个字母)

LSTM 目录 LSTM 1.理论 1.1 LSTM与RNN 1.1.1 RNN的缺点 1.1.2 LSTM 1.2 LSTM基本结构 2.实验 2.1 实验步骤 2.2 算法模型 1.理论 1.1 ...

- NLP之TextRNN(预测下一个单词)

TextRNN @ 目录 TextRNN 1.基本概念 1.1 RNN和CNN的区别 1.2 RNN的几种结构 1.3 多对多的RNN 1.4 RNN的多对多结构 1.5 RNN的多对一结构 1.6 ...

- NLP之基于TextCNN的文本情感分类

TextCNN @ 目录 TextCNN 1.理论 1.1 基础概念 最大汇聚(池化)层: 1.2 textCNN模型结构 2.实验 2.1 实验步骤 2.2 算法模型 1.理论 1.1 基础概念 在 ...

- 用javascript写星际飞机大战游戏

在github里看到了个不错的脚本游戏,决定亲自动手来写,效果如下 下面是代码的思路分享 把整个代码理解消化确实不容易,但是如果你坚持看完相信你一定会有收获 如果没兴趣可以直接点击下面的链接 复制代码 ...

随机推荐

- Codeforces 981F. Round Marriage

Description 一个长度为 \(L\) 的环上有 \(n\) 个黑点和 \(n\) 个白点 , 你需要把黑点和白点配对 , 使得配对点的最大距离最小 , 最小距离定义为两点在环上的两条路径的最 ...

- Hadoop实战之二~ hadoop作业调度详解(1)

对Hadoop的最感兴趣的地方,也就在于Hadoop的作业调度了,在正式介绍如何搭建Hadoop之前,深入理解一下Hadoop的作业调度很有必要.我们不一定能用得上Hadoop,但是如果理通顺Hado ...

- 利用canvas制作图片(可缩放和平移)+相框+文字

前言: 公司一个售前问我能不能用H5做一个手机拍照,给相片添加相框和添加文字上传到服务器的功能,我当时一琢磨觉得可行,就利用空余时间做了一个demo,去掉了拍照和上传,如果以后有机会,会给补上,当然对 ...

- 2017年12月13日 LinQ用法基本的增删改查

LinQ是什么? LinQ是语言集成的查询,是用于C#跟Vb的扩展语言 LinQ的用法 新建一个App_Code文件夹,在文件夹下添加一个数据LinQ to SQL类,可以直接直接点击服务器管理器然后 ...

- Java基础(9)——数组

难点儿的已经过去啦,现在又开始基础了哈~ 之前讲变量的时候,变量是一个个的呀~,那我要搞一串变量该啷个办呢?Java给我们出了个好东西叫数组(*^▽^*) 数组呢,就是将变量一组一组的存起来,这个也是 ...

- cygwin 的安装和配置

Cygwin是一个在windows平台上运行的类UNIX模拟环境,是cygnus solutions公司开发的自由软件(该公司开发的著名工具还有eCos,不过现已被Redhat收购).它对于 ...

- Golang 的 TOML库

TOML 的全称是 Tom's Obvious, Minimal Language,因为它的作者是 GitHub 联合创始人 Tom Preston-Werner. TOML 的目标是成为一个极简的配 ...

- css3之弹性盒模型初探(一)

什么是弹性盒模型? 弹性盒模型是指在父级改变大小的时候内部的自己元素也会相应的改变大小,即子集会按照父级的大小按比例自适应大小. 弹性盒模型的提出可以解决一些响应式布局的需求 如何使用弹性盒模型? ...

- web前端优化之内容优化

前端内容优化主要有以下几条: 1.尽量减少http请求 (1)合并文件,把多个css文件合并在一起: (2)css Sprites,把css相关的background元素进行背景图绝对定位: (3)图 ...

- cnpm 安装

国内npm 安装比较慢,可选择cnpm npm install -g cnpm --registry=https://registry.npm.taobao.org