爬取房价信息并制作成柱状图XPath,pyecharts

以长沙楼盘为例,看一下它的房价情况如何url = https://cs.newhouse.fang.com/house/s/b91/

一、页面

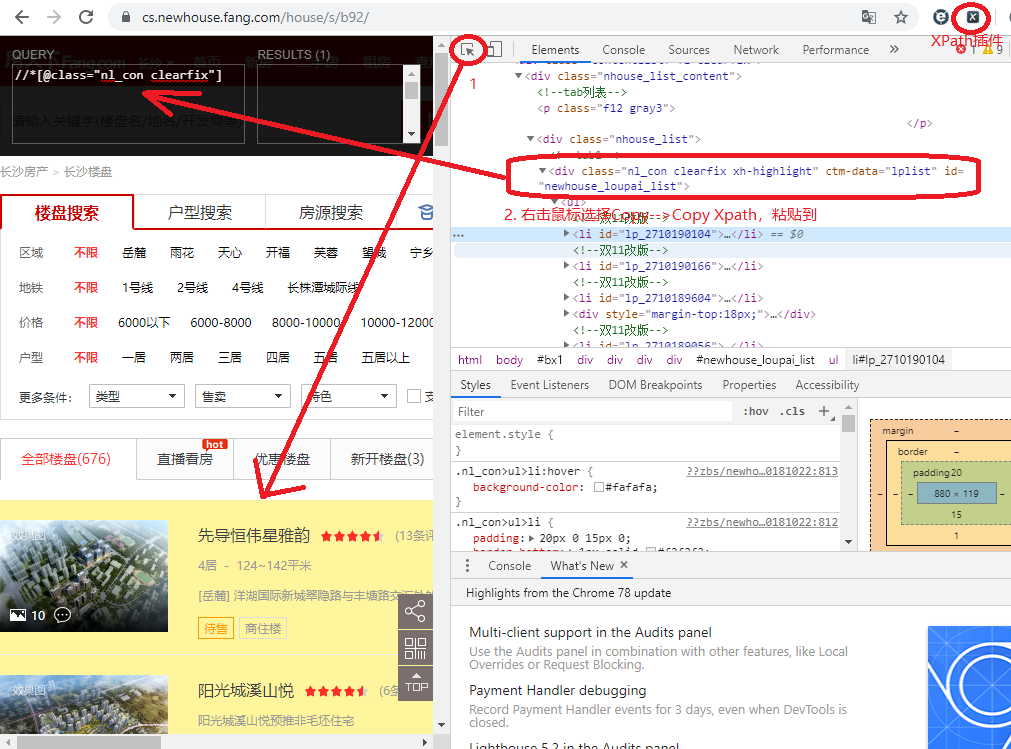

二、分析页面源代码

我们要获得的数据就是名字和价格,先来分析一下源代码,鼠标右键Inspect,并且打开xpath,第一步,找到需要提取数据的区域,选中定位到代码相应位置,然后右击copy xpath到xpath里面去,可以发现插件中右侧results有一个,就是下面那片黄色的区域,即我们要提取的数据。

好了,网页部分已经了解了,那么接下来就是用代码抓取数据了。

三、代码实现

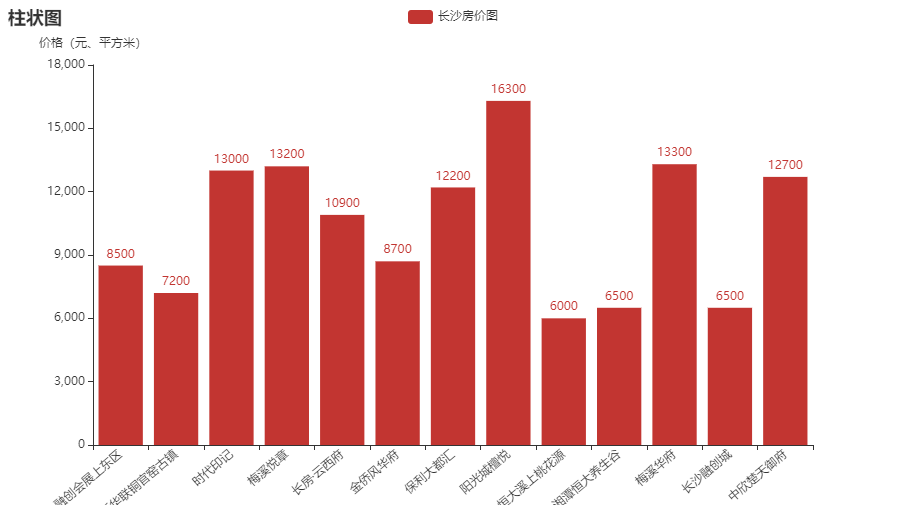

成果图:

play.py

#!/usr/bin/env python

# _*_ coding: UTF-8 _*_

"""=================================================

@Project -> File : Operate_system_ModeView_structure -> play.py

@IDE : PyCharm

@Author : zihan

@Date : 2020/5/6 14:59

@Desc :

================================================="""

import requests

from lxml import etree

from pyecharts.charts import Bar

import pyecharts.options as opts def getData():

url = "https://cs.newhouse.fang.com/house/s/b91/"

headers = {

'User-Agent': ""

}

response = requests.get(url, headers=headers) # 发送请求

data= response.content.decode(encoding='gbk')

html = etree.HTML(data) house_list = html.xpath('//div[@class="nl_con clearfix"]/ul/li') names = []

prices = []

for i in house_list:

name = i.xpath('.//div[@class="nlcd_name"]/a/text()')

price = i.xpath('.//div[@class="nhouse_price"]/span/text()') if name != [] and price != []:

if price != ['价格待定']:

name = name[0].strip()

names.append(name)

price = price[0]

prices.append(price)

return names, prices def main():

print("main() func is starting...")

names, prices = getData()

# print(names)

# print(prices)

bar = Bar()

bar.add_xaxis(names)

bar.add_yaxis('长沙房价图', prices)

bar.set_global_opts(

xaxis_opts=opts.AxisOpts(

axislabel_opts=opts.LabelOpts(rotate=40),

),

yaxis_opts=opts.AxisOpts(name="价格(元、平方米)"),

title_opts=opts.TitleOpts(title="柱状图")

)

bar.render('房价图.html') if __name__ == '__main__':

main()

好了。

爬取房价信息并制作成柱状图XPath,pyecharts的更多相关文章

- Python爬取招聘信息,并且存储到MySQL数据库中

前面一篇文章主要讲述,如何通过Python爬取招聘信息,且爬取的日期为前一天的,同时将爬取的内容保存到数据库中:这篇文章主要讲述如何将python文件压缩成exe可执行文件,供后面的操作. 这系列文章 ...

- [python] 常用正则表达式爬取网页信息及分析HTML标签总结【转】

[python] 常用正则表达式爬取网页信息及分析HTML标签总结 转http://blog.csdn.net/Eastmount/article/details/51082253 标签: pytho ...

- Python爬虫小实践:寻找失踪人口,爬取失踪儿童信息并写成csv文件,方便存入数据库

前两天有人私信我,让我爬这个网站,http://bbs.baobeihuijia.com/forum-191-1.html上的失踪儿童信息,准备根据失踪儿童的失踪时的地理位置来更好的寻找失踪儿童,这种 ...

- Python爬虫之selenium爬虫,模拟浏览器爬取天猫信息

由于工作需要,需要提取到天猫400个指定商品页面中指定的信息,于是有了这个爬虫.这是一个使用 selenium 爬取天猫商品信息的爬虫,虽然功能单一,但是也算是 selenium 爬虫的基本用法了. ...

- python学习之——爬取网页信息

爬取网页信息 说明:正则表达式有待学习,之后完善此功能 #encoding=utf-8 import urllib import re import os #获取网络数据到指定文件 def getHt ...

- Python-王者荣耀自动刷金币+爬取英雄信息+图片

前提:本文主要功能是 1.用python代刷王者荣耀金币 2.爬取英雄信息 3.爬取王者荣耀图片之类的. (全部免费附加源代码) 思路:第一个功能是在基于去年自动刷跳一跳python代码上面弄的,思路 ...

- 常用正则表达式爬取网页信息及HTML分析总结

Python爬取网页信息时,经常使用的正则表达式及方法. 1.获取<tr></tr>标签之间内容 2.获取<a href..></a>超链接之间内容 3 ...

- python爬取酒店信息练习

爬取酒店信息,首先知道要用到那些库.本次使用request库区获取网页,使用bs4来解析网页,使用selenium来进行模拟浏览. 本次要爬取的美团网的蚌埠酒店信息及其评价.爬取的网址为“http:/ ...

- Python爬取网页信息

Python爬取网页信息的步骤 以爬取英文名字网站(https://nameberry.com/)中每个名字的评论内容,包括英文名,用户名,评论的时间和评论的内容为例. 1.确认网址 在浏览器中输入初 ...

随机推荐

- 开源FastGithub

0 前言 github网站访问慢或访问不了,相信很多人都会遇到过,解决方式大概有两种:一种是使用代理访问:另一种是使用ipaddress.com等域名解析网站查询域名的ip,然后在host文件增加ip ...

- 九、部署audit监控文件

审计的目的是基于事先配置的规则生成日志,记录可能发生在系统上的事件(正常或非正常行为的事件),审计不会为系统提供额外的安全保护,但她会发现并记录违反安全策略的人及其对应的行为. 审计能够记录的日志内容 ...

- 【UG二次开发】 UF_OBJ_ask_name 获取对象名字

代码 char name[256]; UF_OBJ_ask_name(objTag, name);

- 使用 Hexo 搭建静态博客

目录 Hexo 简介 什么是 Hexo? Hexo 安装 Hexo 建站 Hexo 配置 Hexo 自定义主题 Hexo 写作 Hexo 服务器 Hexo 生成与发布 一键部署 Hexo 站点到 gi ...

- 工具篇:介绍几个好用的guava工具类

前言 平时我们都会封装一些处理缓存或其他的小工具.但每个人都封装一次,重复造轮子,有点费时间.有没有一些好的工具库推荐-guava.guava是谷歌基于java封装好的开源库,它的性能.实用性,比我们 ...

- Kubernetes 实战——有状态应用(StatefulSet)

一.简介 有状态实例:新实例和旧实例需要有相同的名称.网络标识和状态 无状态实例:可随时被替换 1. ReplicaSet 和有状态 Pod ReplicaSet 通过 Pod 模板创建多个 Pod ...

- 重磅!GitHub官方开源新命令行工具

近日,GitHub 发布命令列工具 (Beta) 测试版,官方表示,GitHub CLI提供了一种更简单.更无缝的方法来使用Github.这个命令行工具叫做GitHub CLI,别名gh. 现在,你就 ...

- 【模拟7.14】B. 熟练剖分(tree) (概率DP)

一道概率神题,考试时没读清题考完看了学长的玄学题解看了好几个小时 首先f[i][j]表示在点 i 为根的子树中,向下最长轻链长度小于等于 j 的概率. 首先递归下去并求出子树大小,然后枚举重儿子,枚举 ...

- canvas介绍和用途

canvas介绍和用途 canvas(画布)主要是位图 svg(矢量图) canvas标签,必须要写的3个属性 id width height 为什么不在style中设置width和height呢? ...

- CentOS7 安装搭建docker环境

一.Docker简介 Docker 版本 :版本分为:社区版CE 企业版EE 社区版分为stable和edge俩种发行方式: stable版本:是季度版发行(三月一更新) edge版本:是月度版发行 ...