国内SRC信息收集

SRC之信息收集

前言:

关于SRC信息收集不在于工具是否全面,工具固然重要,它们能帮我们节省大量的时间收集资产,但不是说我们一定要用到所有工具,收集到某个SRC的所有资产才罢休。资产总会有遗漏,关键是动手实践,动手开挖!

下面推荐几个超级好用的信息收集工具,工具不多,但个个都是精品。

信息

收集流程(看个人):

子域名 — 端口 — 框架和指纹 — 目录 — APP — 小程序 — 公众号

子域名收集工具:

ARL:灯塔资产管理系统

- 官方定义:

资产侦察灯塔系统。旨在快速侦察与目标关联的互联网资产,构建基础资产信息库。 协助甲方安全团队或者渗透测试人员有效侦察和检索资产,发现存在的薄弱点和攻击面。(必装!)

- 安装:

不幸的是现在github上已经没有仓库了,看了网上很多的文章发现安装过程太过繁琐,还得本地拉取乱七八糟的,对我这种懒人简直折磨,这里推荐蚁景网安学院的Gitee仓库,一键安装,免去烦恼。

链接:

https://gitee.com/yijingsec/LinuxEnvConfig.git

安装也很简单,直接git克隆到自己的vps上即可(vps是centos系统的话会有问题,建议ubuntu)

git clone https://gitee.com/yijingsec/LinuxEnvConfig.git #克隆到本地

cd LinuxEnvConfig #进入目录

sudo bash LinuxEnvConfig.sh #执行脚本

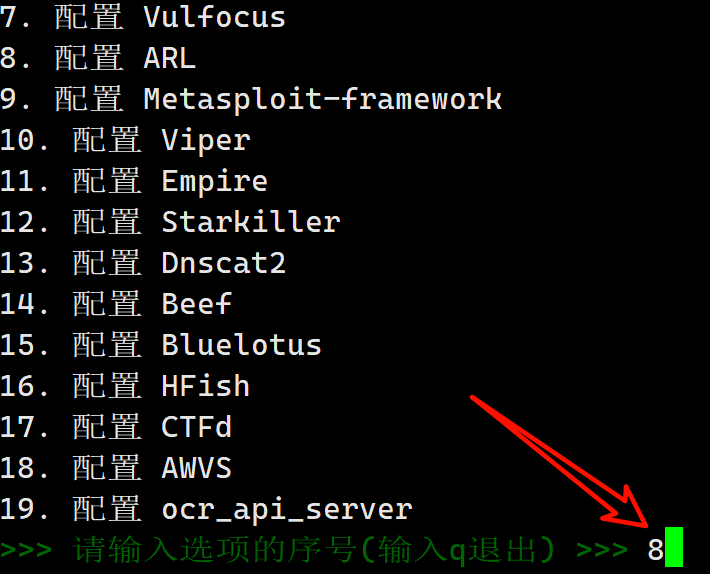

启动之后输入8,按提示安装就好了

安装好后按提示登录就好了,记得改密码,然后就可以愉快的使用了 _

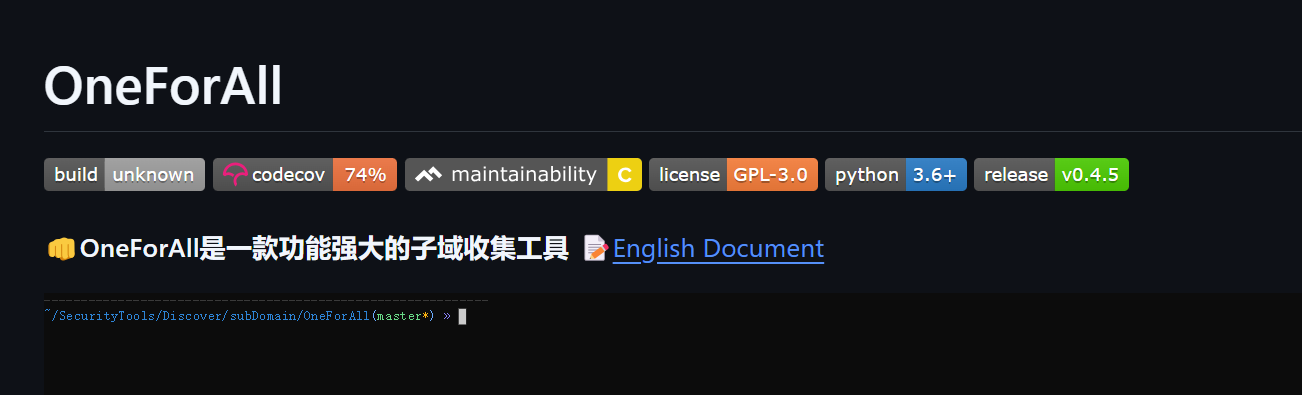

oneforall:资产收集神器,github上8.2k的收藏量

- github链接:

https://github.com/shmilylty/OneForAll

安装使用就不赘述了,毕竟最好的使用教程是官方文档,这里列两个常用命令:

python3 oneforall.py --target example.com run #单个根域名,如baidu.com

python3 oneforall.py --targets ./example.txt run #批量根域名,example.txt在同级目录

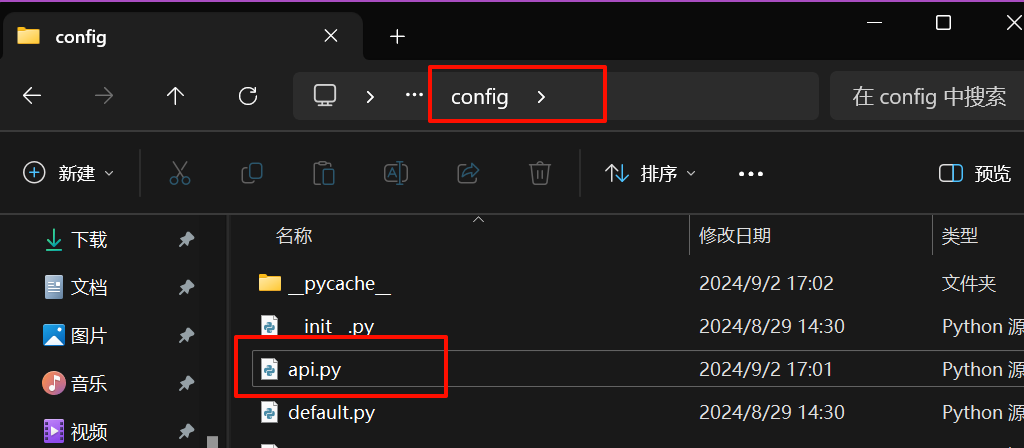

- 注意:一定要配置api.py这个文件,可以调用很多资产测绘工具辅助查找

windows下:OneForAll-master ---> config ---> api.py

linux同理

subfinfer:只为子域名枚举的神器,10k收藏量

- github链接:

https://github.com/projectdiscovery/subfinder

最好的使用教程是官方文档(真不是我懒) _

网络空间测绘搜索引擎

fofa:

网址: https://fofa.info/

好用!但是要会员,不过学生可以用edu邮箱注册,使用教育账号:https://fofa.info/SchoolRegister

hunter:

网址:https://hunter.qianxin.com/

不用会员,消耗积分就可以(点赞)

quake:

白嫖就行了

shodan:

开山鼻祖,收集国外资产必备,国内的话因为某些原因不全(你懂_)

子域名收集先推荐这么多,太多工具收集的话还得去重,很消耗耐心,反而适得其反

端口收集

在用工具进行信息收集时,经常看到网站URL后面跟着个端口号,如https://www.baidu.com:6666,这种时候就可以扫一下端口,看看是不是开了别的服务

namp: 业界冠军

个人习惯用kali自带的,当然也可以去官网下载:https://nmap.org/

参数老多,列几个常用命令:

nmap 目标ip #基本扫描

nmap -p 443 目标ip #TCP端口扫描,扫443端口

nmap -p 100-1000 -sV 目标ip #TCP端口扫描,扫100-1000端口,-sV:显示服务信息

nmap -sU -O 目标ip #-sU:UDP端口扫描 -O:操作系统检测

端口扫描工具用nmap足够了,功能强大 _

框架和指纹

- 识别网站框架推荐谷歌浏览器插件推荐wappalyzer,国外大牛都在用(点赞)

官方链接:https://www.wappalyzer.com/

谷歌浏览器安装直接应用商店搜索:

指纹识别推荐一个在线网站:http://finger.tidesec.net/

目录

主要是扫网站目录,看看有没有敏感文件。

dirsearch:目录扫描神器,11.9k收藏

- github链接:

- 最好的使用教程是官方文档 _

APP,小程序,公众号

-

重点关注股权穿透图,知识产权(里面有小程序,公众号,App,备案)

爱企查:https://aiqicha.baidu.com/

重点关注股权穿透图,经营状况(里面有小程序,公众号,App)

企知道:https://qiye.qizhidao.com/

重点关注股权穿透图,知识产权

谷歌黑客语法

推荐在线网站:https://pentest-tools.com/information-gathering/google-hacking

免去自己手动输入语法,点点点就行了

总结:

网上的信息收集工具实在太多了,导致很多人就纠结:这个工具好不好,收集的全不全,既要又要,最后硬生生卡挖SRC第一步。本文推荐的工具不多,但都是经过时间的严格检验和很多大佬的认可,还是那句话:工具不是重点,动手才是!!!

最后建议专门在浏览器建一个信息收集的书签,以后方便查找。

国内SRC信息收集的更多相关文章

- 菜鸡试飞----SRCの信息收集手册

whois信息 微步在线 https://x.threatbook.cn/ 站长之家 http://whois.chinaz.com/ dns信息-----检测是否存在dns域传送漏洞 子域名的收集 ...

- src挖掘过程之信息收集

信息收集 1.厂商域名 2.厂商ip段 3.厂商业务信息 域名收集 1.基于SSL证书查询 2.第三方网站接口查询 3.Github 4.DNS解析记录 5.子域名枚举等 基于 ...

- 信息收集&Fuzz

本文译自https://0xjoyghosh.medium.com/information-gathering-scanning-for-sensitive-information-reloaded- ...

- Kali Linux信息收集工具

http://www.freebuf.com/column/150118.html 可能大部分渗透测试者都想成为网络空间的007,而我个人的目标却是成为Q先生! 看过007系列电影的朋友,应该都还记得 ...

- python 信息收集器和CMS识别脚本

前言: 信息收集是渗透测试重要的一部分 这次我总结了前几次写的经验,将其 进化了一下 正文: 信息收集脚本的功能: 1.端口扫描 2.子域名挖掘 3.DNS查询 4.whois查询 5.旁站查询 CM ...

- 2017-2018-2 20155303『网络对抗技术』Exp6:信息收集与漏洞扫描

2017-2018-2 20155303『网络对抗技术』 Exp6:信息收集与漏洞扫描 --------CONTENTS-------- 一.原理与实践说明 1.实践内容 2.基础问题 二.实践过程记 ...

- Kali Linux信息收集工具全集

001:0trace.tcptraceroute.traceroute 描述:进行路径枚举时,传统基于ICMP协议的探测工具经常会受到屏蔽,造成探测结果不够全面的问题.与此相对基于TCP协议的探测,则 ...

- 被动信息收集1——DNS基础 + DNS解析工具 NSLOOKUP使用

被动信息收集 特点: 基于公开渠道 与目标不直接接触 避免留下一切痕迹 标准參考--OSINT: 美国军方 北大西洋公约组织 名词解释 DNS--Domain Name System 域名系统 因特网 ...

- Kali Linux信息收集工具全

可能大部分渗透测试者都想成为网络空间的007,而我个人的目标却是成为Q先生! 看过007系列电影的朋友,应该都还记得那个戏份不多但一直都在的Q先生(由于年级太长目前已经退休).他为007发明了众多神奇 ...

- MSF魔鬼训练营-3.1.1信息收集-通过DNS和IP地址挖掘目标网络信息

情报搜集环境站渗透测试全过程的80%~90% 一.外围信息搜集(公开渠道信息搜集OSINT open source intelligence) 3.1.1信息收集-通过DNS和IP地址挖掘目标网 ...

随机推荐

- 2.6倍!WhaleTunnel 客户POC实景对弈DataX

作为阿里早期的开源产品,DataX是一款非常优秀的数据集成工具,普遍被用于多个数据源之间的批量同步,包括类似Apache DolphinScheduler的Task类型也对DataX进行了适配和增强, ...

- RabbitMq 初学五大模式 通俗易懂 超详细 【包含案例】

RabbitMQ五种工作模式 HelloWorld 简单模式 WorkQueues 工作队列模式 Publish/Subscribe 发布/订阅模式 Routing 路由模式 Topic 通配符模式 ...

- keepalived编译安装-麒麟v10Arm64

环境信息 操作系统: Kylin Linux Advanced Server V10 (Lance) 架构:Arm keepalived版本:2.3.1 编译 wget https://www.kee ...

- 树莓派CM4(四):树莓派镜像替换内核

树莓派镜像替换内核 1. 为什么要替换内核 树莓派官方提供的镜像中,自带的内核版本为6.6.31 然而github上提供的内核源码为6.6.40,有些微差别 此外,后续很有可能进行内核裁剪定制等工作, ...

- C++ was not declared in this scope

大概一搜百度,没搜到想要的结果,后面自己发现问题,由于是第二次犯这个错误(第一次很快发现,这一次找了比较久),所以记录一下 当调用一个数据结构或者一个函数的时候,出现这个语句,首先看相关的头文件有没有 ...

- C# 导出Excel NPOI 修改指定单元格的样式 或者行样式

参考文章:原文链接:https://blog.csdn.net/chensirbbk/article/details/52189985 #region 2.NPOI读取Excel 验证Excel数据的 ...

- 阿里云图床(PicGo+阿里云OSS)搭建

阿里云图床搭建方法: 1.登录阿里云,搜索对象存储oss,新用户免费使用3个月20G,到期后,一年也就9元左右,还是很划算的. 2.在左侧列表里,点击Bucket列表,创建Bucket 3.Bucke ...

- 操作 JAR 文件

列出 JAR 文件内容 使用 jar 命令来列出 JAR 文件的内容: jar tf myapp.jar -t 选项表示列出文件,-f 表示指定 JAR 文件. 解压 JAR 文件 使用 jar 命令 ...

- 全网最适合入门的面向对象编程教程:44 Python内置函数与魔法方法-重写内置类型的魔法方法

全网最适合入门的面向对象编程教程:44 Python 内置函数与魔法方法-重写内置类型的魔法方法 摘要: 在 Python 中,内置类型的行为是通过一组特殊的"魔法方法"来实现的, ...

- 专业级语义搜索优化:利用 Cohere AI、BGE Re-Ranker 及 Jina Reranker 实现精准结果重排

专业级语义搜索优化:利用 Cohere AI.BGE Re-Ranker 及 Jina Reranker 实现精准结果重排 1. 简介 1.1 RAG 在说重排工具之前,我们要先了解一下 RAG. 检 ...